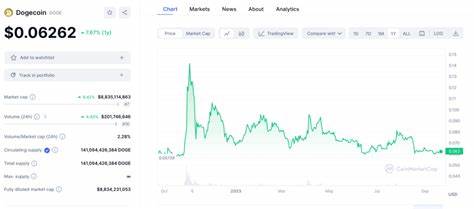

Künstliche Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht, insbesondere im Bereich der Medienerstellung. Die Entwicklung von Deepfake-Technologien, die es ermöglichen, realistische, gefälschte Videos und Audios zu erstellen, ist dabei besonders besorgniserregend. Sicherheitsfirmen warnen nun, dass diese Technologien nicht nur auf Video- und Audioformate beschränkt bleiben könnten, sondern auch in anderen Bereichen, insbesondere im Kryptobereich, gefährliche Auswirkungen haben könnten. Ein jüngster Bericht der Softwarefirma Gen Digital zeigte auf, dass kriminelle Gruppen, die AI-gestützte Deepfake-Scams nutzen, im zweiten Quartal 2024 ihre Aktivitäten massiv ausgeweitet haben. Diese Gruppe, bekannt als „CryptoCore“, soll bereits über 5 Millionen Dollar in Kryptowährungen durch täuschend echte Deepfakes ergaunert haben.

Zwar mag dieser Betrag im Vergleich zu anderen Betrugsformen im Kryptobereich gering erscheinen, doch Experten sind sich einig, dass die Sorglosigkeit der Nutzer in Kombination mit der Raffinesse dieser Angriffe die Sicherheit digitaler Vermögenswerte ernsthaft bedrohen könnte. Das Problem ist, dass viele Krypto-Wallets auf Technologien wie Gesichtserkennung setzen, um den Zugang zu schützen. Ein Sprecher der Web3-Sicherheitsfirma CertiK erklärte, dass Hacker in der Lage sein könnten, diese Systeme zu umgehen, indem sie realistische Deepfakes erzeugen, die wie das Gesicht des echten Nutzers aussehen. Diese Entwicklung könnte dazu führen, dass Sicherheitslösungen, die auf biometrischen Daten basieren, zunehmend anfällig werden. Diejenigen, die im Kryptobereich tätig sind, müssen sich dieser Bedrohung bewusst sein und sicherstellen, dass ihre Sicherheitsvorkehrungen robust genug sind, um gegen solche neuen Angriffsvektoren gewappnet zu sein.

Luis Corrons, ein Sicherheitsexperte von Norton, betont, dass Krypto-Handel ein attraktives Ziel für Cyberkriminelle bleibt. Kryptowährungen bieten hohe finanzielle Anreize und oft geringeres Risiko, da Transaktionen anonym sind und die rechtlichen Rahmenbedingungen in vielen Ländern immer noch unzureichend sind. Dies ermöglicht es Angreifern, mit geringer Wahrscheinlichkeit für ihre Handlungen zur Rechenschaft gezogen zu werden, was die Gefahr weiter erhöht. Die evolutionäre Natur solcher Angriffe erfordert es, dass Nutzer zunehmend geschult werden, um sich gegen AI-gestützte Betrugsversuche zu wappnen. Die Sensibilisierung für die unterschiedlichen Arten von Bedrohungen, die durch Deepfakes entstehen können, ist entscheidend.

Während die technologische Entwicklung voranschreitet, sind die Täter immer raffinierter. Ein CertiK-Ingenieur wies darauf hin, dass das Erkennen von potenziellen Bedrohungen der erste Schritt zur Prävention ist. Dabei ist es von großer Bedeutung, sich über die neuesten Technologien und Sicherheitslösungen zu informieren und skeptisch gegenüber unaufgeforderten Anfragen zu sein. Sich nachdrücklich zu vergewissern, dass keine sensiblen Informationen weitergegeben werden, ist unerlässlich. Aber wie können Nutzer Deepfake-Angriffe erkennen? Corrons nennt einige „rote Fahnen“, auf die man achten sollte.

Anzeichen für gefälschte Inhalte könnten unnatürliche Augenbewegungen, merkwürdige Gesichtsausdrücke oder unpassende Körperbewegungen sein. Wenn das Gesicht einer Person nicht zur geäußerten Emotion passt, ist das ebenfalls ein starkes Indiz. Weitere Warnzeichen sind untypische Körperformen, Unstimmigkeiten und Inkonsistenzen in Audio- und Videoinhalten, die darauf hinweisen könnten, dass man es mit einem Deepfake zu tun hat. Der Faktor Bildung spielt eine entscheidende Rolle. Sicherheitsfirmen empfehlen, regelmäßige Schulungen und Sensibilisierungen für die Nutzer durchzuführen, um mehr Bewusstsein für diese Bedrohungen zu schaffen.

Sicherheitsprotokolle wie die Aktivierung von Multi-Faktor-Authentifizierung für sensible Konten können zusätzlich helfen, die Sicherheit zu erhöhen. Ein gut informierter Nutzer ist schwerer zu täuschen und kann somit einen signifikanten Beitrag zur Verhinderung solcher Angriffe leisten. Ein weiteres Problem betrifft die Synergien, die durch die Kombination von Künstlicher Intelligenz und sozialen Netzwerken entstehen. Die Verbreitung von Deepfake-Technologien in sozialen Medien hat das Risiko von Manipulationen über das Maßen erhöht. Hochentwickelte Deepfake-Technologie könnte verwendet werden, um falsche Informationen oder Behauptungen über Einzelpersonen oder Unternehmen zu verbreiten, was einen noch weiteren Einfluss auf die Gesellschaft haben könnte.

Angriffe, die sowohl auf finanzieller als auch auf sozialer Ebene ansetzen, könnten zu massiven staatlichen oder gesellschaftlichen Unruhen führen. In Anbetracht dieser Anforderungen ist die Bedeutung von Forschung und Entwicklung im Bereich der Sicherheitstechnologie unerlässlich. Es gibt bereits Ansätze, die darauf abzielen, Deepfakes zu erkennen und zu analysieren. Algorithmen können entwickelt werden, um Unstimmigkeiten in Videos zu finden, sogenannte „Schnitte“ oder andere Merkmale, die darauf hindeuten, dass das Material manipuliert wurde. Sicherheitsunternehmen arbeiten aktiv an Lösungen, um die Verbreitung dieser Technologien zu überwachen und den Nutzern Werkzeuge an die Hand zu geben, um sich gegen sie zu schützen.