In der heutigen digitalisierten Welt ist eine schnelle und zuverlässige Datenübertragung essenziell für verschiedenste Anwendungen von einfachen Websuchen bis hin zu komplexen Cloud-Diensten und Videostreaming. Während Begriffe wie Bandbreite und Durchsatz oft in den Vordergrund rücken, rückt Goodput als maßgebliche Größe für die Effizienz einer Datenübertragung zunehmend in den Fokus. Goodput ist nicht einfach nur ein Synonym für die Geschwindigkeit, mit der Daten durchs Netzwerk geschickt werden – vielmehr misst es die tatsächlich nutzbaren, sinnvollen Daten, die ein Empfänger erreicht, exklusive aller Protokoll-Overheads und Wiederholungen. Das Verständnis von Goodput ist somit unverzichtbar, um die wahre Leistungsfähigkeit von Netzwerken realistisch einschätzen zu können und mögliche Flaschenhälse zu identifizieren. Grundsätzlich beschreibt Goodput die Anzahl der nützlichen Informationseinheiten, die pro Zeiteinheit tatsächlich beim vorgesehenen Ziel ankommen.

Es handelt sich dabei um die Nettodatenrate auf Applikationsebene – also jene Datenmenge, die für den Benutzer tatsächlich relevant ist, etwa die Bits eines übertragenen Dokuments oder Videos. Anders als beim Durchsatz, der jeglichen Datenverkehr inklusive Steuerinformationen und Protokoll-Daten misst, wird beim Goodput nur der Anteil einbezogen, der der Applikation direkt zugutekommt. Ein praktisches Beispiel zeigt den Unterschied recht anschaulich: Wenn eine Datei über Ethernet übertragen wird, so besteht diese nicht nur aus den Nutzdaten, sondern auch aus IP- und TCP-Headern sowie Ethernet-Frames. Während der Bruttopayload alle diese Informationen umfasst, ist der Goodput auf die reine Dateigröße begrenzt. Somit kann der Goodput niemals den gesamten Bruttodurchsatz erreichen, zumal auch Protokolleffekte wie Wiederholungen verlorener Pakete oder Steuerungssignale berücksichtigt werden müssen.

Die Ursachen für eine Differenz zwischen der Brutto-Datenrate und dem Goodput sind vielfältig. Zunächst spielen die Protokollebene und deren Overhead eine große Rolle. TCP, das häufig bei Datenübertragungen verwendet wird, nutzt eine Vielzahl von Kontrollmechanismen. Dazu zählen etwa die Flusskontrolle, um Überlastungen der Empfangsseite zu verhindern, und die Staukontrolle, um Überlastungen im Netz zu vermeiden. Diese Mechanismen fügen zusätzliche Paketinformationen und Steuerungsnachrichten hinzu, die zwar den Durchsatz belasten, aber für den Anwender letztlich keine nutzbaren Daten darstellen.

Auch Wiederholungen von Paketen beeinflussen den Goodput negativ. Wenn Datenpakete aufgrund von Fehlern oder Netzwerkkollisionen verloren gehen, sorgt das sogenannte Automatic Repeat reQuest (ARQ) für eine erneute Übertragung der fehlerhaften Pakete. Diese Umschaltung und Wiederholung ist im Bruttodurchsatz enthalten, senkt aber den Goodput, da die effektive Menge an neuen Nutzdaten sinkt. Darüber hinaus wirkt sich die maximale Übertragungseinheit (Maximum Transmission Unit, MTU) auf den Goodput aus. Bei Ethernet liegt die MTU typischerweise bei 1500 Bytes, wovon ein Teil durch Protokollheader belegt wird.

Für IPv4 und TCP beispielsweise sind dies jeweils 20 Bytes, sodass für den eigentlichen Nutzdatentransport oft nur ein Bruchteil, rund 1460 Bytes pro Paket, zur Verfügung steht. Betriebssysteme wie Linux und macOS nutzen unter Umständen noch weitere Header für Zeitstempel und andere Funktionen, was die nutzbare Datenmenge pro Paket weiter verringert. Dadurch entsteht eine unvermeidliche Diskrepanz zwischen Theorie und Praxis. Beim Thema Goodput ist auch die Netzwerklatenz von großer Bedeutung. Verzögerungen beim Versand von Paketen, sogenannte Propagations- und Queuing-Verzögerungen, können zu einer Verlangsamung bei der Datenübertragung führen.

Auch Wartezeiten, die durch TCP bedingt sind, wenn etwa Paketbestätigungen verzögert eintreffen (Delayed ACKs), vermindern den Goodput zugunsten einer stabileren Übertragung. Weiterhin können Faktoren wie Netzwerkstau und Kollisionen im Netzwerk die Netto-Datenrate beeinträchtigen. Besonders in drahtlosen Netzwerken oder in stark ausgelasteten Switch- und Router-Umgebungen kommt es oft zu Paketverlusten und somit zu notwendigen Wiederholungen. Diese beeinträchtigen ebenfalls den Goodput entsprechend. Ein weiterer Aspekt, der oft vernachlässigt wird, ist der Einfluss von NAT (Network Address Translation).

Da die Austauschbarkeit von IP-Adressen in privaten Netzwerken durch NAT geschieht, müssen Router und Firewalls Pakete übersetzen und speichern. Diese zusätzlichen Verarbeitungsschritte verursachen ebenfalls Verzögerungen, die den Goodput schmälern können. Die Messung von Goodput stellt Netzwerktechniker vor Herausforderungen. Im Gegensatz zum Durchsatz, den man relativ einfach am physikalischen Interface ablesen kann, verlangt Goodput eine genaue Analyse auf Anwendungsebene. Dabei muss der Anteil der tatsächlichen Nutzdaten ermittelt und zeitlich erfasst werden.

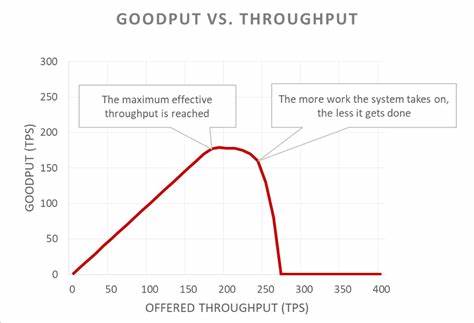

Häufig kommen hierzu Protokollanalysatoren und spezialisierte Testtools zum Einsatz, die neben der Datenmenge auch die Übertragungszeit sowie Paketverluste berücksichtigen. Goodput ist besonders wichtig für Endanwender und Diensteanbieter, da er zeigt, wie performant eine Verbindung in der Praxis wirklich ist. Für einen Videostreamer etwa ist nicht die Brutto-Bandbreite relevant, sondern die tatsächlich ausgelieferte Datenmenge an Videobildern pro Sekunde, also der Goodput. Ähnlich sehen es Online-Spiele, Cloud-Services und jede Anwendung, die auf stabile und effiziente Datenübertragung angewiesen ist. In der Netzplanung und beim Netzmanagement bietet die Betrachtung des Goodputs tiefe Einblicke.

Netzbetreiber können durch seine Analyse Engpässe, ineffiziente Protokollnutzung oder Überlastungen erkennen und geeignete Maßnahmen ergreifen, wie Anpassungen bei der MTU, Optimierungen bei der TCP-Konfiguration oder besseren Einsatz von Quality of Service Mechanismen (QoS). Auch Security-Lösungen profitieren von Erkenntnissen über Goodput, da sie hierbei mögliche Auswirkungen von Firewalls, VPNs oder Intrusion-Prevention-Systemen auf die Effektivität der Datenübertragung beurteilen können. Außerdem ergeben sich durch das Verständnis von Goodput wichtige Erkenntnisse für das Design moderner Protokolle und Netzwerkarchitekturen. Technologien wie Multipath-TCP oder QUIC zielen darauf ab, die Gesamtdatenrate auf Applikationsebene zu erhöhen, indem sie den Goodput optimieren und Latenzzeiten reduzieren. Solche Innovationen zeigen, wie zentral die Optimierung des real genutzten Datentransfers für die Zukunft der Vernetzung ist.

Das Zusammenspiel zwischen Goodput und weiteren Leistungsmetriken im Netzwerk ist komplex und dynamisch. Die physikalische Geschwindigkeit der Verbindung – etwa Gigabit-Ethernet oder moderne Glasfaseranbindungen – bildet zwar die Grundlage, ist aber nur ein Aspekt. Der tatsächlich messbare Goodput wird von der Gesamtarchitektur des Netzwerks, den eingesetzten Protokollen, der Qualität der Hardware und den Bedingungen im Übertragungsweg gleichsam beeinflusst. Für Unternehmen und Organisationen, die auf hohe Datenraten angewiesen sind, ist die gezielte Optimierung des Goodputs daher essenziell. Strategien können den Ausbau und die Anpassung der Infrastruktur, den gezielten Einsatz von Netzwerk-Monitoring-Tools oder das Feintuning von Protokolleinstellungen umfassen.

Auch die Schulung des IT-Personals hin zu einem besseren Verständnis von Goodput und seinen Einflussfaktoren trägt dazu bei, Netzwerke effizienter und nutzerfreundlicher zu gestalten. Nicht zuletzt ist der Goodput auch aus Sicht der Nutzererfahrung von hoher Relevanz. Nutzer merken oft gar nicht, wie viel Bandbreite theoretisch verfügbar wäre, sondern erleben allein die Anwendungsgeschwindigkeit. Wird ein Download durch Protokoll-Overhead, Paketverluste oder Verzögerungen gebremst, sinkt die Zufriedenheit. Gute Netzwerkdienste bemühen sich daher, den Goodput zu maximieren, um die subjektive und objektive Leistungsfähigkeit der Verbindung zu erhöhen.

Zusammenfassend lässt sich sagen, dass Goodput eine fundamentale Größe für das Verständnis und die Optimierung von Netzwerkperformance ist. Während Bruttodurchsatz und Bandbreite wichtige technische Indikatoren darstellen, liefert Goodput die realistische Messung des tatsächlich ankommenden und nutzbaren Datenstroms. In Zeiten immer größerer Datenmengen und wachsender Ansprüche an Echtzeitkommunikation wird seine Rolle unersetzlich, nicht nur für Netzwerktechniker, sondern auch für Anwender und Diensteanbieter. Wer seine Netzwerke zukunftsfähig gestalten möchte, kommt an einer umfassenden Betrachtung des Goodputs nicht vorbei.