Konjunktive Anfragen (Conjunctive Queries, kurz CQ) sind ein grundlegendes Element in der Welt der Datenbanken, insbesondere in OLAP-Systemen, die auf schnelle Analyse großer Datenmengen angewiesen sind. Trotz der scheinbaren Einfachheit steckt in ihrer Verarbeitung eine bemerkenswerte Komplexität, die von klassischen Ansätzen bis hin zu modernen, worst-case optimalen Methoden reicht. Viele Datenbankanwender, Entwickler und sogar Forscher kennen gewisse Grundlagen, scheuen sich aber davor, die verborgenen Details und Herausforderungen dieser Technologie zu ergründen. Hier erhalten Sie einen fundierten Überblick über die wesentlichen Aspekte der konjunktiven Anfrageverarbeitung, von traditionellen binären Joins bis zu den neuesten theoretischen Fortschritten, die das Potential haben, die Zukunft datenintensiver Anwendungen zu prägen.\n\nZunächst ist es wichtig, zu verstehen, was überhaupt eine konjunktive Anfrage ist.

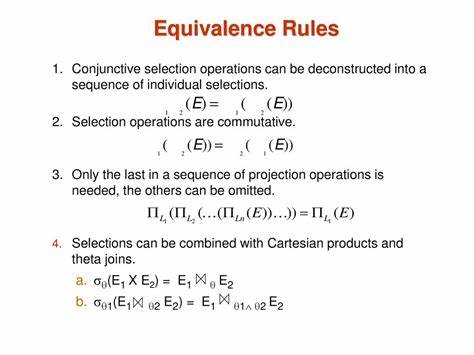

Im Kern handelt es sich um einen Datenbank-Query-Typ, bei dem das Ergebnis durch eine Konjunktion mehrerer Bedingungen definiert wird – also durch eine logische UND-Verknüpfung. Formal lässt sich dies oft über Horn-Klauseln ausdrücken, wobei jede Klausel einer Tabelle und deren Spalten entspricht. Gemeinsame Variablen in verschiedenen Tabellen geben vor, wie diese miteinander verbunden werden, typischerweise durch Join-Operationen. In relationaler Algebra bedeutet das, dass konjunktive Anfragen meist komplexe select–project–join-Befehle darstellen. Ein einfaches Beispiel wäre eine Anfrage, die Daten aus zwei Tabellen miteinander verknüpft, indem sie über eine gemeinsame Spalte verknüpft werden und anschließend bestimmte Spalten im Ergebnis auswählt.

\n\nIn der Praxis ist die Integration von nur zwei Tabellen durch binäre Join-Algorithmen wie Hash Join oder Sort-Merge Join relativ unproblematisch. Hash Joins beispielsweise funktionieren, indem eine Relation auf einem Join-Attribut in eine Hashtabelle übertragen wird und dann die andere Relation durchlaufen wird, um passende Datensätze effizient zu finden. Diese Technik skaliert jedoch nur bedingt, wenn immer mehr Tabellen einbezogen werden oder die Verknüpfungsmuster komplex werden. Ein typisches Beispiel sind dreifache oder sogar noch umfangreichere Joins, bei denen sich die Frage stellt, in welcher Reihenfolge die einzelnen Tabellen zusammengeführt werden, um möglichst wenig Zwischenergebnisse und somit Ressourcenkosten zu verursachen.\n\nDie Wahl der Join-Reihenfolge hat nicht nur Performance-Auswirkungen, sondern auch auf den Speicherverbrauch und die Parallelisierbarkeit des Vorgangs.

Eine typische Umsetzung unter Verwendung von binären Joins setzt Zwischenergebnisse ein, die in temporären Speichern gehalten werden. Das Einfügen solcher Zwischenpuffer generiert zusätzliche Kosten, da neben der eigentlichen Join-Berechnung auch das Speichern, Lesen und Verwalten dieser Puffern zeit- und speicherintensiv sein kann. Ein alternatives Modell nutzt Pipelining, bei dem Zwischenergebnisse nicht vollständig materialisiert, sondern direkt von einer Join-Operation zur nächsten durchgereicht werden. Dieses Vorgehen senkt den Speicherbedarf deutlich, erlaubt außerdem eine natürliche Parallelisierung auf modernen Multikernsystemen, indem verschiedene Teilmengen der Daten gleichzeitig verarbeitet werden.\n\nAllerdings bringt Pipelining auch Herausforderungen mit sich.

Daten mit starker Schieflage – wie bei sozialen Netzwerken, in denen einzelne populäre Knoten viele Verbindungen haben – führen zu ungleichmäßiger Arbeitsverteilung. Das Ergebnis sind ausgebremste Threads oder Prozessoren, die lange auf die Fertigstellung anderer warten, was die Skalierbarkeit einschränkt. In solchen Fällen bieten sich hybride Ansätze an, etwa die Vectorization, die eine Balance zwischen vollständiger Materialisierung und Pipelining schafft, indem kleine Batches verarbeitet werden. Hierdurch wird die Cache- und Speicher-Auslastung optimiert, während die Berechnung besser parallelisiert bleibt. Dennoch ist die genaue Umsetzung solcher Verfahren komplex und unterscheidet sich stark je nach Hardwarearchitektur, weshalb weiterhin intensive Forschung in diesem Gebiet betrieben wird.

\n\nEin zentrales Thema bei der Verarbeitung konjunktiver Anfragen ist die Abschätzung der möglichen Ergebnisgröße. Dies ist entscheidend für die Wahl der effizienten Join-Pläne und die Abschätzung des Ressourcenbedarfs. Klassische analytische Modelle nehmen oft eine Worst-Case-Betrachtung vor, bei der das join-Ergebnis das Produkt der Resultatgrößen der beteiligten Relationen sein könnte. In der Realität ist dies jedoch meist pessimistisch und führt zu ineffizienten Planungen. Die Forschung hat daher versucht, präzisere Schranken zu definieren.

Ein bedeutender Fortschritt wurde durch das sogenannte AGM-Bound-Modell erzielt, das auf der Idee eines fraktionalen Edge-Covers im zugehörigen Abfragegraphen basiert. Hierbei werden Relationen und Attribute als Knoten und Kanten modelliert und mittels linearer Optimierung präzise Obergrenzen für die Ausgabemenge berechnet. Diese Methode erlaubt es, die theoretisch höchsten Datenmengen zu prognostizieren, die durch eine Join-Operation erzeugt werden können, was in der Planung und Optimierung von Abfragen eine fundamentale Rolle spielt.\n\nDas AGM-Bound-Modell war auch Inspirationsquelle für die Entwicklung worst-case optimaler Join-Algorithmen. Im Gegensatz zu klassischen join-Strategien, die oft paarkombinatorische Prozesse mit potenziell schlecht skalierten Zwischenergebnissen ausführen, zielen diese Algorithmen darauf ab, genau so viele Zwischenschritte und Speicherzugriffe wie unbedingt nötig zu verwenden.

Diese Verfahren arbeiten häufig rekursiv, wobei an jedem Schritt eine Variable der Anfrage ausgewählt und deren mögliche Werte iterativ eingegrenzt werden. Eine besonders effektive Implementierung basiert auf trie-basierten Datenstrukturen, die es erlauben, Teilmengen effizient zu durchsuchen und nur gültige Kombinationen weiter zu verfolgen.\n\nEin bekannter Vertreter dieser Algorithmen ist der Leapfrog Triejoin (LFTJ). Mit LFTJ lassen sich die Spaltenwerte der beteiligten Relationen auf sortierte Weise durchlaufen und die Schnittmengen in einer Weise berechnen, die das Worst-Case Ergebnis asymptotisch optimal erreicht. Hierbei werden Iteratoren für jeden Join-Attribut-Wert parallel bewegt und synchronisiert, bis gemeinsame Werte, also Ergebnisse der Join-Operation, gefunden werden.

Die Verwendung von geordneten tries erfordert zwar zusätzliche Vorverarbeitung und beeinflusst Zugriffszeiten, bietet aber eine Pipeline-unterstützende Struktur, die speichereffiziente Verarbeitung großer Joins ermöglicht.\n\nNeben diesen spezialisierten Verfahren hat sich die Forschungscommunity mit dem Konzept des Free Join beschäftigt. Free Join ist ein framework-artiger Ansatz, der traditionelle Joins, worst-case-optimale Joins und sogar frühe Materialisierungsideen vereint. Die Idee ist, das komplexe Join-Problem in kleinere Komponenten, sogenannte Subatoms, zu zerlegen und diese flexibler und feingranularer zu verarbeiten. Dieses Modell erlaubt es, sowohl die Vorteile von zeitversetzten Materialisierungen als auch von interaktiven Iteratoren und spaltenbasierten Operationen zu kombinieren.

Darüber hinaus ermöglichen neue Datenstrukturen wie der Lazy Generalized Hash Trie (LGHT) eine hochparallele und speichereffiziente Implementierung in Hardwaresystemen, die sonst durch Datenabhängigkeiten oder Zugriffsstrategien limitiert wären.\n\nNichtsdestotrotz befindet sich die Parallelisierung worst-case optimaler Join-Algorithmen noch in den Kinderschuhen. Die nicht triviale Arbeitsverteilung, die Handhabung von Datenverzerrungen und der Einsatz moderner Hardware wie GPUs oder SIMD-Einheiten stellen derzeit bedeutende Herausforderungen dar. Einige aktuelle Forschungsansätze setzen auf dynamisches Work-Stealing, adaptive Batch-Größen oder auch Änderung der Query-Pläne zur besseren Auslastung von Parallelhardware und Vermeidung von Flaschenhälsen. Hier sieht die Community großes Entwicklungspotential, das zukünftig zu deutlich performanteren Analysesystemen führen könnte.

\n\nZusammenfassend lässt sich sagen, dass die Verarbeitung konjunktiver Anfragen ein spannendes und vielfältiges Feld mit zahlreichen Herausforderungen ist, die weit über einfache Join-Algorithmen hinausgehen. Von der mathematisch fundierten Abschätzung der Ergebnisgrößen über flexible und speicheroptimierte Join-Techniken bis hin zur allgegenwärtigen Problematik effizienter Parallelisierung auf modernen Hardware-Plattformen entsteht derzeit eine spannende Forschungslandschaft. Anwendung finden diese Methoden sowohl in klassischen Datenbanksystemen als auch in Big Data Frameworks und Analyse-Plattformen, was ihre gesellschaftliche und wirtschaftliche Bedeutung zusätzlich unterstreicht. Wer sich hier vertieft auskennt, kann nicht nur bessere Performanz aus Datenbanken herausholen, sondern auch die Grundlage für innovative datenbasierte Lösungen legen.