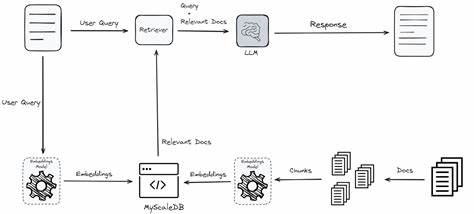

Die rasante Entwicklung von Künstlicher Intelligenz (KI) hat die Art und Weise, wie wir Informationen verarbeiten und generieren, grundlegend verändert. Insbesondere die Verbindung von großen Sprachmodellen (Large Language Models, LLMs) mit externen Wissensquellen durch Retrieval-Augmented-Generation-Systeme (RAG) markiert einen bedeutenden Fortschritt. Diese Systeme kombinieren die Fähigkeit moderner Sprachmodelle zur Erstellung kohärenter Texte mit der Möglichkeit, relevante Dokumente oder Informationen aus umfangreichen Datenbanken abzurufen. So entstehen Ergebnisse, die nicht nur flüssig formuliert sind, sondern auch faktenbasiert und präzise. Doch trotz ihres Potenzials stehen RAG-Systeme vor einer grundlegenden Herausforderung: Es bleibt oft unklar, ob Fehler bei der Antwortgenerierung darauf zurückzuführen sind, dass die Modelle den bereitgestellten Kontext nicht richtig nutzen, oder ob der Kontext selbst schlichtweg nicht ausreichend ist, um die Frage präzise zu beantworten.

Ein innovativer Ansatz, der jüngst in der Forschung vorgestellt wurde, führt das Konzept des „ausreichenden Kontexts“ ein und liefert damit eine neue Perspektive auf die Analyse von RAG-Systemen. Der Begriff beschreibt, ob die bereitgestellten Kontextinformationen für die Beantwortung einer spezifischen Frage vollständig genug sind. Diese Unterscheidung ist essenziell, um Fehlerquellen zu identifizieren, die für die Weiterentwicklung dieser Systeme von grundlegender Bedeutung sind. Die Bedeutung von ausreichendem Kontext in RAG-Systemen lässt sich am besten in Bezug auf zwei zentrale Fragestellungen verdeutlichen: Zunächst, ob das Modell einen Fehler macht, weil es die verfügbaren Informationen nicht korrekt verarbeitet, oder zweitens, weil ihm schlicht die nötigen Informationen fehlen. Die Erkenntnisse aus dieser Analyse ermöglichen eine gezieltere Verbesserung der Modelle, sei es durch besseres Training, optimiertes Abrufsmanagement oder die Entwicklung neuer Strategien zur Fehlervermeidung.

Größere Sprachmodelle wie Gemini 1.5 Pro, GPT 4o oder Claude 3.5 zeigen dabei ein besonders interessantes Verhalten. Sie glänzen mit einer hohen Genauigkeit, wenn ihnen ausreichender Kontext zur Verfügung steht und meistern die Beantwortung der meisten Fragestellungen zuverlässig. Allerdings neigen sie dazu, bei unzureichendem Kontext trotzdem eine Antwort zu generieren, anstatt eine sogenannte Abstinenz zu zeigen und keine Antwort zu geben.

Dies führt in solchen Fällen zu sogenannten Halluzinationen, bei denen die Antwort zwar überzeugend klingt, aber faktisch falsch ist. Das Problem der Halluzination ist eine bekannte Schwäche in großen Sprachmodellen und wird durch diese Erkenntnisse in einem neuen Licht betrachtet. Im Gegensatz dazu zeigen kleinere Modelle wie Mistral 3 oder Gemma 2 eine größere Zurückhaltung. Sie neigen dazu, entweder abzulehnen zu antworten oder Fehler zu machen, selbst wenn eigentlich ausreichender Kontext existiert, der richtig verarbeitet werden könnte. Diese Tendenz geht mit einer höheren Rate an Abwesenheit von Antworten oder „Abstinenz“ einher, was die Zuverlässigkeit zumindest teilweise verbessert, aber auf Kosten der Entscheidungsfreudigkeit funktioniert.

Ein weiterer bemerkenswerter Befund betrifft Fälle, in denen der Kontext zwar nicht vollständig alle Informationen für eine perfekte Antwort liefert, aber dennoch hilfreich ist und die Modellleistung verbessert. Hier zeigt sich, dass selbst unvollständige externe Kontextdaten einen positiven Einfluss auf die Antwortgenauigkeit ausüben können. Ohne diesen Kontext würden die Modelle häufiger falsche oder zu allgemeine Antworten generieren. Das verdeutlicht die Bedeutung einer differenzierten Bewertung der Kontextnützlichkeit und nicht nur der absoluten Vollständigkeit. Ausgehend von diesen wissenschaftlichen Erkenntnissen wurden verschiedene Strategien zur Reduzierung der Halluzinationen in RAG-Systemen entwickelt.

Eine besonders vielversprechende Methode ist die sogenannte selektive Generierung, bei der das Modell auf Basis von Informationen zum ausreichenden Kontext gesteuert wird. Dies drückt sich darin aus, dass das System die Entscheidung treffen kann, wann es antwortet und wann es besser ist, keine Antwort zu geben, um Fehlinformationen zu vermeiden. Dieser Ansatz steigert die Qualität der generierten Antworten und macht sie vertrauenswürdiger, insbesondere in kritischen Anwendungen wie Medizin, Recht oder wissenschaftlicher Forschung. Die Relevanz dieser Forschung liegt nicht nur in der Optimierung bestehender Systeme, sondern auch in der Verbesserung zukünftiger Anwendungen, die auf Retrieval-Augmented-Generation setzen. Von Chatbots und virtuellen Assistenten über automatisierte Kundenservice-Systeme bis hin zu intelligenten Suchmaschinen profitieren diese Technologien unmittelbar von einer präzisen Bewertung und Umschichtung des Kontextbegriffs.

Aufgrund der zunehmenden Verfügbarkeit großer Datenmengen wächst das Potenzial von RAG-Systemen stetig. Umso wichtiger ist es, mit geeigneten Methoden die Qualität und Verlässlichkeit der generierten Ergebnisse sicherzustellen. Das Konzept des ausreichenden Kontexts als neuer Analyseansatz bietet eine fundierte Grundlage für diesen Prozess und fördert die Entwicklung noch robusterer KI-Systeme. Die praktische Umsetzung dieser Erkenntnisse wurde unter anderem durch speziell entwickelte Autorater-Methoden unterstützt, die automatisiert die Qualität und Angemessenheit von Antworten bewerten. Dabei werden nicht nur inhaltliche Richtigkeit, sondern auch die Entscheidung zur Antwortabgabe oder zum Verzicht darauf einbezogen.

Dies führt zu einer transparenten und nachvollziehbaren Leistungsbeurteilung, die für Anwender und Entwickler gleichermaßen von Vorteil ist. Darüber hinaus ist das Auffinden und Teilen von best practices essenziell für die Community. Die Veröffentlichung von Schlüsselbefunden und verwendeten Prompt-Vorlagen auf offenen Plattformen wie GitHub ermöglicht es Forschern und Entwicklern weltweit, die Methoden nachzuvollziehen, anzupassen und weiterzuentwickeln. Dieses Vorgehen fördert den offenen Austausch und beschleunigt die Innovationszyklen im Bereich der KI. Das Zukunftspotenzial von Retrieval-Augmented-Generation-Systemen ist enorm.

Wenn geeignete Methoden zur zuverlässigen Kontextbewertung und Fehlerreduktion angewandt werden, können diese Systeme nicht nur informativere und präzisere Antworten liefern, sondern auch vertrauenswürdiger, sicherer und vielseitiger eingesetzt werden. Damit nimmt der „neue Blick“ auf RAG-Systeme eine Schlüsselrolle für die Zukunft der Künstlichen Intelligenz ein. Insgesamt zeigt die Forschung, wie wichtig der Kontext für das Zusammenspiel von Informationsabruf und Textgenerierung ist. Fehlerursachen können effizienter lokalisiert und behandelt werden, was die Leistungsfähigkeit von RAG-Systemen weiter steigert. Der Fortschritt in diesem Bereich wird dabei helfen, vielfältige Anwendungsgebiete von KI intelligenter und nutzerfreundlicher zu gestalten – ob im Bereich Bildung, Gesundheit, Medien oder Wirtschaft.

Es ist zu erwarten, dass sich diese Erkenntnisse in den nächsten Jahren in vielen Formen der KI-Interaktion widerspiegeln und die Art, wie wir mit Maschinen kommunizieren und arbeiten, grundlegend verändern werden. Die Erforschung des ausreichenden Kontexts markiert einen bedeutenden Schritt auf diesem Weg und bietet wertvolle Impulse, um den Einsatz von Künstlicher Intelligenz sicherer, effektiver und vor allem vertrauenswürdiger zu machen.

![We Tested Google Veo and Runway to Create This AI Film [video]](/images/03DDE5CF-90A5-4952-82C0-21DEBA379860)