Die fortschreitende Digitalisierung und das exponentielle Datenwachstum stellen Unternehmen vor immer komplexere Herausforderungen bei der Auswahl der richtigen Datenbanklösung. Während einige Organisationen in der Vergangenheit auf moderne verteilte Datenbanken wie CockroachDB gesetzt haben, erkennen viele mit dem Wachstum ihres Datenvolumens und veränderten Geschäftsanforderungen die Vorteile einer Migration zu PostgreSQL. Die Migration zu Postgres bietet nicht nur Kosteneinsparungen, sondern auch deutliche Verbesserungen in Performance, Wartungsfreundlichkeit und Ökosystem-Unterstützung. Eine der größten Herausforderungen bei der Skalierung von datenintensiven Anwendungen ist die Balance zwischen Verfügbarkeit, Skalierbarkeit und Kosten. CockroachDB punktet hier vor allem durch eine mühelose horizontale Skalierung und eine native Multi-Region-Unterstützung, was gerade bei extrem verteilten Architekturen von Vorteil ist.

Jedoch zeigen sich bei einem eher zentralisierten Setup mit einfachen Transaktionsanforderungen die Nachteile einer derart hoch skalierbaren Lösung. Die Kosten explodieren und Performance-Einschränkungen durch zeitweilige Timeout-Probleme werden spürbar. Gerade bei Datenbanken mit gigantischem Wachstum, wie es bei einigen Startups und etablierten Unternehmen der Fall ist, können Migrationsprozesse zu einer schweren operativen Hürde werden. Beispielsweise wurden bei CockroachDB wiederholt Migrationsprozesse zum Stillstand gebracht, weil ORM-Tools wie Prisma bei der Anwendung von Schemaänderungen regelmäßig Timeout-Probleme hatten. Diese Verzögerungen können den gesamten Deployment-Prozess blockieren und das Entwicklerteam zwingen, manuelle Eingriffe vorzunehmen, was die Gefahr von Fehlern erhöht und zeitliche Effizienz verringert.

Postgres stellt hier durch seine robuste und bewährte Struktur einen großen Vorteil dar. Die Migrationsdauer und -stabilität verbessern sich maßgeblich, wie Tests zeigen: Veränderungen an großen Tabellen können dort oft in Sekunden statt Stunden durchgeführt werden, was die Produktivität massiv steigert. Dies wirkt sich letztlich auch auf die Agilität des Unternehmens aus und ermöglicht schnellere Weiterentwicklungen der Applikationen. Neben der Migration und Schema-Anpassung ist der Datenexport und Import (ETL-Prozess) ein weiterer kritischer Punkt. Viele moderne ETL-Werkzeuge unterstützen CockroachDB nicht vollumfänglich oder befinden sich noch in einem frühen Entwicklungsstadium mit instabilen Features wie Speicherlecks.

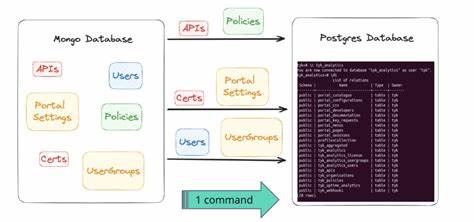

Dadurch entstehen häufig Ausfälle und es wird mehr Zeit für Fehlerbehebung als für den wertschöpfenden Einsatz der Daten aufgewendet. In einem solchen Szenario empfiehlt es sich, eine eigene maßgeschneiderte Lösung zu bauen, die auf bewährten Technologie-Stacks basiert. Beispielsweise kann eine Kombination aus effizienten Skripten, die tabellenweise Daten in einem kompatiblen Format exportieren und reinen CSV-Datenstreams verwenden, die Migration ohne Datenverlust und unter minimaler Downtime durchführen. Solche Prozesse decken auch oft unterschwellige Kompatibilitätsprobleme zwischen den Datenbankformaten ab, etwa bei JSON- oder Array-Typen, die zwischen verschiedenen Systemen leicht variieren können. Ein wesentlicher Punkt bei der Wahl der Datenbank ist die Performance von Abfragen.

CockroachDB kann dank seines optimierten Query-Planners in bestimmten spezialisierten Fällen schneller sein, vor allem bei komplexen Aggregationen, die er clever auf die Knoten des verteilten Systems verteilt. Dennoch zeigt die Praxis, dass die überwiegende Mehrheit der echten Produktruns seltener von diesem Vorteil profitieren. Im Gegenteil sind viele komplexe, durch ORM-Tools generierte SQL-Statements aufgrund ihrer Komplexität und der daraus resultierenden vollständigen Table-Scans bei CockroachDB oft deutlich langsamer als bei Postgres. Die Struktur und Architektur von Postgres lässt sich hervorragend an die Anforderungen moderner Applikationen anpassen. Komplexe Joins, Indizierungen und verschiedene Optimierungen führen zu signifikant geringeren Latenzzeiten.

Erfahrungen aus realen Weltanwendungen bestätigen, dass besonders in Szenarien mit stark verzweigten Relationen und vielen Nebenabfragen Postgres die Performance auf ein deutlich höheres Level hebt. Dabei profitiert Postgres von seinem umfangreichen Ökosystem, das Tools wie PGAnalyze und diverse Extensions bereitstellt, mit denen die Datenbank kontinuierlich überwacht und optimiert werden kann. Neben diesen technischen Effekten verbessert die Migration auch die Entwicklererfahrung signifikant. Bei PostgreSQL ist das Abbrechen oder Stoppen von laufenden Abfragen viel einfacher und sicherer möglich, was bei einer verteilten Datenbanklösung wie CockroachDB dagegen oftmals kompliziert und fehleranfällig ist. Auch die Zuverlässigkeit der Verbindungen spielt eine wichtige Rolle: Periodische Konnektivitätsprobleme, wie sie bei CockroachDB über VPN-Tools und Cloud-Umgebungen auftreten können, führen zu Ausfällen und Frustration im Entwicklerteam.

Darüber hinaus wirkt sich eine Migration auch auf den Support aus. Postgres verfügt über eine breite Community und bewährte kommerzielle Anbieter, die schnellen und kompetenten Service gewährleisten. Im Gegensatz dazu stehen teils schwer zugängliche Supportportale bei neuen Datenbankangeboten und lange Wartezeiten auf Reaktionen, die im kritischen Fehlerfall zu erheblichen Produktionsausfällen führen können. Die Kosten sind bei den meisten Datenbanklösungen ein entscheidendes Argument. Die Ausgaben für vertriebene und hoch skalierte Systeme wie CockroachDB können schnell in die Hunderttausende gehen, was gerade bei weniger komplexen, transaktionsorientierten Anwendungen als zu teuer empfunden wird.

Die Migration zu PostgreSQL ermöglicht es, Betriebskosten drastisch zu senken, ohne signifikante Funktionalität einzubüßen. Dies hat nicht nur direkte finanzielle Folgen, sondern erleichtert auch die langfristige Planung und das Wachstum des Unternehmens. Viele Unternehmen unterschätzen im Vorfeld den Aufwand für eine solche Migration. Ein wichtiger Teilprozess ist das sorgfältige Abgleichen der Datenformate und -schemas mit dem neuen System sowie das Anpassen der Applikationslogik und ORM-Generierung. Dennoch können mit geeigneten Tools und durch eine schrittweise Migrationsstrategie Downtimes minimiert und Risiken begrenzt werden.

Aus den Erfahrungen eines Unternehmens, das jahrelang auf CockroachDB setzte, aber schließlich wegen steigender Kosten, Performanceproblemen und mangelnder Stabilität zu Postgres wechselte, lassen sich wertvolle Learnings ableiten. Der Umstieg war technisch zwar herausfordernd, doch durch eine clevere selbstentwickelte ETL-Pipeline und native Postgres-Features konnte die Migration in weniger als einer Stunde abgeschlossen werden – bei Null Datenverlust und besserer Systemperformance. Nach der Migration kam es zu einer sofort messbaren Reduktion der durchschnittlichen Antwortzeiten von Anfragen, was zu einer spürbar besseren Nutzererfahrung führte. Darüber hinaus wurde innerhalb kürzester Zeit ein Teil der Datenbankabfragen durch gezielte Optimierungen weiter beschleunigt. Die Entwickler konnten sich somit wieder voll auf die Produktentwicklung konzentrieren statt auf Workarounds für Systemprobleme.

Abschließend lässt sich festhalten, dass die Wahl der richtigen Datenbanklösung dynamisch ist und von den jeweiligen Anforderungen des Geschäftsmodells abhängt. Während ein verteiltes System wie CockroachDB für einige use cases ideal erscheint, kann eine Migration zu PostgreSQL angesichts von Stabilität, Kosten und Performancevorteilen für viele Unternehmen ein strategisch richtiger Schritt sein. Der Ökosystemvorteil von Postgres, die massive Verbreitung im Markt und die große Community machen diesen Schritt auch langfristig attraktiv. Unternehmen profitieren nicht nur kurzfristig durch niedrige Betriebskosten, sondern sind auch gut gerüstet für zukünftige Erweiterungen und eine nachhaltige Skalierung. Somit empfiehlt es sich für Softwareentwickler, Architekten und Entscheidungsträger, die Anforderungen regelmäßig zu überprüfen und ggfs.

eine Migration in Betracht zu ziehen, um technologische und wirtschaftliche Vorteile zu sichern.