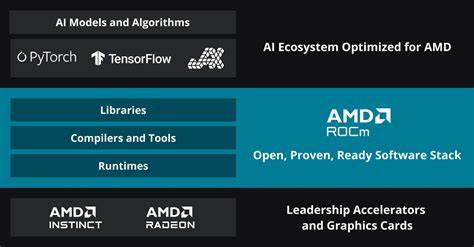

Die Zusammenarbeit zwischen Red Hat und AMD markiert einen bedeutenden Schritt in der Weiterentwicklung offener GPU-Stacks für den Bereich der künstlichen Intelligenz. In einer Zeit, in der skalierbare und effiziente Hardware- und Softwarelösungen im KI-Sektor immer wichtiger werden, bündeln beide Unternehmen ihre Ressourcen, um Innovationen voranzutreiben und die Leistungsfähigkeit von KI-Anwendungen maßgeblich zu steigern. Dabei steht insbesondere die Unterstützung moderner AI-Workloads auf AMD Instinct GPUs im Fokus, die in Kombination mit der etablierten Red Hat Softwareplattform eine optimale Basis für Entwickler, Unternehmen und Forschungsinstitute bildet. AMD bringt mit seinen Instinct MI300X Beschleunigern erstklassige GPU-Hardware ein, die speziell für hohe Rechenanforderungen von KI-Modellen ausgelegt ist. Red Hat stellt mit OpenShift AI eine flexible Container-Plattform bereit, die es ermöglicht, künstliche Intelligenz und maschinelles Lernen reibungslos in bestehende Infrastrukturen zu integrieren.

Die Kombination von Red Hats Expertise im Linux- und Open-Source-Umfeld mit AMDs leistungsfähiger Hardware schafft einen hochmodernen Stack, der sowohl durch Performance als auch durch Offenheit überzeugt. Ein zentraler Bestandteil der Kooperation ist die sogenannte Upstream-Integration des AMD Kernel-Library. Durch das Einbringen dieser speziellen Bibliothek in den Linux-Kernel wird die Performance von KI-Workloads auf AMD GPUs entscheidend verbessert. Neben der Optimierung des Triton-Kernels, einer wichtigen Komponente für die Ausführung neuronaler Netzwerke, widmen sich die Teams auch der Weiterentwicklung von FP8-Arithmetik, einer neuartigen Berechnungsmethode, die insbesondere bei tiefen neuronalen Netzen Effizienzgewinne verspricht. Diese technischen Fortschritte führen dazu, dass sowohl dichte KI-Modelle als auch quantisierte Versionen schneller und ressourcenschonender auf AMD Instinct GPUs laufen.

Parallel zu den Performance-Verbesserungen arbeitet die Partnerschaft intensiv an der Ausweitung der Multi-GPU-Unterstützung. In der Praxis sind viele moderne KI-Anwendungen auf verteilte Rechenressourcen angewiesen, da einzelne GPUs trotz ihrer Leistungsfähigkeit oft nicht ausreichen, um riesige Modelle oder sehr umfangreiche Datensätze effizient zu verarbeiten. Die Verbesserung der kollektiven Kommunikation zwischen mehreren GPUs reduziert Datenstau und erhöht die Gesamtdurchsatzrate. Somit entsteht eine skalierbare Infrastruktur, die sowohl energieeffizient als auch hoch performant ist. Dies eröffnet neue Möglichkeiten für Unternehmen, komplexe KI-Projekte auf Basis von AMD Hardware innerhalb des Red Hat Ökosystems umzusetzen.

Darüber hinaus setzen Red Hat und AMD auf eine starke Einbindung in die Open-Source-Community, namentlich die vLLM-Initiative. vLLM ist ein aufstrebendes Projekt, das sich der Geschwindigkeit und Effizienz von Large Language Model Inferenz widmet. Die gemeinsame Arbeit mit Industriepartnern wie IBM trägt zur steten Verbesserung der zugrundeliegenden Softwarebibliotheken bei, sodass Anwender langfristig von einer stabilen, optimierten und leicht zugänglichen Plattform profitieren. Die projektübergreifende Kollaboration stellt sicher, dass neueste Hardwarefunktionen auch zeitnah in Open-Source-Software integriert werden, was wiederum der gesamten AI-Community zugutekommt. Darüber hinaus wird die Unterstützung von AMD Instinct GPUs in der Red Hat AI Inference Server Software vorangetrieben.

Diese Serverlösung richtet sich speziell an Unternehmen, die AI-Modelle produktiv betreiben möchten und dabei auf hohe Verfügbarkeit, Skalierbarkeit und vereinfachtes Management Wert legen. Die nahtlose Integration von AMDs Hardware in diese Softwareplattform erleichtert die Bereitstellung von KI-Diensten, selbst bei anspruchsvollsten Workloads. Die Partnerschaft reflektiert einen Trend in der IT-Branche, der weg von proprietären und hin zu offenen, transparenteren Software- und Hardware-Stacks führt. Die Kombination aus Red Hats tiefgehender Erfahrung mit Open-Source-Betriebssystemen und Container-Technologien sowie AMDs Innovationskraft im Bereich der GPU-Beschleunigung stellt sicher, dass zukünftige KI-Entwicklungen auf einer soliden und flexiblen Basis aufbauen können. Dies ist gerade deshalb wichtig, weil KI-Anwendungen immer mehr an Bedeutung gewinnen – sei es in der Medizin, im autonomen Fahren, in der Industrieautomatisierung oder in der Kommunikation.

Ein weiterer Vorteil dieser Zusammenarbeit liegt in der nachhaltigen Ausrichtung auf Energieeffizienz. Das Optimieren von Multi-GPU-Szenarien und das Reduzieren unnötiger Rechenzyklen kommen nicht nur der Performance zugute, sondern tragen auch zu einem geringeren Gesamtenergieverbrauch bei. Damit unterstützt die Kooperation Unternehmen dabei, ihre KI-Infrastrukturen umweltfreundlicher zu gestalten und gleichzeitig Kosten zu sparen. Dies ist vor allem im Vergleich mit anderen großen Marktteilnehmern relevant. Während einige Anbieter ihre KI-Stacks vorwiegend proprietär gestalten, setzen Red Hat und AMD konsequent auf Offenheit und gemeinschaftliche Entwicklung.

Dadurch profitieren Entwickler und Nutzer von umfassender Transparenz, schneller Fehlerbehebung sowie einer breiten Auswahl an Tools und Frameworks, die mit der Hardware harmonieren. Insgesamt entsteht durch die enge Kooperation von Red Hat und AMD ein Ökosystem, das in Sachen Skalierbarkeit, Leistungsfähigkeit und Flexibilität neue Maßstäbe setzt. Die gemeinsame Arbeit an der Upstream-Integration, der Multi-GPU-Unterstützung und der vLLM-Community schafft Synergien, die AI-Inferenz und Training auf AMD Instinct GPUs deutlich effizienter machen. Firmen, die auf moderne KI-Infrastruktur setzen möchten, erhalten damit ein zukunftssicheres Angebot, das sowohl auf bewährten Open-Source-Prinzipien als auch auf modernster Hardwaretechnologie basiert. Von der Hardware über das Betriebssystem bis hin zur AI-Laufzeitumgebung entsteht so eine ganzheitliche Lösung, die für unterschiedlichste Anforderungen im KI-Bereich geeignet ist – ob für ressourcenintensive Forschung oder für den produktiven Einsatz in Unternehmen.

Diese strategische Partnerschaft zeigt eindrucksvoll, wie wichtig offene Zusammenarbeit und der Fokus auf Innovationen sind, um den Herausforderungen im dynamischen Feld der Künstlichen Intelligenz gerecht zu werden.