Die rasante Entwicklung von Large Language Models (LLMs) wie GPT-4 und Qwen hat vielfältige Anwendungsbereiche eröffnet. Ob bei der Generierung von Texten, dem Verstehen komplexer Zusammenhänge oder der automatischen Beantwortung von Fragen – LLMs scheinen in vielen Bereichen menschliche Fähigkeiten zu imitieren oder sogar zu übertreffen. Eine besonders spannende und zugleich kontroverse Fragestellung ist, wie gut solche Modelle darin sind, Menschen zu bewerten und ein Ranking von Personen zu erstellen. Dies wirft nicht nur technische, sondern auch ethische und gesellschaftliche Fragen auf. Die Idee, KI-Modelle für das Ranking von Personen einzusetzen, ist nicht neu.

Unternehmen verwenden bereits Algorithmen, um Lebensläufe zu bewerten, Sozialmedia-Profile zu analysieren oder Bewerber:innen in Rekrutierungsprozessen zu ordnen. Doch das direkte Ranking durch ein Sprachmodell, das auf Basis von Textinput versucht, beispielsweise Bewerber:innen für eine bestimmte Position zu bewerten, stellt eine besondere Herausforderung dar. Hierbei geht es nicht nur um das Erkennen von Fähigkeiten, sondern auch um die Einschätzung von Soft Skills, Persönlichkeit oder kultureller Passung, die im Text verborgen sein können. Ein wesentlicher Aspekt bei der Bewertung durch LLMs ist ihre vermeintliche Sicherheit in Aussagen. Trotz bekannter „Halluzinationen“ – falscher oder erfundener Informationen – wirken LLMs oft sehr selbstbewusst in ihren Antworten.

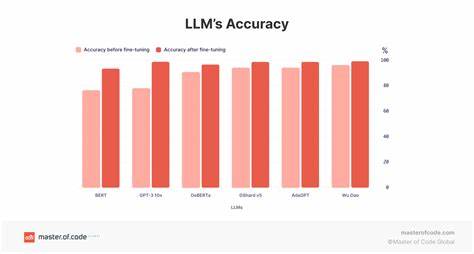

Diese „Vertrauenswürdigkeit“ ist nicht gleichzusetzen mit echter Kompetenz oder sicherem Wissen, sondern resultiert häufig aus dem Training und der Instruktion, die auf eine überzeugende Kommunikation ausgelegt ist. Modelle zeigen selten Unsicherheit oder sagen „Ich weiß es nicht“, da solche Formulierungen in der Regel nicht im Sinne einer flüssigen Nutzererfahrung sind. Wenn es darum geht, zwischen Personen zu unterscheiden und die geeignetere Person für eine Aufgabe herauszufiltern, fällt dieser Mangel an echter Unsicherheit besonders ins Gewicht. Schwächere Modelle tendieren dazu, wenig differenzierende Urteile zu fällen und stattdessen Gleichwertigkeit zu betonen. Aussagen wie „beide sind intelligent“ oder „beide haben relevante Fähigkeiten“ sind häufig und reflektieren eher eine Folge von begrenztem Verständnis als von echtem Erkenntnisgewinn.

Stärkere Modelle können zwar durchaus genauere Einschätzungen treffen, gleichzeitig besteht jedoch die Gefahr, dass diese Einschätzungen auf oberflächlichen oder irrelevanten Kriterien basieren. Eine Herausforderung liegt darin, dass Modelle bei der Beurteilung von Personen fast ausschließlich auf den zugelieferten Textdaten basieren. Soziale Nuancen, Kontext oder verborgene Qualitäten lassen sich oft nicht aus Text alleine erschließen. Betrachtet man etwa Hackernews-Kommentare oder Bewerbungsanschreiben, so können dort enthaltene Informationen zwar Aufschluss über Fachwissen oder Kommunikationsfähigkeit geben, doch persönliche Integrität, Teamfähigkeit oder Kreativität sind weitaus schwerer zu erfassen. Darüber hinaus müssen Rankings gewisse logische Konsistenzkriterien erfüllen.

Wenn ein Modell Person A gegenüber Person B bevorzugt und Person B gegenüber Person C, sollte es auch Person A gegenüber Person C bevorzugen, um widerspruchsfrei zu sein. Ist dies nicht der Fall, sprechen Fachleute von einem Verstoß gegen die sogenannte Transitivität. Bei LLMs zeigen sich hierin häufig Schwächen, da sie vergleichende Einschätzungen stets isoliert treffen und sich nicht an vorherigen Urteilen orientieren. In experimentellen Tests, bei denen LLMs wiederholt Paarvergleiche durchführen müssen, zeigte sich, dass selbst bei großen Modellen mit Milliarden von Parametern intransitive und widersprüchliche Urteile kein seltenes Phänomen sind. Manche Modelle werden beispielsweise durch zufällige Faktoren beeinflusst, oder sie wählen Basismerkmale wie die alphabetische Reihenfolge als Hauptkriterium für ein Ranking.

Diese Oberflächeinschätzungen führen zu höchst unzuverlässigen und inkonsistenten Ergebnissen. Ein weiteres Problem ist der Umgang der Modelle mit Unsicherheit und der Ausdruck von Vertraulichkeit. Um die Bewertung gezielter zu gestalten, können statistische Systeme wie das ELO-Rating eingesetzt werden, das ursprünglich im Schach verwendet wird, um Spielerfähigkeiten zu bewerten. Dieses System berücksichtigt dabei nicht nur einzelne Vergleiche, sondern aggregiert viele Paarvergleiche zu einer Gesamtbewertung. Die Höhe der daraus resultierenden Werte kann Hinweise darauf geben, wie sicher ein Modell in seinen Präferenzen ist.

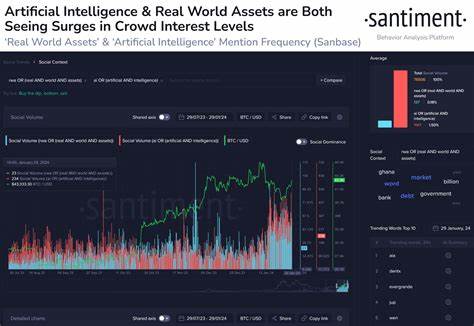

Das Auftragen solcher Bewertungen über Zeit illustriert, dass verlässlichere Modelle einen klareren, konsistenteren Verlauf der Rankingwerte zeigen, während weniger konsistente Modelle ständig schwanken oder nur innerhalb enger Wertebereiche verbleiben. Interessanterweise zeigen einige kleinere Modelle dank längerer Kontextlängen oft konsistentere Bewertungen als größere Modelle mit kürzeren Kontexten, was auf die Bedeutung der Datenmenge und -qualität hinweist. Obwohl diese experimentellen Ansätze Aufschluss über die technische Leistungsfähigkeit von LLMs geben, bleibt die Frage bestehen, wie sinnvoll und verantwortungsvoll es ist, Personen über solche automatischen Rankings zu bewerten. Bereits heute existieren viele dokumentierte Fälle von Bias, Diskriminierung und Fehlurteilen, die auf Vorurteile in Trainingsdaten zurückzuführen sind. LLMs spiegeln solche Verzerrungen wider oder verstärken sie sogar, wenn sie unreflektiert für Entscheidungen eingesetzt werden.

Somit ist Vorsicht geboten, wenn es darum geht, LLMs für Rankings von Menschen heranzuziehen, insbesondere für wichtige Entscheidungen etwa in Personalwesen, Bildung oder sozialen Kontexten. Entscheidend ist ein menschliches Controlling, die Reflexion von Modellergebnissen und die Berücksichtigung ethischer Standards. Technisch gesehen sind LLMs interessant, weil sie in einer komplexen und subjektiven Bewertungssituation dennoch eine gewisse Kontinuität und logische Kohärenz erreichen können. Doch sollten sie niemals die alleinige Entscheidungsinstanz sein. Die Zukunft könnte dennoch von einer sinnvollen Kombination aus menschlicher Expertise und KI profitieren.

Wenn LLMs mit umfangreichen, qualitativ hochwertigen Daten versorgt werden und ihre Unsicherheiten klar kommunizieren, können sie als wertvolle Werkzeuge zur Unterstützung bei Entscheidungsprozessen dienen. Automatisierte Bewertungen könnten Talentpotenziale frühzeitig identifizieren, Defizite aufzeigen oder dadurch personalisierte Förderung ermöglichen. Gleichzeitig sollten Forscher und Entwickler weiterhin daran arbeiten, die Fähigkeiten der Modelle zur Beurteilung von Menschen transparenter, nachvollziehbarer und fairer zu machen. Ansätze wie die Integration von Unsicherheitsindikatoren, das Verhindern von Inkonsistenzen in Ranglisten oder die Berücksichtigung vielfältiger Merkmale können die Qualität der Bewertungen verbessern. Auch das Aufdecken und Korrigieren von Biases in Trainingsdaten und Modellarchitekturen ist ein zentraler Schritt.

Im Kern bleibt jedoch die Erkenntnis, dass LLMs trotz ihrer beeindruckenden technischen Kompetenzen und dem scheinbar überlegenen Weltverständnis Grenzen haben, wenn es um die facettenreiche und tiefgründige Einschätzung menschlicher Qualitäten geht. Die Bewertung eines Softwareingenieurs, Forschers oder jeden anderen Menschen über Kommentare oder Texte ist eine komplexe Aufgabe mit weitreichenden Implikationen. Ein starker Algorithmus ist noch kein Garant für eine gute Beurteilung – vielmehr müssen die erzielten Resultate immer kritisch hinterfragt werden. Zusammenfassend lässt sich sagen, dass LLMs durchaus das Potenzial besitzen, sinnvolle Rankings zu erstellen, solange man ihre Stärken und Schwächen versteht. Sie sind hilfreich bei der Analyse großer Textmengen und können kognitive Muster erkennen.

Doch ihre derzeitige Fähigkeit, Menschen konsistent, differenziert und vor allem fair zu ranken, ist noch nicht ausgereift. Die Forschung auf diesem Gebiet ist weiterhin spannend und wird maßgeblich dazu beitragen, wie wir in Zukunft Menschen durch KI bewerten und unterstützen. Nur mit einem bewussten und reflektierten Umgang kann das Vertrauen in solche automatisierte Bewertungen wachsen – und einen echten Mehrwert schaffen.