Die Wahl der richtigen Datenbank ist für Unternehmen von großer Bedeutung und beeinflusst maßgeblich die Performance, Skalierbarkeit und Kostenstruktur. Im Umfeld moderner Anwendungen, insbesondere in der Cloud, stehen oftmals hoch skalierbare verteilte Datenbanklösungen wie CockroachDB im Fokus. Trotz zahlreicher Vorteile wie nahtloser horizontaler Skalierung und Multi-Region-Support stößt diese Technologie beim Einsatz mit wachsendem Datenvolumen und Komplexität gelegentlich an Grenzen. Erfahrungen aus der Praxis zeigen, wie und warum eine Migration zurück zu PostgreSQL in manchen Fällen sinnvoll sein kann und wie diese erfolgreich umgesetzt wird. Seit Anfang 2022 setzte ein wachsendes Unternehmen auf CockroachDB, um von dessen besonderen Eigenschaften wie hoher Verfügbarkeit und einem SQL-kompatiblen Interface zu profitieren.

Die eingebauten Möglichkeiten zur verteilten Speicherung über mehrere Regionen hinweg erschienen zu Beginn als perfekte Lösung, um zukunftssichere Multi-Region-Anforderungen, beispielsweise aus Datenschutzgründen wie der DSGVO, zu erfüllen. Im Verlauf der Zeit zeigte sich jedoch, dass der tatsächliche Bedarf für komplexe Multi-Region-Szenarien ausblieb. Stattdessen gestalteten sich die alltäglichen Datenzugriffe überwiegend als einfache, transaktionale Queries innerhalb einer einzelnen Region. Während der Wachstumskurs des Unternehmens hielt an, stiegen jedoch auch die Kosten für die Nutzung von CockroachDB stark an – bereits bis 2024 erreichten die monatlichen Ausgaben mitunter das Fünffache und lagen im mittleren sechsstelligen Bereich. Dieses finanzielle Ungleichgewicht zwischen Nutzen und Aufwand wurde zunehmend kritisch hinterfragt.

Parallel traten technische Herausforderungen auf, die sich negativ auf die Entwicklungs- und Deployment-Prozesse auswirkten. Ein zentrales Problem bildeten zunehmend die Datenbankmigrationsvorgänge. Bei der Anwendung von Schema-Änderungen mit dem im Unternehmen verwendeten Object-Relational-Mapper Prisma kam es immer wieder zu Timeouts seitens CockroachDB. Die Folge waren blockierte Deployments für teilweise mehrere Stunden, was die Entwickler dazu zwang, Migrationen manuell und einzeln auf Datenbankebene anzustoßen – ein Prozess, der sowohl fehleranfällig als auch zeitintensiv war. Im direkten Vergleich erwies sich PostgreSQL bei identischen Migrationen als deutlich effizienter.

So konnte eine vergleichbare Schemaänderung auf einer rückgespielten Datenbankinstanz binnen Sekunden durchlaufen, ohne Timeouts oder lockierende Effekte. Die manuelle Umgehung von Migrationproblemen, die eine ernsthafte Gefahr für die Datenbankstabilität und den Entwicklungsworkflow darstellten, wurde somit überflüssig. Neben den Migrationen beeinträchtigten die engen Timeouts auch ETL-Prozesse, die für Datenintegrität und Analyse unerlässlich sind. Der Versuch, über Airbyte Daten aus CockroachDB zu extrahieren und zu replizieren, scheiterte an mangelnder Stabilität und Bugs wie Speicherlecks. Schließlich stand das Unternehmen vor der Herausforderung, eine eigene ETL-Lösung zu entwickeln, um das Datenvolumen effizient in PostgreSQL zu übertragen.

Auch bei der Performanz gab es unterschiedliche Beobachtungen. Während CockroachDB dank seines Optimizers bei bestimmten komplexen Abfragen eine bessere Antwortzeit erzielen konnte, schnitten viele Alltagsabfragen im Postgres-Umfeld deutlich besser ab – teilweise sogar um den Faktor zwanzig. Ursache hierfür waren vor allem die von Prisma erzeugten komplizierten SQL-Statements, die CockroachDB nicht immer optimal optimieren konnte. PostgreSQL hingegen zeigte sich durch sein ausgereiftes Query-Optimierungssystem und seine bessere Kompatibilität mit Werkzeugen wie PGAnalyze überlegen. Ein weiterer praktischer Aspekt im Umgang mit CockroachDB waren die wiederkehrenden Einschränkungen bei der Verwaltung und Nutzerfreundlichkeit.

Beispielsweise war das Abbrechen laufender komplexer Abfragen wesentlich umständlicher und risikoreicher als bei PostgreSQL, da Entwickler oft in der Konsole per Hand eingreifen mussten. Auch die Sichtbarkeit und Handhabung von ungenuzten Indizes führte zu Verwirrung und Mehrarbeit. Aus Sicht des Supports waren die Prozesse erschwert, insbesondere durch getrennte Portale mit getrennter Authentifizierung. Im Falle von kritischen Bugs, welche den Datenbankbetrieb beeinflussten, waren verzögerte Reaktionszeiten und das erneute Eingeben bekannter Cluster-Informationen hinderlich und prägen das Bild einer weniger effizienten Community-Anbindung. Nicht zuletzt gab es regelmäßige Netzwerkprobleme durch instabile VPC-Verbindungen mit Tailscale, die teilweise zu Ausfällen führten – Probleme, die im PostgreSQL-Umfeld nie in vergleichbarer Form auftraten.

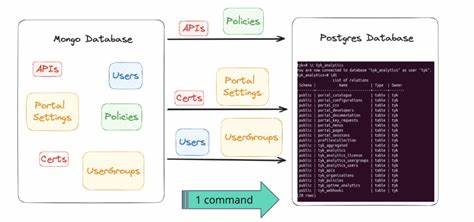

Das eigentliche Migrationsvorhaben stellte beim Umgang mit mehreren Hundert Millionen Datensätzen die größte operative Herausforderung dar. Nach Prüfung vorhandener, aber nicht ausgereifter ETL-Tools wurde entschieden, eine eigene Lösung mithilfe des modernen JavaScript-Ökosystems und speziell des aufkommenden Tools Bun zu entwickeln. Dabei wurden Daten aus CockroachDB schrittweise in CSV-Dateien exportiert und durch parallel laufende Prozesse in PostgreSQL importiert. Das größte Problem stellte sich in der Übertragung komplexer Datentypen wie JSON und Arrays heraus, deren interne Kodierung in CockroachDB vom Postgres-Standard leicht abweicht. Mittels maßgeschneiderter CSV-Parsing-Pipelines gelang es, diese Unterschiede zu überbrücken und eine exakte Datenkonvertierung zu gewährleisten.

Der eigentliche Produktivumzug wurde in einem sorgfältig geplanten Wartungsfenster durchgeführt, wobei auf einer leistungsstarken VM in der Cloud gearbeitet wurde. Der Downtime-Bereich lag bei unter einer Stunde, was im operativen Alltag gut verkraftbar war. Im Anschluss an die Migration konnte eine signifikante Verbesserung der Latenzzeiten bei Anfragen von etwa einem Drittel beobachtet werden. Durch die Nutzung von PostgreSQL-spezifischen Analysewerkzeugen wurden zudem in kurzer Zeit mehrere abfrageoptimierende Maßnahmen eingeleitet. Diese zusätzlichen Optimierungen führten zu einer deutlich stabileren, schnelleren und kosteneffizienteren Datenbankproduktion.

Ein nicht unwesentlicher Erfolgsfaktor war die Erfahrung des Teams und die Bereitschaft, in die Entwicklung individuell angepasster Tools zu investieren. Die Migration zu PostgreSQL war nicht nur eine technische, sondern auch eine finanzielle Entscheidung: Der erzielte Kostenvorteil betrug mehr als 100.000 US-Dollar pro Jahr, bei gleichzeitig verbesserter Performance und Wartbarkeit. Für Unternehmen, die heute auf verteilte Datenbanken setzen, jedoch nicht alle angebotenen Features ausnutzen oder durch unerwartete Performanceengpässe geplagt werden, kann eine Rückkehr zu etablierten, gut unterstützten Systemen wie PostgreSQL durchaus lohnenswert sein. Wichtige Aspekte für eine erfolgreiche Migration sind neben fundierten Tests insbesondere das Verständnis für Datenformate und das Design von ETL-Prozessen.

Ebenso empfehlenswert ist der Einsatz moderner ORM-Tools, die migrationsfreundliche Workflows ermöglichen. Zukunftssicher ist zudem, dass PostgreSQL durch eine breite Community kontinuierlich weiterentwickelt wird. Werkzeuge für Monitoring, Performance-Analyse und Query-Optimierung sind zahlreich und bewährt. Damit bleibt PostgreSQL auch für wachsende und komplexer werdende Anwendungen eine flexible und wirtschaftliche Datenbanklösung. Die Wahl der Datenbank sollte folglich stets den tatsächlichen Anforderungen und Wachstumserwartungen entsprechen.

Nicht selten empfiehlt es sich, hohe Kosten und operative Risiken eines zu komplexen Systems gegen die Stabilität und Effizienz bewährter Technologien abzuwägen. Die beschriebenen Erfahrungen zeigen exemplarisch, wie mit gewissenhaften Planungsschritten und technischer Innovationsfreude eine Migration von CockroachDB zu PostgreSQL reibungslos umgesetzt und dauerhaft wirtschaftlich gestaltet werden kann.