Die Welt der künstlichen Intelligenz und insbesondere der Sprachmodelle entwickelt sich mit beeindruckender Geschwindigkeit. Mit jeder neuen Innovation eröffnen sich neue Möglichkeiten, um komplexe Aufgaben besser zu lösen und den Einsatzbereich von KI nachhaltig zu erweitern. Eine der neuesten und vielversprechendsten Entwicklungen in diesem Bereich ist Simple Test-Time Scaling, oft abgekürzt als S1. Diese Methode stellt eine elegante und zugleich effektive Strategie dar, um die Leistung von Sprachmodellen während ihrer Anwendung merklich zu verbessern. S1 basiert auf der Idee, das Testzeit-Computing gezielt und intelligent zu erweitern.

Klassischerweise werden Sprachmodelle nach ihrem Training eingesetzt, und die Performance ist weitgehend durch die im Vorfeld festgelegten, statischen Modelleigenschaften bestimmt. Test-Time Scaling bricht mit dieser Herangehensweise, indem es dem Modell erlaubt, mehr Rechenzeit oder zusätzliche Verarbeitungsschritte während der eigentlichen Anwendung zu nutzen, um die Qualität der resultierenden Antworten zu erhöhen. Dadurch kann das Modell seine internen Denkprozesse anpassen und verfeinern, ohne dass während des Trainingszugriffs neues Datenmaterial oder weitere Optimierungen benötigt werden. Die Grundlage von S1 fußt auf einer neu erstellten Datensammlung namens s1K, welche 1.000 sorgfältig kuratierte Fragen mit zugehörigen, nachvollziehbaren Problemlösungswegen enthält.

Die Auswahlkriterien für diesen Datensatz waren streng: Herausforderungen müssen ausreichend komplex sein, die Fragen sollen thematisch vielfältig und die Qualität der Lösungen außergewöhnlich hoch sein. Dies stellt sicher, dass das Modell auf einem reichen und anspruchsvollen Fundament trainiert wird, welches seine Fähigkeit zum schrittweisen Denken und gründlichen Überprüfen von Antworten wesentlich fördert. Eine besonders innovative Komponente von S1 ist das sogenannte Budget Forcing. Hierbei handelt es sich um ein Verfahren, bei dem das Modell bewusst dazu gebracht wird, seine Denkzeit zu verlängern oder vorzeitig zu beenden. Konkret kann das Modell den generativen Prozess durch das Hinzufügen von „Wait“-Token mehrmals verlängern, wenn es versucht, die Antwort zu beenden.

Dies simuliert, dass das Modell innehält und seine vorherigen Überlegungen noch einmal prüft. In der Praxis führt dies oft dazu, dass Fehler in den Denkprozessen erkannt und korrigiert werden, was die Genauigkeit der Ergebnisse signifikant verbessert. Dieses Prinzip des kontrollierten Verweilens oder der zeitlichen Streckung des Denkprozesses ist deshalb so erfolgreich, weil Sprachmodelle bei komplexeren Anfragen oftmals mehrere Überlegungen und Korrekturschleifen benötigen, bevor eine optimale Antwort entsteht. Ohne Test-Time Scaling sind sie häufig gezwungen, eine Antwort innerhalb eines festen, starren Zeitrahmens zu generieren, was die Tiefe und Qualität der Überlegungen limitiert. Der Einfluss von Simple Test-Time Scaling zeigt sich deutlich beim Fine-Tuning des großen Sprachmodells Qwen2.

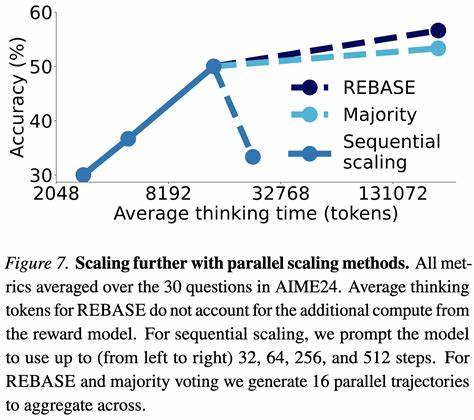

5-32B-Instruct. Nach dem trainieren mit dem s1K-Datensatz und der Integration von Budget Forcing übertrifft das daraus entstandene Modell s1-32B die vorherigen Leistungsbestmarken, etwa das OpenAI-Modell o1-preview, bei anspruchsvollen mathematischen Problemen aus Wettbewerben wie MATH und AIME24 um bis zu 27 Prozent. Dieser Erfolg demonstriert eindrucksvoll, wie gezieltes Testzeit-Computing die Grenzen konventioneller Sprachmodelle sprengen kann. Noch beeindruckender ist, dass durch das Skalieren von s1-32B mit Budget Forcing eine Art extrapolative Verbesserung erreicht wird, die über das hinausgeht, was durch herkömmliches Training möglich wäre. So steigert sich die Genauigkeit auf der AIME24-Aufgabe von 50 auf 57 Prozent, was für solche komplexen Problemlösungen eine beachtliche Steigerung darstellt.

Diese Fähigkeit, während der Anwendung mehr Rechenressourcen adaptiv einzusetzen, eröffnet völlig neue Perspektiven für KI-Systeme in Bereichen, in welchen präzise und tiefgründige Analysen unabdingbar sind. Die gesamte Methodik, inklusive des Datensatzes, des Codebases und des trainierten Modells, ist unter einer offenen Lizenz verfügbar, was die Transparenz und Nachvollziehbarkeit der Ergebnisse fördert. Dies ist besonders wichtig, da viele leistungsstarke KI-Modelle nicht öffentlich zugänglich sind oder deren Trainings- und Optimierungsprozesse nicht offengelegt werden. Durch die Offenheit von S1 können Forschende und Entwickler auf der ganzen Welt an der Weiterentwicklung und Anwendung dieser Technik mitwirken. Simple Test-Time Scaling unterstreicht damit die Bedeutung von „Denkzeit“ für Sprachmodelle – ähnlich wie Menschen, die komplexe Probleme oft erst durch wiederholtes Überdenken lösen.

Während KI-Modelle bisher oft als black-box-Systeme betrachtet wurden, ermöglicht dieses Framework eine tiefergehende Kontrolle und Steuerung der internen Verarbeitungsprozesse, was zu höherer Effektivität und Verlässlichkeit führt. Zukunftsweisend ist auch das Potenzial von S1, auf verschiedenste Domänen übertragbar zu sein. Sei es in der Forschung, der automatischen Textgenerierung, im Bildungsbereich oder in spezialisierten Aufgaben wie der Verarbeitung juristischer oder medizinischer Dokumente – überall dort, wo komplexe logische und analytische Schlussfolgerungen gefragt sind, kann Test-Time Scaling die Qualität und Verlässlichkeit der Ergebnisse nachhaltig verbessern. Darüber hinaus fördert S1 die effizientere Nutzung von Rechenressourcen, da die Investition in zusätzliche Testzeit nur gezielt dann erfolgt, wenn sie einen echten Mehrwert bringt. Dies steht im Gegensatz zu aufwendigen Trainingszyklen oder überdimensionierten Modellen, die enorme Ressourcen verbrauchen, aber nicht immer proportional bessere Ergebnisse liefern.

Im Zusammenspiel von modernster Modellarchitektur, intelligentem Testzeit-Management und hochwertigem, sorgfältig kuratiertem Trainingsmaterial stellt Simple Test-Time Scaling einen bedeutenden Schritt in der Evolution der KI dar. Er zeigt nicht nur, wie man Leistungsbarrieren durch kluge Software-Ansätze überwindet, sondern auch, wie innovative Ideen die Art und Weise verändern, wie Maschinen Probleme angehen und lösen. Für Unternehmen, Forschende und Technikenthusiasten eröffnet sich mit S1 eine spannende Möglichkeit, Sprachmodelle effizienter, intelligenter und anpassungsfähiger zu gestalten. Dies wird langfristig dazu beitragen, die Mensch-Maschine-Interaktion natürlicher, vertrauenswürdiger und produktiver zu machen – ein essentieller Fortschritt in Richtung einer Zukunft, in der KI den Alltag durch präzise und verlässliche Unterstützung bereichert.