In der Welt der künstlichen Intelligenz und automatisierten Kundenservices sind Retrieval-Augmented Generation (RAG)-Modelle derzeit sehr beliebt. Sie versprechen, durch das Einbinden von externem Wissen beim Beantworten von Fragen präzisere und umfassendere Antworten zu liefern. Doch wenn Chatbots ausschließlich auf diese Technik setzen, treten zahlreiche Probleme auf, die nicht nur das Nutzererlebnis verschlechtern, sondern auch immense Kosten verursachen können. Es zeigt sich immer mehr: RAG-Only-Chatbots sind nicht die ultimative Lösung, sondern verdienen durchdachte Hybridansätze, um im Alltag zu bestehen. Denn ohne eine gezielte Steuerung und Kombination mit anderen Systemen stoßen reine RAG-Modelle an entscheidende Grenzen, die grundsätzlich auf die Art und Weise zurückzuführen sind, wie sie Informationen suchen, verarbeiten und bereitstellen.

Ein wesentlicher Schwachpunkt liegt in ihrer Reaktionsgeschwindigkeit. Selbst in Testumgebungen mag eine einzelne Recherchekette wenige Hundert Millisekunden dauern. Im produktiven Einsatz jedoch, wenn ein Index Millionen von Dokumenten umfasst und komplexe Re-Rankings stattfinden müssen, verlängert sich die Antwortzeit deutlich. Für Kunden wirkt das wie eine Verzögerung, die Frustration auslöst und dadurch das Vertrauen in die Automatisierung untergräbt. Parallel dazu steigt der finanzielle Aufwand.

Die Nutzung langlaufender Cross-Encoder und leistungsstarker LLMs verbraucht erhebliche Rechenressourcen, welche sich in hohen Kosten für Unternehmen niederschlagen. Der Finanzverantwortliche wirft also schnell einen argwöhnischen Blick auf die Rechnung am Monatsende. Neben diesen Performance- und Kostendimensionen ist ein weiteres, gravierendes Problem die Zuverlässigkeit und Präzision der Antworten. RAG-Systeme sind nur so gut wie ihr zugrundeliegender Dokumentenkorpus und dessen Indexierung. Wenn der Datenbestand nicht akribisch gepflegt wird, sorgt dies häufig für irrelevante oder gar falsche Informationen in der Antwort.

Solche Halluzinationen – plausible, aber faktisch falsche oder erfundene Inhalte – beschädigen das Nutzervertrauen nachhaltig. Anwender erkennen schnell, wenn ein Chatbot Unsinn erzählt oder wichtige Details fehlen, was sie oftmals wieder zurück zum menschlichen Support zwingt. Unternehmen, die allein auf ein RAG-Modell vertrauen und auf die Pflege eines sauberen Index verzichten, finden sich häufig in einem Strudel von Nachjustierungen, nervenaufreibenden Bugfixes und ständigen Support-Anfragen wieder. Die Versprechungen schneller Wissensbereitstellung verfehlen ihr Ziel, wenn man nicht parallel ein belastbares, kuratiertes System betreibt. Hier kommt das Konzept einer FAQ-Links-Schicht ins Spiel, die sensibel und gezielt auf die am häufigsten gestellten Fragen setzt.

Die Erfahrung zeigt, dass rund 70 bis 90 Prozent der Kundenanfragen sich auf immer ähnliche Themen konzentrieren: Passwortzurücksetzungen, Abrechnungsfragen, grundlegende Konfigurationen. Für diese klassischen Supportfälle wünschen Nutzer schnelle, präzise Antworten ohne Umwege. Ein kleiner, gut gepflegter Index mit FAQ-Links zeigt direkt auf die passenden Dokumentensegmente und spart somit die Aufwände einer vollständigen Recherche durch riesige Datenbestände. Diese FAQ-Ebene erfüllt gleich mehrere Funktionen: Antwortgenauigkeit, da die Antworten auf verifizierten und meist menschlich geprüften Dokumenten beruhen; hohe Geschwindigkeit, da eine Suche im kleinen FAQ-Index blitzschnell möglich ist; geringere Halluzinationsrisiken, weil ausschließlich geprüfte Textausschnitte genutzt werden. Die Pflege eines solchen FAQ-Systems ist anfangs sicherlich aufwendig, aber dank moderner KI-Methoden lassen sich viele Schritte automatisieren.

LLMs helfen, relevante Nutzerfragen aus Dokumenten zu generieren, passende Antworten aus den Texten zu extrahieren und sogar erste Verifizierungen durchzuführen. So reduziert sich der manuelle Aufwand drastisch, und die Qualität bleibt hoch. Natürlich sind FAQ-Links keine Allheilmittel für alle Fragestellungen. Edge Cases, komplexe technische Fragen oder neuartige Szenarien kommen vor, die in keinem FAQ erfasst sind. Hier erweist sich RAG als unverzichtbarer Fallback, der mit seiner breiten Recherchekapazität sorgt, dass in seltenen Fällen trotzdem eine Antwort generiert wird, wenn auch aufwändiger und langsamer.

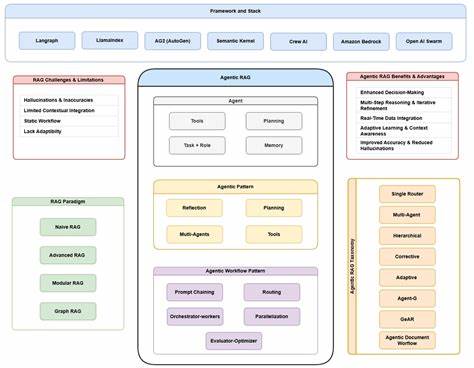

RAG bleibt somit die aussichtsreiche Ergänzung und nicht der primäre Motor der Antwortlogik. Ein innovativerer Ansatz, der über das reine RAG hinausgeht, ist das sogenannte GraphRAG, bei dem Dokumenteninhalte zu Knowledge Graphs verarbeitet werden. Diese bieten den Vorteil, Zusammenhänge und Abhängigkeiten zwischen Entitäten transparent darzustellen und komplexe, mehrstufige Fragestellungen präzise zu beantworten. Doch die Ressourcen- und Wartungsanforderungen sind hoch, weshalb sich diese Technologie vornehmlich für spezialisierte Anwendungsfälle eignet, etwa technische Ingenieur-Assistenten. Aus Praxissicht wirkt eine durchdachte Kombination aus FAQ-Links und RAG-Fallback am stärksten.

Dabei wird die Nutzeranfrage zunächst gegen den kleinen, schnellen FAQ-Index abgeglichen. Erreicht die Ähnlichkeit einen gewissen Schwellenwert, erfolgt die Antwort über vorgeprüfte Verlinkungen und präzise Dokumentausschnitte, die vom LLM lediglich zusammengeführt werden. Scheitert die Übereinstimmung, greift das System auf die vollständige RAG-Pipeline zurück, um Suchergebnisse aus dem großen Dokumentenkorpus zu generieren, diese zu re-ranken und schließlich eine Antwort zu formulieren. Der Vorteil dieses Ansatzes zeigt sich deutlich in der Performance: 70 bis 90 Prozent der Anfragen laufen mit minimalem Zeitaufwand und Kosten ab und sind zudem äußerst präzise. Nur für die verbleibenden 10 bis 30 Prozent wird der komplexere Prozess genutzt.

Gleichzeitig wird so eine Wartbarkeit gewährleistet, da das FAQ-Set regelmäßig aktualisiert werden kann, Eingriffe in das RAG-System selten und kontrolliert erfolgen und eine kontinuierliche Anpassung auf Basis realer Nutzungsdaten möglich ist. Die Betreuung des FAQ-Index, angereichert durch KI-Unterstützung bei der Generierung und Prüfung neuer Einträge, sorgt dafür, dass das System mit dem Produkt und den Nutzeranforderungen wächst. Zudem bietet die Hybridarchitektur eine klarere Nachvollziehbarkeit der Antworten. Nutzer sehen die Quellen und können bei Bedarf auf die hinterlegten Dokumentenseiten zugreifen, was Vertrauen aufbaut und Missverständnisse minimiert. Folgefragen und Gesprächskontexte lassen sich durch die geschickte Verknüpfung von FAQs adressieren, was dem Bot ein natürlicheres Verständnis verleiht.

Ein weiteres häufig geäußertes Argument gegen RAG ist die Komplexität des Datenmanagements und Bedenken hinsichtlich Datenschutz und Compliance. Auch hier bietet die Kombination Vorteile: Indem das FAQ-System ausschließlich geprüfte und freigegebene Inhalte referenziert und das RAG-Indexing gezielt auf konforme Dokumente beschränkt wird, lässt sich ein sicherer Rahmen schaffen. Moderne Automatisierungstools sorgen dafür, dass beim Einpflegen neuer Dokumente diese auf mögliche private oder sensible Daten überprüft werden, wodurch unkontrollierte Datenlecks vermieden werden. Für viele Unternehmen ist der Schritt zu reinem RAG oder nur fine-getunten LLMs verlockend wegen des vermeintlichen Einsparpotenzials im Erstellungsprozess. Doch der Aufwand für kontinuierliche, teure Neu-Trainingsprozesse und der Verlust an Aktualität und Genauigkeit führen oft zu schlechteren Ergebnissen als ein wohlüberlegter Hybridansatz.

Mit intelligenter FAQ-Pflege und gezieltem RAG-Einsatz lässt sich ein dauerhaft hohes Service-Level aufrechterhalten, das sowohl Kundenzufriedenheit steigert als auch die Betriebskosten niedrig hält. Abschließend lässt sich festhalten, dass das blinde Vertrauen auf reine RAG-Modelle im chatbotgestützten Kundenservice eine Sackgasse darstellt. Die Erfahrung zeigt, dass eine Kombination aus einem sorgfältig gepflegten FAQ-Links-Index mit einem RAG-Fallback die Effektivität, Schnelligkeit und Präzision von Chatbots erheblich steigert. Sie sorgt für geringere Betriebskosten, minimiert die Risiken von Halluzinationen und schafft Vertrauen bei Anwendern. Unternehmen sollten daher einen Hybridansatz anstreben, in dem häufige und vorhersehbare Nutzerfragen schnell und exakt beantwortet werden und komplexere, seltene Anfragen intelligent und nachvollziehbar behandelt werden.

So lässt sich das Versprechen intelligenter, effizienter Chatbots nachhaltig erfüllen und die Kundenzufriedenheit signifikant steigern.