In der modernen Welt der künstlichen Intelligenz und Agentensysteme spielt die effiziente Nutzung von Ressourcen und die Optimierung von Ergebnissen eine zentrale Rolle. Die Pareto-Frontier, auch bekannt als Pareto-Grenze oder Pareto-Effizienz, bildet dabei ein fundamentales Konzept, das hilft, den optimalen Kompromiss zwischen verschiedenen konkurrierenden Zielen zu identifizieren. Besonders im Bereich der agentenbasierten Systeme, bei denen unterschiedliche Aufgaben mit begrenztem Budget, Zeit oder Rechenleistung erledigt werden müssen, eröffnet die Betrachtung der Pareto-Frontier neue Möglichkeiten für eine gezielte und nachhaltige Optimierung. Agenten, ob Software-Agenten oder autonome Systeme, operieren meist unter multiplen Zielsetzungen, die sich oft gegenseitig ausschließen oder in Konkurrenz stehen. So könnte ein Agent darauf ausgelegt sein, eine hohe Genauigkeit bei der Entscheidungsfindung zu erreichen und gleichzeitig Kosten sowie Latenzzeiten möglichst gering zu halten.

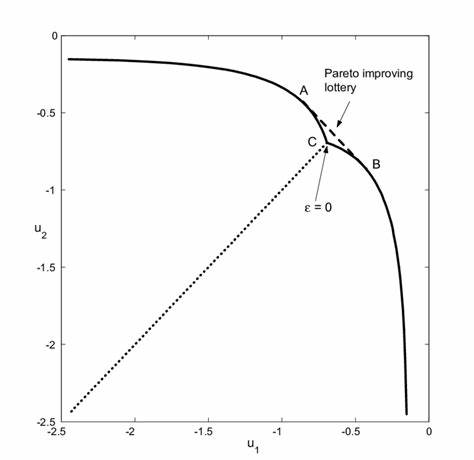

Die Herausforderung besteht darin, eine Konfiguration oder einen Workflow zu finden, der eine ideale Balance bietet – genau hier kommt die Pareto-Frontier ins Spiel. Die Pareto-Frontier beschreibt dabei einen Satz von Lösungen, bei denen keine einzelne Zielgröße ohne Verschlechterung einer anderen verbessert werden kann. Mit anderen Worten stehen alle Punkte auf dieser Front in einem optimalen Verhältnis zueinander, ohne dass ein Ziel objektiv dominiert wird. Für die Optimierung von Agenten bedeutet das, dass die Pareto-Frontier die Menge aller kompromissfähigen Lösungen repräsentiert, aus denen je nach Priorisierung ausgewählt werden kann. Moderne Agentenoptimierungstools wie syftr haben sich darauf spezialisiert, diese Frontier effizient zu bestimmen.

syftr verwendet dabei Multi-Objective Bayesian Optimization in Kombination mit neuartigen Pruning-Techniken, um aus einer Vielzahl von möglichen Agenten-Workflows und -Modellparametern die besten Pareto-optimalen Kombinationen zu finden. Die Algorithmen arbeiten dabei besonders effizient in großen und heterogenen Suchräumen und ermöglichen eine schnellere und ressourcenschonendere Evaluation der Agentenfähigkeiten. Ein zentrales Element bei der Implementierung dieser Optimierung ist die genaue Definition der Zielgrößen. Typischerweise werden Leistungsmessungen wie Genauigkeit, Kosten für Anfragebearbeitung oder Durchsatz mit Einflüssen auf Echtzeitbedingungen wie Latenz kombiniert. Dadurch entsteht ein komplexes Gefüge von Zielen, die gegeneinander abgewogen werden müssen.

Die Pareto-Frontier stellt die Grundlage dar, auf der Entwickler und Data Scientists fundierte Entscheidungen treffen können, welche Agentenkonfiguration den spezifischen Anforderungen und Randbedingungen eines Projekts am besten entspricht. Neben der kosteneffizienten Verbesserung klassischer NLP-Modelle bzw. Large Language Models bietet die Optimierung anhand der Pareto-Frontier auch Vorteile bei der Auswahl von Einbettungsmodellen und Agentenstrategien. Flexible Konfigurationen in Lösungen wie syftr erlauben es, unterschiedliche LLM-Anbieter und Modelle in den Suchraum einzubeziehen, wodurch eine noch präzisere und auf den Anwendungsfall zugeschnittene Optimierung möglich ist. Die technische Infrastruktur hinter solchen Optimierungssystemen ist häufig komplex.

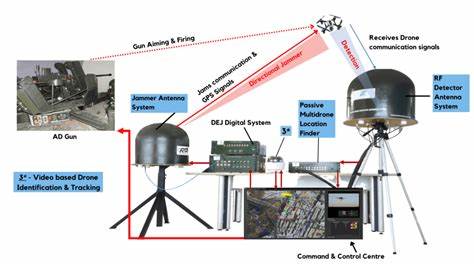

Distributionstechnologien wie Ray sorgen für eine parallele und skalierte Ausführung der Optimierungsstudien, während Datenbanken wie PostgreSQL als robuste Speicherschichten für die Ergebnisse dienen. Diese Kombination ermöglicht es, auch groß angelegte Experimente zuverlässig durchzuführen und die gewonnenen Erkenntnisse effizient zu verarbeiten. In der Praxis bedeutet der Einsatz der Pareto-Frontier in der Agentenoptimierung, dass Unternehmen und Forschungseinrichtungen bessere End-to-End-Systeme entwickeln können, die ihre Ressourcen zielgerichtet einsetzen. So lässt sich beispielsweise bei Chatbots oder automatisierten Textgenerierungssystemen ein ausgewogenes Verhältnis zwischen Antwortqualität und Kosten sicherstellen. Ebenso kann die optimale Balance für Anwendungen im Bereich der Informationsbeschaffung oder RAG (Retrieval-Augmented Generation) gefunden werden, um sowohl Performance als auch Skalierbarkeit zu garantieren.

Ein weiterer Vorteil der Nutzung von Pareto-Frontier-basierten Methoden ist ihre Transparenz. Die Entscheidungsträger erhalten keine Black-Box-Vorschläge, sondern eine nachvollziehbare Menge von optimalen Konfigurationen. Dies fördert das Verständnis über mögliche Trade-offs und unterstützt eine flexible Anpassung an veränderte Anforderungen oder Budgets. Die Zukunft der Agentenoptimierung wird wahrscheinlich verstärkt auf der Weiterentwicklung der Multi-Objective Optimierung basieren. Neue algorithmische Ansätze und technische Frameworks werden es ermöglichen, komplexere Zielgrößen und noch heterogenere Modelle in die Optimierung einzubeziehen.

Damit eröffnen sich weitere Potenziale für den optimalen Einsatz von KI-Agenten in verschiedensten Anwendungsfeldern. Zusammenfassend lässt sich festhalten, dass die Pareto-Frontier ein unverzichtbares Werkzeug darstellt, um die Komplexität bei der Agentenentwicklung zu bewältigen. Durch die Kombination moderner Optimierungstechniken, skalierbarer Infrastruktur und intelligentem Workflow-Design wird es möglich, den Nutzen von KI-Agenten erheblich zu steigern und gleichzeitig wirtschaftliche Effizienzkriterien zu erfüllen. Insbesondere bei zunehmender Vielfalt an Modelloptionen und ständig steigenden Ansprüchen an Leistung und Kostenkontrolle wird die gezielte Anwendung der Pareto-Frontier zu einem wettbewerbsentscheidenden Faktor. Wer heute mit intelligenten Agenten arbeitet, sollte sich intensiv mit der Pareto-Frontier auseinandersetzen, um fundierte, nachhaltige und effektive Entscheidungen treffen zu können.

Die Kombination aus theoretischer Fundierung und praktischer Anwendbarkeit macht die Pareto-Frontier zu einer Schlüsseltechnologie der nächsten Generation von KI-Systemen und Agentenlösungen.