Die Nachfrage nach spezialisierter Hardware für Künstliche Intelligenz (KI) wächst dynamisch und stellt die Halbleiterbranche vor enorme Herausforderungen und Chancen. AMD ist als einer der führenden GPU-Hersteller in den letzten Jahren kontinuierlich gewachsen und hat sich mit den Instinct MI300X Beschleunigern bereits eine solide Position im KI-Servermarkt erarbeitet. Aber AMD will mehr: Ihr Blick richtet sich auf die Skalierung ganzer Rechenzentren. Dabei setzt das Unternehmen mit dem Projekt Helios auf eine umfassende rackbasierte Architektur, die nicht nur die Leistung einzelner Komponenten maximiert, sondern auch die Energieeffizienz und Skalierbarkeit auf ein neues Level hebt. Helios symbolisiert AMDs zukunftsweisenden Weg in eine Ära, in der komplette Systeme als Einheit im Vordergrund stehen, statt isolierter Einzelprodukte.

AMD verfolgt mit seiner Helios-Strategie einen ganzheitlichen Ansatz, der die Integration von CPUs, GPUs und Netzwerkkomponenten nahtlos zusammenführt. Die neue Instinct MI350 Serie mit der CDNA4-Architektur bildet das Herz dieser Lösung. Diese GPU-Beschleuniger bieten eine nahezu doppelt so hohe Rechenkapazität für KI-Workloads wie ihre Vorgänger, insbesondere bei niedrigen Präzisionsformaten wie FP6 und FP4, die bei KI-Inferenzprozessen immer wichtiger werden. Die Nutzung von HBM3E-Speicher mit 288 GB Kapazität und einer Bandbreite von 8 TB pro Sekunde schafft die Grundlagen für schnelle Datenverarbeitung und reduziert Flaschenhälse bei speicherintensiven KI-Aufgaben. AMD geht damit sowohl in der Rohleistung als auch in der Effizienz neue Wege.

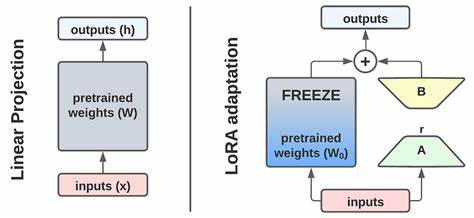

Ein wesentliches Merkmal der MI350-Serie ist die klare Ausrichtung auf KI-spezifische Matrixoperationen. Im Vergleich zu den Vorgängermodellen hat AMD die Anzahl der Matrixoperationen pro Takt verdoppelt. Dies unterstreicht den Fokus, die für KI-Anwendungen besonders relevanten Berechnungen zu optimieren. Gleichzeitig investiert AMD bewusst in zusätzliche Hardware für FP6 und FP4-Datentypen, die sonst bei Konkurrenten wie NVIDIA innerhalb bestehender FP8-Units laufen. AMD legt einen eigenen FP6- und FP4-Cluster an.

Obwohl dies den Die-Flächenverbrauch erhöht, verleiht es einen deutlichen Performance-Vorteil, der sich im Betrieb effizienter und schneller bezahlt macht. Die Leistungssteigerung geht jedoch mit einem erhöhten Stromverbrauch einher. Mit einem Wert von bis zu 1400 Watt beim Spitzenmodell MI355X handelt es sich um eine sehr stromhungrige Lösung. Hier zeigt sich deutlich, dass AMD nicht gegen konservativen Verbrauch optimiert, sondern auf maximale Performance setzt, die vor allem in großen Rechenzentrum-Racks durch Spezialkühlsysteme und neue Energiemanagementkonzepte realisiert wird. Die Möglichkeit, bis zu 128 GPUs in einem flüssigkeitsgekühlten Rack zu betreiben, bedeutet, dass ein einzelnes Rack mit den neuen Beschleunigern auf eine Leistungsaufnahme von rund 180 Kilowatt allein für die GPUs kommt.

Dies erfordert neue Denkansätze in der Rack- und Infrastrukturplanung innerhalb von Rechenzentren. Im Softwarebereich setzt AMD mit der neuen ROCm 7 Plattform wichtige Akzente. Die kontinuierliche Weiterentwicklung der offenen Softwareumgebung ist ein zentraler Bestandteil der Strategie, die Leistungsfähigkeit der Hardware voll auszuschöpfen und gleichzeitig die Entwicklergemeinde aktiv einzubinden. ROCm 7 bietet verbesserte Performance für Inferenz und Training, eine stärkere Unterstützung für verteilte Systeme sowie vereinfachte Management-Funktionen für Enterprise-Kunden. Besonders hervorzuheben ist die zunehmende Unterstützung von Frameworks wie PyTorch bereits am Veröffentlichungstag (Day-0-Support) sowie die native Integration unter Windows, womit AMD die Barrier von Entwickler-Ökosystemen weiter abbaut.

Diese Software-Offensive ist wichtig, um mit NVIDIA zu konkurrieren, das bislang seine hohen Hardware-Leistungen mit einer etablierten Software-Infrastruktur flankiert. Neben GPU und Software kommen auch Netzwerktechnologien bei Helios eine entscheidende Rolle zu. Mit der 400G Ethernet-Karte Pollara 400, entwickelt von AMDs Pensando-Team, liefert AMD einen programmierbaren und hochleistungsfähigen Netzwerkadapter, der speziell für die Anforderungen von skalierenden KI-Clustern optimiert ist. Als erste Lösung, die vom Ultra Ethernet Consortium (UEC) offiziell unterstützt wird, ist die Pollara 400 auf die Zukunft der Ethernet-Technologie ausgerichtet. Die gesteigerte Bandbreite und neue Protokollstandards ermöglichen den Aufbau von internen Netzwerken mit geringerer Latenz und höherem Durchsatz, die für große KI-Racks unverzichtbar sind.

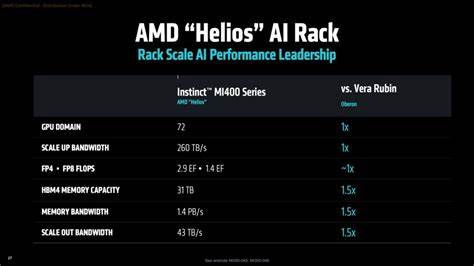

Die Kombination aus MI350-GPUs, den hochmodernen 5. Gen EPYC „Turin“ CPUs und der Pollara 400 AI NIC schafft eine vollständig aufeinander abgestimmte Plattform für KI-Berechnungen. AMDs Lösung richtet sich explizit an Kunden, die eine schlüsselfertige Gesamtlösung wünschen, um komplett auf AMD-Hardware basierende Racks zu betreiben. Die Bündelung der Kernkomponenten kombiniert dabei die Vorteile von AMDs neuesten Chips und Innovationen, was eine kompakte, effiziente und leistungsstarke KI-Infrastruktur möglich macht. Blickt man auf die Roadmap, so ist der MI400, der für 2026 geplant ist, das nächste große Highlight.

Aufbauend auf der bisherigen CDNA4-Architektur soll der MI400 über eine Leistung von 20 PFLOPS im FP8 Bereich verfügen und mit 432 GB HBM4-Speicher ausgestattet sein. Damit wird nicht nur die Rechenleistung auf ein neues Niveau gehoben, sondern auch die Speicherbandbreite auf fast 20 TB pro Sekunde verdoppelt. Besonders wichtig ist ebenso die Unterstützung von Ultra Accelerator Link, ein offener Industriestandard für skalierbare Verbindungstechnologien innerhalb von Racks, der es ermöglicht, bis zu 1024 GPUs in einem einzigen Scale-up-System zu verbinden. Dieses enorme Skalierungspotenzial demonstriert AMDs Ambitionen im Servermarkt. Helios wird somit nicht einfach nur ein weiterer Server sein, sondern eine komplett neue Klasse von rackbasierten KI-Systemen.

Verbaut werden soll auch die kommende 6. Generation der Zen-Architektur in den EPYC-CPUs („Venice“), die auf dem hochmodernen TSMC N2 Prozess basiert. Parallel ist das Netzwerkupgrade mit der 800G Vulcano NIC geplant, welche PCIe 6.0 und Ultra Accelerator Link unterstützt, beides wichtige Technologien für die nächsten Jahre, um Datenflüsse im Datenzentrum beschleunigt und effizient bereitzustellen. Die Zukunft der Rechenzentren ist eindeutig rackorientiert.

Während bisher viele Kunden einzelne Server kauften und zusammenstellten, zeigt sich in der Industrie ein deutlicher Trend hin zu fertigen Komplettlösungen auf Racketage. Argumente dafür sind unter anderem die bessere Energieeffizienz, vereinfachtes Management, konsistente Leistung und höherer Integrationsgrad. AMD spielt hier mit Helios seine Stärken aus und stellt gleichzeitig sicher, dass das System auf zukünftige Workloads und Anforderungen ausgelegt ist. Darüber hinaus sind Modulkonzepte und die Möglichkeit, Hardware in großem Maßstab zu skalieren, entscheidende Wettbewerbsvorteile gegen etablierte Hersteller, insbesondere NVIDIA. AMD verfolgt mit dem Helios-Projekt auch ehrgeizige Nachhaltigkeitsziele.

Bis 2030 plant das Unternehmen eine zwanzigfach bessere Energieeffizienz auf Racketebene gegenüber den im MI300X verwendeten Systemen zu erreichen. Hier spielen neben rein hardwareseitigen Optimierungen auch der Fortschritt und die Kooperation mit der Softwarewelt eine entscheidende Rolle, um Rechenoperationen effizienter und ressourcenschonender durchzuführen. Mittelfristig könnte eine hundertfache Verbesserung in der Gesamtenergieeffizienz möglich werden, was angesichts von steigendem Energieverbrauch in Rechenzentren von enormer Bedeutung ist. Mit dem Fortschreiten der Entwicklung ist davon auszugehen, dass AMD mit der Helios-Strategie nicht nur an Leistung, sondern auch an einer stabilen und skalierbaren Plattform für unterschiedlichste KI-Anwendungen arbeitet. Die Kombination aus innovativer Hard- und Software, einem durchdachten Ecosystem und dem Fokus auf die gesamte Compute-Infrastruktur macht Helios zu einer spannenden Lösungsoption für Unternehmen, die in Zukunft auf KI setzen und leistungsfähige HPC-Cluster betreiben wollen.

Zusammenfassend ist Helios nicht nur ein Produkt, sondern eine Vision, die AMD aufgreift, um in einem rasant wachsenden und hochkompetitiven Markt der Künstlichen Intelligenz Schritt zu halten und gleichzeitig die Anforderungen der nächsten Generation von KI-Anwendungen zu erfüllen. Die geschickte Verzahnung von modernster GPU-Architektur, schnellen Netzwerken, effizienten CPUs und einer leistungsfähigen Softwareumgebung zeigt, dass AMD den Weg der Komplettlösungen für rackbasierte KI-Workloads konsequent verfolgt. Für Unternehmen und Dienstleister bedeutet dies Zugang zu zukunftssicherer Technologie, die sowohl skalierbar als auch leistungsstark ist und gleichzeitig die Betriebskosten senkt. In einer Zeit, in der KI-Modelle immer komplexer und datenintensiver werden, könnte AMDs Helios der Schlüssel zu leistungsfähigen, flexiblen und nachhaltigen KI-Infrastrukturen sein.