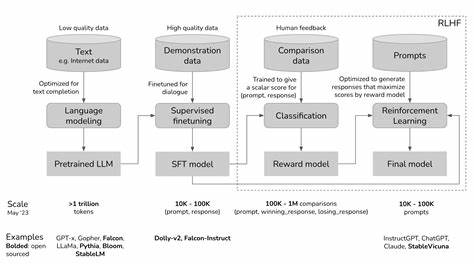

In der heutigen schnelllebigen Welt der künstlichen Intelligenz gewinnt Reinforcement Learning (RL) zunehmend an Bedeutung, insbesondere wenn große Sprachmodelle (LLMs) ins Spiel kommen. Die Anforderungen an Rechenleistung, Skalierbarkeit und Anpassungsfähigkeit steigen stetig, um komplexe Aufgaben wie menschliche Präferenzanpassung, mehrstufige Interaktionen und tiefgründige Problemstellungen effizient zu bewältigen. Hier setzt ROLL an – eine zukunftsweisende RL-Bibliothek, die speziell für großskalige Anwendungen mit Sprachmodellen entwickelt wurde und die Herausforderungen moderner KI-Entwicklung adressiert. ROLL steht dabei für Reinforcement Learning Optimization for Large-Scale Learning und stellt eine hochgradig skalierbare, effiziente und anwenderfreundliche Lösung dar, die auf den neuesten technologischen Trends aufbaut und von Alibaba entwickelt wurde. Die Architektur von ROLL kombiniert mehrere fortschrittliche Komponenten und Technologien, um ein flexibles und leistungsfähigkeitserhöhendes Ökosystem zu schaffen.

Im Kern nutzt das Framework eine multi-rollenbasierte verteilte Architektur, die auf Ray aufbaut – ein leistungsfähiges verteiltes Framework, das Ressourcenmanagement und heterogene Task-Steuerung ermöglicht. Dadurch können Ressourcen optimal zugewiesen, verschiedene Trainings- und Inferenzaufgaben parallel ausgeführt und unterschiedlich komplexe Workloads effizient verarbeitet werden. Durch diese intelligente Steuerung kann ROLL den oft auftretenden Engpass bei der GPU-Nutzung umgehen, was die Trainingszeiten drastisch verkürzt und gleichzeitig die Modellleistung erhöht. Eine der herausragendsten Eigenschaften von ROLL ist die Unterstützung von großen Sprachmodellen mit umfassenden GPU-Ressourcen, was insbesondere bei der Feinabstimmung von Modellen auf menschliche Präferenzen oder bei der Durchführung komplexer mehrstufiger Interaktionen eine Schlüsselrolle spielt. Dabei kommen Technologien wie Megatron-Core zum Einsatz, eine bewährte Lösung zur parallelen Verarbeitung großer Modelle mittels 5D-Plänen.

Ergänzt wird dies durch die Integration von SGLang und vLLM, die fortschrittliche Inferenzmechanismen für Sprachmodelle ermöglichen und so die Effizienz und Latenzzeiten während der Modellnutzung verbessern. ROLL zeichnet sich zudem durch eine Vielzahl integrierter Reinforcement-Learning-Algorithmen und -Strategien aus. Das Framework unterstützt über zwanzig verschiedene RL-Methoden, darunter PPO (Proximal Policy Optimization), GRPO, Reinforce++, GSPO und weitere innovative Verfahren. Die Vielfalt dieser Algorithmen erlaubt es Entwicklern, für individuelle Aufgaben passende Strategien zu wählen und flexibel zu kombinieren. Verstärkt wird diese Flexibilität durch umfangreiche Konfigurationsmöglichkeiten, die etwa Belohnungsnormalisierung, Clipping-Techniken und unterschiedliche Vorteilsschätzungen einschließen, um das Training gezielt zu optimieren.

Die praktische Anwendung von ROLL erstreckt sich über verschiedene Bereiche, in denen große Sprachmodelle ihre Stärken ausspielen. Besonders relevant ist das Framework für Szenarien, in denen Behörden oder Unternehmen Chatbot-Systeme, interaktive Agenten oder komplexe Entscheidungsprozesse einsetzen wollen. Beispielsweise ermöglichen die multi-turn Agentic RL-Funktionen von ROLL vielseitige Interaktionen über mehrere Gesprächsrunden hinweg, was eine präzise und kontextbezogene Nutzerführung gewährleistet. Solche Umgebungen sind im Kundenservice, bei interaktiven Spielen oder in der Automatisierung von Workflow-Systemen zunehmend gefragt. Eine weitere Besonderheit ist die Unterstützung von asynchronen Trainingsprozessen und parallelen Rollouts, die zu einer besseren Ressourcenauslastung führen und gleichzeitig die Gesamttrainingszeit minimieren.

Asynchrone Trainingsmechanismen in ROLL erlauben es, unterschiedliche Trainingsphasen oder Umgebungsbewertungen unabhängig voneinander laufen zu lassen, ohne aufeinander warten zu müssen. Dieses Feature ist besonders wertvoll bei skalierter Infrastruktur mit mehreren Knoten oder beim Einsatz heterogener Ressourcen, da es Engpässe im Rechenprozess reduziert und so die Effizienz maximiert. ROLL bietet außerdem eine hohe Kompatibilität mit modernen Backend-Technologien. DeepSpeed von Microsoft ermöglicht hierbei eine verbesserte Speicherverwaltung und beschleunigte Trainingsdurchläufe durch Techniken wie ZeRO-Optimierungen. In Kombination mit Megatron-LM und FSDP (Fully Sharded Data Parallel) deckt ROLL ein breites Spektrum an Parallelisierungsoptionen ab, die essentiell sind, um Modelle mit Milliarden oder sogar Billionen von Parametern zu trainieren.

Die nahtlose Integration dieser Backends in die Pipeline erleichtert es Entwicklern und Forscherteams enorm, skalierbare Lösungen schnell zu implementieren. Ein weiterer technischer Fortschritt von ROLL ist die Unterstützung von Präzisionsmodi wie FP8 (8-Bit Floating Point), die bei Training und Inferenz eine wesentliche Rolle spielen. Durch die Kombination von FP8-Inferenz mit BF16-Training wird eine signifikante Reduktion des Speicherverbrauchs und eine Beschleunigung der Trainingsphasen erreicht, ohne dabei signifikante Einbußen bei der Modellgenauigkeit hinnehmen zu müssen. Diese Innovation öffnet Möglichkeiten für den Betrieb großer Modelle auf ressourcenschonender Hardware und senkt somit Kosten und ökologische Lasten. Was die Nutzerfreundlichkeit betrifft, setzt ROLL auf eine übersichtliche und umfassend dokumentierte Schnittstelle.

Entwickler können mit nur wenig Setup komplexe RL-Lernprozesse starten, dank schneller Einstiegsmöglichkeiten wie Single-Node und Multi-Node Deployment Guides. Zudem ist das Framework eng mit bekannten Visualisierungstools wie WandB, TensorBoard und SwanLab verbunden, was die Überwachung von Trainingsfortschritten, Performancedaten und Belohnungskurven intuitiv und transparent macht. Die Offenheit und Erweiterbarkeit von ROLL spiegeln sich auch in seiner Community und Open-Source-Philosophie wider. Das Projekt wird kontinuierlich weiterentwickelt, neue Features wie asynchrone Trainingspipelines oder die Integration von Fully Sharded Data Parallel 2 (FSDP2) sind in Vorbereitung. Darüber hinaus bietet ROLL Unterstützung für multimodale Modelle (z.

B. Vision-Language Models), agentische RL-Umgebungen mit Schritt-für-Schritt-Lernen sowie innovative Distillation- und DPO-Pipelines. Diese Vielfalt ist einzigartig und macht ROLL zu einer umfassenden Plattform für Reinforcement Learning auf industriellem Niveau. In der Praxis haben sich mit ROLL zahlreiche vielversprechende Anwendungen herausgebildet, darunter RecGPT – ein Framework zur nutzerzentrierten Empfehlungssystementwicklung –, sowie TaoSR1, das Chain-of-Thought Reasoning zur Verbesserung von Produktsuchmaschinen in E-Commerce-Umgebungen einsetzt. Solche Anwendungsfälle illustrieren, wie ROLL die Grenzen traditioneller Machine-Learning-Methoden sprengt und neue Wege im Umgang mit komplexen Aufgaben eröffnet.

Zusammenfassend lässt sich sagen, dass ROLL durch seine Kombination aus modernster Technologie, Skalierbarkeit und Anwenderfreundlichkeit eine Schlüsselrolle bei der Weiterentwicklung von Reinforcement Learning in großem Maßstab einnimmt. Die modulare Struktur, die Unterstützung für vielfältige Algorithmen und Backends sowie die Integration innovativer Hardwareoptimierungen machen das Framework zu einem unverzichtbaren Werkzeug für Forscher, Entwickler und Unternehmen, die die Leistungsfähigkeit von LLMs optimal nutzen wollen. Mit ROLL wird die Herausforderung, große Sprachmodelle effizient zu trainieren und anzupassen, wesentlich einfacher und zugänglicher. Die Zukunft von Reinforcement Learning liegt in der Skalierung, Flexibilität und Integration heterogener Ressourcen – und genau dort setzt ROLL an. Für Organisationen, die im Bereich künstliche Intelligenz zukunftsfähige Lösungen suchen, bietet es nicht nur eine technische Plattform, sondern auch eine Basis zur Erschaffung neuer Anwendungen und Services, die intelligent, effizient und nutzerorientiert arbeiten.

Mit ROLL steht ein leistungsfähiges Werkzeug bereit, das die nächste Generation der KI-Technologie prägt.