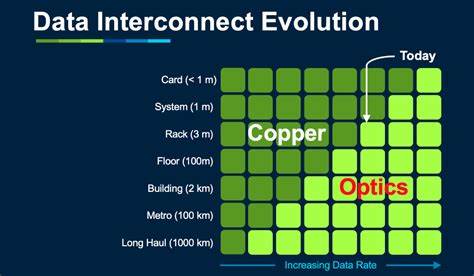

Die IT-Branche steht vor einer bedeutenden Transformation: Der Wechsel von Kupfer- auf optische Verbindungen in hyperskaligen Rechenzentren verändert grundlegend, wie Datenübertragung, Skalierbarkeit und Zuverlässigkeit gewährleistet werden. Insbesondere die jüngsten Veröffentlichungen von Meta über ihre AI-Netzwerkarchitektur gewähren seltene Einblicke in den technischen Wandel, der das Rückgrat moderner AI-Infrastrukturen bildet. Diese Transparenz offenbart nicht nur den Status quo bei Hyperscalern, sondern dient auch als Wegweiser für Unternehmen, die ihre GPU-Cluster erweitern und optimieren möchten.Im Zentrum dieser Entwicklung steht die Unterscheidung zwischen zwei Vernetzungsdomänen: Scale-up und Scale-out. Die Scale-up-Domäne umschreibt eine enge, auf hohe Dichte ausgelegte Infrastruktur innerhalb einzelner Racks.

Hier verbinden direkt angeschlossene Kupferleitungen sogenannte DAC-Kabel (Direct Attached Copper) eine Vielzahl an GPUs extrem performant miteinander. Meta kombiniert in unter einem Rack beispielsweise 72 Blackwell-GPUs, die über mehrere NVLink5-Switches verbunden sind, um eine ungeheure Bandbreite von 200 Gbps pro Lane zu gewährleisten. Diese dichte Kupferverbindung ermöglicht niedrige Latenzen und hohe Datenraten, die notwendig sind, um komplexe neuronale Netze mit milliardenfacher Parameteranzahl zu synchronisieren.Doch Kupferkabel stoßen bei zunehmender Anzahl und Geschwindigkeit schnell an physikalische Grenzen. Signalverluste und elektromagnetische Interferenzen erschweren die Übertragung, während Wärmeentwicklung und Stromverbrauch steigen.

Die Geschwindigkeit, mit der GPUs auch innerhalb eines Racks kommunizieren müssen, fordert andere, effizientere Latenz- und Bandbreitenlösungen. Genau hier setzt die zweite Domäne an, die Scale-out-Verbindung über Optik. Statt über Kupfer verlaufen die Datenströme zwischen einzelnen Racks und Clustern durch optische Fasern, die größere Distanzen und höhere Bandbreiten mit deutlich geringeren Verlusten ermöglichen.Meta nutzt für die übergreifende Vernetzung optische Module, die Remote Direct Memory Access (RDMA) über Converged Ethernet (RoCE) unterstützen. Diese Technologie erlaubt eine nahezu verzögerungsfreie Datenübertragung auf Netzwerkebene, was essentiell für die Konsistenz und schnelle Synchronisation von AI-Workloads ist.

Die optische Vernetzung ermöglicht es, mehrere Racks zu sogenannten AI-Zonen zusammenzufassen, die über Cluster-Level-Switches verbunden sind. Dadurch entsteht eine Architektur, die eher an die Infrastruktur einer großen Stadt erinnert als an ein klassisches Rechenzentrum.Herausforderungen wie Bandbreitendichte, Stromverbrauch und Zuverlässigkeit sind nicht bloß theoretische Betrachtungen, sondern akute Problemstellungen, mit denen Meta und andere Hyperscaler tagtäglich konfrontiert sind. Ein Beispiel verdeutlicht diese Komplexität: Während eines 54-tägigen Trainingslaufs des Llama 3 Modells auf mehr als 16.000 GPUs kam es zu häufigen Systemunterbrechungen.

Diese Ausfälle wirken sich nicht nur auf die Rechenzeit, sondern auch auf die logistischen Abläufe und Kosten in großem Maße aus. Ein einzelner Ausfall eines GPU-Clusters setzt komplexe Wiederanlaufprozesse in Gang, die kostspielig und zeitintensiv sind. Meta begegnet diesen Schwierigkeiten mit ausgeklügelten Checkpointing-Mechanismen, die den trainingsstand in exakt definierten Zeitintervallen speichern, um Verlust bei Ausfällen zu minimieren. Dennoch steigen mit zunehmendem Umfang der Clustern die Anforderungen an die Ausfallsicherheit enorm. Die mittlere Zeit zwischen Ausfällen (Mean Time Between Failures, MTBF) muss in den Bereich von Hunderttausenden Stunden pro Knoten expandieren, um eine akzeptable Betriebskontinuität sicherzustellen.

In diesem Kontext rückt die optische Vernetzung in den Vordergrund. Optische Verbindungen bieten das Potenzial, nicht nur eine größere Bandbreite bereitzustellen, sondern zugleich die Latenz zu verringern und die Zuverlässigkeit zu verbessern. Meta setzt klare Maßstäbe für die Weiterentwicklung von optischen Technologien: Bis 2026 sollen optische Verbindungen eine Bandbreitendichte von mehr als 1,2×N Terabit pro Sekunde pro Millimeter erreichen, verbunden mit hohen Anforderungen an Zuverlässigkeit und niedrige Latenzzeiten. Dabei sind auch verbesserte Strategien zur Fehlerkorrektur (Forward Error Correction, FEC) von zentraler Bedeutung, um die Robustheit gegen Datenverluste in sensiblen AI-Anwendungen zu steigern.Die Konsequenz dieser Entwicklung ist weitreichend.

Die Transformation von Kupfer- zu optischen Verbindungen bedeutet nicht nur eine technische Innovation in hyperskaligen Rechenzentren, sondern beeinflusst die gesamte Designphilosophie von AI-Infrastrukturen. Unternehmen, die aktuell nur kleinere bis mittelgroße GPU-Cluster betreiben, stehen schon jetzt vor ähnlichen Problemen, auch wenn in abgeschwächter Form. Die Grenzen von Kupferkabeln beim Bandbreitenwachstum, thermische Engpässe und Herausforderungen bei der Skalierbarkeit zeigen sich bei zunehmender Komplexität auch in diesen Umgebungen. Aus dieser Perspektive liefert die Meta-Dokumentation einen wertvollen Leitfaden, der über die Grenzen der Hyperscaler hinaus wichtig ist.Darüber hinaus stellt der Wandel hin zu optischen Vernetzungen eine Chance dar, die Energieeffizienz von Rechenzentren zu verbessern.

Kupferleitungen erzeugen nicht nur mehr Wärme, welche zusätzliche Kühlung erfordert, sondern konsumieren auch mehr Energie bei schneller Datenübertragung. Optische Fasern dagegen sind energieärmer und ermöglichen eine höhere Packungsdichte, bei der mehrere Kanäle auf engem Raum untergebracht werden können. Dies unterstützt Rechenzentren dabei, die Umweltbelastung zu reduzieren und gleichzeitig die Infrastruktur zukunftssicher zu gestalten.Nicht zuletzt erfordert der Einsatz von Optik im größeren Maßstab ein neues Verständnis für die Architektur von Rechnernetzwerken. Wo früher starre Hierarchien dominierten, ermöglichen optische Verbindungen heute flexiblere und skalierbare Strukturen, die besser an die Anforderungen distribuierten Lernens angepasst sind.

Die Möglichkeit, enorme Datenmengen lückenlos und in Echtzeit zwischen tausenden von GPUs zu übertragen, verändert die Art und Weise, wie Modelle trainiert, validiert und eingesetzt werden.Insgesamt zeigt der Shift von Kupfer zu Optik die einzigartige Verbindung zwischen Hardware-Innovation und den steigenden Anforderungen moderner AI-Anwendungen. Je komplexer und rechenintensiver die KI-Modelle werden, desto wichtiger sind hochperformante, zuverlässige und effiziente Netzwerke. Die Investitionen in optische Technologien zahlen sich langfristig aus, indem sie die nächste Generation AI-Plattformen ermöglichen, die heute noch visionär erscheinen.Der Einblick, den Meta mit seinen Architekturpapieren gewährt, ist daher mehr als nur eine Offenlegung unternehmensinterner Infrastruktur.

Er signalisiert eine technologische Wende, die Folgen für das gesamte IT-Ökosystem haben wird. Von Startup bis zum etablierten Konzern, von Forschungslabor bis hin zum Cloud-Anbieter – die Prinzipien und Herausforderungen, die Meta dokumentiert, bilden die Grundlage für eine neue Ära in der Entwicklung von AI-Rechenzentren.Die Zukunft der hyperskaligen Infrastruktur wird durch den Paradigmenwechsel hin zu optischer Vernetzung geprägt sein. Unternehmen, die diesen Wandel verstehen und frühzeitig adaptieren, erhalten einen Wettbewerbsvorteil und sind bestens gerüstet, um die Herausforderungen der nächsten KI-Generationen zu meistern. Gleichzeitig fordert diese Entwicklung auch eine verstärkte Zusammenarbeit zwischen Hardwareherstellern, Netzwerkspezialisten und Softwareentwicklern, um die komplexen Anforderungen moderner AI-Workloads effizient zu erfüllen.

Zusammenfassend lässt sich sagen, dass der Übergang von Kupfer- zu optischer Vernetzung ein Schlüsselthema für die Skalierung von AI-Infrastrukturen darstellt. Er ermöglicht nicht nur höhere Bandbreiten und geringere Latenzen, sondern bringt auch bedeutende Fortschritte in Zuverlässigkeit und Energieeffizienz. Die detaillierten Erfahrungen und Ziele von Hyperscalern wie Meta bieten dabei einen wertvollen Kompass für die gesamte Branche und helfen, die Herausforderungen von heute in Chancen für morgen zu verwandeln.