Im Zeitalter von Big Data und immer komplexeren Datenverarbeitungsaufgaben stehen Entwickler vor der Herausforderung, leistungsstarke, flexible und zugleich wartbare Systeme zu entwerfen. Eine der grundlegenden Fragen, die sich dabei stellt, ist die Wahl der Programmiersprache und der zugrunde liegenden Technologien, welche sowohl hohe Performance als auch Agilität gewährleisten. Ein Weg, der in diesem Kontext zunehmend an Bedeutung gewinnt, ist die Kombination aus uniformer strukturierter Syntax, Metaprogrammierung und Laufzeitkompilierung. Obwohl viele Entwickler diese Zusammenhänge auf den ersten Blick als abstrakte Konzepte wahrnehmen, ermöglicht ihr Zusammenspiel in bestimmten Programmierumgebungen – vor allem in Lisp-Dialekten wie Common Lisp – verblüffend effiziente und flexible Lösungen. Diese Technologien bergen ein enormes Potenzial, gerade wenn es darum geht, komplexe Datenbanken mit Milliarden von Einträgen schnell und zuverlässig abzufragen und zu analysieren.

Die Frage lautet also: Warum sollte man Lisp und seine Werkzeuge für solche Aufgaben in Betracht ziehen und welche Vorteile bietet diese Kombination gegenüber klassischen Ansätzen? Die Antwort darauf finden wir, wenn wir zunächst die Rolle der Syntax in der Programmierung betrachten. Häufig wird behauptet, dass Syntax nur eine Frage der Lesbarkeit sei und keinen Einfluss auf die Effizienz oder Ausdruckskraft des Codes habe. Doch der Weg, wie Code geschrieben, strukturiert und interpretiert wird, ist von entscheidender Bedeutung. Eine einheitliche Syntax, wie sie Lisp mit seinen S-Expressions bietet, erlaubt es, Code direkt als Datenstruktur zu begreifen. Diese Eigenschaft bildet die Grundlage für einfache, aber mächtige Metaprogrammierung: Die Programme können während der Ausführung ihren eigenen Code generieren, verändern und neu kompilieren – eine Fähigkeit, die in klassischen Programmiersprachen oft nur umständlich oder ineffizient umzusetzen ist.

Metaprogrammierung bedeutet dabei viel mehr als nur die Automatisierung von wiederkehrenden Aufgaben. Sie eröffnet eine neue Qualität in der Softwareentwicklung, indem sie es erlaubt, Programme auf höheren Abstraktionsebenen zu entwerfen und gleichzeitig die nahe an der Hardware liegende Effizienz zu sichern. Innerhalb eines Lisp-Systems beispielsweise können Entwickler Makros definieren, die zur Kompilierzeit Wege freimachen, repetitive Strukturen zu eliminieren und maßgeschneiderte Spezialfälle direkt in nativen Maschinencode zu übersetzen. Dies führt zu Programmen, die sich optimal an die jeweilige Problemstellung anpassen, ohne zusätzlichen Overhead oder Komplexität im Laufzeitverhalten. Ein besonders eindrucksvolles Beispiel für die Vorteile dieser Technologien stellt der Aufbau einer SQL-ähnlichen Abfragemaschine in Common Lisp dar, die auf die effiziente Verarbeitung fester Datensatzformate mit vorgegebenem Feldlayout ausgelegt ist.

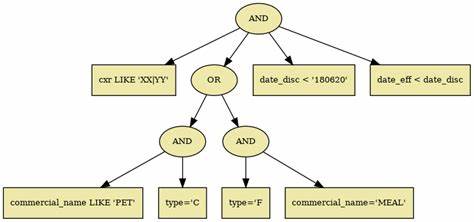

Während traditionelle Interpretationsansätze auf das Traversieren von logischen Bäumen zurückgreifen, was zwangsläufig mit Laufzeitkosten und unter Umgehung von Optimierungspotenzialen verbunden ist, ermöglicht die Kombination aus Metaprogrammierung und Laufzeitkompilierung, aus einer konkreten Abfrage einen spezialisierten, kompakten Prüfcode direkt zur Laufzeit zu erzeugen und zu kompilieren. Dieser Code ist in seiner Struktur nahe an handgeschriebenem C++, vermeidet teure Rekursionen, komplexe Fallunterscheidungen oder dynamische Baumstrukturen und lässt sich zudem stark optimieren, da er für genau diese Abfrage und diesen Datensatz maßgeschneidert ist. Die Fähigkeit, den Compiler explizit zu invoke'n und dadurch zur Laufzeit hochoptimierten Maschinen-Code zu erzeugen, macht die Lösung so schnell, dass sie mit manuellen C++-Implementierungen Schritt hält oder diese gar übertrifft. Ein weiterer Aspekt, der für Lisp und seine Uniform Syntax spricht, sind die eingebetteten domänenspezifischen Sprachen (Embedded Domain Specific Languages – eDSL). Statt auf externe Parser und schwergewichtige Werkzeuge angewiesen zu sein, nutzt man in Lisp die machtvollen Makros und Reader-Anpassungen zur eleganten Definition eigener, auf die jeweilige Anwendungsdomäne zugeschnittener Ausdrucksformen.

Die ursprüngliche SQL-ähnliche Syntax wandelt sich dabei in prägnante S-Expressions, die nicht nur kompakt und elegant sind, sondern auch direkt als Datenstruktur weiterverarbeitet, transformiert und kompiliert werden können. Dieses Vorgehen ermöglicht eine schlichte Handhabung komplexer Abfragen und hochoptimierte Codeerzeugung. Die Iteration über Datenbestände wird nicht einem allgemeinen Interpreter-Code überlassen, sondern profitiert von speziell generiertem und kompiliertem Code, der direkt auf die konkrete Datenstruktur zugeschnitten ist. Gleichzeitig lässt sich durch komplexe Makro-Expansionen und Code-Generierung die Wiederholung von Arbeitsmustern vermeiden – ein Paradigma der Metaprogrammierung, das auf klassische, manuelle Programmierung häufig nicht übertragbar ist. Neben den Vorteilen im Bereich der Code-Generierung und Laufzeitoptimierung schlägt Lisp damit auch eine Brücke zu besseren Entwicklungsprozessen.

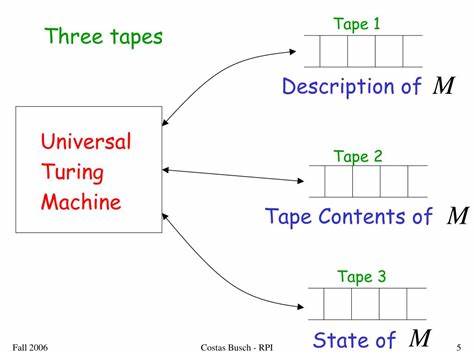

Die sogenannte Image-basierte Entwicklung erlaubt es, laufende Programmzustände, inklusive allen Codes und Datenstrukturen, in einem persistenten Abbild („Image“) zu speichern. Dies bedeutet, dass umfangreiche Konfigurationen und spezialisierte Daten bereits zur Laufzeit in der Umgebung bereitstehen, ohne jedes Mal neu geladen oder erstellt werden zu müssen. Für Echtzeitanwendungen und große Datenbankabfragen ein unschätzbarer Vorteil in Sachen Startzeit und Performance. Ein weiterer wesentlicher Pluspunkt von Lisp-Systemen ist ihre Fähigkeit zur vielstufigen Programmausführung. Der Prozess umfasst verschiedene Phasen wie Lesezeit, Makroexpandierungszeit, Kompilierzeit und schließlich Laufzeit.

Im Gegensatz zu vielen anderen Sprachen, die klar zwischen Kompilier- und Laufzeit trennen, ermöglichen Lisp-Implementierungen eine fließende Übergabe von Steuerung und Codeerzeugung durch diese Phasen. Dadurch können Programme dynamisch angepasst, erweitert und optimiert werden, ohne externe Werkzeuge oder aufwändige Editier-Compile-Run-Zyklen. Dies schafft eine höchst flexible und agile Umgebung für die Entwicklung komplexer Anwendungen, in der Ausführung und Erzeugung von Code Hand in Hand gehen. Von besonderer Bedeutung ist hier die klare Trennung und kombinierte Nutzung von Reader-Makros, regulären Makros und Compiler-Makros. Diese erlauben es, bereits bei der Lesephase der Quelltexte kleine Transformationen durchzuführen, während später durch Makro-Expansion und Kompilation tiefergehende Spezialisierungen und Optimierungen generiert werden.

Damit kann der Code bereits in frühen Phasen angepasst werden und erhält letztlich eine optimale Darstellung für die maschinelle Ausführung. Ein nicht zu unterschätzender Gegenspieler zu Lisp ist das in modernen Programmiersprachen oft propagierte „eval“-Konstrukt. Im Gegensatz zu Lisp, wo Code konsequent als strukturierte Daten behandelt und transformiert wird, ist eval in den meisten dynamischen Sprachen mit erheblichen Einschränkungen behaftet. Code-Manipulationen sind meist stringbasiert, unhandlich und oft ineffizient, da sie nicht nahtlos in den Kompilierungsprozess integriert sind. Die Lokalisierung und das Debuggen solcher dynamisch erzeugten Codes werden dadurch deutlich erschwert.

Bei Lisp erfolgt der gesamte Kompilierungs- und Codegenerierungsprozess stattdessen auf strukturiertem Abstract Syntax Tree-Level, der sich ganz natürlich manipulieren lässt. Ein Beispiel für den praktischen Nutzen dieser Konzepte zeigt sich im direkten Vergleich von Laufzeiten realisierter SQL-ähnlicher Abfragen über große Datenbanken. Während in klassischen Sprachen die gestellten Anforderungen entweder durch schwere Interpretationsschleifen oder umständliche One-Off-Implementierungen realisiert werden, erzielt eine auf Laufzeitkompilierung basierende Lösung aus Common Lisp mit ähnlichem oder sogar geringerem Aufwand Spitzenwerte, die nahe an oder gleichauf mit C++-Optimierungen liegen. Auch Go oder Python können hier nicht mithalten, was die Möglichkeiten von Lisp im Kontext von großen Datenmengen eindrucksvoll unterstreicht. Nicht zuletzt auch dank moderner paralleler Programmierbibliotheken wie lparallel werden CPU-Ressourcen optimal genutzt, wodurch das Potenzial von Multi-Core-Systemen voll ausgeschöpft werden kann.

Das Thema Syntax rückt übrigens durch die Reader-Makros noch einmal in den Fokus. Wenn Anwender auf herkömmliche SQL-Syntax nicht verzichten möchten, ist es möglich, mit Hilfe von read-time Parsing und spezialisierter Transformation diese auch in Lisp umzusetzen und so die unterliegende Verarbeitung und Optimierung trotz unterschiedlicher Syntax beizubehalten. Dadurch wird die Brücke zu bestehenden, vertrauten Sprachen geschlagen, ohne dass dabei auf die hohen Vorteile der Lisp-internen Metaprogrammierung verzichtet werden muss. Die Kombinatorik von einheitlicher Syntax, hierarchischer Metaprogrammierung und Laufzeitkompilierung führt in Summe zu einem Entwicklungsparadigma, das Eleganz und Effektivität vereint. Dabei übernimmt der Entwickler weniger die Rolle des ausführenden Programmschreibers, sondern vielmehr die des Architekten und Dirigenten, der auf abstraktem Level Regeln, Transformationen und Spezialisierungen formuliert – der Rest passiert automatisiert und effizient während der Programmausführung selbst.