Im April 2025 hat Meta mit seiner Meta AI-App einen Konkurrenten zu etablierten KI-Tools wie ChatGPT vorgestellt. Die App basiert auf Llama, einem firmeneigenen KI-Modell, und verspricht vielseitige Einsatzmöglichkeiten von kreativen Texten über Bildgenerierung bis hin zu persönlicher Betreuung. Obwohl die Technologie vielversprechend ist, zeigt sich zunehmend, dass die Anwendung erhebliche gravierende Datenschutzprobleme mit sich bringt, die viele Nutzer erst spät realisieren. Ein Kernproblem liegt in einer Funktion namens „Discover“, die versehentlich private, intime und zum Teil auch rechtlich sensible Gespräche öffentlich zugänglich macht. Dieses Phänomen hat bereits für viel Empörung gesorgt, da Menschen durch eine unklare und missverständliche Benutzeroberfläche dazu verleitet werden, ihre private Kommunikation preiszugeben, ohne dies zu wollen oder zu wissen.

Die „Discover“-Funktion ähnelt eher sozialen Netzwerken wie Instagram oder TikTok als einer sicheren KI-Plattform. Sie präsentiert eine öffentliche Feed-Ansicht, die zunächst kreative Inhalte zeigt, aber mit zunehmendem Scrollen auch immer persönlichere Gespräche zutage fördert. Dabei sind Beispiele aufgetaucht, bei denen Nutzer Fragen zu intimen Gesundheitsproblemen, Beziehungsdilemmata oder belastenden Lebensmomenten gestellt haben. Sogar Nachrichten mit vertraulichen medizinischen Details oder privaten Familienproblemen sind dort offen einsehbar. Besonders erschütternd sind Berichte von Menschen, die emotional belastende Situationen schildern – etwa ein älterer behinderter Tänzer, der von einer Veranstaltung ausgeschlossen wurde, oder Angehörige, die um die Rückführung eines Verstorbenen aus dem Ausland ringen und ihre Sorgen in Sprache festhalten.

Die potenziellen Folgen solcher unfreiwilligen Offenlegungen sind schwerwiegend. Die Nutzer verlieren die Kontrolle über ihre persönlichen Daten, was nicht nur zu peinlichen Situationen führen kann, sondern auch rechtliche und finanzielle Risiken birgt. Es finden sich sogar öffentliche Diskussionen über Unternehmenssteuern oder familiäre Rechtsfragen in der Plattform, die eigentlich vertraulich bleiben sollten. Noch dramatischer wird die Lage, wenn Nutzer die Möglichkeit nutzen, der KI eine ausführliche Übersicht ihrer eigenen Daten zu entlocken. Meta AI zeigt dann auf, was über den Nutzer an Informationen bekannt ist, darunter Name, Alter, Heimatstadt und persönliche Lebensziele, was eine zusätzliche Gefährdung der Privatsphäre darstellt.

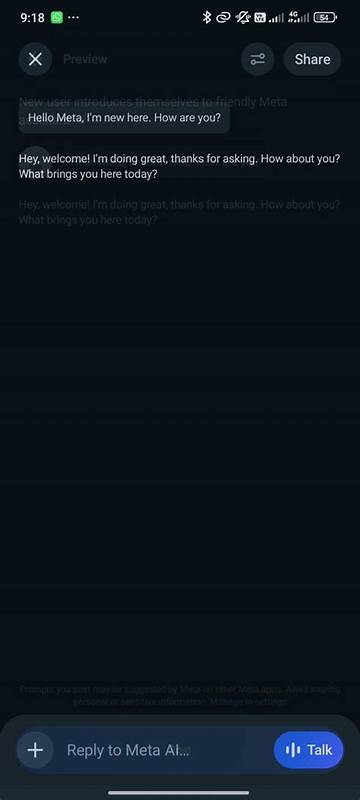

Die Ursache liegt einerseits im designtechnischen Versagen der App. Der „Share“-Button oben rechts in den Chats ist wenig aussagekräftig und lässt Nutzer nicht erkennen, dass das Teilen der Chats nicht privat erfolgt, sondern öffentlich in die „Discover“-Feed hochgeladen wird. Eine kleine Warnung, die nicht im Fokus steht, weist darauf hin, keine persönlichen Informationen zu teilen – doch diese wird von vielen schlicht übersehen oder missverstanden. Der gesamte Vorgang ist stark vereinfacht, es gibt keine mehrstufigen Bestätigungen oder prominente Hinweise, die klar machen, dass die freigegebenen Inhalte von jedermann in der App gesehen, kommentiert und weiterverwendet werden können. Damit unterscheidet sich Meta AI deutlich von anderen KI-Angeboten wie ChatGPT oder Google Gemini, die stattdessen auf freiwillige Link-Freigaben setzen, um Privatsphäre zu gewährleisten.

Erschwerend kommt hinzu, dass Meta keine Hinweisdialoge zeigt, wenn neue Nutzer sich anmelden. Es gibt keine Unterrichtung über Datenschutzoptionen oder Voreinstellungen zum Teilen. Nutzer starten direkt in die App, ohne über die Folgen des „Share“-Buttons informiert zu werden. Das führt dazu, dass viele Menschen sich unwissentlich in einer Art öffentlichem Tagebuch austauschen, während sie eigentlich eine private Unterhaltung führen wollen. Die Kommentare unter den freigegebenen Einträgen spiegeln die Verwirrung und Sorge wider: Nutzer warnen sich gegenseitig, helfen bei der Löschung oder danken, nachdem sie darauf hingewiesen wurden, dass ihr Chat öffentlich war.

Für alle, die Meta AI nutzen und ihre Privatsphäre schützen möchten, gibt es jedoch konkrete Handlungsmöglichkeiten. Um bereits öffentlich geteilte Inhalte wieder privat zu machen, sollten Nutzer zunächst ihr Profil öffnen und in den Einstellungen unter „Daten und Privatsphäre“ die Option „Informationen verwalten“ wählen. Dort kann die Einstellung „Alle öffentlichen Prompts nur für mich sichtbar machen“ aktiviert und anschließend auf alle öffentlichen Einträge angewandt werden. Dies entfernt den öffentlichen Zugriff auf bisher geteilte Chats. Darüber hinaus ist es ratsam, die Funktion „Vorschlagen von Prompts“ in den gleichen Einstellungen zu deaktivieren, insbesondere für Facebook und Instagram.

So wird verhindert, dass Meta KI-Inhalte aus Ihrer Nutzung in den anderen Meta-Apps vorgeschlagen oder als Eingabehilfe verwendet werden. Diese Maßnahmen bieten zwar einen gewissen Schutz, doch der gesamte Vorfall zeigt, wie wichtig eine eigenverantwortliche und bewusst genutzte Datenschutzeinstellung ist. Die Kritik an Meta AI trifft auf eine grundsätzliche Herausforderung in der Entwicklung moderner KI-Apps: Wie verbindet man nutzerfreundliche kreative Funktionen mit konsequentem Schutz der Privatsphäre? Während Meta in der Vergangenheit oftmals mit Datenschutzskandalen konfrontiert war, könnte der aktuelle Fall ein Weckruf sein, um das Design zugänglicher Plattformen überdenken. Für Nutzer ist es zentral, vor der Nutzung von KI-Anwendungen Sicherheitsaspekte bewusst zu reflektieren und bei Unsicherheiten alternative Formen der Kommunikation zu wählen. Bis Meta selbst die Nutzeroberfläche überarbeitet und deutlichere Warnhinweise oder gar Schutzmechanismen implementiert, bleibt das Risiko bestehen, dass private Informationen ungeplant öffentlich werden und für unangenehme Konsequenzen sorgen.

Die Tatsache, dass man sogar sensible Themen wie Liebesbeziehungen, gesundheitliche Beschwerden oder Finanzangelegenheiten in einem öffentlichen Feed wiederfinden kann, sollte jedem Nutzer die Augen öffnen. Zusammenfassend zeigt die Meta AI-App einen spannenden technologischen Fortschritt, doch in ihrem aktuellen Zustand wird die Privatsphäre der Nutzer auf gefährliche Weise kompromittiert. Die Verantwortung liegt sowohl bei Meta, die Usability und Datenschutz miteinander in Einklang bringen müssen, als auch bei den Nutzern, die sorgfältig prüfen sollten, was sie über KI-Plattformen teilen. Datenschutz und Vertrauen dürfen nicht den Innovationen geopfert werden. Nur durch klare Kommunikation, transparente Einstellungen und bewusste Nutzung kann die Integration von KI-Tools in den Alltag gelingen, ohne die eigene Privatsphäre aufs Spiel zu setzen.

Die kommenden Monate werden zeigen, wie Meta auf die öffentliche Kritik reagiert und ob tiefgreifende Verbesserungen am Meta AI-Dienst umgesetzt werden, um diese Vorfälle künftig zu verhindern.