In der digitalen Ära, in der soziale Medien und Diskussionsplattformen zu einem wesentlichen Bestandteil des gesellschaftlichen Austauschs geworden sind, stellt die Erkennung von schädlichen Online-Akteuren eine immer größere Herausforderung dar. Besonders komplex wird die Aufgabe, wenn es darum geht, Nutzer zu identifizieren, die gezielt provozieren oder Diskussionen unterwandern – sogenannte Trolle. Ein aktuelles Forschungsergebnis zeigt, dass ein neuer Ansatz, der sich nicht nur auf die Inhalte konzentriert, sondern vor allem das Verhalten analysiert, neue Einblicke liefert. Besonders auffällig ist dabei eine Gruppe von Reddit-Nutzern, die sich vor allem durch ihr ständiges Widersprechen hervorheben und damit ein ganz eigenes Verhaltensmuster aufweisen. Traditionelle Methoden zur Identifikation problematischer Nutzer basierten meist darauf, den Inhalt ihrer Beiträge zu prüfen oder soziale Netzwerke innerhalb der Plattform zu analysieren.

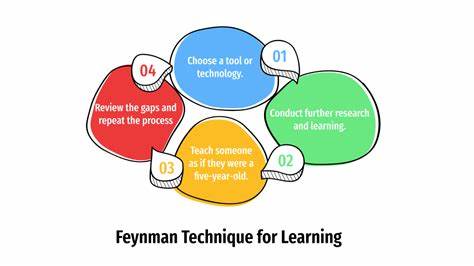

Allerdings haben diese Ansätze zwei wesentliche Schwächen. Zum einen können Nutzer ihre Sprache so kodieren oder verpacken, dass problematische Inhalte schwer erkennbar sind. Zum anderen funktionieren Netzwerkbetrachtungen auf Plattformen wie Reddit nur begrenzt, denn hier entstehen Verbindungen nicht primär durch soziale Freundschaften, sondern durch gemeinsame Interessen in themenspezifischen Foren, den sogenannten Subreddits. Die Forscherinnen und Forscher von Universitäten in Sydney und Lausanne haben deshalb einen innovativen Weg eingeschlagen: Sie entwickelten ein auf künstlicher Intelligenz basierendes System, das das Verhalten der Nutzer analysiert – also wie jemand handelt und mit anderen interagiert, und nicht nur was er sagt. Diese auf Inverse Reinforcement Learning basierende Methode erlaubt es, eine Art „Verhaltens-DNA“ zu entschlüsseln, die zeigt, welche Strategien ein Nutzer verfolgt.

Durch die Untersuchung von fast sechs Millionen Interaktionen auf Reddit über einen Zeitraum von sechs Jahren konnten fünf verschiedene Verhaltensprofile identifiziert werden. Besonders interessant ist die Erkenntnis, dass es eine spezifische Gruppe von Nutzern gibt, deren Hauptziel darin besteht, anderen zu widersprechen. Diese sogenannten „Disagreers“ suchen gezielt Gelegenheiten, gegensätzliche Standpunkte einzubringen, reagieren jedoch selten auf Antworten oder versuchen keine längeren Diskussionen zu führen. Diese Verhaltensweise fiel vor allem in politischen Foren wie r/news oder r/worldnews auf, während sie in kontroversen, aber geschlossenen Communities wie dem inzwischen gesperrten r/The_Donald weniger verbreitet war. Dieses Verhalten wirft ein neues Licht auf die Dynamik politischer Diskussionen im Internet.

Während in manchen Gemeinschaften die Nutzer eher mit unterschiedlichen Meinungen konfrontiert werden und sich dadurch widersprechend äußern, bilden sich in anderen geschlossenen Kreisen vor allem einheitliche Meinungen heraus, die sich gezielt gegen Außenstehende richten. Das erklärt auch, warum herkömmliche Moderationsmechanismen häufig an ihre Grenzen stoßen: Sie orientieren sich oft an Inhalten und können nicht die Verhaltensstrategien erkennen, die Nutzer verfolgen. Bemerkenswert ist zudem, dass das System eine parallele Verhaltensähnlichkeit zwischen Nutzern in vollkommen unterschiedlichen Communities feststellte. So zeigen beispielsweise Nutzer im Fußball-Forum r/soccer und im E-Sport-Forum r/leagueoflegends sehr ähnliche Muster. Beide Gruppen bilden starke Gemeinschaften mit intensiver Emotionalität, starkem Teamgeist und hitzigen Diskussionen über Strategien und Leistungen.

Dieses Phänomen zeigt, dass Online-Polarisierung nicht nur durch Inhalte entsteht, sondern auch durch die Art und Weise, wie Menschen miteinander interagieren. Solche Erkenntnisse sind für Moderatoren von Online-Plattformen hochrelevant, denn sie ermöglichen es, potenziell schädliches Verhalten frühzeitig zu erkennen, noch bevor große Mengen problematischer Inhalte veröffentlicht werden. Ein großer Vorteil der Verhaltensanalyse besteht darin, dass sie sprachunabhängig arbeitet und somit auch in mehrsprachigen oder multikulturellen Kontexten einsetzbar ist. Außerdem ist es für Nutzer deutlich schwieriger, ihr Verhalten grundlegend zu verändern als lediglich die Wortwahl anzupassen, was die Methode widerstandsfähiger gegen Umgehungsversuche macht. Darüber hinaus eröffnet die Forschung neue Perspektiven im Kampf gegen die Verbreitung von Fehlinformationen und Online-Manipulation.

Anstatt sich nur auf die Korrektur oder Löschung fragwürdiger Inhalte zu konzentrieren, könnten Plattformen Verhaltensmuster fördern, die eine konstruktivere und respektvollere Kommunikationskultur begünstigen. So lässt sich die digitale Identität eines Nutzers nicht allein über dessen Worte bestimmen, sondern auch über das Verhalten und die Interaktionen, die er pflegt. Die Untersuchung zeigt eindrucksvoll, dass ein tieferes Verständnis menschlichen Verhaltens im digitalen Raum essentiell ist, um die Herausforderungen von Online-Spaltung, Belästigung und Manipulation zu bewältigen. Methodische Innovationen wie die Verhaltensanalyse mit Hilfe von künstlicher Intelligenz bieten vielversprechende Ansätze, um gesündere Online-Communities zu fördern und den Einfluss von Trollen und giftiger Rhetorik einzudämmen. Zusammenfassend lässt sich sagen, dass die digitalen Debattenräume zunehmend komplexer werden und neue Instrumente brauchen, um schädliche Dynamiken zu erkennen und zu regulieren.

Die Identifikation der „Disagreers“ auf Reddit ist dabei nur ein Beispiel, wie Verhaltensmuster als Schlüssel zum besseren Verständnis und zur besseren Steuerung von Online-Kommunikation dienen können. Mit solchen Technologien könnte die Zukunft der sozialen Medien eine sein, in der Respekt, Sachlichkeit und gemeinschaftlicher Austausch wieder im Vordergrund stehen – auch und gerade in politisch aufgeladenen Diskussionen.