Die rasante Entwicklung von Künstlicher Intelligenz (KI) verändert die Art und Weise, wie Daten verarbeitet und Entscheidungen getroffen werden. Immer mehr Anwendungen verlagern ihre Rechenprozesse vom zentralisierten Rechenzentrum hin zum sogenannten Edge, also an den Rand des Netzwerks. Künstliche Intelligenz am Edge, oft auch als Edge AI bezeichnet, ermöglicht es Geräten, autonome Entscheidungen in Echtzeit zu treffen, ohne die Daten zunächst zur Cloud oder einem Rechenzentrum senden zu müssen. Das revolutioniert zahlreiche Branchen – von der Industrie über das Gesundheitswesen bis hin zu Smart Cities und dem Internet der Dinge (IoT). Doch um die Vorteile dieser Technologie voll auszuschöpfen, ist ein Verständnis der zugrunde liegenden Architektur sowie der mit ihr verbundenen Chancen und Herausforderungen essenziell.

Im Kern beschreibt die Architektur von KI am Edge eine verteilte Struktur. Im Gegensatz zu zentralisierten Systemen, bei denen alle Daten an eine Cloud oder ein zentrales Rechenzentrum gesendet werden, findet die Datenverarbeitung näher am Ursprungsort der Daten statt. Dies kann beispielsweise ein Sensor in einer Fabrikhalle, eine Überwachungskamera auf einem Firmengelände oder ein mobiles Endgerät wie ein Smartphone sein. Diese Geräte verfügen über eingebettete KI-Modelle, die in der Lage sind, komplexe Analysen und Entscheidungen direkt vor Ort durchzuführen. Die Architektur umfasst mehrere Komponenten, darunter eine clientseitige Anwendung, eine Zwischenschicht aus Softwarebibliotheken sowie leistungsfähige Modelle zumeist in Form von großen Sprachmodellen (LLMs) oder Bildverarbeitungsalgorithmen.

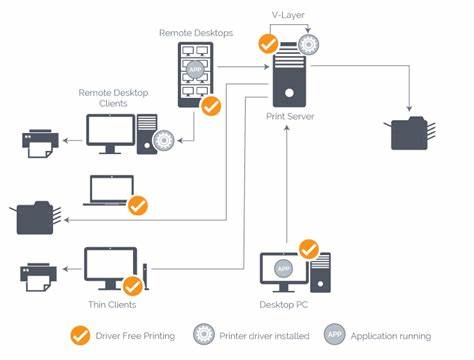

Ein typisches Szenario besteht darin, dass ein Nutzer oder ein Endgerät einen Eingabewert, wie ein natürlichsprachlicher Befehl oder ein Bild, an eine clientseitige Anwendung schickt. Diese Anwendung verarbeitet die Information mithilfe eines Frameworks wie Tensorflow, PyTorch oder spezifischen Bibliotheken zur Modelloptimierung, übersetzt die Daten in eine maschinenverständliche Form und füttert das Modell damit. Anschließend führt die KI ihre Inferenz durch und liefert eine Antwort zurück, die entweder für weitere lokale Entscheidungen genutzt oder an andere Systeme weitergeleitet wird. Ein differenzierter Blick sollte außerdem die Unterscheidung zwischen Near Edge und Far Edge berücksichtigen. Near Edge beschreibt dabei Rechenressourcen, die relativ nahe am zentralen Datennetzwerk oder Rechenzentrum angesiedelt sind, etwa regionale Server oder Firmenstandorte mit gewissen Sicherheits- und Optimierungsmechanismen.

Far Edge hingegen bezieht sich auf Geräte mit sehr spezifischen Funktionen, oft ressourcenbeschränkt und direkt am Ort des Geschehens, wie Überwachungskameras oder Sensoren auf der Fabriketage. Diese Geräte können nur begrenzte Datenverarbeitungsleistung bereitstellen und sind auf effiziente, anwendungsorientierte KI-Modelle angewiesen. Die Vorteile von KI am Edge sind vielfältig. Vor allem ist die Privatsphäre ein wichtiger Faktor. Daten, die lokal verarbeitet werden, verlassen nicht zwingend das Gerät oder das lokale Netzwerk, was Risiken wie eine unkontrollierte Weitergabe sensibler Informationen deutlich reduziert.

Zudem spricht die reduzierte Latenz für den Edge-Einsatz, denn Verarbeitung und Antwort kommen nahezu in Echtzeit, da der Weg über Netzwerke nicht nötig ist. Dies ist z.B. in sicherheitskritischen Bereichen wie der Medizintechnik oder in autonomen Fahrsystemen von großer Bedeutung. Ein weiterer bedeutender Vorteil sind die potenziellen Kosteneinsparungen.

Cloud-basierte KI-Dienste erfordern oft wiederkehrende Nutzungsgebühren und Bandbreitenkosten, die sich bei großflächigem, kontinuierlichem Betrieb schnell summieren. Die Verlagerung auf lokale Geräte kann diese Kosten durch Einsparungen bei der Datenübertragung und zentraler Serverinfrastruktur reduzieren. Gleichwohl bringt der Einsatz von KI am Edge auch Herausforderungen mit sich. Hardwareanforderungen sind ein zentrales Thema. Leistungsstarke KI-Modelle benötigen beträchtliche Rechenleistung, Speicher und Energie.

Vor allem bei komplexen Aufgaben wie der Verarbeitung großer Bild- oder Video-Datenströme kann die nötige Hardware schnell sehr kostspielig und energieintensiv werden. Gleichzeitig ist die Hardware oft zweckgebunden und auf spezifische Funktionen ausgerichtet, so dass generische Systeme für universelle Anwendungen fast immer zu aufwendig sind. Ein weiterer Punkt ist die Komplexität bei der Entwicklung und Programmierung. Edge-Geräte interagieren oft mit spezialisierten Sensoren, Kameras oder Aktoren, deren Schnittstellen und Funktionen nicht immer standardisiert sind. Entwickler benötigen daher detailliertes Know-how sowohl für Hardwarenahe Programmierung als auch für Modelloptimierung, um die Leistung der KI auf dem Gerät zu maximieren und Ressourcen bestmöglich zu schonen.

Die Optimierung von Modellen, zum Beispiel durch hyperparameter tuning oder Quantisierung, ist ein entscheidender Faktor, weshalb Entwickler eine ganz eigene Expertise im Bereich Edge AI benötigen. Eine besondere Herausforderung liegt in der Vielfalt der Hardwareplattformen. Unterschiedliche CPU-Architekturen wie ARM oder x86 sowie verschiedene Typen von Grafikprozessoren und KI-Beschleunigern verlangen maßgeschneiderte Programmieransätze. Es gibt keine einheitliche Lösung, und die Kompatibilität mit verschiedenen Chipsätzen stellt Unternehmen vor zusätzliche Hürden. Zusätzlich sind Wartung und Deployment von KI auf Edge-Geräten deutlich aufwändiger als in cloudbasierten Systemen.

Software- und Modell-Updates müssen oft manuell oder zumindest device-spezifisch eingespielt werden. Gerade bei einer großen Anzahl von zig oder gar hunderten verteilten Geräten kann das zu einem logistischen Herausforderung werden. Zudem müssen Unternehmen sicherstellen, dass während eines Updates der Betrieb nicht durch Ausfallzeiten beeinträchtigt wird, was insbesondere in Produktionsumgebungen problematisch sein kann. Trotz dieser Herausforderungen ist KI am Edge ein bedeutender Schritt in der Weiterentwicklung von verteilten Systemen und intelligenten Anwendungen. Firmen können durch den Einsatz von Edge AI eine bessere Kontrolle über ihre Daten erlangen, Prozesse beschleunigen und neue Anwendungsfelder erschließen.

Die Kombination aus lokalen Echtzeit-Verarbeitungen und gegebenenfalls ergänzenden Cloud-Funktionalitäten ermöglicht hybride Architekturen, die das Beste aus beiden Welten vereinen. Industrie 4.0 ist hier ein Beispiel, in dem Edge KI für vorausschauende Wartung, Qualitätskontrolle und Automatisierung eingesetzt wird. In der Logistik kann AI am Edge zum Beispiel in der Supply Chain dafür sorgen, dass Warenbewegungen verfolgt und optimiert werden, ohne dass große Mengen sensibler Daten in eine zentrale Cloud transferiert werden müssen. Im Gesundheitsbereich helfen Edge-Geräte, Patientendaten sofort zu analysieren und kritische Zustände schneller als je zuvor zu erkennen.

Der technologische Fortschritt bei KI-Modellen, Hardwarekomponenten und Software-Frameworks wird die Verbreitung von Edge AI weiter vorantreiben. Hersteller entwickeln zunehmend kompaktere, effizientere KI-Chips, die speziell für Edge-Geräte optimiert sind. Gleichzeitig werden Open-Source-Bibliotheken und Tools für Modellkompression stärker genutzt, um den Ressourcenverbrauch zu reduzieren. Auch Standards im Bereich des Deployments und der Geräteverwaltung sind auf dem Vormarsch, was die Praxis sollte professionalisieren und Standardprozesse etablieren. Letztlich hängt der Erfolg von KI am Edge davon ab, wie gut Unternehmen den spezifischen Einsatzzweck analysieren und Lösungen gezielt darauf anpassen.

Es geht nicht darum, einfach leistungsfähigste oder größte Modelle auf jedes Gerät zu pressen, sondern durch intelligentes Design und abgestimmte Architektur die bestmöglichen Ergebnisse für die jeweilige Anwendung zu erzielen. Mit dem richtigen Know-how, der passenden Hardware und einer durchdachten Strategie können Firmen somit signifikante Vorteile nutzen und die Weichen für eine innovative, datengetriebene Zukunft stellen.