Arkflow, eine Open-Source-Plattform zur Orchestrierung und Optimierung von Datenpipelines, steht kurz vor einer bedeutenden Erweiterung: die Unterstützung von Python-Prozessoren. Diese Neuerung markiert einen wichtigen Schritt, um die Flexibilität der Plattform zu erhöhen und den Bedürfnissen der Entwickler-Community gerecht zu werden, die oft auf Python als bevorzugte Programmiersprache für Datenverarbeitung und Analyse setzt. Die Einführung der Python-Prozessoren in Arkflow bringt ein hybrides Ökosystem aus Rust und Python zusammen und eröffnet umfangreiche Möglichkeiten für moderne datengetriebene Anwendungen. In den letzten Jahren hat sich Arkflow als robuste und performante Lösung für die Verarbeitung großer Datenmengen etabliert, die vor allem durch die Nutzung der Programmiersprache Rust besticht. Rust gilt als sicher und performant, spielt aber oft in Integrationen mit anderen Sprachen eine Rolle, um die Stärken verschiedener Ökosysteme zu verbinden.

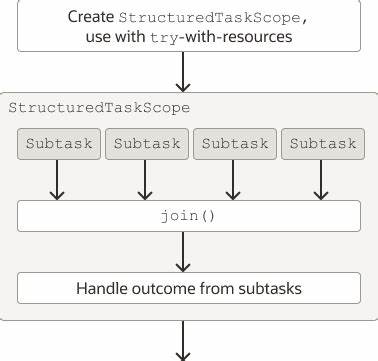

Python ist eine der beliebtesten Programmiersprachen für Data Science, maschinelles Lernen und allgemeine Anwendungsentwicklung im Bereich Big Data, was die Kombination dieser beiden Technologien besonders attraktiv macht. Die technische Umsetzung erfolgte durch die Integration der pyo3-Bibliothek, einem Bindeglied, das es ermöglicht, Python-Code direkt in Rust-Anwendungen einzubetten und auszuführen. Damit können Entwickler Python-Prozessoren als Plug-ins in Arkflow nutzen, ohne auf die Geschwindigkeit und Sicherheit der Grundplattform verzichten zu müssen. Diese Integration wurde umfassend getestet und mit Beispielen ausgestattet, um die Nutzung so intuitiv wie möglich zu gestalten. Ein bedeutsames Feature ist die Fähigkeit von Arkflow, Python-Module asynchron innerhalb der Pipeline zu verarbeiten.

Das bedeutet, dass Python-Funktionen parallel zu anderen Prozessoren ausgeführt werden können, was die Effizienz der Datenverarbeitung erheblich steigert. Gleichzeitig wurden Abhängigkeiten und Docker-Umgebungen angepasst, damit Python direkt in den Containern verfügbar ist, was die Einrichtung und den Betrieb der Pipelines weiter vereinfacht. Der Einzug von Python-Prozessoren bringt für Entwicklerhandlungsfreiheit, da nun viele bewährte Python-Bibliotheken in der Datenpipeline genutzt werden können. Ob es um die Vorverarbeitung von Daten, Machine Learning oder komplexe statistische Analysen geht – die Vielfalt und Marktreife der Python-Ökosysteme eröffnet neue Horizonte. Für Unternehmen bedeutet dies, dass sich vorhandene Python-Skripte und Tools ohne großen Mehraufwand in Arkflow integrieren lassen, was die Entwicklungszeiten verkürzt und die Wartbarkeit verbessert.

Neben der Erweiterung des Funktionsumfangs wurden auch zahlreiche Abhängigkeiten überprüft und verbessert. Beispielsweise wurde die Anbindung relevanter Komponenten auf fest geschriebene Versionen aus git-Repositories umgestellt, was für mehr Stabilität und Nachvollziehbarkeit sorgt. Solch ein Update hilft, Inkonsistenzen zu vermeiden und garantiert, dass neue Features in einer konsistenten Umgebung funktionieren. Die Arkflow-Community profitiert von der Offenheit und Modularität dieser Neuerung – Entwickler können eigene Python-Prozessoren entwickeln, anpassen und direkt in ihre Workflows integrieren. Arkflow bietet eine Beispielkonfiguration, die als Grundlage dient, um schnell eigene Python-Funktionen zu implementieren und diese in der Pipeline zu testen.

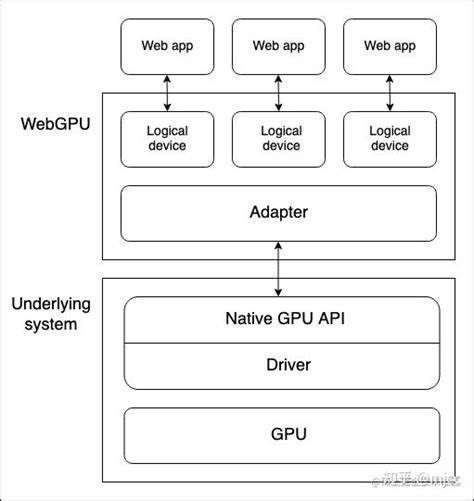

Mehr noch, da Arkflow auch die Containerisierung mittels Docker unterstützt, wurden die Images an die neue Python-Integration angepasst. Mit den neu hinzugefügten Python-Paketen in Build- und Runtime-Images entfallen zusätzliche Konfigurationsschritte, wodurch die bereitzustellenden Umgebungen weniger komplex und schneller einsatzbereit sind. Dies erleichtert zudem Continuous-Integration- und Deployment-Prozesse erheblich. Die Kombination aus Rust und Python in Arkflow verspricht zugleich eine ideale Balance zwischen Performance und Flexibilität. Entwicklern steht dabei ein innovatives Framework zur Verfügung, das die besten Eigenschaften beider Welten nutzbar macht.

Python bringt das enorme Spektrum an Datenanalyse- und KI-Bibliotheken mit, Rust sorgt für eine sichere, effiziente und stabile Basis. Die Erweiterung unterstützt ebenfalls moderne Entwicklungsprozesse, indem zahlreiche Code-Qualitätsmaßnahmen integriert wurden. So wurden Docstrings ergänzt, Formatierungskorrekturen vorgenommen und eine strukturierte Dokumentation geschaffen. Solche Maßnahmen sorgen dafür, dass die Funktionalität langfristig stabil bleibt und neue Entwickler den Einstieg erleichtert. Insgesamt bedeutet die Integration der Python-Prozessoren in Arkflow einen grundlegenden Fortschritt.

Unternehmen und Entwickler können nun komplexe Datenverarbeitungsschritte als Python-Skripte schreiben, die nahtlos innerhalb von Arkflow-Pipelines ausgeführt werden. Durch diesen hybriden Ansatz wird die Nutzung von Arkflow enorm erweitert – weg von reinem Rust-basiertem Code hin zu einer vielschichtigen Plattform, die mit der Vielfalt moderner Datenökosysteme Schritt hält. Gleichzeitig trägt diese Erweiterung dazu bei, die Zukunftssicherheit von Arkflow zu gewährleisten. Immer mehr datenintensive Anwendungen verlangen nach flexiblen und erweiterbaren Plattformen, die sich schnell an neue Anforderungen anpassen lassen. Die Möglichkeit, Python-Prozessoren einzusetzen, positioniert Arkflow hervorragend für den Umgang mit Machine Learning, KI-Projekten und Big Data Workloads, die häufig von der umfangreichen Python-Community profitieren.