In unserer zunehmend digitalisierten Welt begegnen wir immer häufiger Künstlicher Intelligenz (KI) und komplexen mathematischen Modellen, die Software und Entscheidungen beeinflussen. Trotz ihres rein logischen und formalen Charakters neigen Menschen dazu, diese abstrakten mathematischen Konstrukte mit menschlichen Eigenschaften zu versehen – ein Phänomen, das als Anthropomorphisierung bekannt ist. Besonders bei KI-Systemen und Algorithmen, die als „Agenten“ oder gar als „virtuelle Teams“ dargestellt werden, tritt diese Tendenz deutlich hervor. Doch warum passiert das? Und welche Folgen hat diese menschliche Verbildlichung für die Wahrnehmung und Nutzung dieser Technologien? Zum besseren Verständnis lohnt sich eine kritische Auseinandersetzung mit den Ursachen und der Kritik an diesem Trend. Anthropomorphisierung ist ein tief im menschlichen Denken verwurzeltes Verhalten.

Wenn uns etwas unbekannt, komplex oder fremdartig erscheint, versuchen wir, es durch vertraute Bilder greifbarer zu machen. Historisch betrachtet dienten Mythen, Götterfiguren und Erzählungen dazu, unerklärliche Phänomene zu begreifen. Im digitalen Zeitalter führt das dazu, dass wir Maschinen, Systeme oder – wie in aktuellen Diskussionen um KI – mathematische Gleichungen als Menschen „auffassen“. Die Gleichung wird metaphorisch zum „Entwickler“ oder die KI zu einem „Team“, in dem „Modelle miteinander kommunizieren“. Doch die Realität hinter den Kulissen zeigt eine andere Wahrheit: KI ist ein mathematisches Modell.

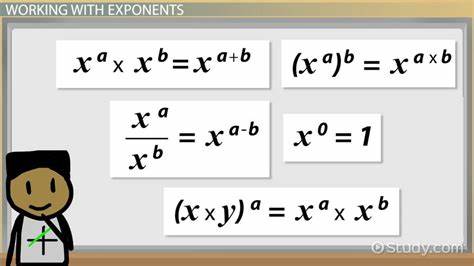

Sie ist eine Funktion, die eine lange Eingabesequenz von Daten nimmt und daraus eine lange Ausgabesequenz generiert. Eingabe und Ausgabe können dabei etwa unsere Absichten als Entwickler beziehungsweise den daraus resultierenden Programmcode repräsentieren. Diese Sichtweise hebt die mechanistische und formal-logische Natur von KI hervor und macht deutlich, dass menschliche Eigenschaften im Kern nicht zum Modell gehören. Warum dennoch die Verlockung, KI als „virtuelles Team“ oder gar als eine Gruppe von Softwareentwicklern darzustellen? Hier spielen psychologische und soziale Faktoren eine Rolle. Menschen empfinden Nähe und Verständnis leichter, wenn sie abstrakte Konzepte personalisieren.

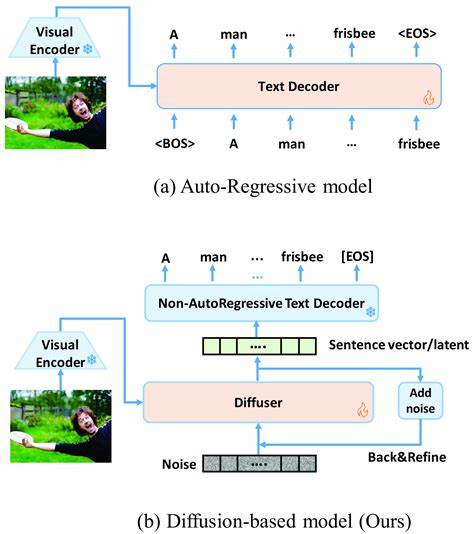

Zudem bieten solche Metaphern Manager*innen und Anwender*innen scheinbare Kontrollmöglichkeiten oder wenigstens eine Bezugsebene, die technische Komplexität reduziert. Leider führt gerade diese vereinfachende Sicht häufig zu Irrtümern und Fehlannahmen über die Arbeitsweise von KI und deren Kontrollierbarkeit. Die Vorstellung, dass KI-Systeme intern wie eine Konferenz von „Bots“ kommunizieren, erzeugt zwar ein anschauliches Bild, aber es verdeckt die tatsächliche Komplexität und die Herausforderungen in der Interpretierbarkeit. Jenseits von Schwarz-Weiß-Metaphern handelt es sich bei komplexen neuronalen Netzwerken oft um sogenannte „Black Boxes“, deren innere Entscheidungswege selbst für Expert*innen schwer nachvollziehbar sind. Werden solche Modelle übereinander geschaltet und kommunizieren miteinander, verschärft sich dieses Erklärbarkeitsproblem dramatisch.

Die Gefahr, die Entscheidungsfindung nicht mehr verstehen zu können, wächst – ein Zustand, der in Fachkreisen als „nuclear option“ bezeichnet wird und nur mit besonders überzeugendem Mehrwert in Kauf genommen werden sollte. Anstatt in diese undurchsichtigen Systeme mehr Indirektion zu integrieren, wäre es sinnvoller, den Fokus auf Qualität der Eingaben (Inputs) und Nachvollziehbarkeit des Prozesses zu legen. Der User sollte das System nicht als „gefährliche Gruppe von kleinen Robotern“ betrachten, sondern als eine präzise mathematische Maschine, die auf Basis eines gut definierten Inputs qualitativ hochwertig produziert. Wer die KI nicht als magisches Team, sondern als Gleichung versteht, kann die Verantwortung und Kontrolle über den Entwicklungsprozess bewahren – und mögliche Fehler schneller erkennen oder beheben. Dieser Perspektivwechsel eröffnet auch konstruktive Möglichkeiten für die Zukunft der Softwareentwicklung.

Die klassische Vorstellung eines großen Entwicklerteams wird durch autonome, leistungsfähige Modelle abgelöst, die komplexen Code effizient und korrekt erzeugen können. Es ist daher vorteilhaft, die menschliche Steuerung eher auf die sorgfältige Formulierung von Vorgaben zu legen, anstatt auf ineffiziente, menschlich geprägte Interaktionen zwischen multiplen Bots oder Agenten. So kann die symbiotische Zusammenarbeit zwischen Mensch und Maschine durch gesteigerte Präzision und reduzierte Komplexität auf Augenhöhe stattfinden. Es stellt sich außerdem die Frage, inwieweit die Technologievermarktung diese Anthropomorphisierungen fördert. Anbieter von AI-Diensten haben ein wirtschaftliches Interesse daran, Konzepte ansprechend und nachvollziehbar zu machen.

Die Inszenierung von KI als „smarter Assistent“ oder „Agententeam“ mag das Nutzererlebnis vereinfachen, doch es besteht die Gefahr, dass dadurch die Transparenz und das Verständnis für algorithmische Prozesse geopfert werden. Für Entwickler*innen, die auf Qualität, Nachvollziehbarkeit und Effizienz Wert legen, ist eine nüchterne Betrachtung wesentlich hilfreicher. Dass wir uns bei KI versehentlich zum Teil von Kindheitsbildern und medialen Erfahrungen mit sprechenden Tieren oder Maschinen leiten lassen, ist menschlich nachvollziehbar. Doch gerade bei wissenschaftlich-technischen Innovationen sollten wir den Schleier dieser anthropomorphen Projektionen ablegen und die Technologie auf der Basis ihrer wahren Eigenschaften bewerten. Die kommende Generation von Softwareentwicklern steht somit in der Verantwortung, ein differenziertes Verständnis von KI zu vermitteln und deren Missverständnisse zu korrigieren.

Ein bewusster Umgang mit Sprache und Metaphern ist zentral, um die Vorteile mathematischer und algorithmischer Systeme bestmöglich auszuschöpfen. Wenn Entwickler und Nutzer KI als präzises Werkzeug begreifen, mit einem klaren Input-Output-Verhalten, können sie die Innovationskraft maximieren. Gleichzeitig bleibt die menschliche Kontrolle intakt, und die Entstehung von technisch schwer erklärbaren „Black-Box“-Szenarien wird vermieden. Abschließend lässt sich sagen, dass die Anthropomorphisierung von mathematischen Gleichungen und KI zwar aus psychologischen und soziokulturellen Gründen verständlich ist, jedoch in technischem und praktischen Kontext äußerst problematisch sein kann. Statt KI als eine Art Menschenensemble zu sehen, sollten wir sie als hochentwickelte mathematische Funktionen wahrnehmen.

Nur so können wir ihre Potenziale optimal nutzen, während wir gleichzeitig Transparenz und Kontrolle sicherstellen. Ein Umdenken weg von überzogenen menschlichen Projektionen hin zu rationalem Umgang mit Technologie ist daher ein entscheidender Schritt für die Zukunft der Softwareentwicklung und den verantwortungsvollen Einsatz von KI.