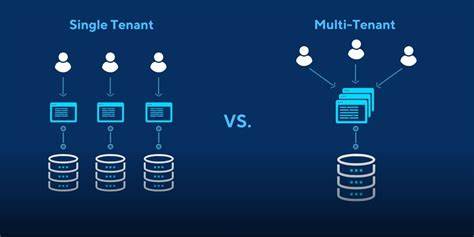

In der heutigen Zeit setzen viele Unternehmen auf Multi-Tenant-Architekturen, um eine zentrale Datenbanklösung für mehrere Mandanten zu realisieren. Dies bringt vielseitige Vorteile mit sich, wie etwa geringere Kosten, einfachere Wartung und schnelle Skalierbarkeit. Allerdings ergeben sich dadurch auch komplexe Anforderungen bei der Datenverwaltung, insbesondere wenn einzelne Mandantendaten für Debugging, Tests oder Migrationen extrahiert werden sollen. Dies ist besonders herausfordernd, wenn die Datenbank nicht durchgehend mittels Foreign Keys (FK) strukturiert ist und die Tenant-Informationen nicht durchgängig in allen Tabellen vorliegen. PostgreSQL ist als leistungsstarkes Open-Source-Datenbanksystem mit zahlreichen Funktionen etabliert, doch das selektive Dumpen von Daten in einer Multi-Tenant-Umgebung ist keine triviale Aufgabe.

Für Entwickler und Datenbankadministrator*innen ist es daher wichtig, geeignete Werkzeuge und Methoden zu kennen, die eine gezielte Datenextraktion ermöglichen, ohne die Konsistenz der Daten zu gefährden oder aufwendige manuelle Arbeitsschritte zu erfordern. Ein grundlegendes Problem vieler Multi-Tenant-Datenbanken ist, dass nicht alle Tabellen direkt eine Tenant-ID oder ein Account-ID-Feld enthalten. So kann zum Beispiel die Tabelle für Nutzer ein solches Feld beinhalten, wohingegen damit verbundene Einträge, etwa Posts oder Aktivitäten, nur über eine Nutzer-ID referenziert werden. Wenn zusätzlich keine ausnahmslos implementierten Fremdschlüsselbeziehungen existieren, fehlt ein formaler Weg, um zusammengehörige Datensätze automatisch zu erkennen und korrekt zusammenzuführen. Die mangelnde Datenintegrität erschwert daher die Nutzung von Standardwerkzeugen wie pg_dump, welches Daten meist nur auf Tabellen- oder Datenbankebene exportiert, ohne tiefere Beziehungen zu berücksichtigen.

In solchen Szenarien werden spezialisierte Datenunterteilungstools (Data Subsetting Tools) relevant, die darauf ausgelegt sind, Teilmengen großer Datenbestände konstruktiv auszuwählen. Einige bekannte Beispiele in diesem Bereich sind Greenmask, Jailer, Tonic Condenser und ähnliche Lösungen. Diese Werkzeuge können in der Regel die Beziehungen zwischen Datensätzen entlang von Foreign Key-Pfaden verfolgen und so gezielt Daten herausfiltern, die in Abhängigkeit zu den referenzierten Schlüsseln stehen. Dabei ist zu beachten, dass viele Tools primär in eine Richtung der FK-Beziehungen funktionieren, was die Modellierung bei bidirektionalen oder komplex verschachtelten Strukturen erschweren kann. Die fehlende Implementierung von Foreign Keys ist ein weiteres wesentliches Hindernis.

Viele dieser Werkzeuge sind darauf angewiesen, die Datenstruktur über die FK-Beziehungen zu erfassen. Wenn diese Informationen nicht vorhanden sind, bleibt nur die Möglichkeit, sogenannte virtuelle Fremdschlüssel selbst zu definieren, sodass das Tool eine graphenartige Struktur der Beziehungen aufbauen kann. Greenmask bietet beispielsweise die Funktion, diese virtuellen Foreign Keys manuell anzugeben, wodurch sich trotz fehlender physischer Constraints eine konsistente Subset-Auswahl erreichen lässt. Diese Vorgehensweise setzt allerdings ein gutes Verständnis der Datenstruktur und der hinterlegten Beziehungen voraus. Für Unternehmen, die mit einem solchen Setup arbeiten, kann es demnach sinnvoll sein, die Datenbank langfristig um FK-Beschränkungen zu ergänzen oder die Tenant-Datenmodelle zu normalisieren, damit eine eindeutigere Mandantentrennung sichergestellt ist.

Die Einführung von Tenant IDs in allen relevanten Tabellen, einschließlich derer, die bisher nur indirekt assoziiert sind, verbessert nicht nur die Datenqualität, sondern unterstützt auch Compliance-Anforderungen und erleichtert spätere Migrationen, etwa in separate Datenbanken oder Regionen. Parallel zu Tools gibt es auch Techniken und praxisorientierte Tipps, die den manuellen Dump-Prozess durch SQL-Skripte und Filterkonzepte erleichtern. Beispielsweise kann man durch rekursive Abfragen und Verknüpfungen mit Join-Operatoren die psychologische Layer von zusammenhängenden Datensätzen simulieren und damit gezielte Teilexporte auslösen. Diese Ansätze erfordern jedoch eine intensive Einarbeitung in die jeweiligen Schema-Details und sind fehleranfälliger, zumal ohne FKs die Referenzen lose und nicht strikt validiert sind. Außerdem sind regelmäßige Datenbankmigrationen empfehlenswert, um sowohl bestehende Tabellenstrukturen zu verbessern als auch neue Mandantenoperationen reibungslos einzuführen.

Dabei gilt es, technische Lösungen mit organisatorischen Maßnahmen zu kombinieren – etwa die Schaffung eines konsistenten Namensschemas für ID-Felder und das Aufsetzen von Datenintegritätsprüfungen. Insgesamt zeigt sich, dass die Auswahl passender Datenextraktionswerkzeuge von der Datenbankarchitektur maßgeblich abhängt. Wo FK-Constraints umfassend implementiert sind, erleichtern gängige Subsetting-Tools und auch herkömmliche Dump-Utilities die Arbeit erheblich. Bei unvollständigen oder fehlenden FK-Definitionen muss durch virtuelle Schlüssel, manuelle Mapping-Skripte oder eine schrittweise Modernisierung der Datenbanken für ausreichende Strukturierung gesorgt werden. Für Entwickler, die neu in einem Unternehmen mit einer komplexen Multi-Tenant-Postgres-Datenbank starten, ist es besonders wichtig, zuerst die Datenarchitektur zu verstehen und Informationen über das Verhalten der verschiedenen Tabellen zueinander einzuholen.

Die Einführung von Tenant-Informationen und FK-Constraints sollte idealerweise gemeinsam mit den verantwortlichen Teams vorangetrieben werden, um technische Schulden abzubauen und langfristige Erweiterbarkeit sicherzustellen. Sowohl technisch als auch im organisatorischen Kontext gilt: eine klar nachvollziehbare, konsistente Datenmodellierung bildet die wesentliche Grundlage für effiziente Entwicklungsprozesse, insbesondere bei der Fehlerbehebung und beim Testen von tenant-spezifischen Problemen. Schließlich unterstützen moderne Cloud-Datenbankanbieter und -Dienstleister oft ebenfalls Werkzeuge, die speziell auf Multi-Tenant-Daten zugeschnitten sind. Dabei helfen Features wie automatisierte Datenmaskierung oder segmentierte Snapshots bei der Einhaltung von Datenschutzvorgaben ohne großen manuellen Aufwand. Zusammenfassend sind für das Thema „Selektives PgDump von Multi-Tenant-Datenbanken“ insbesondere folgende Kernaspekte entscheidend: Die Qualität und Vollständigkeit der Datenbankstruktur, etwa über Tenant IDs und FK, haben großen Einfluss auf die Auswahl und Effektivität von Dump- und Subsetting-Tools.