Die fortschreitende Entwicklung künstlicher Intelligenz (KI) hat in den letzten Jahren für eine erhebliche Veränderung der Art und Weise gesorgt, wie Inhalte im Internet erstellt und konsumiert werden. Besonders auf Social-Media-Plattformen lässt sich zunehmend ein Anstieg von Texten feststellen, die entweder vollständig oder teilweise durch KI-Systeme generiert wurden. Das stellt Betreiber, Nutzer und Moderatoren vor die Herausforderung, echte von maschinell erzeugten Beiträgen zu unterscheiden. Eine verlässliche Erkennung von KI-generierten Texten ist dabei aber mit zahlreichen Schwierigkeiten verbunden und stellt die Entwickler von Detektionssystemen vor große technische und ethische Probleme. Im Folgenden wird ein detaillierter Einblick in die Situation rund um die Erkennung von KI auf Social-Media geboten, wobei sowohl bestehende Lösungen als auch deren Grenzen und mögliche Zukunftsperspektiven beleuchtet werden.

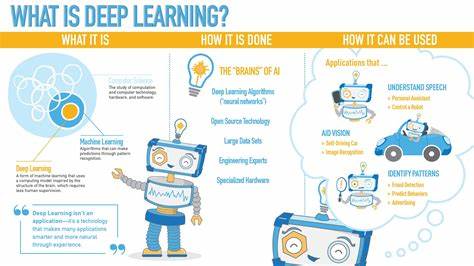

Das Thema KI-Erkennung gewinnt vor allem deshalb an Bedeutung, weil immer mehr Inhalte auf sozialen Netzwerken mithilfe von großen Sprachmodellen wie ChatGPT oder vergleichbaren neuronalen Netzen erstellt werden. Diese Technologien sind in der Lage, Texte zu generieren, die oft kaum noch von menschlichen Beiträgen unterscheidbar sind. Das kann einerseits Vorteile bringen, etwa die Unterstützung von Nutzern bei der Formulierung von Beiträgen, andererseits birgt es Risiken wie die Verbreitung von Fehlinformationen, Spam oder manipulativem Content. Betreiber sozialer Plattformen wünschen sich aus diesem Grund robuste Methoden, um KI-Text automatisch zu erkennen und so die Qualität ihrer Inhalte sicherzustellen. Bei der Suche nach technischen Lösungen wird häufig auf kommerzielle Dienste zurückgegriffen, die eine Analyse von Texten per API anbieten.

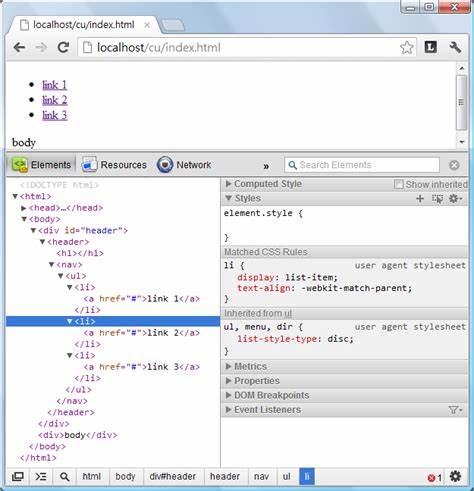

Ein bekanntes Beispiel dafür ist GPTZero, das speziell für die Erkennung von KI-generierten Inhalten entwickelt wurde. GPTZero kann auf einzelne Textabschnitte angewendet werden und bewertet die Wahrscheinlichkeit, ob der Text von einer künstlichen Intelligenz stammt. Die Vorteile solcher Dienste liegen in ihrer vergleichsweise hohen Erkennungsrate und der einfachen Einbindung. Allerdings gibt es auch Nachteile – vor allem im Hinblick auf Datenschutz und Kosten, da alle Inhalte an einen externen Anbieter übermittelt werden müssen, was in vielen Fällen nicht erwünscht ist. Daher arbeiten Entwickler und Communities an Open-Source-Alternativen, die man selbst hosten kann.

Projekte wie Binoculars und ZipPY schlagen Wege vor, KI-Texte lokal zu erkennen, ohne die Daten an Dritte zu senden. Diese Lösungen bieten den Vorteil der vollständigen Kontrolle über die Daten, sind aber mit erheblichem technischem Aufwand verbunden. Sie erfordern häufig leistungsstarke Hardware wie GPUs mit viel Arbeitsspeicher, um Modelle mit mehreren Milliarden Parametern effizient auszuführen. Zudem sind diese Modelle oft relativ langsam und damit nur schwer für den Echtzeit-Einsatz auf großen Plattformen geeignet. Eine weitere Herausforderung liegt in der sich schnell ändernden Landschaft der KI-Textgeneratoren.

Viele Open-Source-Detektoren basieren auf Trainingsdaten, die ältere Versionen von KI-Modellen widerspiegeln. Sobald neue Generationen von KI-Generatoren erscheinen, verändern sich die Stilmerkmale der Texte, was die Erkennungsgenauigkeit verringern kann. Dies macht regelmäßige Updates der Erkennungsmodelle erforderlich. Der ständige Wettlauf zwischen neuen KI-Textgenerationstechniken und deren Detektion erinnert an eine Art Katz-und-Maus-Spiel. Leider sind bestehende Detektionswerkzeuge nur bedingt verlässlich.

Es kann sowohl zu falsch-positiven Ergebnissen kommen, bei denen menschliche Texte fälschlicherweise als KI-generiert erkannt werden, als auch zu falsch-negativen, bei denen KI-Texte nicht erkannt werden. Gerade in Bildungskontexten, in denen KI-Detektoren eingesetzt werden, zeigte sich, dass deren Fehleranfälligkeit einen großen Einfluss auf die Bewertung von Texten haben kann. Dies lässt Zweifel an der bisherigen Effizienz der KI-Erkennung aufkommen und macht deutlich, dass reine technische Lösungen allein oftmals nicht ausreichen. Ein viel diskutierter Ansatz zur Verbesserung der Erkennung ist das sogenannte Watermarking oder digitale Wasserzeichen, das direkt bei der Textgenerierung durch die KI eingebaut wird. Hierbei wird der ausgegebene Text mit subtilen Mustern versehen, die von Detektionssystemen belastbar ausgelesen werden können.

Dies könnte theoretisch eine nahezu hundertprozentige Erkennungsquote ermöglichen, ohne den hohen Rechenaufwand aktueller Modelle. Allerdings weigern sich die großen KI-Anbieter bisher, obligatorische Wasserzeichen einzuführen. Dies hat Gründe, die unter anderem mit Wettbewerbsstrategien und technischen Herausforderungen zusammenhängen. Darüber hinaus stellt sich die Frage, inwieweit die Gesellschaft und soziale Plattformen bereit sind, KI-generierte Texte rigoros zu bekämpfen. Manche Experten argumentieren, dass eine komplett technische Abwehr wenig Erfolg versprechend ist und eher dazu führt, dass Nutzer versuchen, das System zu täuschen oder Umgehungsmöglichkeiten finden.

Stattdessen wird darauf verwiesen, dass eine Kombination aus Content-Moderation, Nutzersicherheit und Vertrauensmechanismen effizienter sein kann. Die Einführung von Reputationssystemen, bei denen Nutzer über ihre Historie und Verhalten bewertet werden, könnte helfen, die Einflussnahme von manipulativem KI-Content einzudämmen. Moderationsteams müssten dann noch besser darin geschult werden, KI-Inhalte zu identifizieren und kontextabhängig zu bewerten. Technische und ethische Fragen gehen dabei Hand in Hand. Die automatische Identifikation von KI-Texten wirft Datenschutzfragen auf, vor allem wenn Beiträge an externe Server übermittelt werden.

Zudem entsteht ein Spannungsfeld zwischen Transparenzpflichten, Nutzerrechten und dem Schutz vor manipulativen Inhalten. Die Balance zwischen zensierender Kontrolle und freier Meinungsäußerung muss auch im Zeitalter von KI sorgfältig gewahrt bleiben. Zusammenfassend ist die Erkennung von KI-generierten Texten auf Social-Media-Plattformen derzeit ein komplexes und dynamisches Thema. Während einige kommerzielle und Open-Source-Ansätze vielversprechende Ergebnisse liefern, sind diese Werkzeuge bislang nicht fehlerfrei und oft mit hohem technischen Aufwand verbunden. Die schnell voranschreitende Entwicklung von KI-Modellen stellt Detektoren vor große Herausforderungen.