Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren eine Vielzahl von Branchen fundamental verändert – darunter auch die Chemie. Diese KI-Systeme, die auf der Analyse gigantischer Textmengen basieren, demonstrieren nun beeindruckende Fähigkeiten, komplexe Fachfragen zu beantworten und chemisches Wissen zu nutzen. Die Frage stellt sich, wie sich die chemischen Kenntnisse und das logische Denkvermögen dieser Modelle im Vergleich zur Expertise erfahrener Chemiker schlagen und welche Auswirkungen das auf Forschung, Lehre und Anwendung haben kann. Große Sprachmodelle sind Maschinenlernmodelle, die anhand riesiger Textdaten darauf trainiert wurden, Zusammenhänge zu verstehen und sprachliche Aufgaben zu bewältigen, auch wenn sie für bestimmte Bereiche nicht explizit trainiert wurden. In der Chemie, einer Disziplin, die stark durch schriftlich dokumentierte Informationen geprägt ist, besitzen solche Modelle großes Potenzial, da die Mehrzahl chemischer Erkenntnisse, Daten und Hypothesen in Publikationen, Datenbanken und Lehrmaterialien vorliegt.

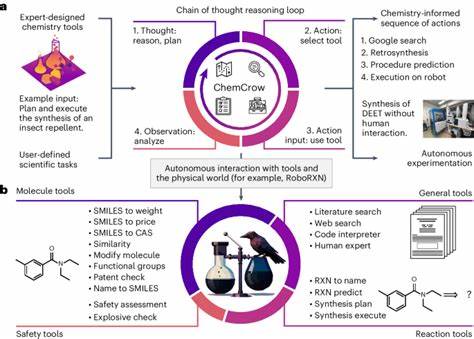

Dadurch können LLMs eine Art »chemischer Copilot« für Forscher und Studierende dargestellt werden, der durch die Verarbeitung umfassender Textmengen qualitativ hochwertige Informationen bereitstellt. Eine kürzlich veröffentlichte umfassende Studie – in der das Framework ChemBench eingeführt wurde – vergleicht die chemischen Kenntnisse und das logische Denkvermögen verschiedener großer Sprachmodelle mit denen menschlicher Chemiker. ChemBench vereint tausende von Fragen aus diversen Quellen, die ein breites Spektrum der chemischen Wissenschaft abdecken. Damit bietet das Framework eine weitreichende Grundlage, die Fähigkeiten von LLMs systematisch zu bewerten und mit menschlicher Expertise gegenüberzustellen. Erstaunlicherweise zeigten führende Modelle in der Studie eine durchschnittliche Leistung, die sogar über der der besten befragten Chemiker lag.

Dieser Befund verdeutlicht, dass die neuesten Entwicklungen in der KI es ermöglichen, chemisches Wissen nicht nur reproduktiv, sondern auch in gewissem Maße analytisch zu verarbeiten. Das bedeutet, dass Modelle wie GPT-4 oder spezialisierte open-source-Varianten durchaus in der Lage sind, selbst komplexere Aufgaben zu bewältigen, die normalerweise Expertenwissen erfordern. Allerdings zeigen sich trotz dieser beeindruckenden Leistungsfähigkeit auch klare Grenzen. Gerade bei Aufgaben, die tiefgehende Kenntnis von chemischen Strukturen und deren Interpretation erfordern, tun sich die Modelle noch schwer. Ein Beispiel ist die Analyse von NMR-Spektren, bei der die Bestimmung der Anzahl unterschiedlicher Signale oft eine Herausforderung bleibt – sowohl für das Modell als auch teilweise für Menschen.

Das Problem liegt dabei unter anderem darin, dass Maschinen zwar molekulare Repräsentationen wie SMILES-Codes verarbeiten können, jedoch nicht immer die komplexe räumliche und symmetrische Information einer Verbindung ausreichend genau erfassen und interpretieren können, wie es menschliche Chemiker tun. Darüber hinaus verfügen viele der Modelle über eine übermäßige Zuversicht in ihre Antworten, auch wenn diese inkorrekt sind. Dies birgt gerade in der Chemie erhebliche Risiken, etwa wenn Falschinformationen zu Sicherheitsaspekten oder toxikologischen Eigenschaften verbreitet werden. Es zeigt sich, dass LLMs häufig keine zuverlässigen Selbsteinschätzungen ihrer Unsicherheiten treffen. Eine vertrauenswürdige Einschätzung der eigenen Antwortqualität ist jedoch wesentlich, um KI-Systeme in sensible Bereiche wie Chemikaliensicherheit oder Arzneimitteldesign verantwortungsvoll einzubinden.

Die Experten, die in der Studie befragt wurden, waren zumeist hochqualifiziert und durften in Teilen auf externe Hilfsmittel wie Websuchen oder spezialisierte Datenbanken zugreifen. Dennoch wurden die Modelle mit diesen Werkzeugen in einigen Fällen in Performance übertroffen, was auf die hohe Datenbasis und die generalisierende Fähigkeit der LLMs zurückzuführen ist. Dennoch machten die Ergebnisse auch klar, dass eine rein oberflächliche Beantwortung von Fragen – etwa auf Basis von auswendig gelernten Fakten – längst nicht ausreicht, um in der Chemie erfolgreich zu sein. Insbesondere bei Fragen, die mehrere Denkschritte erfordern, zeigten die Modelle Schwächen. Ein weiterer interessanter Aspekt betrifft den Umgang mit Präferenzfragen, bei denen Chemiker subtile, oft intuitiv gewonnene Einschätzungen fällen – etwa bei der Auswahl von Molekülen für potenzielle Wirkstoffkandidaten.

Hier konnten die Modelle kaum eine Übereinstimmung mit den menschlichen Präferenzen erzielen. Diese Erkenntnis verweist auf den großen Gegenstand der menschlichen Intuition und Erfahrung, die bislang schwer in maschinelle Systeme übertragbar ist. Die ChemBench-Studie illustriert nicht nur die Leistungsfähigkeit, sondern auch die Notwendigkeit, die Methodik der Chemielehre und -prüfung zu überdenken. Traditionelle Lehr- und Prüfungsformen, die stark auf reines Faktenwissen oder Aufgaben basieren, die leicht automatisierbar sind, könnten unter dem Einfluss dieser neuen Technologien an Relevanz verlieren. Stattdessen wird kritisches Denken, komplexe Problemlösungen und interpretative Fähigkeiten immer wichtiger – Bereiche, in denen menschliche Chemiker weiterhin eine Schlüsselrolle einnehmen.

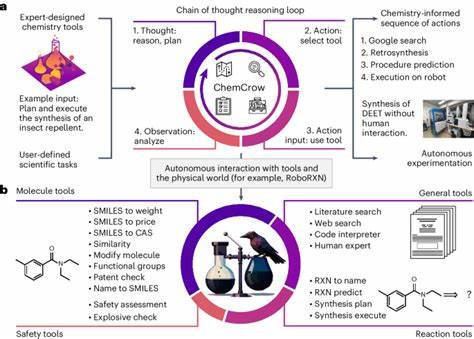

Die Analysen zeigen zudem, dass die Performance der Modelle stark von der Größe des jeweiligen Modells abhängt. Ein großer Modellumfang korreliert mit einer besseren Leistung. Gleichzeitig gehen größere Modelle mit mehr Rechenaufwand und Ressourcen einher, was Fragen zur Nachhaltigkeit und Zugänglichkeit aufwirft. Um das Potenzial voll auszuschöpfen, könnte die Integration von LLMs mit spezialisierten Datenbanken und Tools ein erfolgversprechender Weg sein. So könnten Modelle, die externe Quellen wie PubChem oder Sicherheitsdatenbanken anzapfen, wesentlich fundiertere und aktuellere Antworten liefern, besonders bei wissensintensiven Aufgaben.

Ein weiteres Problemfeld ist die sogenannte „Dual Use“-Thematik, bei der KI-Technologie zum Missbrauch genutzt werden kann – beispielsweise zur Gestaltung toxischer oder illegaler Substanzen. Der Umgang mit solchen Risiken erfordert eine verantwortungsbewusste Gestaltung und Regulierung von Sprachmodellen, um Schaden zu minimieren und zugleich den wissenschaftlichen Fortschritt zu fördern. In der praktischen Anwendung eröffnen große Sprachmodelle faszinierende Möglichkeiten. Chemiker könnten in Zukunft durch KI-Assistenten unterstützt werden, die Informationen schnell zusammenfassen, Literatur durchsuchen und auch bei der Planung von Experimenten helfen. Diese Copilot-Systeme könnten dabei helfen, das enorme Wachstum an chemischem Wissen handhabbar zu machen und schneller innovative Lösungen zu finden.

Gleichzeitig bedarf es eines kritischen Umgangs mit Modellen, die trotz Fortschritten noch nicht zuverlässig jede Fragestellung korrekt beantworten. Einzelne Fehlantworten, insbesondere bei sicherheitsrelevanten Themen, könnten schwerwiegende Konsequenzen haben. Deshalb ist es unabdingbar, menschliche Expertise nicht vollständig zu ersetzen, sondern in einem hybriden System mit KI zu verbinden. Abschließend zeigt die aktuelle Forschung klar, dass große Sprachmodelle im Bereich der Chemie ein wesentliches Werkzeug im 21. Jahrhundert sein werden.

Sie meistern ein breites Themenspektrum, können weit mehr als reine Informationsabrufsysteme sein und fordern uns heraus, Lern- und Arbeitsweisen anzupassen. Die Zukunft der Chemie liegt wohl in der Zusammenarbeit zwischen menschlicher Expertise und künstlicher Intelligenz, bei der beide ihre Stärken einbringen, um das Verständnis der chemischen Welt zu vertiefen, effizienter zu forschen und neue Entdeckungen zu ermöglichen. Die Weiterentwicklung von Bewertungsframeworks wie ChemBench wird dabei eine zentrale Rolle spielen, um Fortschritte messbar zu machen und kritische Schwachstellen aufzudecken. Nur so kann die sichere, hilfreiche und innovative Nutzung von LLMs in der Chemie gewährleistet werden.