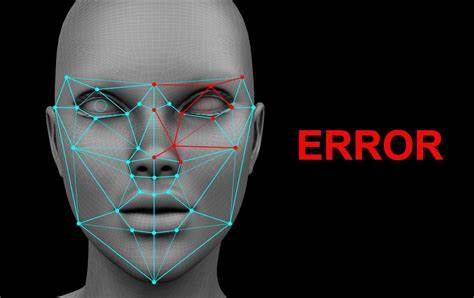

In einer zunehmend digitalisierten Welt gewinnt die Gesichtserkennungstechnologie im Einzelhandel immer mehr an Bedeutung. Händler setzen auf diese Systeme, um Ladendiebstahl zu verhindern und die Sicherheit zu erhöhen. Doch der Einsatz dieser Technologie bringt auch erhebliche Risiken mit sich, die im Fall von Danielle Horan aus Manchester eine erschreckende Dimension angenommen haben. Die junge Makeup-Unternehmerin wurde aufgrund eines Fehlers im Gesichtserkennungssystem fälschlicherweise des Diebstahls beschuldigt und aus zwei Filialen von Home Bargains verwiesen. Ihre Erfahrung wirft drängende Fragen zur Zuverlässigkeit und Ethik der Gesichtserkennung auf und sorgt für eine Debatte über Datenschutz, Menschenrechte und die Grenzen automatisierter Überwachungssysteme.

Im Mai und Juni 2025 ereignete sich dieser Vorfall in zwei verschiedenen Filialen eines Einzelhändlers in der Region Greater Manchester. Danielle Horan wurde ohne konkrete Erklärung aus den Läden begleitet, während andere Kunden sie beobachteten. Erst durch hartnäckige Nachfragen und Nachforschungen stellte sie fest, dass ihr Bild mit einem angeblichen Diebstahlsfall von Toilettenpapier im Wert von etwa zehn Pfund in Verbindung stand, zu dem sie nie einen Beitrag geleistet hatte. Die Situation steigerte sich für sie zu einem nervenaufreibenden Erlebnis voller Unsicherheit, Angst und Stress, da ihr lange eine Erklärung oder Entschuldigung verweigert wurde. Die Technologie hinter dem Vorfall stammt von der Firma Facewatch, die Gesichtserkennungssysteme zur Identifikation sogenannter Ladendiebe anbietet.

Ziel ist es, Personen, die zuvor bei Diebstahl aufgefallen sind, automatisch zu erkennen und das Verkaufspersonal zu alarmieren. Dabei werden Profilbilder in eine Datenbank eingepflegt, die an die Filialen weitergegeben wird. Im Fall von Danielle Horan jedoch war das System fehlerhaft, ihr Bild wurde fälschlicherweise mit einem Vorfall verknüpft, bei dem sie die Ware ordnungsgemäß bezahlt hatte. Die Konsequenzen für die Betroffenen sind gravierend. Eine falsche Zuordnung führt nicht nur zu sozialer Stigmatisierung, sondern hat auch rechtliche und psychologische Auswirkungen.

Danielle berichtete von massivem Stress und Angstzuständen, ausgelöst durch die unbegründete Beschuldigung und die öffentlichen Demütigungen vor anderen Kunden. Dieses Gefühl, „schuldig durch Algorithmus“ bestraft zu werden, steht im starken Gegensatz zum Rechtsprinzip der Unschuldsvermutung, das in westlichen Gesellschaften verankert ist. Die Empörung über solche Fälle wächst. Menschenrechtsorganisationen wie Big Brother Watch warnen vor der mangelnden Rechtssicherheit und Transparenz bei der Nutzung der Gesichtserkennung im Einzelhandel. Laut der Organisation melden sich immer mehr Betroffene, die unberechtigt auf sogenannten Watchlists landen und ohne fairen Prozess diskriminiert werden.

Die Angst vor Überwachung und Fehlern der Technik sorgt für ein Klima des Misstrauens und der Unsicherheit. Gesichtserkennung ist technisch komplex und kaum fehlerfrei. Faktoren wie Lichtverhältnisse, Bildwinkel, Gesichtsausdrücke und Ähnlichkeiten zu anderen Personen können zu Fehlalarmen führen. Besonders problematisch ist die Abhängigkeit von mangelhaften oder unvollständigen Datenbanken, die zu fälschlichen Identifizierungen führen. Eine solche Fehlfunktion im System hat gravierende Folgen, wenn Menschen irrtümlich kriminalisiert werden.

Aus rechtlicher Sicht gilt, dass beim Umgang mit biometrischen Daten höchste Anforderungen an Datenschutz und Verhältnismäßigkeit einzuhalten sind. Auch wenn der Einsatz im Einzelhandel in Großbritannien momentan legal ist, unterliegt er strengen Vorschriften. Die Datenschutzgesetze fordern Transparenz über Zweck und Umfang der Datenerhebung sowie klare Kontrollmechanismen. Doch der aktuelle Fall zeigt, dass in der Praxis diese Vorgaben unzureichend umgesetzt werden. Während der Einzelhändler Home Bargains keine öffentliche Stellungnahme zum Vorfall abgab, reagierte Facewatch mit einem Eingeständnis der Fehlerhaftigkeit und erklärte, die betroffenen Geschäfte wurden von der Nutzung des Systems suspendiert.

Zudem kündigte das Unternehmen Mitarbeiterschulungen an, um derartige Vorfälle künftig zu vermeiden. Dennoch bleibt die Frage, wie viele weitere Menschen von fehlerhaften Systemen betroffen sind und welche Verantwortung Unternehmen für Schadensersatz und moralische Wiedergutmachung tragen. Danielle Horans Fall ist kein Einzelfall. Weltweit häufen sich Berichte über Fehlalarme und Diskriminierungen durch Gesichtserkennungstechnologien. Kritiker bemängeln, dass vor allem Menschen mit dunklerem Hauttyp oder anderen Merkmalen häufiger falsch erkannt werden, was die Problematik von algorithmischer Voreingenommenheit (Bias) verdeutlicht.

Die Systeme lernen aus Daten, die historische Ungerechtigkeiten reproduzieren können, wodurch rassistische oder diskriminierende Effekte verstärkt werden. Diese Debatte trifft auf ein gesellschaftliches Spannungsfeld: Auf der einen Seite steht das Verlangen nach Sicherheit und Diebstahlsprävention, auf der anderen die Sorge um den Schutz der Privatsphäre und die Wahrung der Grundrechte. Fachleute fordern daher eine kritische Überprüfung des Einsatzes von Gesichtserkennung im öffentlichen Raum und eine stärkere Regulierung durch Gesetzgeber. In Großbritannien gibt es inzwischen Bestrebungen, den Einsatz dieser Technologie im Einzelhandel komplett zu verbieten. Dazu kommt die Problematik der fehlenden Transparenz gegenüber Betroffenen.

Wie der Fall von Danielle Horan zeigt, fällt es den Menschen schwer, sich gegen eine falsche Anschuldigung zu wehren. Mangelnde Auskunftspflichten und unklare Beschwerdewege verhindern eine schnelle und gerechte Klärung. Die psychischen Belastungen, die durch solche Vorwürfe entstehen, werden oft unterschätzt. Viele fühlen sich stigmatisiert und aus dem gesellschaftlichen Leben ausgeschlossen. Zudem wirft der Fall ethische Fragen auf.

Ist es vertretbar, Menschen allein auf Basis algorithmischer Entscheidungen zu bestrafen, ohne menschliche Kontrolle und ohne rechtsstaatliche Garantien? Wie kann sichergestellt werden, dass Technologie dem Menschen dient, statt ihm zu Schaden zu werden? Diese Fragen rücken angesichts zunehmender Automatisierung und künstlicher Intelligenz immer stärker in den Fokus. Abschließend muss betont werden, dass Technologien wie Gesichtserkennung trotz ihres Potenzials Gefahren bergen, wenn sie unkritisch eingesetzt werden. Erfahrungen wie die von Danielle Horan verdeutlichen die Notwendigkeit eines verantwortungsvollen Umgangs, umfassender Schulungen des Personals sowie transparenter und gerechter Prozesse für Betroffene. Nur durch eine klare Regulierung, technologische Verbesserungen und gesellschaftliches Bewusstsein kann das Vertrauen in solche Systeme wiederhergestellt werden. Der Schutz der Bürger vor Fehlidentifizierung und falschen Beschuldigungen muss oberste Priorität haben.

Nur so lässt sich verhindern, dass aus dem wohlgemeinten Vorsatz, Diebstähle zu verhindern, ein verletzendes und entwürdigendes Erlebnis für Unschuldige wird. Die Debatte um den Einsatz von Gesichtserkennungssystemen steht exemplarisch für die Herausforderungen, die die Digitalisierung für unsere Gesellschaft mit sich bringt – ein Balanceakt zwischen Sicherheit, Innovation und Menschenrechten.