Die Vorstellung einer Intelligenzexplosion ist seit Jahrzehnten ein faszinierendes Konzept unter Forschern und Technik-Enthusiasten. Gemeint ist ein Szenario, bei dem eine künstliche Intelligenz fähig wird, sich selbst immer schneller und effektiver zu verbessern – bis ein Punkt erreicht ist, an dem der Quantensprung im technologischen Fortschritt nicht nur unaufhaltsam, sondern auch für uns Menschen kaum noch vorhersehbar ist. Doch trotz der immensen Fortschritte, die wir in den letzten Jahren im Bereich der KI erlebt haben, gibt es zahlreiche Hinweise darauf, dass diese Intelligenzexplosion durch verschiedene Bremsen und Beschränkungen gehemmt wird. Um zu verstehen, warum das so ist, lohnt es sich, die wichtigsten Faktoren zu betrachten, die das explosive Wachstum der KI-Fähigkeiten bremsen könnten. Ein zentraler Aspekt liegt im Verhältnis zwischen den Erwartungen an technologischen Durchbruch und der realen Funktionsweise der KI-Entwicklung.

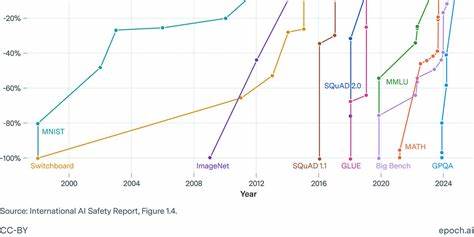

Viele der aktuellen Fortschritte beruhen auf der Kombination großer Datenmengen mit steigender Rechenleistung. Dennoch zeigt sich, dass diese Fortschritte eher gradueller Natur sind und sich nicht zu einem plötzlichen exponentiellen Sprung addieren. In der Praxis bedeutet das, dass KI-Modelle heute zwar in vielen Bereichen beeindruckende Leistungen erbringen, sie aber meist breit gefächertes Wissen mit relativer Sicherheit anwenden, statt radikal neue, revolutionäre Durchbrüche zu schaffen. Dabei spielt die Art der Lern- und Optimierungsprozesse eine entscheidende Rolle. KI-Modelle werden häufig mithilfe von Trainingsdaten und klar definierten Evaluationsaufgaben geschult, was zu einer gezielten Verbesserung in vorgegebenen Bereichen führt.

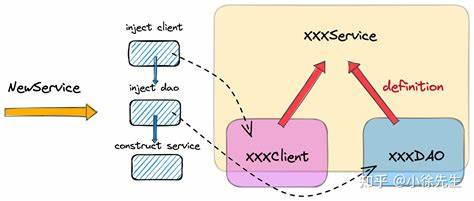

Dieser Prozess wird oft mit einem „Hillclimbing“ verglichen: KI-Systeme verbessern sich stetig bei bekannten Aufgaben, ähnlich wie ein Bergsteiger eine bekannte Route hinaufsteigt. Doch diese Methode stößt an natürliche Grenzen, wenn es darum geht, völlig neue Wege oder Paradigmen zu entdecken, die außerhalb des Gewohnten liegen. Daraus ergibt sich, dass eine Intelligenzexplosion, die auf der Idee der exponentiellen Selbstverbesserung basiert, durch solche strukturellen Beschränkungen ausgebremst wird. Zusätzlich ist es wichtig, auf die vielschichtige Natur der KI-Forschung hinzuweisen. Sie ist keine einfache lineare Optimierung, sondern ein komplexes Zusammenspiel aus Datensammlung, Modellarchitekturen, Trial-and-Error-Experimenten sowie der menschlichen Intuition und Kreativität in der Forschung.

Das bedeutet, dass die Geschwindigkeit des Fortschritts keine rein technische Frage ist, sondern auch von sozialen, wirtschaftlichen und organisatorischen Faktoren abhängt. So wirkt sich etwa die Verfügbarkeit von Rechenkapazitäten unmittelbar auf das Tempo der KI-Entwicklung aus, aber die effizienteste Nutzung von Ressourcen ist ein eng begrenzender Faktor. Hier entsteht ein Spannungsverhältnis zwischen der reinen Theorie eines unbegrenzten Wachstums und den „Bremsen“ der realen Welt. Ein weiterer entscheidender Punkt ist das Problem der sogenannten „Verallgemeinerung“. Während viele KI-Modelle immer besser darin werden, spezifische Aufgaben zu lösen, fehlt ihnen oft die Fähigkeit, Wissen auf neue, unbekannte Situationen zu übertragen, die über ihr Trainingsgebiet hinausgehen.

Diese begrenzte Generalisierungsfähigkeit hemmt das Potenzial für eine selbstbeschleunigende Intelligenzentwicklung, da sie die Fähigkeit einschränkt, eigenständig neue Forschungsfragen zu formulieren oder innovative Problemlösungen zu entdecken. Darüber hinaus gibt es bei der praktischen Anwendung von sogenannten Verstärkungslernverfahren (Reinforcement Learning) zusätzliche Herausforderungen. Diese Methoden gelten als vielversprechend, um KI-Systemen eine gewisse Anpassungsfähigkeit und Entscheidungsfähigkeit in komplexen, dynamischen Umgebungen zu verleihen. Doch der Sprung von der reinen Datenverarbeitung zu aktiven Handlungsvollzügen in unterschiedlichen dominierten Bereichen wie Robotik oder Forschung ist enorm und bislang mit großen Schwierigkeiten verbunden. Die Komplexität der realen Welt erzeugt dabei eine Reihe von Problemen – von unvorhersehbaren Umwelteinflüssen bis hin zu ständig wechselnden Bedingungen, in denen Modelle ihre Handlungskompetenz anpassen müssen.

Das macht den Weg zu einer universellen, sich selbst verbessernden KI, wie sie in Szenarien der Intelligenzexplosion postuliert wird, deutlich steiniger und langwieriger. Auch wirtschaftliche und organisationale Faktoren spielen eine wesentliche Rolle. KI-Forschung findet heute vor allem in Wettbewerbsumfeldern großer Technologieunternehmen statt, wo finanzielle und technische Ressourcen begrenzt und strategische Entscheidungen äußerst vorsichtig getroffen werden. Die Ressourcenallokation für Forschung und Entwicklung wird stets gegen kurzfristige Markterfolge abgewogen, was bedeutet, dass übermäßige Investitionen in risiko- und kapitalintensive KI-Forschung mit ungewissem Ausgang zurückhaltend erfolgen. In diesem Kontext entstehen natürliche Bremsen, die eine abrupt eintretende Intelligenzexplosion unwahrscheinlich machen.

Ein Blick auf die Geschichte der Wissenschaft zeigt ebenfalls, dass bahnbrechende Entdeckungen selten durch eine einzige Methode oder einen einzigen Durchbruch zustande kommen. Vielmehr handelt es sich um eine kumulative, meist langsame Entwicklung aus vielen kleineren Erkenntnissen. Es gibt zudem Theorien, die besagen, dass mit zunehmender Komplexität eines Systems die Leistung oder Kreativität pro zusätzlichem Aufwand nicht mehr proportional steigt, sondern letztlich sogar abnimmt – ein Phänomen, das als Komplexitätsbremse bekannt ist. Diese Idee findet sich auch in der Debatte um die KI-Entwicklung wieder: Je komplexer die Modelle und deren Trainingsverfahren werden, desto schwieriger wird es, signifikante Fortschritte zu erzielen. Dies steht im Gegensatz zur oft gehörten Hypothese eines unaufhaltsamen, exponentiellen Fortschritts.