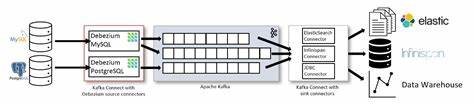

Die stetig zunehmende Bedeutung von Daten in Echtzeit macht Change Data Capture (CDC) zu einem unerlässlichen Bestandteil moderner Datenarchitekturen. Insbesondere bei der Übertragung großer Datenmengen von PostgreSQL-Datenbanken zu Kafka-Systemen sind Performanz, Ressourceneffizienz und Zuverlässigkeit entscheidende Faktoren. In diesem Kontext treten zwei führende Tools gegeneinander an: Conduit und Kafka Connect. Obwohl Kafka Connect seit Jahren eine feste Größe ist, zeigt die jüngste Untersuchung von Conduit eine beeindruckende Überlegenheit, die für viele Unternehmen neue Möglichkeiten eröffnet. Die Motivation hinter dem Vergleich liegt in der Suche nach einer effizienteren Lösung, durch die nicht nur höhere Datendurchsätze erzielt, sondern auch relevante Ressourcen wie Arbeitsspeicher und CPU-Auslastung reduziert werden.

Dies ist für Organisationen von großer Bedeutung, die ihre Infrastrukturkosten senken und gleichzeitig das Maximum aus ihren Datenströmen herausholen wollen. Conduit kündigt sich mit seiner bevorstehenden Version 1.0 als ernstzunehmender Konkurrent an, der gegenüber Kafka Connect insbesondere mit moderner Architektur und optimiertem Ressourcenmanagement punktet. Bei der Durchführung der Benchmark-Tests wurde sichergestellt, dass beide Systeme unter exakt gleichen Bedingungen agieren. Die Tests fanden auf einer AWS EC2 t2.

xlarge Instanz statt, ausgestattet mit 4 virtuellen CPUs und 16 GB Arbeitsspeicher. Sowohl PostgreSQL als auch Kafka liefen containerisiert in Docker-Umgebungen. Für die Datengrundlage wurden 20 Millionen Datensätze mit einem komplexen Schema eingefügt, welches diverse Feldtypen wie Ganzzahlen, Text, Boolean-Werte und Zeitstempel umfasste. Dieses Setup gewährleistet eine realistische und belastbare Grundlage für den Performancevergleich. Die Benchmarks konzentrierten sich auf zwei typische Arbeitslasten: den Snapshot-Modus und den CDC-Modus.

Während der Snapshot-Modus eine einmalige vollständige Datenübertragung beschreibt, wobei initial alle vorhandenen Datensätze kopiert werden, fokussiert sich der CDC-Modus auf das kontinuierliche Streaming der Änderungen, die nach dem Start des Prozesses in der Datenbank eintreten. Die Ergebnisse offenbaren klare Vorteile zugunsten von Conduit, insbesondere im CDC-Betrieb. Conduit erreichte eine knapp 7 Prozent höhere Nachrichtenrate mit etwa 48.000 Nachrichten pro Sekunde im Vergleich zu rund 44.900 Nachrichten pro Sekunde bei Kafka Connect.

Parallel dazu zeigte sich ein drastischer Unterschied im Speicherverbrauch. Während Kafka Connect bei knapp 6,8 GB lag, benötigte Conduit lediglich etwa 110 MB – ein Rückgang von über 98 Prozent. Ein ähnlich deutliches Bild zeichnet sich bei der CPU-Auslastung ab, wo Conduit etwa 25 Prozent weniger CPU-Ressourcen verbrauchte. Diese Zahlen sind bemerkenswert, da die Speicher- und CPU-Effizienz nicht nur die laufenden Betriebskosten signifikant beeinflussen, sondern auch die Skalierbarkeit und Flexibilität der eingesetzten Infrastruktur erhöhen. Projekte mit begrenzten Ressourcen können so auf leistungsfähige Datenreplikationsprozesse setzen, ohne teure Hardware anschaffen zu müssen.

Conduit ermöglicht sogar den Betrieb in deutlich schmaler dimensionierten Umgebungen, was viele zusätzliche Anwendungsmöglichkeiten eröffnet. Im Snapshot-Modus war die Differenz in der Durchsatzrate zwar geringer, allerdings führte Conduit mit einem leichten Vorsprung von rund drei Prozent. Hier zeigte sich, dass Conduit zwar mit höherer CPU-Auslastung, aber gleichzeitig mit einem um 18 Prozent geringeren Speicherverbrauch arbeitete. Diese Konstellation impliziert, dass Conduit gezielt mit mehr CPU-Power effizientere Datenverarbeitungsstrategien fährt, was gerade bei großen Datenaufkommen von Vorteil sein kann. Eine der Schlüsseltechnologien, die Conduit zugrunde liegt, ist der bewusste Verzicht auf die Java Virtual Machine (JVM).

Viele etablierte Werkzeuge basieren auf der JVM und bringen eine gewisse Ressourcenlast mit sich. Conduits Architektur hingegen nutzt eine moderne Pipeline-Engine, die eine schnelle und ressourcenschonende Datenverarbeitung erlaubt. Die Implementierung einer ReadN-Methode im Postgres-Connector, die das Lesen größerer Datensätze in einem Zug ermöglicht, war ein weiterer Hebel zur Performance-Steigerung und brachte bei CDC eine Steigerung von über sieben Prozent gegenüber herkömmlichen Verfahren. Ein weiterer Aspekt ist die Flexibilität bei der Konfiguration von Batch-Größen und Puffern im Snapshot-Modus. Bei Conduit wurde experimentell eine Batchgröße von 75.

000 Abstand empfohlen, die optimale Nutzung von Ressourcen gewährleistet und hohe Durchsätze unterstützt. Kafka Connect wiederum zeigte sich hier weniger abstrakt skalierbar. Das Benchmarking-Tool Benchi, das sowohl Conduits eingebaute Metriken als auch die JMX-Metriken von Kafka erfasst, ermöglichte eine zuverlässige, wiederholbare und präzise Sammlung und Analyse der Performance-Daten. Mit einem automatisierten Setup konnten sowohl Durchsatzraten als auch CPU- und Speicherauslastungen in Echtzeit überwacht und vergleichend dargestellt werden. Diese wissenschaftliche Methodik sichert die Aussagekraft der Ergebnisse und bietet praktische Anhaltspunkte für den Einsatz in Produktionsumgebungen.

Auch wenn Conduit bereits beeindruckende Resultate liefert, sieht das Entwicklerteam noch erhebliches Potenzial für zukünftige Verbesserungen. Experimente mit der Datenübertragung in größeren Chargen zwischen unterschiedlichen Prozesskomponenten brachten beispielsweise dramatische Performance-Zuwächse. So konnte die Übertragungsdauer einzelner Objekte mittels gepufferter Kanäle und großer Batches von mehreren Sekunden auf nur Millisekunden reduziert werden. Die weitere Optimierung solcher Mechanismen verspricht noch höhere Datenraten und bessere Ressourcenausnutzung. Die offene Architektur und der Verzicht auf schwergewichtige Laufzeitumgebungen ermöglichen es Conduit, seine Performance auch weiterhin zu optimieren, ohne die Ressourcenanforderungen signifikant zu erhöhen.

Für Unternehmen, die sowohl hohe Datenvolumen bewältigen als auch ihre Infrastrukturkosten minimieren möchten, bietet Conduit somit eine ansprechende Alternative zu etablierteren Lösungen wie Kafka Connect. Die praktische Reproduzierbarkeit der Tests ist durch ein öffentlich bereitgestelltes Skript gewährleistet. Interessenten können auf einfache Weise ihre eigene Benchmark-Umgebung aufsetzen, um die Ergebnisse zu validieren oder individuelle Anpassungen vorzunehmen. Das trägt zur Transparenz bei und fördert eine breitere Akzeptanz und Weiterentwicklung der Technologie. Neben den reinen Leistungskennzahlen ist auch die Anpassbarkeit ein relevantes Kriterium.

Conduit unterstützt eine flexible Schema-Verwaltung, die auf Wunsch deaktiviert werden kann, um Performance-Overhead zu vermeiden. Diese Funktionalität ist gerade für den produktiven Betrieb von Vorteil, in dem eine Balance zwischen Datenkonsistenz und Verarbeitungsgeschwindigkeit gefunden werden muss. Der Vergleich zwischen Conduit und Kafka Connect zeigt somit eindrücklich, wie moderne Softwareentwicklung und innovative Implementierungsansätze die Grenzen bisheriger Technologien verschieben. Conduit profitiert von einer schlanken, auf Effizienz bedachten Architektur, die großen Datenmengen mit geringem Ressourcenaufwand bewältigt. Abschließend lässt sich feststellen, dass Conduit im Bereich Postgres zu Kafka CDC nicht nur einen Leistungsvorsprung besitzt, sondern mit seiner ressourcenschonenden Arbeitsweise auch einen nachhaltigen Betrieb mit Kostenvorteilen ermöglicht.

![I go about finding interesting things to write about [Thread]](/images/D7A29EC1-4A5B-4D63-8BA5-6697A20974EC)