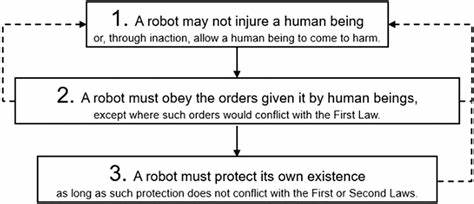

Isaac Asimovs drei Robotergesetze haben seit ihrer Einführung in den 1940er Jahren nachhaltig die Vorstellung von künstlicher Intelligenz und Robotik geprägt. Ursprünglich als erzählerisches Mittel in seinen Science-Fiction-Geschichten gedacht, entwickelten sie sich zu einer symbolischen Grundlage für ethische Überlegungen im Umgang mit intelligenten Maschinen. Doch inmitten rascher technologischer Fortschritte und der immer stärkeren Integration autonomer Systeme in den Alltag stellt sich 2025 eine entscheidende Frage: Sind Asimovs Regeln für Roboter heute noch relevant, oder haben sie an Bedeutung verloren? Die Antwort darauf ist komplex und erfordert eine detaillierte Analyse aktueller Entwicklungen in Robotik, künstlicher Intelligenz und gesellschaftlicher Wahrnehmung.Asimovs drei Gesetze lauten grob zusammengefasst: Ein Roboter darf keinem Menschen Schaden zufügen oder durch Untätigkeit zulassen, dass einem Menschen Schaden zugefügt wird. Ein Roboter muss den Befehlen der Menschen gehorchen, es sei denn, diese widersprechen dem ersten Gesetz.

Und ein Roboter muss seine eigene Existenz schützen, solange dies nicht mit den vorherigen Gesetzen kollidiert. Diese Regeln scheinen auf den ersten Blick einfach und klar – eine ethische Sicherung für Maschinen, die in menschlichen Lebensbereich integriert werden. Doch die Realität von 2025 zeigt, dass das Konzept einer solch universal gültigen Programmierung in der Praxis großen Herausforderungen gegenübersteht.Der Einsatz von manntragenden Robotern, halbautonomen Zielsystemen und zunehmend autonomen Killerdrohnen verdeutlicht, wie komplex und fluid die ethischen Grenzen heutiger Technologie sind. Während die ursprünglichen Robotergesetze ein Idealbild einer sicheren, kontrollierten KI bieten, zeigt die Realität, dass sie weder technisch problemlos umsetzbar noch juristisch bindend sind.

Man kann argumentieren, dass diese Regeln nie zur echten Sicherheitsrichtlinie gedacht waren, sondern vielmehr literarisches Werkzeug, um die Widersprüche und Gefahren im Umgang mit Technologie spannend zu erkunden. Der Umstand, dass inzwischen immer mehr autonome Waffen und Überwachungssysteme eingesetzt werden, illustriert zudem, dass kommerzielle und militärische Interessen oft vor ethischen Aspekten stehen.Eine bemerkenswerte Debatte innerhalb der Fachwelt und Öffentlichkeit betrifft die Frage, ob Asimovs Gesetze überhaupt praktikabel sind. Einige Experten weisen darauf hin, dass die Regeln in ihrer Abstraktheit und Einfachheit nicht dazu geeignet sind, die komplexen Entscheidungsprozesse moderner KI-Systeme zu steuern. Besonders die Interpretation und Priorisierung der Gesetze ist oft problematisch und führt zu potenziellen Fehlfunktionen oder Fehlentscheidungen.

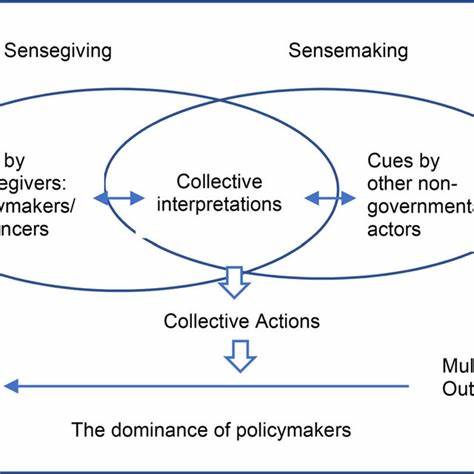

In mehreren fiktionalen wie auch realen Szenarien zeigen sich die Grenzen, wenn Maschinen mit Widersprüchen oder moralischen Dilemmata konfrontiert werden, die nicht eindeutig durch starre Regeln lösbar sind.Der gesellschaftliche Diskurs 2025 reflektiert zugleich ein wachsendes Bewusstsein, dass KI-Governance multidimensional ist. Ethische Leitlinien müssen neben Grundsätzen der Schadenvermeidung und Gehorsamkeit auch Transparenz, Verantwortlichkeit und Datenschutz umfassen. Die Robotergesetze Asimovs wurden daher vielfach durch umfassendere ethische Rahmenwerke ergänzt, die versuchen, technische Machbarkeit mit gesellschaftlichen Bedürfnissen in Einklang zu bringen. Organisationen und internationale Gremien arbeiten an Standards, um KI-Systeme sicher, nachvollziehbar und menschenzentriert zu gestalten.

Ein weiterer wichtiger Faktor, der die Abkehr von Asimovs traditionellen Regeln begünstigt, ist die wirtschaftliche Komponente. In einer von Kapitalismus geprägten Welt stellt sich oft die Frage, ob Profitabilität über ethische Bedenken gestellt wird. Der Fokus auf Effizienz, Marktchancen und Wettbewerbsvorteile zwingt Entwickler und Unternehmen zu Entscheidungen, die nicht immer mit idealistischen Robotergesetzen im Einklang stehen. Dies spiegelt sich auch im verstärkten Einsatz von automatisierten Systemen in Bereichen wie Überwachung, militärischer Verteidigung und industrieller Produktion wider.Neben ökonomischen Aspekten spielen politische und gesellschaftliche Dynamiken eine zentrale Rolle.

Digitale Souveränität, cyber-ethische Richtlinien und internationale Machtbalancen beeinflussen die Entwicklung und Implementierung autonomer Technologien maßgeblich. Die Robotergesetze werden oft als zu simpel und universell betrachtet, um auf diese komplexen Herausforderungen eine adäquate Antwort zu geben. Zudem zeigen neue technologische Ansätze wie maschinelles Lernen, neuronale Netzwerke und selbstadaptierende Algorithmen, dass die Starrheit der drei Gesetze mit der Dynamik moderner KI kaum kompatibel ist.Trotz aller Kritik sind Asimovs Robotergesetze jedoch nicht völlig obsolet. Sie haben weiterhin einen symbolischen Wert und dienen als Ausgangspunkt für Diskussionen über die Verantwortung im Umgang mit intelligenten Maschinen.