Die Chemie befindet sich im Umbruch. Große Sprachmodelle (Large Language Models, LLMs) wie GPT-4 und andere KI-Systeme entwickeln sich rasch zu wichtigen Helfern für Chemiker, indem sie komplexe Fragestellungen bearbeiten, Reaktionsvorhersagen liefern und sogar Expertenwissen simulieren. Doch wie gut sind diese Modelle wirklich im Vergleich zu menschlichen Chemikern? Sind sie nur raffinierte Informationswiedergabemaschinen oder können sie gar in der chemischen Forschung, Lehre und Sicherheit tiefgründig mitdenken und verfügen über echtes Verständnis? Die Forschung am Karlsruher Institut für Technologie, der Friedrich-Schiller-Universität Jena und weiteren Partnern hat eine neue Benchmark entwickelt, ChemBench genannt, die genau diese Frage systematisch untersucht. Mit über 2700 Fragen aus unterschiedlichsten chemischen Fachgebieten, die sowohl Wissen, Berechnung als auch komplexe Schlussfolgerungen abdecken, liefert ChemBench ein umfassendes Bild der Fähigkeiten aktueller LLMs im Bereich Chemie. Dabei wurden große, moderne Sprachmodelle mit den Leistungen erfahrener Chemiker verglichen, die teils Zugriff auf Hilfsmittel wie Websuche hatten.

Eine der erstaunlichsten Erkenntnisse des Studies ist, dass einige LLMs in der Summe besser abschneiden als menschliche Experten. Das Flaggschiffmodell, o1-preview, beantwortete nahezu doppelt so viele Fragen korrekt wie der beste Chemiker in der Studie. Auch zahlreiche andere Modelle übertrafen im Durchschnitt die Fähigkeiten der Chemiker. Dies unterstreicht, wie weit die KI-Technologie in den letzten Jahren vorangeschritten ist, wenn es darum geht, chemisches Fachwissen zu verarbeiten. Dennoch offenbart die Analyse auch Schwächen der Modelle.

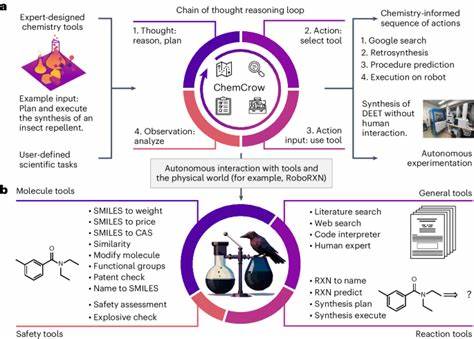

Besonders bei Fragen, die reine Faktenkenntnis erfordern, sind die KI-Systeme manchmal unterlegen. Während Experten auf spezialisierte Datenbanken zurückgreifen können, haben viele LLMs nur Zugriff auf wissenschaftliche Publikationen, so dass wichtige Details verloren gehen. Im Bereich der chemischen Sicherheit oder Toxizität zeigen die Modelle zudem Unsicherheiten und liefern teilweise übermäßiges Selbstvertrauen, was problematisch sein kann, wenn Laien diese Antworten ungefiltert nutzen. Die Fähigkeit zur Chemie ist nicht nur von der Größe des Modells abhängig, sondern auch von der Art und Weise, wie chemische Informationen in den Trainingsdaten repräsentiert sind. Modelle wie Galactica nutzen beispielsweise besondere Markierungen für Molekülstrukturen oder chemische Gleichungen, um diese speziell behandeln zu können.

Dennoch konnten die LLMs in der Bewertung nicht immer die richtige Anzahl typischer NMR-Signale vorhersagen oder die korrekte Symmetrie bemerkter Verbindungen erkennen, was auf begrenzte Fähigkeit zur Strukturrechnung hindeutet. Neben Wissensfragen überprüfte ChemBench auch, ob LLMs über chemische Intuition und Präferenzen verfügen. Gerade in der Medikamentenentwicklung ist diese Fähigkeit zentral, um aus zahlreichen Molekülen diejenigen auszuwählen, die weiterverfolgt werden sollen. Hier enttäuschten die KI-Modelle: Sie konnten die menschlichen Vorlieben selbst in einfachen Vergleichsfragen kaum reproduzieren. Somit ist klar, dass menschliche Erfahrung und Intuition momentan noch nicht einfach durch KI ersetzt werden können.

Ein weiteres wichtiges Merkmal ist die Einschätzung der eigenen Sicherheit. Im Idealfall sollten KI-Systeme wissen, wann sie eine Frage nicht korrekt beantworten können, und dies offen kommunizieren. Die Forscher baten die Modelle, ihre Antwortsicherheit auf einer Skala von 1 bis 5 zu bewerten. Das Ergebnis: Viele Modelle sind schlecht kalibriert und zeigen tendenziell eine zu hohe oder unpassende Sicherheit bei falschen Antworten. Dieses Fehlen selbstkritischer Reflexion kann in sicherheitskritischen Bereichen wie Toxizitätsfragen oder Chemikaliensicherheit problematisch sein.

Das ChemBench-Projekt umfasst nicht nur eine große Sammlung von Fragen, sondern bietet mit ChemBench-Mini auch eine kompakte Version mit etwa 236 ausgewählten Fragen für praktische Routinebewertungen. Besonders hervorzuheben ist, dass das Testset offen zugänglich ist, Entwickler von KI-Modellen es leicht integrieren und neue Modelle vergleichen können. Es ist damit ein entscheidendes Werkzeug für die Weiterentwicklung chemischer KI-Systeme, indem es Ergebnisse transparent macht und den Wettlauf um verbesserte Modelle fördert. Die Erkenntnisse haben auch Auswirkungen auf die Chemieausbildung. Da LLMs viele Routinefragen und sogar komplexe Aufgaben oft schneller und präziser lösen als Studierende, könnte dies zu einem Paradigmenwechsel in der Lehre führen.

Statt reine Fakten zu pauken, müsste der Fokus stärker auf kritisches Denken und die Fähigkeit zur Überprüfung von Ergebnissen gelegt werden. Die Kombination aus menschlicher Kreativität und KI-Unterstützung eröffnet ganz neue Möglichkeiten. Schließlich besteht eine Herausforderung im verantwortungsvollen Umgang mit der Technologie. Der einfache Zugang zu leistungsfähigen LLMs birgt Risiken - schlecht informierte Nutzer könnten falsche oder unsichere Empfehlungen für den Umgang mit gefährlichen Substanzen erhalten. Deshalb ist es wichtig, klare Regeln, Sicherheitsmechanismen und Aufklärung einzuführen, um Fehlinterpretationen zu vermeiden.