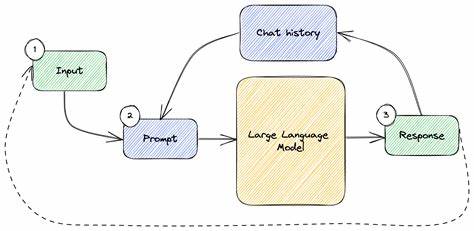

Die rasante Entwicklung von Künstlicher Intelligenz (KI) hat in den vergangenen Jahren neue Möglichkeiten für die Interaktion mit Maschinen eröffnet. Besonders im Bereich des Prompt Engineerings, also der gezielten Steuerung von KI-Modellen mittels Eingabetexten, entstehen immer innovativere Methoden, um bessere und präzisere Ergebnisse zu erzielen. Eine dieser Methoden, die das Potential hat, die Art und Weise, wie wir mit KI-Textmodellen arbeiten, grundlegend zu verändern, ist das sogenannte Prompt Chaining in Verbindung mit bidirektionaler Typinferenz. Dieses Konzept ist nicht nur innovativ, sondern bietet auch Lösungsansätze für zahlreiche Herausforderungen im Umgang mit komplexen promptbasierten Workflows. Prompt Chaining beschreibt die technique, bei der eine große, komplexe Aufgabe in einzelne kleinere Aufgaben zerlegt wird.

Diese werden sequenziell abgearbeitet, wobei das Ergebnis eines Prompts als Eingabe für den nächsten dient. Das Ergebnis ist eine Verkettung von Aufgaben, die eine höhere Genauigkeit und Kontrolle durch Spezialisierung auf Teilprobleme erlaubt. Das Schlüsselziel dabei besteht darin, ein umfangreiches Problem in überschaubare Schritte zu teilen, um das KI-Modell jeweils auf einen eng umrissenen Kontext zu fokussieren, was dessen Leistungsfähigkeit maßgeblich verbessert. Ein traditioneller Ansatz bei Prompt Chaining verlangt oft, dass man die Struktur der erwarteten Zwischenergebnisse exakt definiert. Das bedeutet in der Praxis, dass man für jeden Schritt die Datenformate, meist in JSON, sorgfältig entwerfen und pflegen muss.

Darüber hinaus muss man prüfen, ob der KI-Ausgang den erwarteten Vorgaben entspricht. Diese Arbeit ist nicht nur fehleranfällig, sondern führt bei wachsender Komplexität zu erheblichem Mehraufwand und behindert die Skalierbarkeit solcher Systeme. Genau hier setzt die Innovation der bidirektionalen Typinferenz an. Inspiriert von Konzepten aus der Programmiersprachenforschung, erlaubt diese Technik dem System, automatisch Typen und Strukturen von Daten abzuleiten, indem es aus dem Kontext heraus arbeitet. Im Gegensatz zu starren Deklarationen wird somit der gesamte Typinferenzprozess dynamisch gestaltet.

Dies bedeutet, dass für den Entwickler oder Prompt Engineer keine expliziten, redundanten Typdefinitionen notwendig sind. Vielmehr kann das System anhand der Verwendung der Daten bestimmen, wie die erwartete Struktur und Typen des Outputs aussehen müssen. Das Konzept der bidirektionalen Typinferenz macht sich dabei die Idee zunutze, dass Informationen sowohl vorwärts, als auch rückwärts durch den Programmcode oder Prompt-Chain fließen können. Wird ein Wert an einer bestimmten Stelle genutzt und dort ein Typ erwartet, so kann die Typinformation rückwirkend auf den Ursprung angewandt werden, um das Schema zu bestimmen. Die Anwendung dieser Methode in der Praxis ist der Forschungsprogrammiersprache Fall-from-Grace, auch als Grace bezeichnet, zu verdanken.

Grace ist eine auf JSON aufbauende Sprache, welche speziell darauf ausgelegt ist, Prompt Chaining durch durchdachte Typinferenz zu vereinfachen und gleichzeitig leistungsfähiger zu machen. Mit ihr können Entwickler komplexe Workflows beschreiben, ohne sämtliche Zwischentypen mühsam formulieren zu müssen. Dadurch reduziert sich der Boilerplate-Code drastisch, was die Entwicklung effizienter und weniger fehleranfällig macht. Ein Beispiel verdeutlicht die praktische Anwendung von Grace. Stellen Sie sich vor, Sie möchten ein Gedicht generieren.

Anstatt einen einzigen umfassenden Prompt zu verfassen, der die gesamte Aufgabe in einem Block abwickelt, teilt Grace den Vorgang auf in: - Strukturplanung des Gedichts (Form, Strophenzahl, Reimschema) - Auswahl eines poetischen Stils (Tonfall, Erzählweise, Stilmittel) - Endgültiges Verfassen des Gedichts auf Basis der vorherigen Ergebnisse. Jeder Schritt ist ein separater prompt, dessen Ausgaben automatisch typisiert sind. Die Daten, die von einem Schritt zurückkommen, werden vom System analysiert und daraus ein Typ abgeleitet, der die sichtbaren Eigenschaften beschreibt. So kann der nächste Prompt diese Informationen unmittelbar nutzen, ohne dass eine manuelle Datenmodellierung oder Validierung erforderlich wäre. Durch Typinferenz bietet Grace gleichzeitig eine automatische JSON-Schema-Generierung, die sicherstellt, dass alles korrekt strukturiert und valide an die KI übergeben wird.

Dies schafft Vertrauen in die Zwischenausgaben und ermöglicht auch Monitoring oder Korrekturen vor weiteren Verarbeitungsschritten. Die Folge ist eine sichere, nachvollziehbare und gut kontrollierte Prompt-Chain. Ein wesentlicher Vorteil dieses Ansatzes liegt zudem in der verbesserten Übersichtlichkeit und Wartbarkeit komplexer Prompt Chains. Ohne explizite und oft umfangreiche Schema-Definitionen in Form von JSON oder Pydantic-Modellen entfällt ein großer Aufwand an manueller Modellpflege. Entwickler können sich somit auf die inhaltliche Gestaltung und Verfeinerung der Prompt-Schritte konzentrieren, während Grace die Typkonsistenz und Datenstruktur automatisch gewährleistet.

Ein weiteres interessantes Feature von Grace ist die Unterstützung sogenannter Summentypen oder Tagged Unions. Diese erlauben die Definition von mehreren möglichen Varianten innerhalb eines Datenfeldes – beispielsweise um unterschiedliche Werkzeuge oder Befehle innerhalb einer Action-Pipeline zu modellieren. Dadurch kann Grace traditionelle Werkzeugintegrationen auf elegante Weise abbilden, meist ohne dass der Nutzer komplexe Typinformationen kodieren muss. Vor allem bei der Integration von Tools in einen Prompt-Workflow bietet dies sehr viel Potenzial. Statt jede mögliche Anfrage oder Befehl ausführlich zu beschreiben und zu spezifizieren, nutzt Grace die Möglichkeit, dass der Prompt selbst ein Tagged Union von möglichen Werkzeugaufrufen erwartet.

Die Logik zur Ausführung dieser Tools kann dann auf Basis der inferierten Typen gesteuert werden. Somit entstehen flexible, erweiterbare Systeme, deren Struktur sich organisch aus der Logik und der Nutzung durch den Nutzer ergibt. Die Vereinfachung durch Typinferenz schafft auch die Basis für eine sogenannte schema-getriebene Prompt-Generierung. Anstatt alle Informationen in umfangreichen natürlichen Sprachbeschreibungen mitzugeben, kann Grace aus dem Typenschema und den strukturierten Daten selbst einen präzisen Prompt zusammensetzen, der das KI-Modell äußerst klar anweist, was gefragt ist. Das reduziert Inkonsistenzen und verbessert die Resultate weiter.

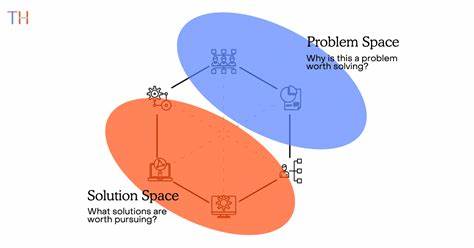

Grace unterstützt den Umgang mit komplexen Feldnamen, die beliebige Sonderzeichen, Leerzeichen oder auch unterschiedliche Groß- und Kleinschreibweisen enthalten können. Das ermöglicht es, beschreibende Metadaten direkt in die Feldbezeichnungen einzugliedern. Diese Informationen werden von der KI beim Generieren der Antwort berücksichtigt, ohne die Lesbarkeit und Bearbeitung der Daten zu erschweren. So lassen sich Kontext und Semantik elegant mitliefern. Die Idee, Prompt-Chaining als ein Problem zu begreifen, das eher in der Domäne von Programmiersprachen angesiedelt ist, ist ein vielversprechender neuer Blickwinkel.

Sie überwindet die klassische Vorstellung, dass es sich bei Prompting nur um Textmanipulation handelt, und positioniert es stattdessen als eine Art Domänenspezifische Programmiersprache (DSL) mit eigenen Regeln und Vorteilen. Durch die Verbindung von bidirektionaler Typinferenz mit einer als Programmiersprache gestalteten Umgebung wird Prompt Engineering nicht nur einfacher, sondern vor allem mächtiger. Komplexe Workflows lassen sich deklarativ und sicher definieren, der Entwickler gewinnt Kontrolle auf hohem Niveau und das System sorgt für automatische Konsistenzprüfung. Die Forschungsarbeiten zu Grace zeigen eindrucksvoll, dass die Zukunft des Prompt Engineerings nicht in immer mächtigeren Sprachmodellen an sich besteht, sondern in der intelligenten und kontrollierten Automatisierung der Art und Weise, wie wir mit ihnen kommunizieren und sie orchestrieren. Gerade die Skalierbarkeit und ein reduzierter manueller Aufwand könnten Grace oder ähnliche Systeme zu wichtigen Bausteinen für professionelle KI-Produkte machen.

Auch wenn Grace aktuell ein Forschungsprototyp ist und für produktive Umgebungen noch nicht vollständig ausgereift ist, stellt dieses Konzept eine wichtige Weichenstellung dar. Die Vernetzung von Typensystemen, automatisierter Schema-Generierung und KI-Prompting könnte die Grundlage für nächste Generationen von Tools bilden, die deutlich intuitiver, flexibler und zuverlässiger Nutzeranforderungen umsetzen. Zusammenfassend lässt sich sagen, dass Prompt Chaining mit bidirektionaler Typinferenz einen neuen Standard für die Entwicklung intelligenter KI-Workflows setzen kann. Die Verknüpfung klassischer Programmierkonzepte mit moderner KI-Technologie schafft eine Symbiose, die das Management komplexer Aufgaben erheblich vereinfacht. Entwickler profitieren von reduzierter Komplexität, bessere Kontrollmöglichkeiten und eine höhere Ergebnisqualität werden ermöglicht.

Für Unternehmen, die KI-Lösungen implementieren oder innovative Produkte entwickeln möchten, eröffnet sich damit eine spannende Perspektive. Die Nutzung solcher Technologien verspricht nicht nur Effizienzgewinne, sondern auch eine verbesserte Nutzererfahrung und eine nachhaltige Skalierung komplexer Projekte. Die Zukunft des Prompt Engineerings liegt demnach nicht allein in der Weiterentwicklung großer Modelle, sondern vor allem in der Weiterentwicklung der Werkzeuge und Frameworks, die diese Modelle intelligent und kontrolliert einsetzen. Die Verbindung von Programmiersprachenansätzen und KI-Prompting, wie sie am Beispiel von Grace erkennbar ist, zeigt einen aussichtsreichen Weg, der die Industrie nachhaltig verändern könnte.