Die Entwicklung von Embedded Audio Digital Signal Processing (DSP) Software ist in der heutigen Technologiebranche eine hochkomplexe und zeitintensive Herausforderung. Insbesondere dann, wenn hochwertige Audiofunktionen auf verschiedenen Hardwareplattformen oder in unterschiedlichen Formfaktoren implementiert und wiederverwendet werden sollen, stoßen Entwickler häufig an ihre Grenzen. Diese Schwierigkeiten sind nicht nur technische Hürden, sondern wirken sich direkt auf Effizienz, Kosten und Markteinführungszeiten aus. Die Gründe für diese Komplexität liegen tief in den Anforderungen und Besonderheiten der Audio-DSP-Entwicklung. Ein zentraler Schmerzpunkt ist die Dauer und Komplexität der Iterationszyklen.

Das feine Abstimmen von Audio-Parametern wie Filterkoeffizienten oder Equalizer-Einstellungen erfordert oft zahlreiche Feinschliffe. Jede Veränderung bedeutet in der Regel, den Quellcode anzupassen, die Firmware neu zu kompilieren und das Zielgerät erneut zu flashen. Diese Abfolge benötigt viel Zeit und behindert schnelle Experimentierzyklen. Die Folge ist, dass Audioingenieure Schwierigkeiten haben, verschiedene Klangabstimmungen in Echtzeit zu vergleichen oder sofortiges Feedback über Hörtests zu erhalten. Die langfristige Erinnerung an vorherige Klangversionen verblasst schnell, wodurch es erschwert wird, objektive Verbesserungen vorzunehmen.

Die menschliche Hörwahrnehmung ist extrem sensitiv, so dass selbst minimale Anpassungen große Unterschiede machen können. Ohne die Möglichkeit, Parameter live zu verändern, gleicht die Abstimmung vieler DSP-Algorithmen einer langwierigen und aufwändigen Trial-and-Error-Methode. Eine weitere Herausforderung stellt die Wiederverwendbarkeit von Audio-DSP-Software über verschiedene Hardwareplattformen hinweg dar. Traditionell sind viele DSP-Algorithmen direkt für eine bestimmte Prozessorarchitektur optimiert. Diese Optimierungen beinhalten oft handgeschriebene Assembly-Befehle oder plattformspezifische Anpassungen, die sich nicht problemlos auf andere Plattformen übertragen lassen.

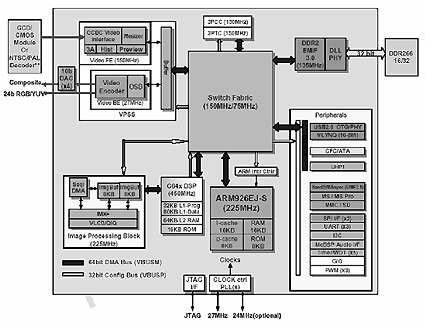

Wenn ein Produkt auf einer anderen DSP-Architektur oder einem aktualisierten System-on-Chip (SoC) umgesetzt wird, ist häufig eine komplette Neuentwicklung oder zumindest eine umfangreiche Optimierung notwendig. Die überwiegende Mehrheit der existierenden Audio-DSP Bibliotheken ist monolithisch aufgebaut und vereint viele Signalverarbeitungsfunktionen in einem Block. Diese mangelnde Modularität erschwert die gezielte Anpassung an spezifische Kundenbedürfnisse oder Produktanforderungen, da selbst kleine Anpassungen eine erneute umfangreiche Test- und Entwicklungsphase nach sich ziehen. Die Folge ist eine Vielzahl von getrennten Codebasen für unterschiedliche Plattformen, was den Wartungsaufwand erheblich erhöht und die Fehleranfälligkeit steigert. Eines der gravierendsten Defizite in der Embedded-Audio-Entwicklung ist das Fehlen von Echtzeitsteuerbarkeit und interner Sichtbarkeit während der Entwicklung.

Anders als bei Desktop-Software, bei der Entwickler Parameter zur Laufzeit anpassen und sofort Resultate inspizieren können, laufen Embedded DSP-Systeme oft ohne eine nutzerfreundliche Benutzeroberfläche. Die Einsicht in interne Prozesse beschränkt sich oft auf Hardware-Debugger oder zusätzliche Instrumentierung, die jedoch wiederum die performante Echtzeitverarbeitung beeinträchtigen kann. Selbst das Hinzufügen von einfachen Debug-Ausgaben wie printf-Anzeigen kann Timing-Probleme verursachen, was bei sensiblen Audioanwendungen inakzeptabel ist. Dies sorgt dafür, dass DSP-Entwickler häufig im Dunkeln arbeiten und nur verzögert Rückmeldung über den Status und die Leistung der Algorithmen erhalten. Die fehlende Live-Steuerung erschwert zudem das Feinabstimmen der Klangparameter erheblich.

Da keine dynamische grafische Oberfläche zur Verfügung steht, müssen Entwickler die klassischen, zeitaufwändigen Compile-Flash-Listen-Zyklen durchlaufen, welche die Innovationsgeschwindigkeit erheblich drosseln. Die realen Auswirkungen dieser aufwendigen Entwicklungsprozesse zeigen sich in der oft langwierigen Produktentwicklung. Es ist keine Seltenheit, dass Projekte im Bereich Embedded Audio DSP über Monate bis Jahre laufen und die Audioalgorithmen über mehrere Produktgenerationen weiter optimiert werden müssen. Ein eindrucksvolles Beispiel sind die Apple AirPods, deren Audioqualität sich erst nach mehreren Iterationen und langfristiger Forschung zu einem erstklassigen Klangerlebnis entwickelte. Hier spiegelt sich der enorme Entwicklungsaufwand wider, der nötig ist, um selbst in einem High-End-Consumerprodukt die hohen Erwartungen an Klangtreue und Performance zu erfüllen.

Solche Beispiele verdeutlichen, dass ohne moderne Entwicklungswerkzeuge und methodische Verbesserungen erhebliche Ressourcen gebunden werden, was sich direkt auf Zeit- und Kostenpläne auswirkt. Vor diesem Hintergrund gewinnt der Einsatz von besseren Tools, höheren Abstraktionsschichten und modularen Designs an Bedeutung. Neue Entwicklungsplattformen, die interaktive grafische Werkzeuge, Echtzeit-Parametersteuerung und eine modulare Komponentenstruktur bieten, erhöhen die Flexibilität und reduzieren die Entwicklungszeiten drastisch. So erlauben sie es Teams, mit vorgefertigten, optimierten Modulen Audio-Pipelines per Drag-and-Drop zusammenzustellen und Parameter in Echtzeit zu justieren, ohne jedes Mal umständlich neuen Code generieren und kompilieren zu müssen. Dies beschleunigt nicht nur die Klangentwicklung, sondern ermöglicht parallelisierte Arbeitsprozesse zwischen Audioingenieuren und Firmwareentwicklern.

Eine plattformübergreifende Hardwareabstraktion trägt darüber hinaus dazu bei, dass die gleiche Audioverarbeitungslogik nur einmal implementiert und dann auf unterschiedlichsten DSP-Architekturen eingesetzt werden kann. Solche Lösungen sparen nicht nur Entwicklungszeit, sondern verringern auch die Komplexität bei der Pflege und Weiterentwicklung diverser Produktlinien. Open-Source-Projekte wie Sound Open Firmware illustrieren, wie Modularität und Portabilität die Audio DSP Entwicklung vereinfachen können. Indem sie standardisierte APIs und konfigurierbare Datenmodelle nutzen, ermöglichen sie es Entwicklern, Algorithmen auf verschiedenen Prozessoren ohne umfangreiche Anpassungen zu betreiben. Branchenführende Firmen berichten, dass moderne Audio DSP Entwicklungsplattformen die Entwicklungszeit um ein Vielfaches – teils bis zu zehn Mal – im Vergleich zu herkömmlichen Methoden verkürzen können.

Der Effekt ist eine drastisch geringere Time-to-Market bei gleichzeitig hochwertigerer Audioqualität. Eine konkret entwickelte Lösung eines Unternehmens ist beispielsweise eine Engine, die nach dem Booten ein einzelnes Audio-Graphen lädt und durchgängig speichert, was dazu führt, dass Parameteränderungen sofort hörbar sind, ohne Wartezeit durch erneutes Kompilieren oder Neustarten. Diese Engine abstrahiert hardwarebedingte Eigenheiten wie Wortlängen und Cache-Management und erlaubt so die nahtlose Ausführung desselben Audio-Projekts auf verschiedenen Prozessorarchitekturen wie ARM, Xtensa oder RISC-V. Messungen zur Leistungsfähigkeit erfolgen ohne störende Debug-Ausgaben, indem jeder Verarbeitungsknoten seinen eigenen Zyklus- und Pufferstatus überwacht. Das hält den Speicherverbrauch konstant und verhindert Audioaussetzer – entscheidend für die Stabilität in Echtzeit-Anwendungen.

Frühzeitiger Zugriff auf solche fortschrittlichen Plattformen bietet Entwicklern die Möglichkeit, Entwicklungszyklen neu zu denken und das bisher übliche „Stone Age“-Vorgehen hinter sich zu lassen. Indem Parameter sofort angepasst und deren Auswirkungen live gehört werden können, wird kreative Klangentwicklung möglich, die komplexe Firmware-Optimierung mit minimalem Aufwand verbindet. Konventionelle Probleme wie Plattform-spezifische Fehler, Zeitverlust beim Testen oder Unsicherheiten beim Tuning lassen sich so deutlich reduzieren. Zusammenfassend lässt sich sagen, dass Embedded Audio DSP Softwareentwicklung über Plattformen hinweg aufgrund von langen Iterationszyklen, mangelnder Wiederverwertbarkeit und eingeschränkter Echtzeiteinstellungen immer noch hohe Anforderungen stellt. Die Entwicklung von hochwertigen Audioerlebnissen wird dadurch zum langwierigen Prozess, der viel Engineering-Know-how, Zeit und Budget bindet.

Fortschrittliche Instrumente, modulare Architekturen und Echtzeitsteuerungsfunktionen können diese Herausforderungen signifikant entschärfen und neue Wege für eine schnellere, effizientere und qualitativ hochwertigere Entwicklung eröffnen. Die Zukunft der Embedded Audio DSP Entwicklung liegt in der Kombination aus intelligenter Softwareabstraktion und leistungsfähigen Toolchains, die es Teams ermöglichen, das volle Potenzial moderner Hardware auszuschöpfen und innovative Audioprodukte schneller auf den Markt zu bringen.