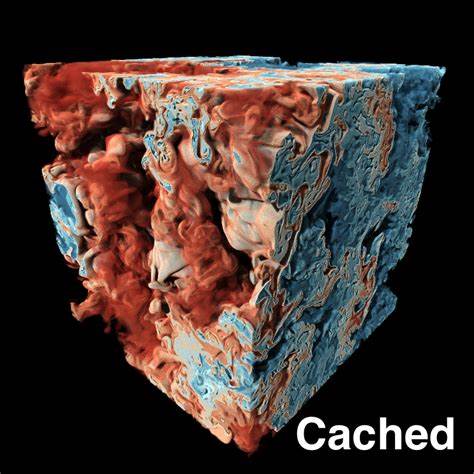

Die stetige Zunahme an produzierten wissenschaftlichen und technischen Daten stellt Forscher sowie Datenwissenschaftler vor eine enorme Herausforderung: Wie können Terabytes bis Petabytes an Informationen effizient visualisiert und interaktiv genutzt werden, ohne dabei enorme Rechenressourcen oder teure Hardware in Anspruch zu nehmen? In Zeiten, in denen Big Data immer präsenter wird, spielt die Visualisierung eine entscheidende Rolle, um Erkenntnisse aus komplexen Datensätzen zu gewinnen und fundierte Entscheidungen zu treffen. Ein bahnbrechender Ansatz zur Bewältigung dieser Hürde ist der Einsatz eines Cache-beschleunigten Frameworks für die interaktive Visualisierung von tera-scale Datenmengen mittels impliziter neuronaler Repräsentationen (Implicit Neural Representations, INR). Das Konzept der INR basiert darauf, dass große Datensätze mithilfe neuronaler Netzwerke kompakt kodiert werden können. Diese Netzwerke approximieren dabei ihre zugrundeliegenden Datenfunktionen und erlauben so eine effiziente Kompression und Rekonstruktion der ursprünglich enormen Dateimengen. Dadurch eröffnen sich neue Möglichkeiten für eine interaktive und qualitativ hochwertige Visualisierung, die zuvor nur auf professionellen High-End-Arbeitsstationen realisierbar war.

Bisher war die visuelle Verarbeitung von INR-basierten Daten eine Herausforderung, da das Berechnen von Datenpunkten aus einem neuronalen Netzwerk zeitaufwändig ist und nicht dieselbe Geschwindigkeit wie das direkte Lesen von Daten aus dem GPU-Speicher erreicht. Dieses Problem schränkt die Benutzerfreundlichkeit und die Interaktivität der Visualisierung ein, da jede neue Bildgeneration viele rechenintensive Abfragen an das Netzwerk erfordert. Um diese Barriere zu überwinden, führte ein Forscherteam unter der Leitung von Daniel Zavorotny eine Cache-beschleunigte Rendering-Architektur ein, die speziell für miliardengroße Datensätze entworfen wurde. Durch den intelligenten Einsatz eines mehrstufigen, skalierbaren Caches im GPU-Speicher kann die Methode redundante Netzwerkanfragen reduzieren und gleichzeitig den Fokus auf neu erkundete Volumenbereiche legen. Der Cache ermöglicht somit eine effiziente Zwischenspeicherung häufig genutzter Daten, was die Renderzeit drastisch verringert.

Praktisch bedeutet dies, dass interaktive Visualisierungen nun auch auf Consumer-Hardware flüssig laufen können, ohne den Gebrauch von teuren, speziell aufgeschalteten Arbeitsstationen. Dabei ist die zugrundeliegende Cache-Struktur hierarchisch organisiert, was eine hohe Auflösung dort ermöglicht, wo der Nutzer gerade hinsieht, während weniger relevante Bereiche mit geringerer Detailtiefe geladen werden. Diese adaptive Datenverwaltungsstrategie erhöht die Effizienz ungemein. Die Forscher konnten im Vergleich zu bisherigen State-of-the-Art-Methoden eine durchschnittliche Beschleunigung um den Faktor fünf erreichen, ohne die visuelle Qualität zu beeinträchtigen. Ein weiterer Vorteil ist die Kompatibilität des Frameworks mit existierenden hardwarebeschleunigten INR-Kompressoren, was eine nahtlose Pipeline von der Datenerfassung bis zur interaktiven Visualisierung ermöglicht.

In Hochleistungsrechenzentren können dadurch riesige Datensätze in Echtzeit generiert, komprimiert und gespeichert werden. Anschließend stehen diese Daten Forschern zur Verfügung, um sie auf normalen Desktop-PCs in hoher Qualität interaktiv zu erkunden. Dies verändert die Arbeitsweise in vielen wissenschaftlichen Disziplinen grundlegend. Die Vorteile dieser neuartigen Technologie sind vielseitig. Für die Wissenschaft bedeutet die Möglichkeit, extrem große Simulations- oder Messdaten unmittelbar zu visualisieren, nicht nur schnellere Einsichten, sondern auch erweiterte Erkundung und Hypothesengenerierung.

Die herkömmlichen Ansätze, bei denen Daten vorab reduziert oder aggregiert werden mussten, leiden oft unter Informationsverlust oder fehlender Interaktivität. Mit dem Cache-beschleunigten INR-Framework können Anwender nun dynamisch das Datenvolumen erkunden, Details adaptiv fokussieren und sofortiges Feedback erhalten. Besonders in Bereichen wie der Klima- und Erdsystemforschung, Astrophysik, medizinischer Bildgebung oder auch in der Materialwissenschaft eröffnen sich durch diese Technologie völlig neue Perspektiven. Auch die wirtschaftliche Komponente ist nicht zu vernachlässigen. Die Nutzung von kostengünstiger Consumer-Hardware für die Datenvisualisierung reduziert Investitions- und Betriebskosten in Forschungseinrichtungen signifikant.

Zugleich profitieren Entwickler von Softwaresystemen, die auf diesem Framework aufbauen, durch die Effizienzgewinne und Skalierbarkeit. Kritisch diskutiert wird in der Fachwelt zwar die notwendige Komplexität der Cache-Strategien sowie die Skalierung auf noch höhere Datenvolumen. Dennoch zeigt die aktuelle Forschung deutlich, dass die Kombination aus neuraler Repräsentation und intelligenter Zwischenspeicherung ein zukunftsträchtiger Weg ist. Eine weitere Herausforderung liegt in der Optimierung der adaptiven Abfragepriorisierung. Das System muss erkennen, welche volumetrischen Regionen für den Nutzer relevant sind und welche sich temporär zurückstellen lassen.

Hier kommen lernbasierte Vorhersagemodelle zum Einsatz, die die Nutzerinteraktion analysieren und damit die Visualisierungsleistung weiter verbessern. Insgesamt steht das von Zavorotny et al. entwickelte Framework für die nächste Generation der Datenvisualisierung, die mit den gewaltigen Datenmengen unserer Zeit Schritt hält. Die Verzahnung von modernen Machine-Learning-Konzepten, GPU-beschleunigtem Caching und einer hierarchischen Datenstrukturierung ermöglicht interaktive, detailreiche Visualisierungen von Datensätzen, die zuvor nur durch massiv parallele Supercomputing-Ressourcen zugänglich waren. Für Anwender bedeutet dies eine enorme Zeitersparnis und einen neuen Grad an Erkenntnisgewinn.

Die Zukunft der Datenvisualisierung wird maßgeblich durch solche innovativen Architekturen geprägt sein. Forschung und Industrie profitieren gleichermaßen von diesen Fortschritten, die Wissenschaft zugänglicher und handhabbarer machen. Das Cache-beschleunigte INR-Framework verkörpert eine wichtige Entwicklung in der Datenwissenschaft, die in den kommenden Jahren eine zentrale Rolle bei der Aufbereitung und Interpretation gigantischer Datenbestände einnehmen wird.

![The Linux Scheduler: A Decade of Wasted Cores [pdf]](/images/F251FAB6-EE0B-482A-98BC-5BD1F960E650)