Die rasante Entwicklung von Künstlicher Intelligenz (KI) begeistert seit Jahren Experten und Nutzer gleichermaßen. Besonders Modelle, die über reine Mustererkennung hinausgehen und komplexe Denkprozesse, auch als 'reasoning' bezeichnet, simulieren, erzielten in letzter Zeit beeindruckende Fortschritte. Einige dieser KI-Modelle, darunter OpenAIs o3, konnten durch ihre Fähigkeit, mathematische und programmiertechnische Aufgaben besser zu lösen, für Aufsehen sorgen. Doch eine aktuelle Analyse von Epoch AI legt nahe, dass dieser Fortschritt bald deutlich langsamer verlaufen könnte – möglicherweise innerhalb des nächsten Jahres. Diese Prognose hat sowohl das Potenzial als auch die Grenzen moderner KI-Forschung ins Zentrum der Diskussion gerückt.

Die Fortschritte bei Reasoning-KI-Modellen beruhen auf einer Kombination aus großer Datenmenge, ausgeklügelten Lernverfahren und immensem Rechenaufwand. Dabei erfolgt zunächst eine klassische Trainingsphase mit großen Datensätzen, bevor eine spezielle Technik namens Reinforcement Learning zum Einsatz kommt. Dieses verstärkende Lernen ermöglicht es dem Modell, aus seiner eigenen Arbeitsweise zu lernen, indem es Feedback erhält und seine Problemlösungen iterativ optimiert. Gerade diese Phase ist entscheidend für die Leistungssteigerung der Modelle. Laut Epoch AI ist davon auszugehen, dass bislang bei den großen KI-Modellen der Rechenaufwand in dieser letzten Trainingsphase, also im Reinforcement Learning, noch vergleichsweise moderat war.

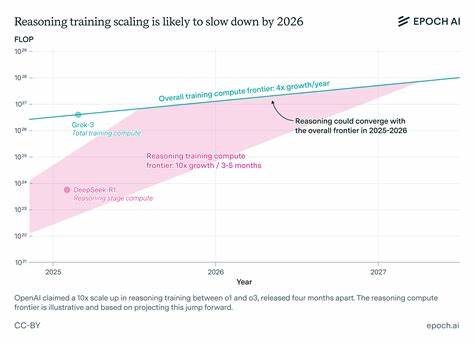

Beispielsweise hat OpenAI für das Modell o3 einen um das Zehnfache höheren Rechenaufwand als für dessen Vorgänger aufgebracht, wobei ein Großteil dieses Aufwands in das verstärkende Lernen investiert wurde. Die Zukunftspläne der Firma deuten sogar darauf hin, dass dieser Trend sich verstärken wird, sodass künftig mehr Rechenkapazität in das Verfeinern der Modelle durch Reinforcement Learning als in das eigentliche Grundtraining gesteckt wird. Doch genau hier sieht die Analyse von Epoch AI eine signifikante Grenze. Im Gegensatz zu dem gefühlt unendlichen Wachstumspotenzial der Rechenleistung, gibt es physische, wirtschaftliche und technische Beschränkungen, wie viel Ressourcen für das verstärkende Lernen überhaupt eingesetzt werden können. Diese Restriktionen werden vermutlich dazu führen, dass die Effizienzsteigerungen der Modelle im Reasoning-Bereich in den kommenden Jahren nicht mehr so rasant wachsen wie bisher.

Aktuelle Daten deuten darauf hin, dass die Verbesserungen aus dem traditionellen Modelltraining immer noch etwa alle zwölf Monate eine Vervierfachung der Leistungsfähigkeit bewirken. Im Gegensatz dazu verdoppeln sich die Fortschritte durch verstärkendes Lernen alle drei bis fünf Monate jeweils um das Zehnfache. Doch wenn sich diese Entwicklung bis 2026 angleicht, könnte das bedeuten, dass der zusätzliche Nutzen durch intensiveres Reinforcement Learning an Grenzen stößt. Ein wichtiger Aspekt in dieser Diskussion ist zudem die sogenannte Overhead-Kosten. Forschung, die weit über den direkten Rechenaufwand hinausgeht, bringt zusätzliche Herausforderungen mit sich: komplexere Modelle erfordern umfangreiche Testphasen, Experten müssen neue Algorithmen entwickeln und validieren, die Infrastruktur muss angepasst und weiter ausgebaut werden.

All diese Faktoren erzeugen nicht unerhebliche Kosten, die den Fortschritt ebenfalls bremsen können. Das kann dazu führen, dass trotz vorhandener Hardwarekapazitäten die Skalierung der Leistungen der Modelle an Grenzen stößt, weil Forschung, Entwicklung und Praxis sich nicht im gleichen Tempo weiterentwickeln. Diese Erkenntnisse sind besonders kritisch, da die gesamte KI-Branche erheblich in die Weiterentwicklung von Reasoning-Modellen investiert hat. Viele der bahnbrechenden Anwendungen unserer Zeit bauen auf der Fähigkeit von Modellen auf, komplexe rational-logische Aufgaben zu lösen – von maschinellem Programmieren bis hin zur Analyse großer Datenmengen. Gleichzeitig ist bekannt, dass diese Modelle nicht ohne Fehler sind.

Insbesondere die Tendenz zu sogenannten Halluzinationen, also erfundenen oder fehlerhaften Antworten, ist bei Reasoning-Modellen stärker ausgeprägt als bei manchen herkömmlichen KI-Architekturen. Dies macht weiterhin viel Forschung notwendig, die neben der reinen Leistungssteigerung auch die Verlässlichkeit der Modelle verbessern soll. Neben den technischen und finanziellen Herausforderungen wirkt sich die Verlangsamung des Fortschritts auch auf die Innovationsdynamik in der KI-Branche aus. Unternehmen wie OpenAI, Google und andere führende Forschungsinstitute müssen ihre Strategien überdenken, wie sie Ressourcen am effektivsten einsetzen, um weiterhin bahnbrechende Ergebnisse zu erzielen. Gleichzeitig könnten alternative Ansätze an Bedeutung gewinnen, beispielsweise hybride Modelle, die mehrere KI-Techniken kombinieren oder komplett neue Lernmethoden abseits von Reinforcement Learning ausprobieren.

Die Prognose von Epoch AI ist ein Weckruf für die gesamte Branche. Während der Hype um KI und ihr Potential weiter anhält, verdeutlicht sie, dass die Entwicklung hochkomplexer, autonom agierender KI-Systeme keine lineare Erfolgsgeschichte ist. Grenzen bei Rechenkapazität, steigende Kosten und technische Herausforderungen könnten den Fortschritt bald bremsen. Den Forschern und Entwicklern fällt nun die Aufgabe zu, Wege zu finden, wie mit begrenzten Ressourcen maximale Fortschritte erzielt werden können. Innovative Methoden zur Effizienzsteigerung, neue Algorithmen und interdisziplinäre Ansätze sind gefragt, um die nächsten Evolutionsschritte der KI möglich zu machen.