Die Wahl der richtigen Datenbanklösung ist für Unternehmen eine fundamentale Entscheidung, die sich direkt auf Skalierbarkeit, Performance und Betriebskosten auswirkt. In den letzten Jahren hat CockroachDB aufgrund seiner verteilten Architektur und der Fähigkeit zu horizontaler Skalierung für viel Aufmerksamkeit gesorgt, besonders bei Anwendungen, die Multi-Region-Setups benötigen. Doch für viele Firmen zeigt sich mit zunehmendem Wachstum und Komplexität, dass alternative Lösungen wie Postgres wieder an Attraktivität gewinnen. Die Migration von CockroachDB zu Postgres ist dabei ein entscheidender Schritt, der nicht nur aus technischer Sicht gut geplant sein muss, sondern auch Auswirkungen auf den gesamten Entwicklungs- und Betriebsprozess hat. Begonnen hat der Wechsel vieler Unternehmen aufgrund steigender Kosten und operativer Schwierigkeiten, die bei der Nutzung von CockroachDB auftreten können.

So kann die Rechnung für einen CockroachDB-Cluster im Laufe der Zeit erheblich anwachsen, was speziell bei einzelnen Regionen und weniger komplexen Datenanforderungen schnell zum Kostenfaktor wird. In einem Fall wie dem von Motion, einem Unternehmen, das Anfang 2022 noch CockroachDB einsetzte, stiegen die Kosten über zwei Jahre hinweg auf das Fünffache an, was sich im mittleren sechsstelligen Bereich pro Jahr bewegte. Dies stellte eine belastende Ausgabe dar, die vor allem dadurch entstand, dass viele der Vorteile von CockroachDB wie Multi-Region-Skalierung nicht im vollen Umfang genutzt wurden. Technisch gesehen sind Migrating-Prozesse durchdacht und gut vorbereitet durchzuführen. Ein entscheidender Vorteil lag hier in der Nutzung eines Object-Relational Mappers (ORM) wie Prisma, der die Testing-Phase der Migration vereinfacht und solche Head-to-Head-Vergleiche von Datenbanken ermöglicht.

Bei der Durchführung von Datenbank-Migrationen stellte sich heraus, dass CockroachDB bei großen Datenmengen tendenziell zu Timeout-Problemen neigt. Insbesondere wenn Migrationen durchgeführt werden, etwa das Hinzufügen neuer Spalten, blockierten häufig lange Laufzeiten oder gar Abbrüche die gesamte Deployment-Pipeline. Dies führte dazu, dass Entwickler gezwungen waren, Migrationen manuell und oft parallel anzustoßen, was den Prozess nicht nur verlängerte, sondern auch das Risiko für Fehler erhöhte. Im Vergleich dazu konnte Postgres dieselben Migrationen auf einer Datenbank in ähnlicher Größe in einem Bruchteil der Zeit ausführen, teilweise nur in wenigen Sekunden. Diese Performance-Gewinne bei der Migration sind ein direktes Beispiel für die operative Effizienz, die Postgres zu bieten hat.

Ein weiteres Problem, das im Laufe des Betriebs mit CockroachDB spürbar wurde, betraf ETL-Prozesse (Extract, Transform, Load). Während Datenbankmigrationen oft als einmalige Herausforderung betrachtet werden, sind ETL-Prozesse für viele Unternehmen integraler Bestandteil der Datenstrategie und notwendig, um Daten für Analyse- und Integrationszwecke aufzubereiten und zu bewegen. Bei CockroachDB zeigte sich schnell, dass es nur eingeschränkte Möglichkeiten für stabile ETL-Lösungen gab. Dies wurde besonders durch die Tatsache erschwert, dass der einzige verfügbare Airbyte-Connector für CockroachDB lange Zeit in der Alpha-Phase verblieb und durch Speicherlecks und Instabilitäten geprägt war. Solche technischen Schwächen beeinträchtigten den operativen Ablauf deutlich, was sich für Unternehmen mittelfristig als kritisch herausstellt.

Interessant sind auch die Performance-Differenzen bei der Ausführung von Abfragen. Obwohl CockroachDB in bestimmten Fällen, insbesondere bei einigen Abfragen mit Aggregationen, dank seines Optimierers Vorteile bietet, offenbarten reale Anwendungsfälle ein anderes Bild. Viele generierte SQL-Statements, insbesondere solche, die von ORMs automatisch erzeugt wurden, waren überaus komplex und führten bei CockroachDB zu schlechten Ausführungsplänen wie Full Table Scans, die erheblich zu längeren Antwortzeiten führten. Tatsächlich zeigten Vergleiche, dass Abfragen auf Postgres oft bis zu zwanzig Mal schneller abliefen, was auf den effektiveren Query Planner und die bessere Verarbeitung von komplexen Joins und Indizes zurückzuführen ist. Diese Leistungsvorteile bedeuten bei echten Anwendungen eine deutlich bessere Benutzererfahrung und geringere Latenzen in der Anwendung.

Auch die Entwickler- und Betriebserfahrung mit CockroachDB brachte einige unerwartete Herausforderungen mit sich. So verursachte die Verwaltung von Indizes, die als ungenutzt angezeigt wurden, Verwirrung in der Entwicklercommunity. Für das Abbrechen von laufenden, teuren Anfragen war es bei CockroachDB deutlich aufwändiger als bei Postgres. Während letzteres meist mit einem simplen Mausklick im SQL-Client zu bewerkstelligen ist, erfordert CockroachDB die manuelle Intervention auf Cluster-Ebene und das koordinierte Abbrechen über mehrere Nodes hinweg. Das erhöht die Komplexität und das Risiko für Systeminstabilitäten.

Der Support-Prozess bei CockroachDB stellte ebenfalls einen kritischen Prozesspunkt dar. Die Trennung zwischen verschiedenen Support-Portalen, die Notwendigkeit, Daten mehrfach einzugeben, und insbesondere die langen Wartezeiten führen in kritischen Situationen zu Verzögerungen, die bei Produktionsausfällen gravierend sein können. Im Gegensatz dazu bietet PostgreSQL durch seine weite Verbreitung und die große Community Zugang zu umfangreicher Dokumentation, schnellen Problemlösungen und einer Vielzahl von professionellen Support-Angeboten. Ein weiterer Stolperstein auf technischer Ebene waren etwaige Verbindungsprobleme innerhalb der virtuellen privaten Netzwerke (VPC), die sich periodisch manifestierten und scheinbar ohne klare Ursache verschwanden. Diese Probleme, die sich auf verschiedene Umgebungen erstreckten, konnten trotz intensiver Untersuchungen nicht vollständig behoben werden und waren mit CockroachDB verbunden.

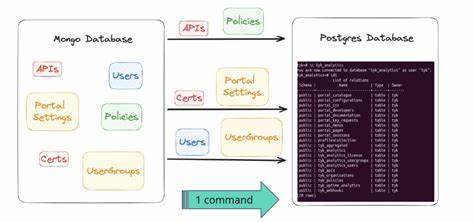

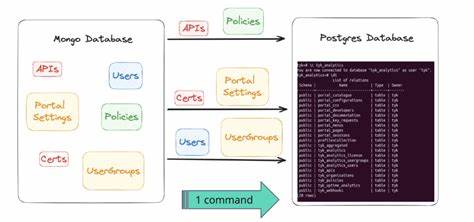

Mit Postgres hingegen traten keine derartigen Instabilitäten auf, was wiederum den stabilen Betrieb begünstigte. Die tatsächliche Migration großer Datenmengen – ein erhebliches Hindernis bei solch einem Wechsel – wurde durch den Einsatz von modernen Tools und Skripten unterstützt. In einem bekannten Fall wurde die Migration mithilfe einer innovativen Lösung unter Verwendung von Bun, einem JavaScript-Laufzeitumgebung, durchgeführt. Dabei wurden die Daten aller Tabellen ausgegeben, in CSV-Dateien gespeichert und dann parallel via Streaming-Prozessen nach Postgres importiert. So konnte trotz der hohen Datenmenge von etwa 100 Millionen Datensätzen in der größten Tabelle die Migration binnen 15 Minuten erfolgreich abgeschlossen werden.

Eine besondere Herausforderung stellte die unterschiedliche Behandlung von JSON- und Array-Feldern in CockroachDB und Postgres dar, die individuelle Anpassungen und Datenkonvertierungen notwendig machten. Nach der Migration zeigte sich schnell ein positiver Effekt auf das System. Die aggregierte Latenzzeit der Anfragen sank um etwa ein Drittel, was für eine deutlich bessere Performance und Nutzerzufriedenheit sorgte. Mit Tools wie PGAnalyze wurden im Nachgang zusätzliche unoptimierte Abfragen identifiziert und behoben, sodass die Vorteile der Migration nachhaltig gesteigert werden konnten. Außerdem führte die Umstellung zu erheblichen Kosteneinsparungen, welche speziell durch das geringere Ressourcen- und Support-Management von Postgres in einem mittleren sechsstelligen Bereich pro Jahr lagen.