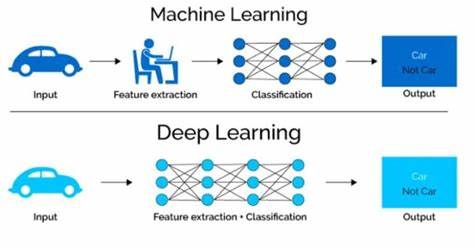

Grafikprozessoren (GPUs) haben sich in den letzten Jahren zu unverzichtbaren Komponenten für das maschinelle Lernen (ML) entwickelt. Besonders in Rechenzentren sind die Anforderungen an GPU-Ressourcen durch vielfältige ML-Modelle, sowohl bei Training als auch bei Inferenz, enorm gestiegen. Angesichts dieses exponentiellen Wachstums ist eine effiziente Verwaltung und Nutzung von GPUs essenziell, um Energieverbrauch zu senken, Durchsatz zu verbessern und Latenzzeiten zu minimieren. Genau hier setzt LithOS an, ein neuartiges Betriebssystem, das speziell für die Bedürfnisse des maschinellen Lernens auf GPUs entwickelt wurde und die interne Ressourcenzuteilung auf eine ganz neue Ebene hebt. LithOS ist das Ergebnis intensiver Forschung und Entwicklung, die darauf abzielt, die bestehenden Herausforderungen im GPU-Management zu beseitigen.

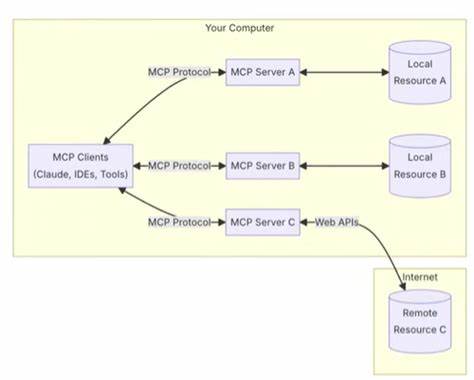

Traditionelle Systeme wie NVIDIA MPS (Multi-Process Service) oder aktuelle state-of-the-art Ansätze stoßen bei komplexen Workloads oft an ihre Grenzen. Sei es durch ineffiziente Ressourcennutzung, hohe Latenzzeiten oder unnötigen Energieverbrauch – die Anforderungen von modernen ML-Anwendungen erfordern ein radikal transparentes und feinkörniges Management der GPU-Komponenten. LithOS verfolgt genau diesen Ansatz mit einer neuen Architektur, die mehrere innovative Mechanismen beinhaltet. Im Zentrum von LithOS steht der TPC-Scheduler, ein Scheduler zur Verwaltung von Texture Processing Clustern (TPCs) auf GPUs. TPCs sind elementare Verarbeitungseinheiten innerhalb moderner GPUs.

Die Fähigkeit, diese Einheiten nicht nur zu teilen, sondern sogar dynamisch zwischen verschiedenen Workloads zu stehlen, führt zu einer stark erhöhten Auslastung und verbessert so den Gesamtdurchsatz. Durch die Umsetzung einer „spatialen“ Scheduling-Strategie auf der Granularität von einzelnen TPCs ermöglicht LithOS eine bislang unerreichte Flexibilität in der parallelen Ausführung verschiedenartiger ML-Modelle. Ein weiterer bedeutender Fortschritt ist die sogenannte Kernel-Atomisierung. Traditionelle GPU-Ausführung leidet oft unter sogenannten „Head-of-line-Blocking“-Effekten, bei denen ein einzelner Prozess oder Kernel den Fortschritt anderer blockiert. LithOS zerlegt laufende Kernel transparent in kleinere Atom-Einheiten.

Diese Aufteilung erlaubt es, Ressourcen dynamisch während der Ausführung umzuschichten und freizugeben, was den Durchsatz erhöht und die Latenz bei der Verarbeitung reduziert – ein absolut entscheidender Vorteil gerade für Anwendungen in der Inferenz, bei denen schnelle Antwortzeiten gefragt sind. Die Effizienz von LithOS wird zudem durch eine Hardware-unterstützte Right-Sizing-Mechanismus weiter verbessert. Dieser Mechanismus bestimmt minimal notwendige TPC-Ressourcen pro Atom und passt die Zuteilung dynamisch an den Bedarf an. So wird verhindert, dass Ressourcen unnötig allokiert werden, was nicht nur die Leistung optimiert, sondern auch erheblich Energie spart. Gerade in ressourcenintensiven Rechenzentren ist dies ein Faktor, der sowohl die Betriebskosten senkt als auch die ökologische Nachhaltigkeit fördert.

Ergänzend dazu integriert LithOS eine transparente Power-Management-Komponente. Basierend auf der Analyse des aktuellen Workloads und dessen Verhalten während der Ausführung wird die Leistungsaufnahme der GPU automatisch angepasst. Dieser proaktive Ansatz zur Energieeinsparung ermöglicht eine Reduzierung des Stromverbrauchs um bis zu einem Viertel, ohne signifikanten Leistungseinbruch in Kauf nehmen zu müssen. Gerade bei kontinuierlich laufenden ML-Diensten in Rechenzentren mit tausenden GPUs ist solch eine Optimierung ein enormer Gewinn. Die Implementierung von LithOS in der Programmiersprache Rust unterstreicht zudem den Fokus auf Sicherheit, Stabilität und Performance.

Rust als moderne Systemsprache bietet neben Speicher- und Threadsicherheit auch hervorragende Performance-Eigenschaften, die für die hochkomplexe Verwaltung von GPU-Ressourcen notwendig sind. Das Forschungsteam hat die Leistungsfähigkeit von LithOS ausgiebig in verschiedenen ML-Szenarien getestet und mit etablierten Lösungen verglichen. Dabei zeigte LithOS herausragende Verbesserungen sowohl bei Latenzen als auch beim Gesamtdurchsatz. Speziell bei der sogenannten Inferenz-Stacking-Strategie reduzierte LithOS die spitzen Latenzzeiten um das 13-fache im Vergleich zu NVIDIA MPS. Auch beim hybriden Einsatz von Inferenz und Training gleichzeitig betrug die Reduktion der Latenzen ein Vielfaches, während die Gesamtdurchsatzrate deutlich über den bisherigen Bestleistungen lag.

Diese Ergebnisse sprechen für sich: LithOS ermöglicht eine effiziente parallele Berechnung verschiedenartiger ML-Modelle ohne Kompromisse bei der Qualität der Antwortzeiten oder dem Ressourcenverbrauch. Die Kombination aus besserer Auslastung, geringeren Latenzen und signifikanten Energieeinsparungen macht LithOS zu einem vielversprechenden Fundament für zukünftige Betriebssystementwicklungen im Bereich der GPU-basierten Berechnungen. Angesichts der zunehmenden Integration von KI-Anwendungen in nahezu allen Branchen – von selbstfahrenden Fahrzeugen über medizinische Diagnostik bis hin zu Finanzdienstleistungen – ist eine solche Weiterentwicklung von fundamentaler Bedeutung für Skalierbarkeit, Wirtschaftlichkeit und ökologische Verträglichkeit. Darüber hinaus eröffnet LithOS neue Forschungsperspektiven. Die Idee eines Betriebssystems speziell für GPUs fordert traditionelle Ansätze heraus und regt zur Entwicklung zusätzlicher Mechanismen an, die den spezifischen Herausforderungen von ML-Workloads Rechnung tragen können.

Zukunftige Erweiterungen könnten noch tiefere Einblicke in die GPU-Architektur nutzen, kunstliche Intelligenz im OS-Management implementieren oder eine noch bessere Zusammenarbeit mit CPUs und anderen Hardwarekomponenten realisieren. LithOS stellt somit nicht nur eine technische Innovation dar, sondern auch einen Paradigmenwechsel im Umgang mit GPU-Ressourcen. Der Ansatz einer transparenten, dynamischen und effizienten Verwaltung auf Betriebssystemebene setzt neue Maßstäbe für die Zukunft intelligenter Recheninfrastrukturen. Für Unternehmen, Forscher und Entwickler im Bereich maschinelles Lernen ist LithOS daher von enormer Relevanz und öffnet das Tor zu deutlich leistungsfähigeren, ressourcenschonenderen und nachhaltigen ML-Systemen. Insgesamt ist die Entwicklung von LithOS ein wegweisender Schritt zur Optimierung der Ressourcennutzung in der Ära der künstlichen Intelligenz.

Die Verbindung von innovativen Scheduling-Algorithmen, adaptiven Ressourcenanpassungen und intelligentem Power Management schafft eine ideale Basis für die nächste Generation von GPUs im datenzentrierteren, von KI geprägten Zeitalter. Dadurch wird die enorme Transformationskraft von maschinellem Lernen nicht nur nutzbarer, sondern auch wirtschaftlich tragbarer und ökologisch verantwortungsbewusster.