In der Welt der künstlichen Intelligenz und speziell bei der Entwicklung von Sprachmodellen sind die Methoden zur Textgenerierung entscheidend dafür, wie natürlich, kohärent und kreativ die erzeugten Inhalte wirken. Eine der jüngeren und vielversprechend diskutierten Techniken ist das sogenannte Min-P Sampling. Doch was verbirgt sich hinter dieser Methode, welche Vorteile bietet sie und welche kritischen Aspekte gilt es zu beachten? Diese Frage steht im Zentrum einer umfassenden Analyse, die das Potenzial und die Grenzen von Min-P Sampling beleuchtet. Sprachmodelle wie GPT, BERT und andere neuronale Netzwerke basieren darauf, Wahrscheinlichkeiten für verschiedene Wortfolgen zu berechnen, um natürliche Sprache möglichst realistisch zu generieren. Klassische Sampling-Methoden wie Greedy Search zielen darauf ab, stets das wahrscheinlichste nächste Wort zu wählen, was jedoch häufig zu monotonen und unnatürlichen Texten führt.

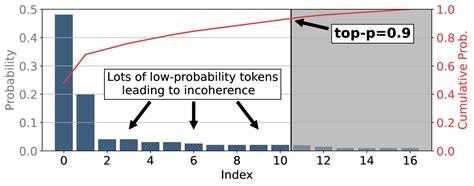

Um das zu umgehen, wurden Techniken wie Top-k Sampling und nucleus sampling (Top-p Sampling) etabliert, die eine gewisse Zufälligkeit hinzufügen, um abwechslungsreichere und lebendigere Texte zu erzeugen. Min-P Sampling knüpft hier an und stellt eine weiterentwickelte Form von sampling-basierten Methoden dar. Im Kern geht es darum, nicht nur anhand der höchsten Wahrscheinlichkeiten zu entscheiden, sondern eine Mindestwahrscheinlichkeitsschwelle („Minimal Probability“) für die nächsten Wortkandidaten zu definieren. Diese Schwelle dient dazu, eine angemessene Auswahl an Alternativen zu zulassen und zugleich das Risiko zu minimieren, in irrelevante oder semantisch unpassende Bereiche abzudriften. Der große Vorteil von Min-P Sampling liegt darin, dass es ein feiner justierbares Gleichgewicht zwischen Vielfalt und Kohärenz schafft.

Indem nur Wörter berücksichtigt werden, die über einer definierten Mindestwahrscheinlichkeit liegen, kann das Modell flexibler reagieren, ohne die Gefahr inkohärenter Sätze zu steigern. Gerade in komplexen Anwendungen, wo sowohl Kreativität als auch inhaltliche Konsistenz gefordert sind – wie bei literarischer Textgenerierung, Chatbots oder automatischer Textzusammenfassung – erweist sich dieser Ansatz als wertvoll. Dennoch ist Min-P Sampling nicht frei von Herausforderungen. Der wichtigste Kritikpunkt betrifft die Schwierigkeit, die ideale Mindestwahrscheinlichkeit für verschiedene Anwendungsszenarien festzulegen. Ein zu hoher Wert schränkt die kreativen Optionen stark ein und führt oft zu einer zu deterministischen Textausgabe, während ein zu niedriger Wert das Risiko erhöht, unlogische oder zusammenhangslose Wortfolgen zu produzieren.

Zudem erfordert die Feinjustierung dieser Schwelle oft intensives Experimentieren und domain-spezifische Anpassungen. Ein weiterer wichtiger Aspekt ist die Performance des Modells in puncto Laufzeit und Rechenaufwand. Sampling-Methoden mit dynamischen Wahrscheinlichkeitsfiltern wie Min-P können, abhängig von der Implementierung, aufwendiger sein als einfache Greedy-Methoden, da potenziell eine größere Auswahl an Wortkandidaten im Entscheidungsprozess berücksichtigt werden muss. Hier zeigt sich, dass der Einsatz von Min-P Sampling besonders dort sinnvoll ist, wo die Qualität der Textgenerierung klar im Vordergrund steht und Ressourcen nicht die primäre Beschränkung darstellen. Die Forschung in diesem Bereich ist hochdynamisch.

Verschiedene Studien vergleichen Min-P Sampling mit anderen etablierten Verfahren und evaluieren dessen Einfluss auf Metriken wie Perplexity, Textkonsistenz, semantische Relevanz und menschliche Bewertung der Textqualität. Dabei zeichnet sich ab, dass Min-P Sampling besonders dann glänzt, wenn es darum geht, kreative und dennoch verständliche Texte zu erzeugen, die nicht zu stark von den Trainingsdaten abweichen, aber auch nicht vollkommen auf vorhersehbaren Pfaden bleiben. Ebenso spannend sind die möglichen Kombinationen von Min-P Sampling mit anderen Techniken wie Temperatursteuerung. Während die Temperatur innerhalb des Modells eine weichere oder schärfere Wahrscheinlichkeitsverteilung erzeugt, kann die Min-P Schwelle als zusätzlicher Filter fungieren, der die Auswahl noch gezielter begrenzt. Diese Kombination eröffnet neue Möglichkeiten, die Textgenerierung an spezielle Anforderungen anzupassen und Feinheiten im Output zu kontrollieren.

Für Entwickler und Forscher in der KI-Landschaft ist es essenziell, Min-P Sampling nicht isoliert zu betrachten, sondern als Teil eines umfassenden Methodenspektrums zur Textgenerierung. Gerade im Zusammenspiel mit modernen Transformer-Architekturen bietet die Methode interessante Ansätze, um das Spannungsfeld zwischen Kreativität, Kohärenz und Effizienz zu meistern. Die kritische Reflexion über den richtigen Einsatz und die Parametrisierung von Min-P Sampling kann somit den Unterschied ausmachen zwischen einem mittelmäßigen und einem herausragenden Sprachmodell. Abschließend lässt sich festhalten, dass Min-P Sampling eine faszinierende Weiterentwicklung unter den Sampling-Methoden darstellt. Es ermöglicht eine differenziertere Steuerung der Textausgabe, die besonders bei komplexen oder kreativen Aufgaben von großem Nutzen ist.

Gleichzeitig weist es jedoch technische und methodische Herausforderungen auf, die noch weiter erforscht und optimiert werden müssen. Der Weg zu wirklich menschlich wirkenden Sprachmodellen führt über die Kombination und Feinjustierung solcher innovativer Techniken, wobei Min-P Sampling eine entscheidende Rolle spielen kann.