Die Datenbankforschung steht an der Spitze der technologischen Innovation und prägt maßgeblich die digitale Welt von morgen. Eine der zentralen Publikationen in diesem Bereich sind die Proceedings of the VLDB Endowment (PVLDB), die jährlich die neuesten wissenschaftlichen Erkenntnisse und Techniken zum Thema Datenbanken und große Datensysteme publizieren. Für die Ausgabe 2024-2025 zeichnet sich ab, dass die Forschung verstärkt auf die Herausforderungen und Chancen der modernen Datenverarbeitung fokussiert. In diesem umfassenden Überblick wird deutlich, wie Forscher neue Paradigmen, Methoden und Systeme vorstellen, um Effizienz, Skalierbarkeit, Sicherheit und Intelligenz von Datenbanksystemen weiter zu verbessern.Die Proceedings des VLDB Endowment sind bekannt für ihre hohe wissenschaftliche Qualität und für die Vielfalt der behandelten Themen.

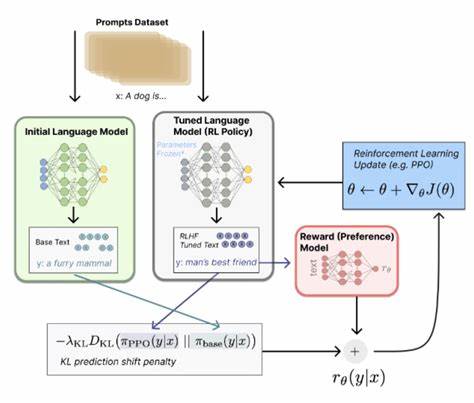

Dabei reicht das Spektrum von optimierten Algorithmen für Datenbankabfragen über graphbasierte Datenanalysen bis hin zu Anwendungen großer Sprachmodelle (Large Language Models, LLMs) und deren Integration in datenintensive Systeme. Die Veranstaltungsleitung für Volume 18 liegt bei Themis Palpanas und Nesime Tatbul, die gemeinsam mit einem Team erfahrener Associate Editors und Reviewing Boards die Publikationen kuratieren und sicherstellen, dass wegweisende Arbeiten veröffentlicht werden.Eine der herausragenden Entwicklungen in den Proceedings ist die Integration von Künstlicher Intelligenz und maschinellem Lernen in traditionelle Datenbank- und Abfragesysteme. Regelbasierte Rewrite-Systeme, die durch große Sprachmodelle unterstützt werden, können die Effizienz von Datenbankabfragen signifikant erhöhen, indem sie komplexe Abfrageoptimierungen automatisieren. Ansätze wie LLM-R2 machen deutlich, wie natürliche Sprachverarbeitung und komplexe Regelwerke Hand in Hand gehen, um Abfragen dynamisch zu verbessern.

Parallel hierzu erfährt die Verarbeitung von Graphdatenbanken eine bemerkenswerte Beschleunigung. Die vorgestellten Arbeiten zu graphbasierten Partitionierungsmethoden – wie CUTTANA – und effizienten Algorithmen für das Mining von Mustern in Graphen gewährleisten nicht nur eine schnellere Datenverarbeitung, sondern auch eine bessere Skalierbarkeit in verteilten Systemen. Die Erforschung von Graph Neural Networks (GNN) und entsprechenden Trainingssystemen wird weiter intensiviert, was sich in Arbeiten über verteilte, load-balancierte Trainingstechniken und der Untersuchung von Adjazenz- und Speicherformaten widerspiegelt.Ein weiteres zentrales Thema ist die autonome und automatisierte Verarbeitung großer Zeitreihendaten. Angefangen bei der vollständigen Automatisierung der Prognose korrelierter Zeitreihendaten bis hin zu innovativen Transformer-basierten Modellen, die spezifische Herausforderungen wie Trajektorien-Similarität lösen.

Modelle wie „A Memory Guided Transformer“ zeigen, wie tiefe neuronale Netze helfen, die Prognosegenauigkeit bei minimalem Rechenaufwand zu steigern, was für viele Anwendungen in Monitoring und IoT entscheidend ist.Die Datenqualität und System-Integrität aller Datenbank- und Analyseprozesse bleiben ein Dauerthema. Fortschritte in der Anomalieerkennung, speziell bei logbasierten Systemen, ermöglichen es, komplexe Fehlerquellen schneller zu identifizieren und zu beheben. Ebenso werden datenschutzorientierte Methoden, wie die Entwicklung differenzieller Privatsphäre und deren Anpassung an Datenbanksysteme, kontinuierlich ausgeweitet. Dies zeigt sich in Verbesserungen der Noise-Calibration für anonyme Datenanalysen und neuartigen Ansätzen zur Synthese von privaten Daten als Grundlage für Benchmarking und Tests.

Hochleistungsdatenbanken für Echtzeitanwendungen und große Überwachungsinfrastrukturen sind ebenfalls prominent vertreten. Arbeiten zum Design schemaloser Zeitreihendatenbanken auf Pinterest demonstrieren die hohe Praxisrelevanz der Forschung, indem sie aufzeigen, wie variable und heterogene Manageressourcen effizient verwaltet werden. In Kombination mit GPU-beschleunigten relationalen Engines und beschleunigtem graphbasiertem Indexing entstehen Systeme, die den Anforderungen moderner, datenintensiver Anwendungen gerecht werden.Neben technischen Innovationen werden auch Grundlagenforschungen zu theoretischen Aspekten von Datenbanksystemen intensiv diskutiert. So beschäftigen sich Studien mit neuen Methoden der Kardinalitätsschätzung, welche für Optimierungstechniken zentral sind, oder mit der Formalisierung von Datalog-Erweiterungen, die das Wissen über Fakten und Regeln erstmals in einem konsistenten, relationellen Rahmen verbessern können.

Ebenso sind effiziente Algorithmen für klassische Probleme wie das Finden größter Cliquen oder die Suche nach ähnlichen Subgraphen weiterhin Forschungsschwerpunkte.Spannend ist zudem der wachsende Einfluss von serverlosen Architekturen auf die Datenbankforschung. Projekte wie Nitro zeigen, wie verteiltes Reinforcement Learning durch serverlose Computing-Modelle beschleunigt und skaliert werden kann. Diese Ansätze verschieben traditionelle Grenzen und bieten flexible, kosteneffektive Lösungen für hochkomplexe, skalierbare Systeme.Zusammenfassend spiegelt Volume 18 der Proceedings of the VLDB Endowment das breite Spektrum und die Tiefe der modernen Datenbankforschung wider.

Innovationen bei der Integration Künstlicher Intelligenz, bei der Optimierung großer Graph- und Zeitreihendatenbanken sowie neue Modelle für Datenschutz und Systemeffizienz zeichnen einen klaren Weg in die Zukunft. Die vielfältigen Beiträge aus Wissenschaft und Praxis schaffen die Grundlagen für Systeme, die den Datenmengen und Anforderungen von morgen gewachsen sind. Für Forscher, Entwickler und Anwender bedeutet dies eine reiche Quelle an Inspiration und praxistauglichen Ideen, wie Daten besser, schneller und sicherer verarbeitet werden können. Die Proceedings bleiben somit eine unverzichtbare Ressource für alle, die am Puls der Datenbanktechnologie arbeiten und die digitale Transformation aktiv mitgestalten wollen.

![GitHub Helping Users Work Together (2013) [video]](/images/606033DB-4397-4F1A-B8B9-F94CA1699256)