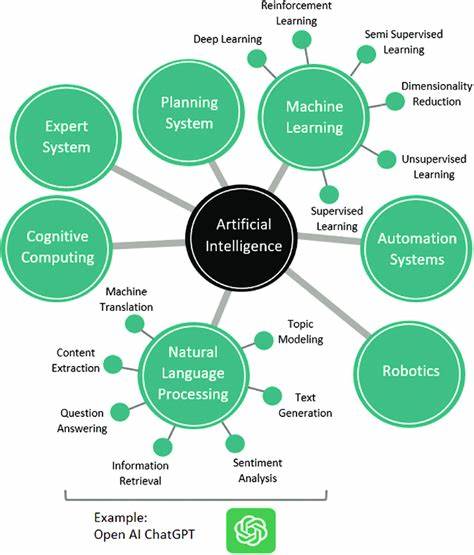

Die Entwicklung Künstlicher Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht. Doch während spezialisierte KI-Systeme bereits beeindruckende Leistungen in spezifischen Aufgaben zeigen, bleibt die Messung der sogenannten Allgemeinen Künstlichen Intelligenz (AGI) eine der größten Herausforderungen im Bereich der Forschung. AGI bezeichnet eine Form von KI, die in der Lage ist, eine breite Palette von kognitiven Aufgaben auf menschlichem Niveau oder darüber hinaus zu bewältigen. Um den Fortschritt in diesem Bereich zu evaluieren, sind neue und innovative Messmethoden notwendig. Hier kommen interaktive Reasoning Benchmarks ins Spiel, die zunehmend als vielversprechendes Instrument zur Beurteilung von AGI zählen.

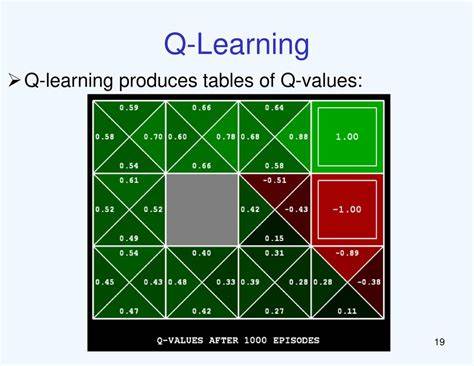

Diese Benchmarks ermöglichen es, die Fähigkeit von Systemen zu testen, komplexe Probleme dynamisch zu lösen, anstatt nur auf festgelegte, statische Aufgaben zu reagieren. Diese interaktiven Tests nehmen eine Schlüsselrolle ein, indem sie nicht nur das reine Faktenwissen oder die vorprogrammierte Antwortfähigkeit eines Modells beurteilen, sondern vielmehr die Fähigkeit zum logischen Denken, zur Anpassung an neue Herausforderungen und zum Lernen aus Interaktionen. Anders als traditionelle Benchmarks, die häufig multiple-choice Fragen oder Feststellung von Faktenwissen enthalten, verlangen interaktive Reasoning Benchmarks von den KI-Systemen, sich aktiv auf eine Aufgabe einzulassen, Informationen zu sammeln, Schlussfolgerungen zu ziehen und gegebenenfalls Strategien zu ändern oder zu optimieren. Dies spiegelt eher die Komplexität und Dynamik intelligenter Entscheidungsfindung wider, wie sie auch Menschen eigen ist. Videos und Demonstrationen zu diesem Thema verdeutlichen, wie solche Benchmarks gestaltet sind und welche Aufgaben sie beinhalten.

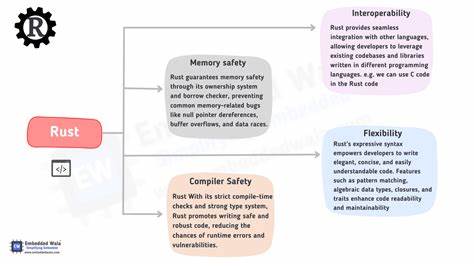

Sie zeigen beispielsweise Szenarien, in denen ein KI-Agent eine Reihe von Hinweisen interpretieren, Hypothesen aufstellen und in Echtzeit auf neue Informationen reagieren muss. Durch diesen interaktiven Ansatz können Forscher Einblicke in das Verständnis und das „Denken“ von KI-Systemen gewinnen, was bloße Leistungsindikatoren in statischen Tests nicht leisten können. Zudem helfen diese Benchmarks dabei, Schwächen in den Algorithmen zu identifizieren, wie etwa Schwierigkeiten bei der Generalisierung oder dem Umgang mit Unsicherheiten. Dadurch entsteht eine Grundlage für gezieltes Training und die Weiterentwicklung von Modellen. Die Anwendung interaktiver Reasoning Benchmarks trägt maßgeblich dazu bei, das Ziel einer echten AGI zu erreichen – nämlich einer Maschine, die nicht nur lernt, sondern versteht und flexibel auf vielfältige Herausforderungen reagieren kann.

In der Forschung hat sich gezeigt, dass Fortschritte in diesem Bereich auch unmittelbare Auswirkungen auf die Praxis haben, beispielsweise in der Automatisierung komplexer Arbeitsprozesse, im Bereich der Robotik oder in intelligenten Assistenzsystemen. Ein weiterer Vorteil dieser interaktiven Prüfverfahren liegt in ihrer Möglichkeit, verschiedene Fähigkeiten zu kombinieren. Intelligenz wird hier ganzheitlich verstanden und bewertet. Das umfasst Sprachverständnis, logisches Denken, Problemlösung und auch kreative Aspekte. Daher entsprechen sie eher den realen Anforderungen, die an ein System mit echter Intelligenz gestellt werden.

Während die technische Umsetzung solcher Benchmarks noch mit Herausforderungen verbunden ist – etwa die Gestaltung von Szenarien, die für Menschen gleichermaßen nachvollziehbar wie anspruchsvoll sind oder die Sicherstellung von fairen Vergleichsbedingungen – ist ihr Potenzial unbestritten. Sie fördern Innovationen in der Modellarchitektur und stimulieren neue Ansätze im Lernverhalten von KI-Systemen. Insgesamt lässt sich sagen, dass interaktive Reasoning Benchmarks ein entscheidender Schritt auf dem Weg zur Messung und Entwicklung Allgemeiner Künstlicher Intelligenz sind. Sie bringen die Forschung in eine Richtung, die nicht nur quantitative, sondern vor allem qualitative Fortschritte ermöglicht. In Zukunft werden solche Methoden eine zentrale Rolle einnehmen, wenn es darum geht, die Fähigkeiten von KI-Systemen realistisch einzuschätzen und zu verbessern.

Entsprechend lohnt es sich für Forscher, Entwickler und Interessierte, diesen Trend aufmerksam zu verfolgen und aktiv mitzugestalten.

![Measuring AGI: Interactive Reasoning Benchmarks [video]](/images/2393D6D6-6334-4E61-BD29-456901A2439F)