Unicode ist seit seiner Einführung eine der grundlegendsten Technologien für die digitale Welt. Es handelt sich dabei um einen universellen Zeichensatz, der darauf abzielt, alle Schriftzeichen, Symbole und Sonderzeichen aller Sprachen und Schriftsysteme abzubilden. Damit stellt Unicode eine unverzichtbare Grundlage dar, um Texte verschiedenster Ethnien, Kulturen und Fachgebiete in digitalen Systemen korrekt darzustellen und auszutauschen. Trotz seiner zentralen Bedeutung bringt Unicode jedoch neben zahlreichen Vorteilen auch Herausforderungen und Probleme mit sich, die Entwickler und Nutzer gleichermaßen beschäftigen. Die Betrachtung von Unicode lässt sich daher als Zusammenspiel von guten Seiten, schwierigen Aspekten und teils unerwarteten Problemen beschreiben – oder, frei nach dem Ausdruck des Themas, als das Gute, das Schlechte und das Hässliche der Unicode-Unterstützung.

Ein Blick zurück in die Geschichte ist hilfreich, um die Motivation für die Entwicklung von Unicode zu verstehen. Vor der Einführung von Unicode existierten diverse unterschiedliche Codepages und Zeichensätze, die jeweils auf bestimmte Sprachen oder Regionen ausgelegt waren. Dies führte zu Kompatibilitätsproblemen, die grenzüberschreitende Kommunikation und den Datenaustausch erschwerten. Unicode wurde entwickelt, um ähnlich wie ein internationales Alphabet eine einheitliche Grundlage zu schaffen, die alle Zeichen praktisch aller Sprachen repräsentiert. Dieses Prinzip hat sich im Laufe der Zeit als extrem mächtig erwiesen.

Doch auch wenn Unicode theoretisch universell jedem Zeichen eine eindeutige Nummer zuweist, ist die praktische Umsetzung oft komplexer. Verschiedene Betriebssysteme, Programmiersprachen und Anwendungen unterstützen Unicode in unterschiedlichem Maße und bieten Interpretationen, die nicht immer zueinander passen. Gerade bei der Anzeige, Eingabe und Verarbeitung von Unicode-Daten treten häufig Probleme auf. Ein Beispiel hierfür sind die vielen Varianten von Zeichen, etwa unterschiedliche Versionen von Akzentbuchstaben oder Ligaturen. Manche Unicode-Zeichen können ähnlich aussehen, aber unterschiedliche Bedeutungen oder Codes besitzen, was zu Verwechslungen führen kann.

Die richtige Normalisierung von Unicode-Zeichen ist in diesem Zusammenhang essentiell, wird aber nicht immer einheitlich durchgeführt. Neben technischen Schwierigkeiten sind es oft auch Design-Entscheidungen im Bereich des Unicode-Standards, die Diskussionen auslösen. Der Unicode-Konsortium bemüht sich, ursprünglich vorkommende Zeichen aufzunehmen und ständig zu erweitern, was einerseits den Zeichenvorrat stetig an Reichhaltigkeit wachsen lässt. Andererseits führt dies zu einer enormen Komplexität der Spezifikation und erschwert Entwicklern die Integration in Software-Produkte. Die Herausforderung liegt darin, neue Zeichen sinnvoll zu ergänzen ohne die Kompatibilität zu gefährden oder bestehende Implementierungen zu überfordern.

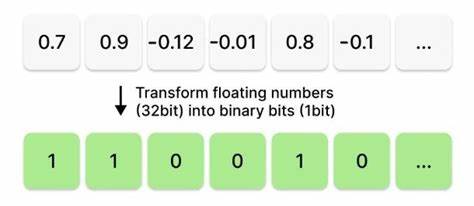

Ein bedeutender Fortschritt war die Fertigstellung der Unicode-Versionen mit der Aufnahme von Zeichen wie Emojis, die heutzutage nicht mehr aus der digitalen Kommunikation wegzudenken sind. Emojis haben Unicode zu einer Art Medium für emotionalen Ausdruck gemacht und die Nutzung von Unicode weit über die rein sprachliche Darstellung hinaus erweitert. Jedoch zeigen auch Emojis die Grenzen des Standards auf, da kulturelle Bedeutungen, Geschlecht oder ethnische Diversität in den Zeichen interpretiert und angepasst werden müssen, was immer wieder Anpassungen und Debatten auslöst. Auf technischer Ebene gibt es zudem Herausforderungen bei der Verarbeitung von Unicode in Programmiersprachen und Datenbanken. Der Umgang mit mehrbyteigen Zeichen, unterschiedliche Kodierungen wie UTF-8, UTF-16 oder UTF-32, sowie die richtige Behandlung von Zeichengrenzen sind typische Problemfelder.

Fehlerhafte Implementierungen können zu Datenverlust, fehlerhafter Anzeige oder Sicherheitslücken führen. Daher ist es wichtig, dass Entwickler sich intensiv mit Unicode-Standards auseinandersetzen und bewährte Praktiken einsetzen, um Kompatibilität und Sicherheit zu gewährleisten. Die Popularität von Unicode hat auch Auswirkungen auf die Internationalisierung und Lokalisierung von Software. Unicode ermöglicht es, Anwendungen nutzerfreundlich für Menschen mit verschiedensten sprachlichen Hintergründen zu gestalten. Dies steigert die Benutzerzufriedenheit und öffnet Märkte.

Gleichzeitig erfordert die Nutzung von Unicode neben der reinen Zeichendarstellung auch den Umgang mit kulturellen Konventionen wie Datum- und Zeitformaten, Sortierreihenfolgen und anderen sprach- und regionenspezifischen Faktoren. In der Open-Source- und Entwickler-Community werden die Vor- und Nachteile von Unicode ausführlich diskutiert. So gibt es Veranstaltungsformate wie die OSCON-Konferenz, auf der Experten wie Tom Christiansen in Vorträgen und Workshops praktische Einblicke zum Thema Unicode anbieten. Solche Veranstaltungen helfen, die technische Komplexität zu durchdringen und das Verständnis zu vertiefen. Zusammenfassend lässt sich sagen, dass Unicode zweifellos ein Meilenstein der digitalen Technologie darstellt.

Seine universellen Prinzipien erlauben eine nie dagewesene Verständigung über Sprach- und Schriftsystemgrenzen hinweg. Dennoch bleibt die vollständige und fehlerfreie Integration von Unicode eine anspruchsvolle Aufgabe, die von der Softwareentwicklung bis zur Benutzeroberfläche alle Ebenen umfasst. Trotz der vorhandenen Schwierigkeiten ist der Einsatz von Unicode unabdingbar für eine globalisierte digitale Welt. Wer sich mit Unicode auseinandersetzt, erkennt, dass sowohl pädagogische Bemühungen als auch technische Kompetenz wichtig sind, um das volle Potenzial des Standards auszuschöpfen und typische Fallen zu vermeiden. Angesichts der stetig wachsenden Anforderungen wird die Weiterentwicklung von Unicode und seiner supportenden Systeme auch zukünftig von großer Bedeutung sein.

Die Junior- bis Senior-Entwickler, Systemadministratoren und Infrastruktur-Spezialisten sind daher gut beraten, sich in diesem Bereich kontinuierlich fortzubilden und auf dem Laufenden zu bleiben. Die Zukunft von Unicode sieht vielversprechend aus, nicht zuletzt dank engagierter Gemeinschaften und Experten, die daran arbeiten, das Gute zu bewahren, das Schlechte zu mitigieren und das Hässliche zu eliminieren.