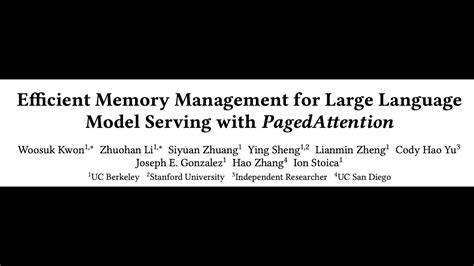

Große Sprachmodelle wie GPT, BERT oder andere Transformer-basierte Systeme dominieren mittlerweile zahlreiche Anwendungen in der Künstlichen Intelligenz, von Chatbots über Übersetzungsdienste bis hin zu komplexer Textgenerierung. Die enorme Leistungsfähigkeit dieser Modelle kommt jedoch mit einem massiven Bedarf an Rechenleistung und insbesondere an Speicherbedarf, der bisher eine der größten Hürden bei der praktischen Verwendung darstellt. Effizientes Speichermanagement ist deswegen eine Schlüsselanforderung, um den Einsatz großer Sprachmodelle skalierbarer, ressourcenschonender und insgesamt wirtschaftlicher zu gestalten. Ein vielversprechender Ansatz ist hier das Konzept der PagedAttention, das eine echte Innovation in der Verarbeitung von Schlüssel-Werte-Caches bei der Modellinferenz darstellt.Sprachmodelle nutzen ein sogenanntes Key-Value-Cache (KV-Cache), um Aufmerksamkeitsscores innerhalb von Sequenzen effizient zu speichern und wiederzuverwenden.

Dieser Cache wächst dynamisch mit der Länge der verarbeiteten Eingabesequenzen, was vor allem bei der Bearbeitung langer Texte oder komplexer Anfragen zu einem erheblichen und teilweise ineffizienten Speicherverbrauch führt. Traditionelle Systeme stoßen hier schnell an ihre Grenzen, da der Speicher stark fragmentiert wird und sich redundante Duplikate bilden. Das schränkt nicht nur die maximale Batch-Größe ein, sondern führt auch zu unnötiger Verschwendung von teurem Grafikprozessor-RAM (GPU-RAM).PagedAttention knüpft an ein bewährtes Konzept aus der Informatik an: Virtueller Speicher und Paging, wie es in Betriebssystemen für die Speicherverwaltung genutzt wird. Die Idee dahinter ist, die Aufmerksamkeitsschichten im Modell so zu gestalten, dass das Speichern und Abrufen der Schlüssel-Werte-Daten segmentiert und effizient getaktet geschehen kann.

Dadurch können Speicherfragmente minimiert und die Auslastung des verfügbaren Speichers optimiert werden. Das ist vergleichbar mit Seiten im Betriebssystem, die nur bei Bedarf geladen und wieder freigegeben werden. Auf diese Weise werden nur die tatsächlich benötigten Daten im schnellen Speicher gehalten, während andere Teile temporär ausgelagert oder intelligent geteilt werden.Die praktische Umsetzung dieser Idee wurde mit dem LLM-Serving Framework vLLM realisiert. vLLM betreibt das PagedAttention-Verfahren und ermöglicht dadurch nahezu verschwendungsfreie Verwendung des Key-Value-Caches.

Zudem erlaubt es eine flexible gemeinsame Nutzung des Speichers über mehrere simultan laufende Anfragen hinweg. Das spart nochmals eine erhebliche Menge an Ressourcen und erlaubt viel größere Batchgrößen, was die Durchsatzrate massiv steigert, ohne dass sich dies negativ auf die Latenzzeiten auswirkt. Besonders bei längeren Eingabesequenzen, größeren Modellen und komplexeren Dekodierungsalgorithmen zeigen sich die Vorteile besonders deutlich.Für Entwickler und Unternehmen, die auf Transformer-basierte Sprachmodelle setzen, ist das ein kultureller Wandel und ein technologischer Fortschritt zugleich. Statt sich durch begrenzte Hardware-Ressourcen ausbremsen zu lassen, kann man dank PagedAttention und vLLM eine viel effizientere Nutzung vorhandener GPUs erreichen.

Das setzt neue Maßstäbe beim Betrieb von Sprachmodellen in produktiven Umgebungen, etwa in Cloud-Anwendungen, bei SaaS-Produkten oder in datenintensiven Forschungsprojekten. Die Kosten für die Infrastruktur lassen sich spürbar reduzieren, gleichzeitig steigt die Performance und Skalierbarkeit.Die im Rahmen des PagedAttention-Ansatzes erzielte Memory-Effizienz ist aber nicht nur für das reine Serving von Modellen relevant. Auch in der Forschung, etwa beim Training oder der Feinabstimmung großer Sprachmodelle, öffnet sich ein neues Spektrum an Möglichkeiten. Die Fähigkeit, große Kontexte und längere Textabschnitte effizient zu verarbeiten, ist entscheidend, um Modelle besser zu machen und neue Einsatzfälle zu erschließen.

So lässt sich auch die Komplexität anspruchsvoller Aufgaben bewältigen, ohne dass der Speicherbedarf linear explodiert.Hinzu kommt, dass die zugrundeliegende Software von vLLM Open Source ist, was den Zugang zu dieser Innovation erleichtert und eine breite Verbreitung fördert. Die Community kann somit nicht nur von den Performance-Gewinnen profitieren, sondern auch aktiv zur Weiterentwicklung und Anpassung beitragen. Das ermöglicht eine schnelle Integration in verschiedenste Anwendungen und Systeme, von der Cloud bis zum Edge Computing.Zusammenfassend ist PagedAttention ein Meilenstein in der Entwicklung effizienter Speicherverwaltungsstrategien für große Sprachmodelle.

Es verbindet bewährte Konzepte aus der Betriebssystemtheorie mit hochmodernen Deep-Learning-Technologien und löst somit ein grundlegend praktisches Problem in der KI-Praxis. Die dadurch erzielte Erhöhung der Batchgröße und gleichzeitige Reduktion von Speicherfragmentierung stellen einen Wettbewerbsvorteil dar, der sowohl Kosteneinsparungen als auch eine höhere Nutzerzufriedenheit ermöglicht.Die Zukunft großer Sprachmodelle wird maßgeblich von solchen technologischen Innovationen geprägt sein, die es erlauben, die enormen Ressourcenanforderungen besser zu beherrschen und effizienter zu nutzen. PagedAttention und vLLM zeigen, wie durch intelligentes Speichermanagement und systemübergreifende Denkweisen große Fortschritte erzielt werden können. Entwickler, Betreiber und Anwender von KI-Systemen sollten diese Wege daher mit Aufmerksamkeit verfolgen und in ihre Infrastruktur investieren – um das volle Potenzial der künstlichen Intelligenz auch in Zukunft nutzbar zu machen.

Große Sprachmodelle werden sich so nicht nur als Werkzeuge der Wissenschaft, Wirtschaft und Gesellschaft etablieren, sondern auch nachhaltig und ressourcenschonend betrieben werden können.