Large Language Models (LLMs) gehören heute zu den wichtigsten Technologien im Bereich der Künstlichen Intelligenz. Sie bieten beeindruckende Fähigkeiten, komplexe Texte zu verstehen, Inhalte zu generieren und komplexe Aufgaben zu bewältigen. Doch trotz ihres Potenzials stoßen LLMs oft an Grenzen, wenn es darum geht, praktikable Lösungen für spezifische Anforderungen oder Funktionen außerhalb von rein sprachbasierten Antworten bereitzustellen. Genau hier setzt das kürzlich mit Version 0.26 erschienene LLM CLI Tool an und bringt eine bahnbrechende Neuerung mit sich: die Unterstützung für das Ausführen von Tools direkt aus dem Terminal, basierend auf Python-Code oder Plugins.

Diese Innovation eröffnet völlig neue Wege, wie Entwickler und Nutzer mit LLMs interagieren können und erweitert die Anwendungsvielfalt enorm. Die Integration von Werkzeugen ist ein entscheidender Schritt, um die Fähigkeiten von LLMs zu erweitern. Anstatt ausschließlich auf die textliche Verarbeitung fokussiert zu sein, kann das LLM CLI Tool nun Python-Funktionen und Plugins als Werkzeuge einbinden, die das Modell bei der Lösung von Aufgaben unterstützen. Dies bedeutet konkret, dass jede Funktion, die als Python-Code vorliegt, in den Ablauf des Modells eingehängt und vom LLM genutzt werden kann, um Berechnungen anzustellen, Daten abzufragen oder interaktive Aufgaben zu erfüllen. Ein großer Vorteil dieses Tools ist seine universelle Kompatibilität mit gängigen LLM-Anbietern wie OpenAI, Anthropic und Google Gemini.

Sogar lokale Modelle lassen sich dank der Integration mit Ollama nahtlos einbinden. Dieses breite Support-Spektrum ermöglicht es Entwicklern, flexibel und herstellerübergreifend zu arbeiten. Der Zugriff auf Werkzeuge erfolgt im CLI mittels einfacher Kommandozeilenoptionen wie --tool oder der Kurzform -T, mit denen einzelne Funktionen oder ganze Plugins aktiviert werden können. Zusätzlich gibt es die --functions Option, die es erlaubt, Python-Funktionen direkt über den CLI einzugeben und so spontan neue Werkzeuge bereitzustellen. Eine weiterer wesentlicher Fortschritt ist die Unterstützung von asynchronen und synchronen Kontexten, was die Performance und Effizienz bei der Ausführung mehrerer Tools gleichzeitig verbessert.

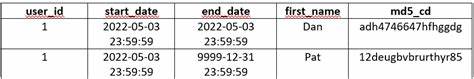

So lassen sich verschiedene Aufgaben parallel bearbeiten, was gerade bei komplexen Datenabfragen oder umfangreichen Berechnungen von großem Vorteil ist. Was macht das LLM CLI Tool darüber hinaus aus? Die Integration von Plugins als Erweiterungen gestaltet sich spielerisch einfach. Entwickler können eigene Tool-Plugins schreiben oder aus einer stetig wachsenden Sammlung installieren und damit die Funktionalität ihrer LLM-Umgebung passend zu ihren Anforderungen erweitern. Beispielsweise gibt es Plugins, die mathematische Berechnungen ermöglichen, wie das simpleeval Plugin, das Python-Ausdrücke sicher und effizient ausführt, oder QuickJS für die Ausführung von JavaScript Code im Sandbox-Umfeld. Besonders spannend ist auch das Datasette-Plugin, mit dem Anwender SQL-Abfragen gegen entfernte Datasette-Datenbanken absetzen und daraus verwertbare Informationen gewinnen können.

Ein praktisches Anwendungsbeispiel fällt sofort ins Auge: Mathematik gilt als Schwachstelle vieler LLMs, denn selbst einfache Multiplikationen großer Zahlen können fehlerhaft beantwortet werden. Mit Tools wie simpleeval kann das LLM CLI diese Lücke elegant schließen. Das Plug-in evaluiert Ausdrücke innerhalb eines sicheren Sandboxes und liefert robuste, zuverlässige Ergebnisse zurück, die das Modell direkt nutzen kann. Das Ergebnis ist eine deutlich gesteigerte Genauigkeit und Robustheit bei der Bearbeitung mathematischer Fragestellungen. Die Nutzungsmöglichkeiten wachsen zudem mit der Fähigkeit, ad-hoc Python-Funktionen direkt per CLI einzubinden.

So kann beispielsweise ein Entwickler innerhalb weniger Zeilen Code eine Suchfunktion implementieren, die eine Website oder einen Blog durchsucht. Ein solcher Workflow ermöglicht extrem flexible und maßgeschneiderte Anwendungen, ohne dass lange Plugin-Entwicklungen notwendig wären. Auch hier spielt die verbesserte Token-Verarbeitung der neuen GPT-4.1-Modelle eine Schlüsselrolle, da sie komplexe und umfangreiche Eingaben wie HTML-Inhalte wesentlich besser verarbeiten können. Die Python-API des LLM Tools ist ebenfalls stark erweitert worden und unterstützt nun die Verwendung von Tools in Ketten.

Mit der neuen chain()-Methode können LLMs Tool-Aufrufe erkennen, diese ausführen und basierend auf den Ergebnissen weiterfragen oder handeln. Dies ermöglicht eine Art automatisierten Dialog mit eingebetteten Funktionen, wodurch komplexe Workflows und Problemlösungen ohne externes Eingreifen ablaufen können. Besonders für Entwickler ist das ein bedeutender Fortschritt, da so eine programmatische Steuerung und Erweiterung von LLMs einfacher und effizienter möglich wird. Wichtig zu erwähnen ist auch, dass die Community rund um das LLM CLI aktiv Plugins entwickelt und neue Features vorantreibt. Die Einführung eines cookiecutter Templates für Tool-Plugins erleichtert die Entwicklung eigener Erweiterungen und fördert die Verbreitung neuer Tools.

Zudem arbeitet das Entwicklerteam an einer Integration des emerging Model Context Protocols (MCP), das zukünftig eine standardisierte und herstellerübergreifende Schnittstelle für Toolzugriffe innerhalb von LLMs schaffen soll. Diese Entwicklung wird die Verbindung zwischen Modellen und externen Tools weiter vereinfachen und automatisieren. Von der Perspektive eines Anwenders betrachtet, ist der Nutzen enorm. Die Fähigkeit, Werkzeuge direkt im Terminal oder in Python-Skripten ausführen zu lassen, macht die Interaktion mit LLMs weitaus produktiver und vielseitiger. Die Barrieren zwischen Spracheingabe und programmgesteuerter Funktionalität verschwinden immer mehr, was eine neue Generation intelligenter Systeme hervorbringt, die deutlich leistungsfähiger und anpassungsfähiger sind.

Darüber hinaus ist die Technologie nicht nur für Entwickler interessant, sondern eröffnet auch für Nicht-Programmierer neue Möglichkeiten, indem sie über Plug-and-Play-Plugins erweiterte Funktionalitäten nutzen können. Zum Beispiel kann ein Datenjournalist mit dem Datasette-Plugin Abfragen gegen umfangreiche Open-Data-Datenbanken stellen, ohne SQL selbst schreiben zu müssen. Ein kleines Team in einer Redaktion kann so Forschung und Analyse einfacher und schneller durchführen. Die Tatsache, dass lokale Modelle wie Qwen3:4b jetzt auch Tool-Unterstützung bieten und das LLM CLI Tool dabei integriert werden kann, zeigt, dass die Zukunft nicht mehr allein in der Cloud liegt. Anwender können zunehmend flexibel und datenschutzfreundlich mit eigenen Ressourcen arbeiten, während die Modelle trotzdem von der erweiterten Werkzeugnutzung profitieren.

Die Entstehung dieses Features ist kein Zufall, sondern das Ergebnis eines technologischen Trends, der sich seit 2022 abzeichnet. Schon die Idee des sogenannten ReAcT-Patterns, das die Kommunikation zwischen Language Models und externen Tools formalisiert, bildet die Basis für das heutige System. Die Verbindung von Modell-Output mit automatischer Tool-Ausführung ist inzwischen eine Standardfunktion vieler großer Anbieter geworden und wird von zahlreichen Forschungsteams weiter optimiert. Zusammengefasst zeigt das LLM CLI Tool in Version 0.26 eindrucksvoll, wie die Einbindung von Werkzeugen und Plugins LLMs auf ein neues Nutzungsniveau hebt.

Es verbindet die Flexibilität von Python-Funktionen mit der Leistungsfähigkeit moderner Sprachmodelle und schafft so eine effektive Brücke zwischen natürlicher Sprachverarbeitung und programmatischer Funktionalität. Wer sich mit Künstlicher Intelligenz und ihren praktischen Anwendungen beschäftigt, sollte diese Entwicklung genau beobachten. Die Zukunft von LLMs liegt in der nahtlosen Integration von Werkzeugen, die Modelle zu aktiven Partnern im kreativen und analytischen Prozess machen. Mit der wachsenden Plugin-Ökonomie, der Unterstützung verschiedener Anbieter und der ständig steigenden Leistungsfähigkeit der Modelle ist das Potenzial riesig. Jedes Projekt, das diese Technologie einsetzt, gewinnt nicht nur an Effektivität, sondern auch an Innovationsfähigkeit.

Damit stellt das LLM CLI Tool nicht nur eine interessante technische Neuerung dar, sondern einen Meilenstein für die gesamte KI-Community. Es ebnet den Weg für neuartige und tiefgreifende Anwendungen, bei denen Sprachverständnis und Toolausführung Hand in Hand gehen. Es bleibt spannend, wie sich diese Technologie weiterentwickelt und welche kreativen Lösungen die Entwicklergemeinschaft daraus schöpfen wird.