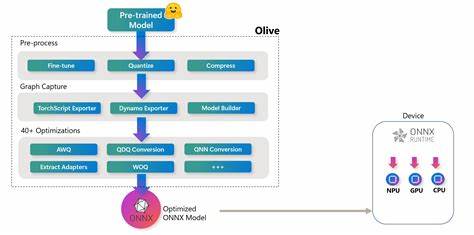

Künstliche Intelligenz (KI) revolutioniert zahlreiche Branchen, von Medizin über Finanzen bis hin zu autonomen Fahrzeugen. Um die Leistung von KI-Modellen in Produktivumgebungen zu steigern und gleichzeitig Ressourcen effizient zu nutzen, sind Optimierungsstrategien unerlässlich. Olive hat sich als leistungsfähiges Toolkit etabliert, das speziell für die Modelloptimierung innerhalb des ONNX Runtime-Ökosystems entwickelt wurde. Es bietet Entwicklern eine praktische und flexible Lösung, um KI-Modelle zu beschleunigen, zu verkleinern und so für reale Anwendungen besser nutzbar zu machen. Olive zielt darauf ab, das volle Potenzial von vortrainierten KI-Modellen auszuschöpfen, indem es diverse Optimierungstechniken automatisiert und vereinfacht anbietet.

Dies ist vor allem in Zeiten wichtig, in denen die Nachfrage nach schnelleren, effizienteren und kostengünstigeren KI-Anwendungen rasant wächst. Das Toolkit unterstützt verschiedene Optimierungsverfahren, darunter Quantisierung, Pruning, Modellkonvertierung und weitere Techniken, die gezielt Performance-Verbesserungen bei minimalem Genauigkeitsverlust erreichen. Die enge Integration von Olive mit ONNX Runtime stellt sicher, dass optimierte Modelle auf verschiedensten Plattformen ausgeführt werden können – von Edge-Geräten bis hin zu leistungsstarken Servern in der Cloud. ONNX Runtime als Framework bietet dabei nicht nur eine breite Kompatibilität mit unterschiedlichen Hardwarearchitekturen, sondern auch eine stabile und erprobte Ausführungsumgebung für KI-Modelle. Olive erweitert dieses Ökosystem also um den wichtigen Aspekt der Modelloptimierung und macht den Einsatz von KI in der Praxis nachhaltiger und effizienter.

Der Einstieg mit Olive gestaltet sich unkompliziert. Mit wenigen Befehlen lässt sich das Python-Paket installieren und erste Workflows starten. Die zugrunde liegende Architektur ist modular aufgebaut, sodass Anwender individuelle Optimierungsschritte flexibel kombinieren können. Darüber hinaus ermöglicht Olive auch die Orchestrierung komplexerer Workflows, in denen mehrere Optimierungsmethoden nacheinander angewendet werden. Dies eröffnet vielfältige Möglichkeiten, Modelle maßgeschneidert an spezifische Anforderungen anzupassen.

Quantisierung ist eine der zentralen Funktionen, die Olive bietet. Dabei werden hochpräzise Gleitkommadarstellungen von Modellen in weniger präzise, aber schnellere und ressourcenschonendere Darstellungen wie INT8 umgewandelt. Diese Technik führt oft zu erheblichen Beschleunigungen und Einsparungen beim Speicher- und Energieverbrauch, was besonders in mobilen und eingebetteten Systemen von großem Vorteil ist. Olive erleichtert diesen Prozess und stellt sicher, dass die Modelle nach der Quantisierung weiterhin eine hohe Genauigkeit aufweisen. Neben Quantisierung umfasst Olive auch Funktionen zum sogenannten Modell-Pruning, bei dem nicht essenzielle Teile des neuronalen Netzwerks entfernt werden, um die Größe zu reduzieren und latente Berechnungsschritte zu minimieren.

Durch geschicktes Pruning bleibt die Leistung des Modells erhalten, während die Ausführungsgeschwindigkeit steigt und der Speicherbedarf sinkt. Diese Methode ist besonders hilfreich bei ressourcenbegrenzten Einsatzgebieten. Modelle lassen sich mit Olive zudem problemlos in verschiedene Formate konvertieren und für spezifische Hardwarearchitekturen bereitstellen. Dies vereinfacht die Integration in bestehende Systeme und beschleunigt Entwicklungszyklus sowie Testprozesse. Die Unterstützung gängiger Frameworks und Plattformen sorgt dafür, dass Entwickler flexibel bleiben und ihre Modelle optimal auf die jeweils verwendete Infrastruktur ausrichten können.

Ein weiteres Highlight von Olive ist die Möglichkeit, Workflows auf entfernten Rechenressourcen auszuführen, beispielsweise in Cloud-Umgebungen wie Microsoft Azure AI. Diese Fähigkeit eröffnet spannende Perspektiven für Teams, die skalierbare Optimierungsprozesse implementieren möchten, ohne ihre lokale Infrastruktur zu überlasten. Durch die Auslagerung auf externe Rechenressourcen lassen sich zeitaufwendige Optimierungen effizient parallelisieren und beschleunigen. Neben den technischen Möglichkeiten überzeugt Olive auch durch ein benutzerfreundliches, dokumentiertes und gut gepflegtes Softwarepaket. Entwickler haben Zugriff auf umfangreiche Tutorials, Beispiele und Referenzmaterialien, die den Umgang mit dem Toolkit erleichtern.

Zudem ist Olive Open Source und wird kontinuierlich durch die Community und das Entwicklerteam weiterentwickelt. Dadurch profitiert die Anwenderschaft von stetigen Verbesserungen und einer lebendigen Kollaboration im Bereich KI-Modelloptimierung. Nicht zuletzt ist Olive so konzipiert, dass Nutzer eigene Optimierungsmethoden implementieren und in das Framework integrieren können. Diese Erweiterbarkeit macht das Toolkit zukunftssicher und unterstützt individuelle Forschungs- oder Projektanforderungen. Entwickler haben dadurch die Freiheit, Olive an innovative Methoden und neue Herausforderungen anzupassen, ohne auf proprietäre Lösungen angewiesen zu sein.

Durch die Kombination aus modularer Struktur, leistungsfähigen Optimierungsfunktionen und nahtloser Integration in ONNX Runtime liefert Olive eine überzeugende Lösung für aktuelle Herausforderungen der KI-Modellentwicklung. Es hilft, Modelle so zu gestalten, dass sie sowohl auf modernen Servern als auch auf Low-Power-Geräten performant laufen. Das erhöht die Einsatzmöglichkeiten von KI-Anwendungen nachhaltig und fördert die Verbreitung intelligenter Technologien in unterschiedlichsten Branchen. Zusammenfassend ist Olive ein unverzichtbares Werkzeug für Entwickler und Unternehmen, die auf der Suche nach effizienten Wegen sind, KI-Modelle zu optimieren. Die einfache Installation, umfangreiche Funktionalität und Offenheit für Erweiterungen machen das Toolkit besonders attraktiv.

Mit Olive lassen sich Kosten senken, Rechenzeiten verkürzen und die Benutzererfahrung durch schnellere Antwortzeiten verbessern. Die Zukunft von KI-Anwendungen hängt maßgeblich davon ab, wie gut es gelingt, Modelle für verschiedene Plattformen zu optimieren und leistungsfähig bereitzustellen. Olive leistet hierbei einen entscheidenden Beitrag und ermöglicht es, das volle Potenzial von ONNX-basierten Modellen auszuschöpfen. Wer im Bereich der KI-Entwicklung aktiv ist, sollte Olive deshalb als wertvolles Werkzeug in seinem Technologie-Stack einplanen und die vielfältigen Vorteile nutzen, die das Toolkit bietet.