Künstliche Intelligenz hat in den letzten Jahren enormes Potenzial bewiesen, insbesondere im Bereich der natürlichen Sprachverarbeitung. Eine der aktuell spannendsten Entwicklungen ist die Integration von leistungsfähigen Sprachmodellen mit Retrieval-Augmented Generation (RAG), wodurch KI-Systeme nicht nur aktuelle Informationen aus großen Datenbanken abrufen, sondern auch kontextuell relevante und präzise Antworten generieren können. Das jüngste Beispiel für diesen Fortschritt ist der neue RAG-Chatbot auf Basis des Qwen3-Modells von Alibaba, kombiniert mit einer innovativen, benutzerfreundlichen Denk-UI, die den Nutzer am inneren Prozess der KI teilhaben lässt. Das Qwen3-Modell gilt als eines der leistungsstärksten Sprachmodelle auf dem Markt, speziell entwickelt für anspruchsvolle Anwendungen wie Programmierung, Mathematik und komplexes logisches Denken. Durch seine enorme Kapazität und das Training auf einer Vielzahl von Datenquellen kann Qwen3 nicht nur komplexe Fragen beantworten, sondern auch auf spezialisierte Informationssammlungen zugreifen, wenn es in einer RAG-Architektur eingebettet wird.

Die Idee hinter Retrieval-Augmented Generation ist simpel, aber effektiv: Das Modell kombiniert sein generatives Sprachwissen mit externen, aktuellen und kontextrelevanten Informationen, die es dynamisch abruft. So entsteht eine hybride Anwendung, die sowohl tiefes Verständnis als auch Aktualität garantiert. Der Entwickler Arindam1729 hat diesen Ansatz im Rahmen eines Projekts umgesetzt, bei dem das Qwen3-Modell mit LlamaIndex als RAG-Framework verbunden wurde. LlamaIndex dient dabei als Vermittler, um Dokumente in Form eines Vektor-Speichers abzulegen und bei Anfragen rasch passende Textpassagen zu einem Thema zu finden. Diese werden dann dem Sprachmodell zur Interpretation und textlichen Ausformulierung übergeben.

Das besondere an Arindams Implementation ist die Integration einer speziell entwickelten Benutzeroberfläche mit Streamlit, welche die inneren Denkprozesse des Modells sichtbar macht. Ein häufig auftretendes Verhalten von Ausgaben großer Sprachmodelle, darunter auch Qwen3, sind sogenannte Think-Tags, die definierte Denkabschnitte innerhalb der Antwort markieren. Diese werden normalerweise versteckt oder komplett entfernt, was jedoch den Vorteil einer gewissen Nachvollziehbarkeit der Antwort reduziert. Anstatt die internen Gedankengänge wegzulassen, zeigt Arindams Interface diese transparent dem Nutzer. Die UI gliedert sich klar und übersichtlich: Eingabe, Ausgabe und der Denkprozess werden getrennt dargestellt.

Dies erhöht nicht nur das Vertrauen in die generierte Antwort, sondern unterstützt auch Entwickler dabei, besser zu verstehen, wie das Modell auf eine Anfrage reagiert und warum es eine bestimmte Lösung gewählt hat. Die technische Grundlage des Projekts besteht aus dem leistungsfähigen Modell Qwen3-235B-A22B, einem der Flaggschiffmodelle von Alibaba, das über Nebius Ai Studio zugänglich ist. Die Dokumente werden mit LlamaIndex zuerst geladen, anschließend transformiert und schließlich in einem Vektor-Index abgelegt, damit sie effizient abgerufen werden können. Dabei ist das System flexibel gehalten und erlaubt den Austausch des verwendeten Vektor-Stores, was Entwicklern freien Spielraum bei der Wahl ihrer Dateninfrastruktur lässt. Die Kombination aus Qwen3 und LlamaIndex im RAG-Setting bringt klare Vorteile für eine Vielzahl von Anwendungsfällen mit sich.

Besonders im Bereich komplexer technischer Unterstützung, Wissensmanagement und interaktiver Chatbots zeigt sich das Potenzial. Die Nutzer profitieren von präzisen und fundierten Antworten, da das Modell nicht nur aus seinem gelernten Weltwissen schöpft, sondern auch aktuelle und externe Dokumente intelligent bezieht und verknüpft. Der modulare Aufbau garantiert zudem die Erweiterbarkeit – neue Modelle, andere Vektor-Stores oder UI-Elemente können ohne großen Aufwand integriert werden. Neben der technischen Funktionalität kommt der Einsatz von Streamlit als Frontend-Framework hinzu. Streamlit bietet eine einfache, aber effektive Möglichkeit, schnelle Prototypen und Anwendungen mit interaktiver Oberfläche zu erstellen, die sowohl für Entwickler als auch für Endanwender leicht verständlich sind.

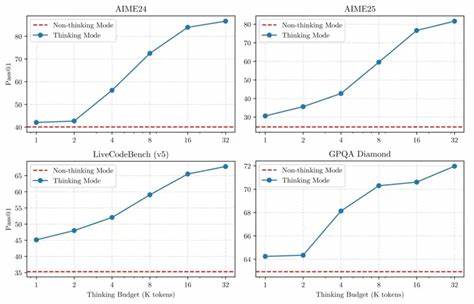

Gerade die Visualisierung der Denkabschnitte mittels spezieller UI-Blöcke vermittelt ein tieferes Verständnis und eine neue Art der Interaktion mit der KI. Diese Transparenz ist besonders bei Anwendungen wichtig, die auf Vertrauen und Nachvollziehbarkeit angewiesen sind. Erfahrungen aus der Community zeigen, dass Qwen3 aufgrund seiner Geschwindigkeit, Konsistenz und herausragenden Leistungsfähigkeit im Bereich der reasoning tasks hohe Anerkennung genießt. Die Kombination mit RAG-Frameworks wie LlamaIndex begegnet ebenso Herausforderungen wie zum Beispiel der Handhabung ungewöhnlicher Model-Ausgaben (etwa der Think-Tags), führt aber insgesamt zu einer bedeutenden Verbesserung im Umgang mit komplexen Anfragen. Nutzer berichten, dass durch das Sichtbarmachen der internen Denkwege auch Fehler und Schwächen besser nachvollzogen und somit optimiert werden können.

Die Open-Source-Verfügbarkeit des Projektes lädt Entwickler ein, eigene Ideen zu verwirklichen, indem sie die modulare Struktur an ihre individuellen Bedürfnisse anpassen. Dies bringt die Chance mit sich, dass künftig weitere Innovationen beim Thema KI-gestützter Dialogsysteme entstehen und neue Horizont erschließen. Von der individuellen Fachberatung bis hin zu automatisierten Support-Lösungen ergibt sich ein breit gefächertes Einsatzspektrum. Darüber hinaus ist die Lernkurve für Interessierte relativ niedrig gehalten, was die praktische Umsetzung angeht. Streamlit ermöglicht mit wenigen Zeilen Code eine ansprechende und funktionale Oberfläche, während LlamaIndex den komplexen Umgang mit Vektorspeichern und Dokumentenabfragen abstrahiert.