Die Welt der Geospatialen Indexierung ist grundlegend für moderne Anwendungen, die mit räumlichen Daten arbeiten – von Navigation über Stadtplanung bis hin zu Umweltmonitoring. In dieser komplexen Landschaft hat sich eine bemerkenswerte Methode herauskristallisiert, die trotz ihrer Entstehung bereits in den 1960er und 1980er Jahren heute noch als leuchtendes Beispiel für effektive Datenorganisation gilt. Diese Methode basiert auf sogenannten Z-Order Kurven, auch bekannt als Morton-Order, und einer cleveren Suchtechnik, die die Nutzung geordneter Punktmengen neu definiert. Die Z-Order Kurve ist ein Raumfüllendes Verfahren, das zweidimensionale Punkte durch das Verweben ihrer Koordinaten in einer eindimensionalen Reihenfolge nummeriert. Ihre Geschichte reicht zurück in die 1960er Jahre, als sie zunächst im Canada Geographic Information System (CGIS) als eine der ersten GIS Technologien Anwendung fand.

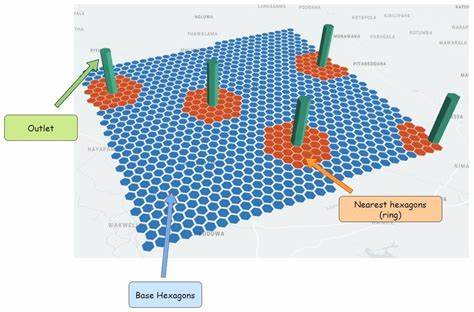

Besonders überraschend ist, dass eigentlich viele GIS-Experten von dieser Methode bisher kaum Kenntnis genommen oder sie unterschätzt haben – ihr Potenzial für effiziente Such- und Indexierverfahren wurde lange Zeit nicht ausreichend gewürdigt. Die Grundidee hinter der Z-Order Methode ist die Umwandlung eines mehrdimensionalen Raumes in eine eindimensionale Reihenfolge, die dabei möglichst nahe Punkte im ursprünglichen Raum auch in der sortierten Reihenfolge nebeneinander anordnet. Dies ähnelt der Funktionsweise von Quadtrees, die Räume rekursiv in vier Bereiche teilen. Im Gegensatz dazu benötigt die Z-Order jedoch keine komplexen Baumstrukturen, da die Sortierung der Datenpunkte anhand ihrer Z-Werte eine implizite Repräsentation der Raumteilung erzeugt. Diese Implizitheit führt zu einem äußerst kompakten und zugleich leistungsfähigen Index, in dem räumliche Suchen zu einfachen Bereichssuchen in einer sortierten Liste von Werten transformiert werden können.

Während andere populäre räumliche Indizes wie R-Trees oder Quadtrees komplexe Verzweigungen und Pflegeaufwände mit sich bringen, gelingt es der Z-Order Methode mit minimalem Verwaltungsaufwand eine performant effiziente Abbildung des Raums bereitzustellen. Ein entscheidender Fortschritt der Z-Order basierten Indizierung ist eine Technik, die als BIGMIN-Suche bekannt ist. Diese wurde in den 1980ern entwickelt, um die Suche innerhalb des Z-Kurven-Wertspektrums so zu optimieren, dass unnötige Datenbereiche, die durch Sprünge in der Z-Kurve entstehen, effizient ausgefiltert werden können. Ohne diese Optimierung würde die Selektion aller Punkte innerhalb einer Bounding Box oft auch viele irrelevante Elemente enthalten, was sowohl Zeit als auch Ressourcen verschwendet. Mit der BIGMIN-Optimierung gelingt es, die Grenzbereiche der Suchregion präzise zu identifizieren und somit mehrere Intervalle von Z-Werten zu bestimmen, die durchsucht werden müssen.

Dieses Verfahren minimiert den sogenannten Overfetch und macht die Indexierung nicht nur theoretisch elegant, sondern auch praktisch leistungsfähig. Neben der technischen Eleganz bietet die Z-Order basierte Indexierung auch praktische Vorteile in Bezug auf Implementierung und Ressourceneffizienz. Die Methode erfordert keine komplexen Datenstrukturen, was vor allem bei großen Datensätzen und performanten Umgebungen von Vorteil ist. Die Daten können in einfachen Arrays sortiert abgelegt werden, und Suchabfragen lassen sich als sequenzielle oder binäre Suchen realisieren. Dies hat den Nebeneffekt, dass bestehende Datenbanken ohne spezielle Erweiterungen eingesetzt werden können, da die Z-Werte einfach als zusätzliche Spalte mitgeführt werden können.

Ein weiterer Pluspunkt ist die natürliche Unterstützung für Parallelisierung. Da Suchanfragen in bestimmten Z-Bereichen abgearbeitet werden, lässt sich die Last auf mehrere Prozesse oder Server aufteilen, ohne dass sich Suchbereiche gegenseitig beeinflussen. In verteilten Umgebungen und Cloud-Architekturen, in denen Daten über verschiedene Knoten verteilt sind, bringt dies erheblichen Performancegewinn. Im direkten Vergleich mit alternativen Raumfüllenden Kurven wie der Hilbert-Kurve zeigen sich interessante Unterschiede. Während die Hilbert-Kurve für eine bessere räumliche Lokalität bekannt ist – das heißt, Punkte, die im Raum nahe beieinander liegen, sind auch in der eindimensionalen Reihenfolge nah – punktet die Z-Order durch ihre einfache Berechnung und die extrem effizienten Bitarithmetik-Operationen.

Insbesondere bei der BIGMIN-Methode liefert die Z-Order unvergleichliche Vorteile, die mit der Hilbert-Kurve schwer realisierbar sind. Die Z-Order Methode ist vor allem für Punkte optimiert. Bei komplexeren Geometrien wie Linienzügen oder Polygonen bietet sie in der Grundform nur begrenzte Einsatzmöglichkeiten. Hier erfordern Anforderungen wie Abdeckungen und Intervallprüfungen andere Herangehensweisen, wie beispielsweise das cell-basierte Indexieren bekannt von Google’s S2-Index. Trotzdem machen die Vorteile der Z-Order Methode sie zu einem wertvollen und sparsamen Werkzeug in vielen Use Cases.

In der Praxis zeigt sich dabei eine unerwartete Synergie mit Graph-basierten Anwendungen, wie Routing-Engines. Wenn beispielsweise Knotenpunkte eines Straßennetzwerks bereits nach ihrem Z-Wert sortiert sind, kann die räumliche Indexierung nahezu kostenlos mitlaufen. Die Sortierung der Knoten stärkt sogar die Effizienz von Algorithmen wie Dijkstra, da die Daten lokal im Speicher organisiert sind und Cache-Effekte begünstigt werden. Aus technischer Perspektive ist die eigentliche Herausforderung in der Z-Order basierten Indexierung nicht das Design der Methode, sondern deren effiziente Umsetzung. In Programmiersprachen mit eingeschränkter Bitmanipulation, wie JavaScript, kann die Berechnung der Z-Werte mit BigInt Typen sehr langsam sein, während in Low-Level Sprachen wie C oder C++ Hardware-Befehle (PDEP/PEXT) eine rasante Bitverschachtelung erlauben.

So liegen Chancen und Herausforderungen eng beieinander, und es gibt beständige Entwicklungen zur Performanceverbesserung, etwa durch den Einsatz von 16-Bit Komprimierung oder emulierten Bitarrays. Unter Geospatial-Entwicklern und Data Scientists beginnt dieser Algorithmus langsam an Bedeutung zu gewinnen. Auch wenn die Methode bereits Jahrzehnte alt ist, wird ihre Wirkung erst jetzt in neueren Tools und Bibliotheken sichtbar, wie der JavaScript-NPM-Bibliothek „zbush“, die eine einfache Variante der Z-Order basierten Punktindizierung und Suche bereitstellt. Dieses neue Interesse entsteht aus der Erkenntnis, dass viele etablierte Indizes mehr Komplexität und Ressourcenverbrauch mit sich bringen, als für bestimmte Szenarien notwendig ist. In der geokodierten Web-Welt gibt es weitere Schnittstellen.

Diskussionen in Foren und auf Plattformen wie Mastodon zeigen, dass Entwickler die Z-Order Methode gerne mit moderner Technologie kombinieren, um performante Anwendungen zu bauen, die mit wenig Overhead auskommen. Beispielsweise ermöglicht die Kombination aus Z-Order Indexierung und relationalen Datenbanken eine elegante Lösung, bei der nur ein einfacher SQL-Befehl mit einem Z-Wert-Bereich erforderlich ist. Abschließend lässt sich festhalten, dass die Z-Order basierte Indexierung ein unterschätzter Schatz der räumlichen Datenverarbeitung ist. Sie bietet eine raffinierte, anpassungsfähige und leichtgewichtige Alternative zu traditionellen Strukturen. Mit steigender Bekanntheit und technischer Weiterentwicklung wird sie aller Wahrscheinlichkeit nach einen festen Platz im Werkzeugkasten moderner Geoinformationssysteme einnehmen und könnte aufgrund ihrer Effizienz und Einfachheit sogar zum neuen Standard werden.

Die Zukunft der Geospatialen Indexierung wird somit nicht nur von konstanten Innovationen durch neue Algorithmen geprägt sein, sondern auch von der Wiedereinführung und Weiterentwicklung bewährter Konzepte aus der Vergangenheit. Das Verständnis und die Anwendung dieser verborgenen Schätze erlaubt es Entwicklern und Forschern, räumliche Daten effizienter zu organisieren, zu durchsuchen und zu analysieren – und so die Herausforderungen in unserer zunehmend digitalisierten und räumlich vernetzten Welt noch besser zu meistern.