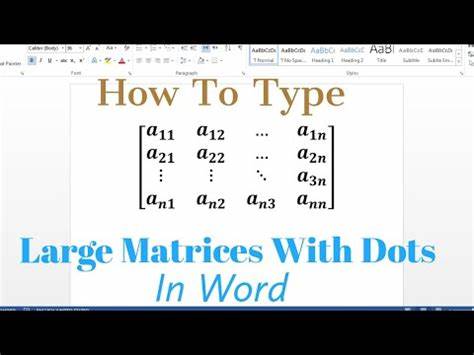

In der heutigen Zeit, in der Daten in nie dagewesener Menge und Komplexität anfallen, stehen Wissenschaftler, Datenanalysten und Ingenieure häufig vor der Herausforderung, mit riesigen Matrizen umzugehen. Diese großen, oft undurchsichtigen Matrizen gelten gemeinhin als schwer handhabbar und problematisch, doch wenn man sie genauer betrachtet, sind sie nicht unbedingt schlechter oder komplexer als viele andere Probleme, auf die Fachleute stoßen. Das Verständnis dieser sogenannten „Giant Inscrutable Matrices“ und deren angemessene Einordnung ist somit von großer Bedeutung, um die Effizienz moderner Datenanalysestrategien zu steigern und Vorurteile gegenüber großen Datenstrukturen abzubauen. Giant Inscrutable Matrices sind prinzipiell große rechteckige oder quadratische Anordnungen von Zahlen oder Datenpunkten, die in vielen Bereichen wie der Statistik, maschinellem Lernen, Physik oder Wirtschaft auftreten. Ihre Größe kann schnell in den Millionen oder Milliarden von Elementen liegen, insbesondere wenn zum Beispiel Bilddaten, genetische Daten oder Netzwerkinformationen verarbeitet werden.

Die Komplexität ergibt sich dabei weniger aus der Struktur selbst, als vielmehr daraus, dass diese Matrizen schwer durchschaubar sind – sprich, deren Interpretation und Handhabung ist alles andere als trivial. Es ist wichtig zu verstehen, dass die bloße Größe oder Undurchsichtigkeit einer Matrix nicht automatisch bedeutet, dass sie schlechter oder schwieriger zu behandeln sei als andere Probleme. Vielmehr müssen dazu verschiedene Faktoren betrachtet werden, wie die Verfügbarkeit von effizienten Algorithmen, die Leistungsfähigkeit moderner Hardware und die Fortschritte in der theoretischen Mathematik. Beispielsweise hat sich der Bereich der numerischen Linearen Algebra in den letzten Jahrzehnten so weiterentwickelt, dass selbst sehr große Matrizen verlässlich und effizient bearbeitet werden können. Methoden wie iterative Verfahren, Approximationstechniken oder Randomisierung erlauben oft eine schnelle und präzise Schätzung von Lösungen, ohne die gesamte Matrix vollständig zu analysieren.

Darüber hinaus hat sich gezeigt, dass viele der riesigen Matrizen, die in realen Anwendungsfällen entstehen, spezielle Strukturen oder Muster aufweisen. Diese können durch niedrig-rangige Approximationen oder sogenannte „sparse“ (dünn besetzte) Darstellungen ausgenutzt werden, um die Komplexität bei der Verarbeitung deutlich zu reduzieren. Somit wird die vermeintliche Undurchsichtigkeit aufgebrochen und praktische Lösungen möglich. Das Verständnis und die Nutzung dieser Muster sind ein wesentlicher Bestandteil moderner Datenwissenschaft und ermöglichen es, große Matrizen effizienter zu verarbeiten und interpretieren. Ein weiterer wichtiger Punkt ist, dass gigantische Matrizen keineswegs eine Alleinstellung im Bereich komplexer datenbasierter Probleme besitzen.

Komplexe Verknüpfungen, hochdimensionale Datenräume oder schwierig interpretierbare Modelle wie neuronale Netze stellen ähnliche Herausforderungen dar. Diese Probleme zeichnen sich ebenfalls durch eine scheinbare Undurchsichtigkeit aus, sind jedoch durch mathematische und algorithmische Fortschritte mittlerweile besser beherrschbar. Oft ist die menschliche Wahrnehmung der Komplexität eines Problems nicht unbedingt mit seiner mathematischen oder algorithmischen Schwierigkeit gleichzusetzen. Riesige Matrizen sind also nicht zwangsläufig schwerer zu verstehen oder zu verwenden als andere schwierige datenbezogene Aufgaben. Auch die Rolle der Hardware darf bei der Betrachtung großer Matrizen nicht vernachlässigt werden.

Mit der Entwicklung von Hochleistungsrechnern, GPUs und spezialisierten Chips wird die Verarbeitung und Analyse sehr großer Matrizen zunehmend erleichtert. Cloud-Computing bietet zudem nahezu unbegrenzte Rechenkapazitäten, die je nach Anforderungen skaliert werden können. All dies führt dazu, dass große Matrizen in der Praxis oftmals effizienter verwaltet werden können, als man auf den ersten Blick vermuten würde. Dieser Paradigmenwechsel trägt dazu bei, die Angst vor großen, unüberschaubaren Datenstrukturen zu reduzieren. Die Implikationen für das maschinelle Lernen sind besonders bedeutend.

Große Matrizen finden sich dort unter anderem in Form von Gewichts- oder Aktivierungsmatrizen innerhalb von tiefen neuronalen Netzen. Trotz der enormen Größe dieser Matrizen funktioniert das Training und die Nutzung der Modelle sehr effektiv. Das belegt eindrucksvoll, dass große Matrizen keineswegs das Hindernis sind, für das sie manchmal gehalten werden. Stattdessen sind sie integraler Bestandteil moderner Technologien mit großem Nutzenpotenzial. Es ist ebenfalls interessant zu betrachten, wie die Forschung im Bereich der Matrixfaktorisierung und Dimensionsreduktion zur besseren Handhabung großer Matrizen beiträgt.

Techniken wie die singuläre Wertzerlegung (SVD), Hauptkomponentenanalyse (PCA) oder nicht-negative Matrixfaktorisierung erlauben es, die wesentlichen Informationen aus einer großen Matrix zu extrahieren und damit deren Komplexität handhabbar zu machen. Solche Methoden werden erfolgreich in verschiedensten Feldern eingesetzt, von Empfehlungssystemen über Bildverarbeitung bis hin zur Bioinformatik. Diese Ansätze belegen, dass undurchsichtige große Matrizen durchaus strukturiert und nutzbar gemacht werden können. Zudem darf nicht vergessen werden, dass viele Probleme und Datenformate so komplex sind, dass eine gewisse Undurchsichtigkeit oder Komplexität nicht vermeidbar ist. Die Einschätzung, dass große Matrizen schlechter oder „schlimmer“ seien als andere Datenstrukturen, stammt oft aus einer Angst vor neuen Technologien oder mangelnder Erfahrung.

Tatsächlich fordern sie genauso viel Kompetenz, creativen Ansatz und Verständnis wie andere große Herausforderungen in der Datenverarbeitung. Abschließend lässt sich festhalten, dass giant inscrutable matrices keine unüberwindbaren Hindernisse, sondern Herausforderungen darstellen, die mit den richtigen Methoden und Technologien gut bewältigt werden können. Ihre Handhabung ist vergleichbar mit jener anderer komplexer Datenstrukturen und -modelle. Das Fortschreiten moderner mathematischer Verfahren, Algorithmenentwicklung und Hardwareverbesserung macht den Umgang mit ihnen heute zugänglicher als je zuvor. Wer sich mit großen Matrizen beschäftigt, ist gut beraten, den Fokus nicht allein auf die schiere Größe oder scheinbare Undurchsichtigkeit zu legen, sondern auf die Möglichkeiten, Strukturen und Werkzeuge, die zur Verfügung stehen.

In vielen Fällen offenbaren sich darin versteckte, verwertbare Informationsebenen, die einen echten Mehrwert schaffen. Deshalb sind große, schwer verständliche Matrizen keinesfalls schlechter als andere komplexe Informationsobjekte – sie sind einfach ein anderer Ausdruck der faszinierenden Vielschichtigkeit der Datenwelt.