Die künstliche Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht. Besonders große Sprachmodelle wie GPT-4 oder Claude haben gezeigt, wie komplexe Aufgaben bewältigt und anspruchsvolle Texte erzeugt werden können. Doch die Zeit, in der KI-Systeme rein reaktiv und auf vorgegebene Abläufe beschränkt waren, neigt sich dem Ende zu. Der nächste große Schritt heißt „selbstbewusste“ oder auch selbstreflektierende KI-Agenten, die nicht nur Aufgaben ausführen, sondern ihre eigene Leistung bewerten, daraus lernen und sich stetig verbessern können. Diese Entwicklung könnte die Art und Weise, wie wir mit Maschinen interagieren und diese in Geschäftsprozesse integrieren, grundlegend verändern.

Selbstbewusste KI-Agenten zeichnen sich vor allem durch ihre Fähigkeit zur Autonomie aus. Anders als klassische Systeme benötigen sie nicht ständig menschliche Eingriffe oder enge Richtlinien, um zu funktionieren. Sie sind in der Lage, eigenständig Entscheidungen zu treffen, Strategien zu überprüfen und entsprechend ihrer Erfahrungen anzupassen. Neben der Autonomie ist die Reflexion von zentraler Bedeutung: Diese Systeme analysieren ihre eigenen Aktionen und deren Ergebnisse, erkennen Fehler oder Schwächen und implementieren Verbesserungen. Die Kombination von Autonomie und Reflexion verleiht KI-Agenten eine gewisse menschliche Intelligenz, insbesondere das Lernen durch Erfahrung.

Der Einsatz großer Sprachmodelle (LLMs) bildet die technische Grundlage für diese neuen agentischen Systeme. LLMs bieten eine bemerkenswerte Flexibilität im Verstehen und Erzeugen natürlicher Sprache, was sie prädestiniert für komplexe Aufgaben wie Recherche, Berichtserstellung oder Dialogführung. Modernes Frameworks und Bibliotheken wie LangGraph, OpenAI-API-Integration oder LlamaIndex ermöglichen es, LLMs mit Gedächtnis- und Reflexionsmechanismen auszustatten. Ein zentraler Bestandteil ist dabei die Retrieval-Augmented Generation (RAG), die sicherstellt, dass das KI-Modell sein Wissen mit aktuellen und themenspezifischen Datenbanken abgleicht und so präzisere und kontextbewusstere Antworten liefern kann. Ein exemplarischer Anwendungsfall für adaptive LLM-Agenten ist der selbstverbessernde Forschungsassistent.

Dieser Agent erhält eine Aufgabe, etwa „Verfasse einen Bericht zu Fusionsenergie“. Er zerlegt diese große Aufgabe in kleinere Teilaufgaben wie Informationsbeschaffung, Zusammenfassung und Qualitätsbewertung. Nach jeder Teilaufgabe reflektiert der Agent seine Ergebnisse kritisch, bewertet deren Qualität und trifft eigenständig die Entscheidung, ob eine Überarbeitung notwendig ist. So durchläuft der Prozess mehrere Iterationen, bis ein zufriedenstellendes Ergebnis erzielt wird. Während dieses Zyklus speichert der Agent alle Zwischenstände und Feedback-Schleifen in einem Speicher, um für zukünftige Aufgaben oder Reflektionen auf relevante Erkenntnisse zurückgreifen zu können.

Technisch gesehen besteht der Aufbau solcher Agenten aus mehreren Komponenten: Zunächst braucht es einen leistungsfähigen LLM, der als Kern für das Verstehen und Generieren von Text dient. Anschließend wird ein Wissensspeicher implementiert, der es dem Agent ermöglicht, kontextspezifische Informationen abzurufen und zu verwenden. Die Planungskomponente zerlegt die Hauptaufgabe in strukturierte Teilziele. Dann folgt die Ausführung der jeweiligen Teilziele im Rahmen vorhandener Ressourcen und Wissensbasis. Der wichtigste neuartige Schritt ist die Reflexion – hier analysiert der Agent seine eigenen Arbeitsergebnisse anhand vorgegebener Kriterien wie Genauigkeit, Vollständigkeit oder Klarheit und trifft auf Grundlage dieses Feedbacks adaptive Entscheidungen für mögliche Verbesserungen.

Abschließend steuert eine Schleife diesen Prozess, bis der Agent die Aufgabe als erledigt akzeptiert. Der Nutzen solcher selbstlernenden und sich anpassenden Systeme ist vielfältig. In der Forschung können sie umfangreiche Literatur sichten, strukturierte Zusammenfassungen erstellen und diese eigenständig verfeinern. Im Kundenservice ermöglichen sie die automatisierte Bearbeitung von Anfragen mit immer besserer Qualität, da der Agent aus vorherigen Interaktionen lernt. Im Rechtswesen oder bei Compliance-Prüfungen können diese Agenten Dokumente analysieren, Risiken identifizieren und Empfehlungen geben, wobei sie Fehler immer weiter minimieren.

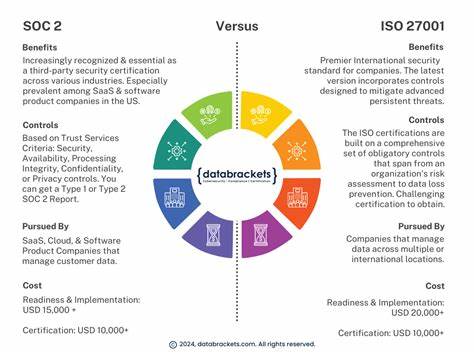

Auch in Bildungsanwendungen können adaptive Agenten personalisierte Lerninhalte erstellen, die sich individuell an den Wissensstand und die Fortschritte der Lernenden anpassen. Neben den technischen Chancen bringen selbstreflektierende KI-Agenten auch neue Herausforderungen mit sich. Die Komplexität der Systeme erfordert eine robuste Architektur, damit Fehler nicht unbemerkt bleiben oder automatische Verbesserungen ungewollte Folgen haben. Ebenso ist die Nachvollziehbarkeit von Entscheidungen essenziell, um Vertrauen aufzubauen und rechtliche Vorgaben zu erfüllen. Hier können Metareflektions-Mechanismen helfen, bei denen ein weiterer Agent die Kohärenz und Konsistenz des Gesamtoutputs überwacht und bewerten kann.

Ebenfalls wichtig sind Mechanismen für menschliches Eingreifen, insbesondere wenn das System Unsicherheiten oder Risiken erkennt. Das Potenzial selbstbewusster, adaptiver KI-Agenten ist groß, weil sie den Weg für eine neue Generation intelligenter Software ebnen, die nicht nur reagiert, sondern wirklich versteht und sich entwickelt. Innovationskraft und Produktivität werden steigen, da sich zeitaufwendige manuelle Prüfungen und Anpassungen reduzieren lassen. Unternehmen profitieren von skalierbaren Lösungen, die sich flexibel an dynamische Anforderungen anpassen. Gleichzeitig wird die Rolle des Menschen am Arbeitsplatz immer mehr zur Überwachung, Steuerung und kreativen Ergänzung dieser intelligenten Systeme.

Um mit der Entwicklung solcher Systeme zu starten, empfehlen sich kleine, iterative Projekte mit klar definierten Zielen und regelmäßigem Monitoring der Reflexionsprozesse. Das Einbinden von Frameworks wie LangGraph zur strukturierten Aufgabenverwaltung und LlamaIndex für den kontextbezogenen Wissenszugriff ermöglicht effiziente Implementierungen. Zudem sollte die Auswahl eines leistungsfähigen LLM erfolgen, dessen Eigenschaften zu den jeweiligen Anforderungen passen. Wichtig ist auch der Aufbau eines nachhaltigen Feedback-Cycles, um kontinuierliche Verbesserungen zu gewährleisten. Der Trend zu agentischen, selbstadaptiven KI-Systemen wird zukünftig viele Bereiche unseres Lebens durchdringen.

Bereits heute entstehen Anwendungen, die weit über traditionelle Regelstrom- oder regelbasierte Programmierung hinausgehen und echtes Lernverhalten an den Tag legen. Je weiter die Forschung voranschreitet und die Integration von Tools, Wissensspeichern und selbstreflektierenden Mechanismen verfeinert wird, desto leistungsfähiger und autonomer werden diese Agenten. Sie tragen dazu bei, die wachsenden Herausforderungen der Digitalisierung zu meistern und neue Erkenntnisse in kurzer Zeit zu generieren. Zusammenfassend steht die Entwicklung selbstbewusster KI-Agenten für eine neue Phase der künstlichen Intelligenz, die auf autonomer Entscheidungsfindung, innerer Selbstbeurteilung und stetiger Optimierung basiert. Diese innovativen Systeme verändern grundlegend, wie Maschinen mit komplexen Aufgaben umgehen, sich an neue Situationen anpassen und mit Menschen zusammenarbeiten.

Für Unternehmen und Entwickler eröffnen sich damit spannende Möglichkeiten, intelligente Lösungen zu bauen, die nachhaltig, skalierbar und hochgradig anpassbar sind. Wer frühzeitig auf diese Technologie setzt, kann den Innovationsvorsprung sichern und die Weichen für die Zukunft der KI-gesteuerten Automatisierung stellen.