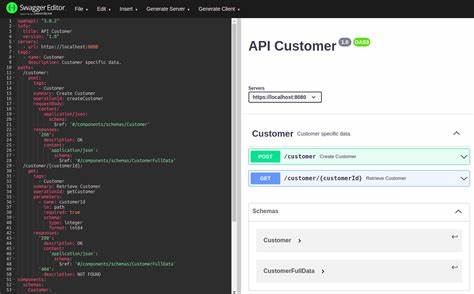

Die rasante Weiterentwicklung von Künstlicher Intelligenz und die zunehmende Bedeutung von Large Language Models (LLMs) haben das Feld der Interaktion mit APIs grundlegend verändert. Ein zentrales Bindeglied zwischen LLMs und externen Diensten sind sogenannte Model Context Protocol (MCP) Server. Diese Server ermöglichen es KI-Agenten, mit Werkzeugen und APIs effizient zu kommunizieren. Vor dem Hintergrund vorhandener REST-APIs stellt sich die Frage: Kann man MCP-Server einfach automatisch aus bestehenden OpenAPI-Schemas generieren oder ist dieser Ansatz zu kurzsichtig? Die Diskussion um die automatische Generierung von MCP-Servern aus OpenAPI-Spezifikationen ist hochaktuell und verdient eine differenzierte Betrachtung. Zunächst erscheint es logisch und zeitsparend, die investierte Zeit und Dokumentation einer REST-API direkt für die Erstellung eines MCP-Servers zu nutzen.

OpenAPI bietet eine ausführliche Beschreibung aller API-Endpunkte, ihrer Parameter und Rückgabewerte. Ein direktes 1-zu-1 Mapping könnte theoretisch eine vollständige und umfassende MCP-Schnittstelle liefern. Doch die Realität zeigt deutliche Hürden. Ein wesentliches Problem liegt darin, dass MCP-Server mit den Aufgaben und Workflows im Sinn eines KI-gestützten Agents entworfen sind, während REST-APIs reine Ressourcenoperationen abbilden. Ein REST-Endpunkt könnte sehr granular sein – etwa um einen einzelnen Datensatz abzurufen, zu ändern oder zu löschen – doch eine LLM-gesteuerte Anwendung benötigt in der Regel komplexere Aufgaben wie die Zusammenfassung von Informationen, Arbeitsabläufe oder das Ausführen mehrstufiger Prozesse.

Bei einem direkten Codegenerierungsansatz werden viele kleine Werkzeuge erzeugt, die den Umfang des MCP-Servers sehr groß machen. Dies ist problematisch, da LLMs Schwierigkeiten haben, sich innerhalb eines überbordenden Angebots an Optionen zurechtzufinden. Ein konkretes Beispiel ist die GitHub API mit mehr als 600 Endpunkten. Wenn diese alle 1:1 übertragen werden, wird das Modell mit einer immensen Auswahl an potenziellen Werkzeugen konfrontiert, die es oft nicht präzise oder effektiv auswählen kann. Fehlaufrufe und Fehlinterpretationen sind die Folge, was die Zuverlässigkeit des Systems stark beeinträchtigen kann.

Noch schwieriger gestaltet sich der Umgang mit komplexen JSON-Payloads und flexiblen Parametern in REST-APIs. LLMs sind nicht dafür optimiert, feinkörnige Konfigurationsdetails zu prüfen oder aus vielfältigen optionalen Feldern die passende Kombination für einen spezifischen Anwendungsfall auszuwählen. Die Interaktion wirkt sehr abstrakt und führt häufig zu nicht-intuitiven oder fehleranfälligen Ergebnissen. Die Kerndifferenz zwischen den Zielsetzungen von REST und MCP zeigt sich auch in der inhaltlichen Gestaltung. REST fokussiert sich auf das Modellieren von Ressourcen und deren Manipulation.

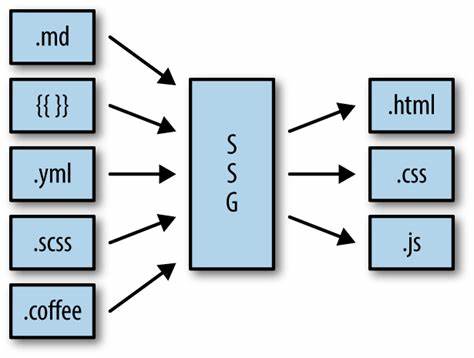

MCP hingegen adressiert Aufgaben, die mehrere Schritte und kontextuelle Wissensverarbeitung benötigen. So sind Werkzeuge im MCP-Umfeld idealerweise hochgradig abstrahiert und orientieren sich an zielgerichteten Workflows, nicht an atomaren Datenoperationen. Die ausschließliche Übertragung von API-Endpunkten ignoriert diese notwendige Abstraktionsstufe. Der Vorteil der Automatisierung beim Erstellen von MCP-Servern sollte daher nicht vorschnell überschätzt werden. Ein kritischer, hybrider Ansatz erscheint zielführender: Die automatische Codegenerierung aus OpenAPI-Schemas kann als Ausgangspunkt dienen – eine erste „Rohfassung“ sozusagen.

Im nächsten Schritt sollte diese Liste der generierten Tools konsequent überprüft, reduziert und verfeinert werden. Nicht jeder API-Endpunkt ist für eine KI-Interaktion gleichermaßen relevant oder sinnvoll. Stattdessen werden nur diejenigen Operationen ausgewählt, die einen klaren Mehrwert bieten und sich direkt für KI-gesteuerte Aufgaben eignen. Darüber hinaus ist es essenziell, die Tool-Beschreibungen neu zu gestalten und sie mit konkreten Hinweisen zu versehen, wann und warum ein LLM das Werkzeug einsetzen sollte. Anstelle von einfachen technischen Zusammenfassungen sind verständliche Anwendungsfälle, Beispielabläufe und Empfehlungen wichtig.

Ein weiterer entscheidender Schritt ist die Entwicklung von höherstufigen Tools, die mehrere API-Aufrufe unter einer einheitlichen Schnittstelle zusammenfassen und dadurch komplexe Workflows handhabbar machen. Ein solcher Ansatz nutzt die Stärken von LLMs optimal aus, indem er es ermöglicht, Aufgaben mit hohem Abstraktionsgrad zielgerichtet zu adressieren und Interaktionen zu vereinfachen. Diese Workflows können etwa die Verwaltung von Benutzerdaten, Datenmigrationen oder das Zusammenstellen von Berichten umfassen. Wichtig ist dabei, dass MCP-Server zustandslos bleiben sollten, um die Komplexität zu beherrschen und Fehleranfälligkeit zu minimieren. Ein praktisches Beispiel liefert das Entwicklerteam von Neon, die bei der Implementierung ihres MCP-Servers bewusst nur sinnvolle und nutzbare Tools aus dem umfangreichen REST-API-Angebot ableiteten.

Zudem integrierten sie höherstufige Workflows, die mehrere Endpunkte bündeln. Einer der erfolgreichsten Workflows betrifft das automatisierte Testen und Ausführen von Datenbankmigrationen, wobei Nutzer inhärent komplexe Vorgänge per einfacher Anfrage initiieren können. Dieses Vorgehen zeigt, dass durch intelligente Auswahl und Ergänzung der generierten Werkzeuge ein leistungsfähiger und handhabbarer MCP-Server entsteht, der LLMs wirkungsvoll bei komplexen Aufgaben unterstützt. Für alle, die sich intensiver mit MCP-Servern beschäftigen möchten, ist die Open-Source-Version des Neon MCP-Servers ein wertvolles Projekt. Die kontinuierliche Verbesserung und Community-Beteiligung unterstreichen, wie wichtig eine wohlüberlegte Konzeption und Umsetzung ist.

Aus SEO-Sicht ist es zudem wichtig, den Fokus auf relevante Suchbegriffe wie „MCP Server erstellen“, „OpenAPI zu MCP Konvertierung“, „KI-Integration mit APIs“ und „Modellmanagement in AI-Agenten“ zu legen. Unternehmen profitieren von einer soliden Infrastruktur, die nicht nur Entwicklungsaufwand reduziert, sondern auch die Zuverlässigkeit und Benutzerfreundlichkeit intelligenter Assistenzsysteme erhöht. Zusammenfassend lässt sich sagen, dass die automatische Generierung von MCP-Servern aus OpenAPI-Schemas keine einfache „Yay or Nay“-Entscheidung ist. Einer reinen 1:1 Umwandlung mangelt es an praktischer Nutzbarkeit und Effizienz. Erfolgreiche MCP-Server profitieren von einer Kombination aus automatischer Codegenerierung, selektiver Auswahl, semantischer Anpassung und der Kreation höherstufiger abstrahierter Werkzeuge zur gezielten Steuerung von Workflows.

Dieser hybride Ansatz ist der Schlüssel, um das Potenzial von LLMs und bestehenden APIs voll auszuschöpfen und so zukunftsfähige, intelligente Schnittstellen zu entwickeln.

![Do you hate Dino Dini's Soccer? One tiny bug, a world of hurt [video]](/images/D2ECC8D5-41FC-40FA-B1D7-B6A3008FD4DB)