Die Wahl des richtigen Datenbanksystems ist eine entscheidende Entscheidung für jedes Unternehmen, das auf verlässliche und effiziente Datenverarbeitung angewiesen ist. In den letzten Jahren hat sich PostgreSQL, oft einfach als Postgres bezeichnet, als eine der beliebtesten Open-Source-Datenbanken etabliert. Immer mehr Unternehmen entscheiden sich für eine Migration weg von komplexeren oder teuereren Systemen hin zu Postgres. Die Gründe hierfür sind vielfältig und betreffen sowohl technische als auch wirtschaftliche Faktoren. Eingangs war CockroachDB für viele Startups und technikorientierte Unternehmen eine attraktive Wahl.

Mit seinen Stärken bei der horizontalen Skalierung und Multi-Region-Setups versprach CockroachDB einfache Handhabung bei steigenden Datenmengen sowie hohe Verfügbarkeit durch Verteilung über mehrere Standorte. Insbesondere unter Berücksichtigung von Compliance-Anforderungen wie der DSGVO, die eine Datenlokalisierung in bestimmten Regionen vorschreiben, schien CockroachDB eine zukunftssichere Lösung zu sein. Jedoch zeigte sich mit zunehmendem Wachstum der Systeme und Daten die Kehrseite der Medaille. Die Kosten explodierten, und einige der anfangs vielversprechenden Vorteile traten deutlicher in den Schatten. Die Kostenentwicklung stellte dabei wohl das drängendste Problem dar.

Während das Unternehmen zunächst von der Cloud-Distribution profitierte, stiegen nach und nach die Ausgaben drastisch an. Ein fünfmal höherer Kostenpunkt innerhalb von nur zwei Jahren war für viele Unternehmen nicht mehr tragbar. Interessant war dabei, dass viele der teureren Funktionen, wie Multi-Region-Fähigkeiten, nicht aktiv genutzt wurden, da der Betrieb zunächst auf eine einzelne Region beschränkt war und die Abfragen eher simpel blieben. Viele Firmen fragten sich deshalb zurecht, warum sie für ein komplexes, verteiltes System zahlen sollten, wenn Postgres mit einer leistungsfähigen, bewährten Architektur kostengünstigere und schnellere Ergebnisse liefern konnte. Ein weiterer Kritikpunkt war die Komplexität von Migrationen und die damit verbundenen technischen Stolpersteine.

So stießen Unternehmen beim Einsatz von CockroachDB zunehmend auf Timeouts in der Migration, vor allem bei großen und komplexen Datenbanken. Das Deploy von Migrationen konnte sich erheblich verzögern, manchmal mussten Migrationen sogar manuell und einzeln ausgeführt werden, was den Prozess ineffizient und fehleranfällig machte. Zeitliche Blockaden von bis zu zwei Stunden während Deploys waren keine Seltenheit und frustrierten Entwickler, die so gezwungen waren, pragmatische und oftmals unsaubere Workarounds außerhalb der Datenbank zu entwickeln, um das System am Laufen zu halten. Im Gegensatz dazu setzte sich Postgres als performante und stabile Alternative durch. Tests mit vergleichbaren Migrationen zeigten, dass Postgres diese Operationen vielfach schneller und zuverlässiger ausführen konnte – teilweise innerhalb von weniger als zehn Sekunden.

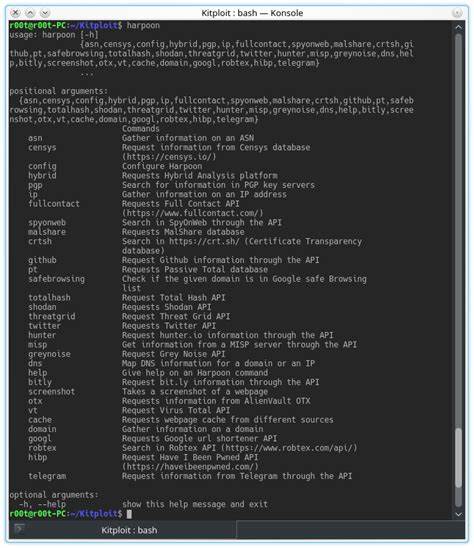

Dies führte zu einer erheblichen Reduzierung von Ausfallzeiten und technischen Risiken. Die Verlässlichkeit der Migrationsprozesse und der geringere Wartungsaufwand waren ausschlaggebend für viele Unternehmen, den Schritt zu einer Postgres-basierten Infrastruktur zu wagen. Neben Migrationsproblemen beeinflussten auch Schwierigkeiten bei der ETL-Integration (Extract, Transform, Load) die Entscheidung. Die Unterstützung von Tools und Connectors für die Replikation aus CockroachDB heraus war sehr eingeschränkt, und die vorhandenen Lösungen waren oft instabil oder befanden sich noch in der frühen Entwicklungsphase, was die Datenintegration erschwerte. Zum Zeitpunkt der Migration war einzig eine Alpha-Version des Airbyte-Connectors verfügbar, die sich durch einen hohen Speicherverbrauch und wiederholte Timeouts auszeichnete.

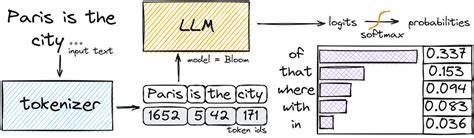

Postgres hingegen profitierte von einer ausgereiften ETL-Ökologie, die das Datenhandling intuitiver und schneller machte. Auch die Geschwindigkeit von Abfragen (Queries) offenbart die praktischen Unterschiede zwischen CockroachDB und Postgres. Obwohl in Einzelfällen CockroachDBs Optimizer für bestimmte Abfragen geringfügig bessere Resultate lieferte, waren die meisten realen Abfragen komplexer strukturiert, oft durch ORM-Frameworks wie Prisma generiert. Hier zeigten sich größere Schwächen, denn CockroachDB tendierte dazu, bei komplizierten, verschachtelten Abfragen umfassende Tabellen-Scans durchzuführen, die zu langen Antwortzeiten führten. Im Vergleich dazu konnte Postgres diese Abfragen häufig mit ausgefeilteren Planungen deutlich schneller verarbeiten, teilweise sogar zwanzigmal schneller.

Gerade bei großen Tabellen mit vielen Joins und Verschachtelungen machte sich die Effizienz von Postgres bemerkbar und ermöglichte eine bessere Nutzererfahrung durch schnellere Ladezeiten und reaktionsschnellere Schnittstellen. Zusätzlich zu Performanceproblemen kamen beim Betrieb von CockroachDB auch UI- und Bedienungsprobleme hinzu. Die Nutzeroberflächen für das Management und die Diagnose von Indizes zeigten häufig ungenaue oder irreführende Informationen, was Entwickler verwirrte und die Fehlerbehebung erschwerte. Auch das Management laufender Abfragen war in CockroachDB komplizierter, da das Abbrechen einer Anfrage oft nur über einen separaten Webzugang möglich war und nicht immer zuverlässig funktionierte. Im Gegensatz dazu bietet Postgres einfache und bewährte Tools, die in der täglichen Arbeit helfen, zum Beispiel durch intuitive SQL-Clients, die das direkte Abbrechen von Abfragen ermöglichen.

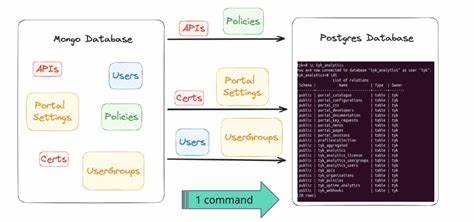

Zudem gab es wiederkehrende Verbindungsprobleme mit CockroachDB in diversen Umgebungen, die sich durch Perioden vollständiger Nichterreichbarkeit bemerkbar machten und trotz vielfältiger Maßnahmen nicht dauerhaft behoben werden konnten. Diese instabile Netzwerkkommunikation wirkte sich nicht nur auf Anwendungen aus, sondern verhinderte auch effiziente Datenbankwartungen und beeinträchtigte den Entwicklungsworkflow. In der Postgres-Welt waren solche Probleme kaum bekannt oder traten bedeutend seltener auf, was die Zuverlässigkeit des gesamten Systems erhöhte. Der eigentliche Migrationsprozess von CockroachDB zu Postgres stellte eine erhebliche Herausforderung dar, insbesondere auf Grund von Unterschieden in der Datenkodierung, unter anderem bei JSON- und Array-Typen. Diese Unterschiede machten einen reinen Datenexport und -import unmöglich, ohne dabei komplexe Transformationspipelines zu implementieren.

Ein individuell entwickeltes ETL-Script, eingesetzt mit modernen Tools wie dem JavaScript Runtime-Umfeld Bun, stellte sicher, dass die Daten korrekt extrahiert, angepasst und anschließend in Postgres importiert werden konnten. Dank dieser Automatisierung verlief die Datenmigration selbst bei einer riesigen Datenbank mit 100 Millionen Datensätzen schnell und effizient und erzielte eine minimale Ausfallzeit von unter einer Stunde. Dies erlaubte eine unterbrechungsarme Umstellung, die in der Praxis oft als kritisch erachtet wird. Das Ergebnis der Migration war außerordentlich positiv. Die Systemlatenz reduzierte sich nachhaltig um etwa ein Drittel, was sich unmittelbar auf die Nutzerzufriedenheit und die betriebliche Effizienz auswirkte.

Gleichzeitig ermöglichte die große und aktive Postgres-Community sowie die umfangreiche Tool-Unterstützung eine schnelle Identifikation und Optimierung von fehlerhaften oder ineffizienten Abfragen, sodass Performance-Probleme meist binnen Stunden behoben werden konnten. Neben der technischen Überlegenheit führte der Wechsel zu erheblichen Kosteneinsparungen – im Beispiel von Motion beliefen sich diese langfristig auf über 110.000 US-Dollar jährlich. Die Migration hin zu Postgres verdeutlicht, dass Technologieentscheidungen stets kritisch hinterfragt werden sollten. So attraktiv manche Features und Technologien auf dem Papier wirken, ist der praktische Betrieb mit realen Daten, Lastmustern und Integrationsanforderungen oft ernüchternd.

Open-Source-Datenbanken wie Postgres bieten dabei eine robuste Grundlage, die durch kontinuierliche Verbesserungen und eine große Anwenderbasis stetig profitiert. Für Unternehmen, die eine effiziente, kostengünstige und skalierbare Lösung suchen, ist Postgres daher eine sehr gute Wahl. Abschließend lässt sich sagen, dass Postgres mit seiner Stabilität, Leistungsfähigkeit und vielfältigen Ökosystemen das Potenzial hat, das Rückgrat von datengetriebenen Anwendungen zu sein. Für Entwickler, DevOps-Teams und Unternehmen, die auf hohe Verfügbarkeit, gute Performance und überschaubare Kosten setzen, stellt die Migration zu Postgres eine zukunftsfähige und erprobte Option dar. Wer sich auf den Weg macht, sollte zwar die Besonderheiten einer solchen Migration kennen, aber kann sich gleichzeitig auf eine lebendige Community, eine lange Historie und zahlreiche unterstützende Tools verlassen.

Die Erfolgsgeschichten wie die von Motion bieten wertvolle Orientierung und motivieren viele andere, ähnliche Herausforderungen anzupacken und ihre Datenbanken fit für die Zukunft zu machen.