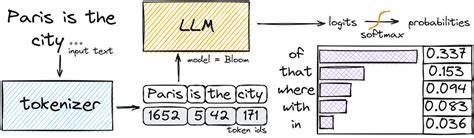

Die Nutzung großer Sprachmodelle, auch bekannt als Large Language Models (LLMs), gewinnt zunehmend an Bedeutung in der Welt der künstlichen Intelligenz. Gleichzeitig bringt die Handhabung sehr langer Ausgaben Herausforderungen mit sich, vor allem wenn es darum geht, umfangreiche Texte mit mehr als 100.000 Tokens zu verarbeiten oder zu generieren. Solche Anforderungen stellen insbesondere Entwickler, Wissenschaftler und professionelle Anwender vor komplexe Fragen: Wie kann man lange Ausgaben effizient und präzise erstellen? Wie lassen sich technische Limitierungen der Modelle überwinden? Im Folgenden werden bewährte Strategien und Überlegungen vorgestellt, die helfen, diese Herausforderungen zu meistern. Ein Punkt, der oft bei der Arbeit mit LLMs genannt wird, ist die sogenannte Kontextfenstergröße.

Diese definiert, wie viele Tokens das Modell in einem einzelnen Verarbeitungsschritt aufnehmen und berücksichtigen kann. Die meisten beliebten Modelle, wie GPT-3 oder GPT-4, haben begrenzte Kontextfenster, die oft bei 4.000 bis 8.000 Tokens liegen. Neuere Modelle versuchen dieses Limit zu erweitern: Google hat beispielsweise mit Gemini ein Modell vorgestellt, das eine längere Kontextverarbeitung ermöglicht.

Dies ist besonders hilfreich, wenn man nicht einfach kurze Textabschnitte bearbeitet, sondern sehr lange Dokumente übersetzen oder umformatieren möchte. Allerdings ist die Verfügbarkeit solch neuer Modelle abhängig von Zugangsbedingungen und technischen Voraussetzungen, sodass Alternativlösungen gesucht werden müssen. Eine bekannte Methode zur Handhabung extrem langer Texte besteht darin, diese in kleinere Sinnabschnitte zu unterteilen. Dabei wird der Text in logisch zusammenhängende Teile aufgesplittet, die innerhalb des Kontextfensters des Modells bearbeitet werden können. Nach der Bearbeitung erfolgt eine anschließende Zusammenführung der Abschnitte, was manchmal manuell oder durch weitere KI-gesteuerte Schritte unterstützt wird.

Diese Technik hilft dabei, Limitierungen des Kontextfensters zu umgehen, bleibt jedoch anfällig für mögliche Informationsverluste an den Übergängen zwischen den Textteilen. Zudem erfordert diese Methode eine sorgfältige Planung der Textaufteilung, da man sicherstellen will, dass der Kontext jedes Abschnitts verständlich und vollständig genug bleibt. Parallel zu dieser Segmentierungsstrategie gewinnt die Verwendung von sogenannten „Long-Context“-Modellen an Bedeutung. Technologische Entwicklungen und Forschungsarbeiten konzentrieren sich seit einiger Zeit darauf, die Kontextkapazität von Sprachmodellen drastisch zu erweitern. Modelle mit 100.

000 Tokens oder mehr im Kontextfenster sind in Aussicht und werden nach und nach in der Praxis getestet. Diese Modelle eröffnen neue Möglichkeiten, da sie in der Lage sind, den gesamten Text in einem einzigen Schritt zu verarbeiten. Damit lassen sich etwa umfangreiche Manuskripte oder Datenbanken effizienter analysieren oder bearbeiten. Allerdings sind diese Modelle oft noch in der Erprobung und können eine höhere Rechenleistung oder spezielle Hardware erfordern. Neben der Technik und Modellarchitektur spielt auch die Art der Aufgabenstellung eine wichtige Rolle bei der Generierung von langen LLM-Ausgaben.

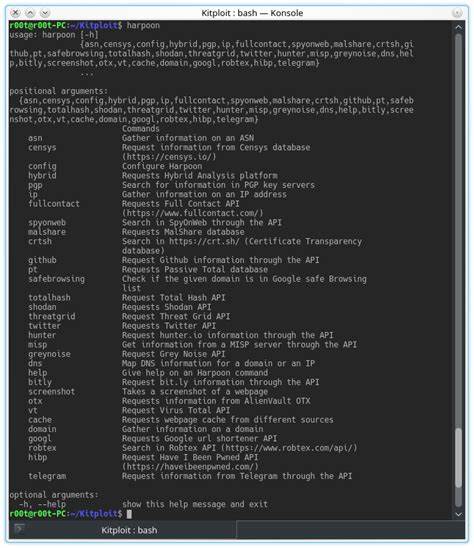

Besonders bei Übersetzungen oder Neustrukturierungen großer Dokumente ist es entscheidend, die Aufgabe in passende Module zu zerlegen. So kann eine Vorgehensweise darin bestehen, zunächst eine grobe Rohübersetzung oder -bearbeitung durchzuführen und im Anschluss iterativ Feinjustierungen in mehreren Durchläufen vorzunehmen. Dies optimiert die Qualität und ermöglicht eine bessere Kontrolle über den Gesamtprozess. Häufig werden auch externe Werkzeuge eingesetzt, um die Ausgabe eines LLM effizient zu steuern. Beispielsweise lassen sich Textchunks mithilfe spezialisierter Software automatisch segmentieren, Übersetzungen in mehreren Schritten orchestrieren oder endgültige Dokumente nachbearbeiten.

Hierbei entsteht ein synergetischer Effekt, denn die Kombination aus KI-Fähigkeiten und traditioneller Datenverarbeitung öffnet den Raum für skalierbare und robuste Lösungen. Ein weiterer wichtiger Aspekt ist die Kosten-Nutzen-Analyse bei der Verwendung von LLMs mit sehr großem Kontextfenster. Größere Modelle oder erweiterte Kontextfenster erhöhen tendenziell den Ressourcenverbrauch, insbesondere bei Cloud-basierten LLM-Diensten. Unternehmen und Entwickler müssen deshalb stets abwägen, welche Lösungen aus Kostensicht sinnvoll sind. Manchmal ist es effizienter, mehrere kleinere Anfragen zu stellen und die Ergebnisse intelligent zusammenzuführen, anstatt mit einem einzigen, riesigen Kontextfenster zu arbeiten.

Die Optimierung von Prompt-Design beziehungsweise Eingabeaufforderungen ist ebenfalls entscheidend. Gute Prompts können die Menge an notwendigen Tokens reduzieren, indem sie präzise und zielgerichtete Anweisungen enthalten. Insbesondere bei komplexen und langen Texten sollte der Prompt so gestaltet sein, dass das Modell relevante Informationen priorisiert und unnötige Wiederholungen vermieden werden. Diese Maßnahmen tragen dazu bei, das verfügbare Kontextfenster optimal zu nutzen und besser strukturierte Ausgaben zu generieren. Darüber hinaus experimentieren Entwickler auch mit sogenannten „Retrieval-Augmented Generation“-Ansätzen (RAG).

Hierbei wird nicht der gesamte Text an das Modell übergeben. Stattdessen werden relevante Teile aus einer externen Wissens- oder Textdatenbank dynamisch abgerufen und als Kontext hinzugefügt. Dies erweitert effektiv den verfügbaren Kontext über die Grenzen des Modell-internen Kontextfensters hinaus und ermöglicht die Bearbeitung umfangreicher Dokumente oder Sammlungen. Solche hybriden Systeme verbinden die Stärken von Informationsabruf und Sprachmodellgeneration und sind gerade in Forschung und Industrie hoch im Kurs. Langfristig erwartet man, dass die Kombination aus immer leistungsfähigeren Modellen mit größeren Kontextfenstern, optimierten Tools zur Textvorverarbeitung, intelligentem Prompt-Design und hybriden Architekturen eine umfassende und effiziente Bearbeitung riesiger Textmengen erlauben wird.

Die praktische Umsetzung erfordert jedoch weiterhin fundiertes Know-how in KI-Technologien, Textverarbeitung und Softwareentwicklung. Für Anwender, die aktuell mit großen Textprojekten arbeiten, gilt es, die vorgestellten Strategien flexibel und situationsspezifisch einzusetzen. Das bedeutet, je nach Anwendungsfall kann es sinnvoller sein, ein großes Modell mit erweitertem Kontext zu nutzen oder mehrere kleinere Schritte mit segmentierten Texten zu kombinieren. Ebenso ist die sorgfältige Planung von Datenfluss, Qualitätssicherung und Kostenmanagement essenziell. Abschließend lässt sich festhalten, dass die Generierung langer Ausgaben mit großen Sprachmodellen ein dynamisches und technisch anspruchsvolles Feld ist, das sich ständig weiterentwickelt.

Die Balance zwischen Modellfähigkeiten, technischer Infrastruktur und praktischen Anforderungen bestimmt den Erfolg maßgeblich. Wer hier mit Weitsicht und strategischem Vorgehen arbeitet, kann großartige Ergebnisse erzielen und die Potenziale von LLMs voll ausschöpfen.