Die Welt der Künstlichen Intelligenz hat mit der Einführung von GPT-4.1 einen bedeutenden Entwicklungsschritt gemacht. Das Modell bietet gegenüber seinen Vorgängern erhebliche Verbesserungen im Bereich des Coding, der Befolgung von Anweisungen und im Umgang mit umfangreichem Kontext. Für Entwickler, Forscher und KI-Begeisterte bedeutet das eine neue Ära des Prompt-Engineerings, bei der die Art und Weise der Formulierung von Aufforderungen („Prompts“) eine entscheidende Rolle spielt. Der Schlüssel zum Erfolg liegt darin, das Modell zielgerichtet, klar und präzise anzuleiten, um optimale Ergebnisse zu erzielen.

Die Besonderheit von GPT-4.1 liegt darin, dass es Anweisungen wesentlich genauer und wortwörtlicher als frühere Versionen ausführt. Während frühere Modelle öfter den Kontext interpretierten und Absichten freier erschlossen, folgt GPT-4.1 strikt den vorgegebenen Instruktionen und kann somit besser gesteuert werden. Diese Eigenschaft eröffnet vielfältige Möglichkeiten in der Anwendung, erfordert aber zugleich eine Anpassung der bisherigen Prompting-Techniken.

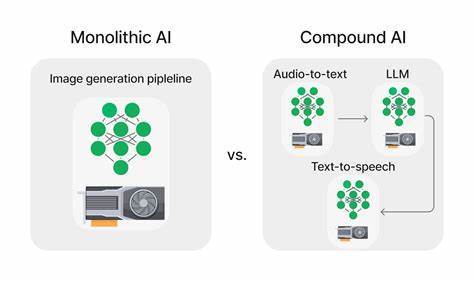

Wer die veränderte Herangehensweise versteht, kann die Leistung des Modells gezielt und effizient ausnutzen.Ein empfehlenswerter Einstieg in den Umgang mit GPT-4.1 ist das Einbinden von sogenannten agentischen Workflows. Darunter versteht man mehrstufige, autonome Problemlösungsprozesse, bei denen die KI in mehreren Schritten Informationen sammelt, analysiert, plant und schließlich konkrete Aktionen ausführt. Im Training von GPT-4.

1 lag ein Fokus darauf, dem Modell vielfältige agentische Problemlösestrategien zu vermitteln, um besonders bei komplexen Aufgaben wie Softwareentwicklung bessere Ergebnisse zu erzielen. In Tests zeigte sich eine deutliche Steigerung der Problemlösungsrate.Damit agentische Workflows voll ausschöpfen können, empfiehlt sich die Verwendung spezifischer System-Prompt-Erinnerungen. Diese sorgen dafür, dass das Modell im Verlauf einer Interaktion fokussiert bleibt und den Dialog nicht zu früh beendet. Die erste Erinnerung ist die sogenannte „Persistence“, bei der das Modell angeleitet wird, so lange aktiv zu bleiben, bis eine Aufgabe vollständig gelöst ist.

Hierbei wird verhindert, dass es prematurely die Kontrolle an den Nutzer zurückgibt ohne das Problem wirklich abzuschließen. Daneben verweist die „Tool-calling“-Erinnerung darauf, stets verfügbare Werkzeuge einzusetzen, um präzise Informationen zu erhalten, anstatt zu raten oder hypothetisch zu antworten. Schließlich sorgt eine optionale „Planning“-Erinnerung dafür, dass vor und nach jedem Arbeitsschritt ausführlich reflektiert und geplant wird. Diese strukturierte Vorgehensweise erhöht die Lösungstiefe und Präzision signifikant.Ein weiterer wichtiger Aspekt von GPT-4.

1 ist die verbesserte Fähigkeit zur Nutzung externer Werkzeuge über die API. Anders als bei früheren Modellen sollte man jetzt bevorzugt die dedizierte Tools-Schnittstelle verwenden, um Funktionen aufzurufen. Das Vorgehen, Tool-Beschreibungen manuell in den Prompt zu integrieren und die Ergebnisse eigenständig zu parsen, ist nicht nur fehleranfällig, sondern reduziert auch die Leistungsfähigkeit. Der direkte Tool-Call über die API sichert eine präzise Umsetzung von Anfragen und steigert die Erfolgsrate bei komplexen Aufgaben.Ein Vorteil von GPT-4.

1 ist auch der erweiterte Kontextumfang von bis zu einer Million Tokens. Das ermöglicht den Einsatz für anspruchsvolle Szenarien wie die Analyse umfangreicher Dokumentensammlungen oder mehrstufiges logisches Schlussfolgern. Allerdings gilt es, den Kontext klug zu strukturieren, da die Modellleistung bei sehr komplexen oder zu umfangreichen Aufgaben auch leiden kann. Wichtig ist hier, relevante Dokumente bestmöglich auszuwählen und in sinnvoller Reihenfolge einzubetten. Dabei empfiehlt es sich, Instruktionen sowohl am Anfang als auch am Ende des Kontextes zu platzieren, um die Aufmerksamkeit des Modells gezielt zu lenken.

Eine hochwirksame Technik, die mit GPT-4.1 gut harmoniert, ist das sogenannte „Chain-of-Thought“-Prompting. Dabei wird das Modell dazu angeregt, seine Problemlösestrategie Schritt für Schritt verbal zu erläutern, um komplexe Aufgaben systematisch zu bearbeiten. Obwohl GPT-4.1 kein dediziertes Reasoning-Modell ist und intern nicht automatisch kognitive Zwischenschritte generiert, reagiert es sehr gut auf explizite Aufforderungen zum „laut Denken“.

Diese Vorgehensweise verbessert die Genauigkeit und Nachvollziehbarkeit der Antworten und kann bei der Fehlersuche oder bei komplexer Logikanalyse wertvolle Dienste leisten.Die Art und Weise, wie Anweisungen formuliert werden, spielt eine zentrale Rolle für den Erfolg. GPT-4.1 folgt Angaben präzise und erwartet klare, explizite Instruktionen. Das bedeutet, dass unklare oder widersprüchliche Vorgaben zu unerwünschtem Verhalten führen können.

Auch ist es sinnvoll, Beispiele und Workflow-Beschreibungen in den Prompt einzubauen, um die erwünschte Verhaltensweise zu demonstrieren. Stark betonte Aufforderungen, etwa in Großbuchstaben oder mit Belohnungen, sind in der Regel nicht nötig und könnten sich kontraproduktiv auswirken. Stattdessen empfiehlt sich ein klarer, sachlicher Stil mit gut strukturierten Abschnitten für Regeln, Ablauf und Beispielabfragen.Ein praktisches Beispiel für eine sehr effektive Prompt-Struktur bietet die OpenAI-eigene SWE-bench Verified Agent-Umgebung. Dort wird der Agent angewiesen, ein technisches Problem in einem Quellcode-Repository schrittweise und gründlich zu analysieren, eigenständig geeignete Werkzeuge zum Einlesen von Dateien zu verwenden, die Lösung sorgsam zu testen und nur nach vollständiger Problemlösung die Kontrolle zurückzugeben.

Der Prozess ist streng strukturiert und enthält ausführliche Leitlinien, wie der Agent vorzugehen hat. Gerade bei der Arbeit in der Softwareentwicklung oder bei Debugging-Tasks kann dieses Vorgehen erhebliche Vorteile bringen.Neben der inhaltlichen Gestaltung ist auch die Wahl des Formats für Prompt und Kontext wichtig. Markdown eignet sich hervorragend, um mit Überschriften, Listen und Codeblöcken übersichtliche Strukturen zu schaffen. XML eignet sich besonders, wenn verschachtelte Strukturen, Metadaten oder Beispiele eingebunden werden sollen.

JSON ist zwar sehr präzise und maschinenlesbar, kann aber durch die notwendige Zeichenescapierung und seine Verbosität sperriger sein. Die Wahl des Formats sollte daher an die jeweilige Aufgabe und die Art der Daten angepasst werden.Insgesamt zeigt sich, dass der Umgang mit GPT-4.1 nicht nur technisches Wissen, sondern auch ein gutes Verständnis für menschliche Kommunikationsprinzipien erfordert. Präzision, Klarheit und eine strukturierte Herangehensweise an den Dialog sind entscheidend, um die Fähigkeiten des Modells voll auszuschöpfen.

Entwickler sind gut beraten, ihre Prompts iterativ zu testen und anhand von Evaluationsmetriken systematisch zu verbessern. Die empirische Herangehensweise, bei der Schritt für Schritt Fehlerquellen identifiziert und behoben werden, führt zu den besten Ergebnissen.Die Zukunft des Prompt-Engineerings liegt zweifellos in der Kombination aus fortschrittlichen Modellen wie GPT-4.1 und durchdachten Workflow-Designs. Wer die beschriebenen Prinzipien beherzigt, wird in der Lage sein, intelligente, autonome Agenten zu erschaffen, die komplexe Aufgaben zuverlässig und effizient bearbeiten.