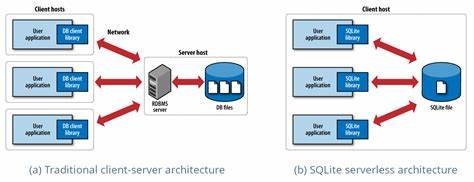

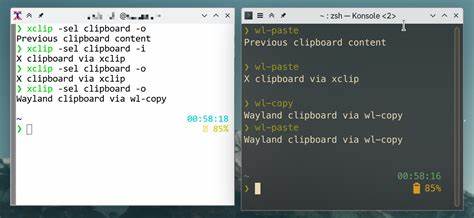

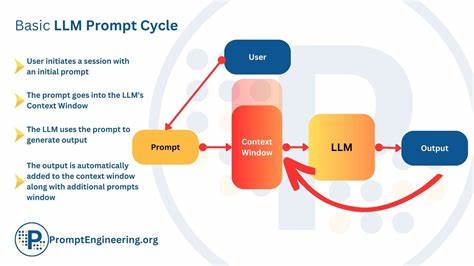

SQLite ist unbestreitbar eine der meistgenutzten eingebetteten Datenbanklösungen weltweit. Von Smartphones über Webbrowser bis hin zu zahlreichen Anwendungen ist SQLite allgegenwärtig – und doch bleibt die Architektur dieses Datenbanksystems ein faszinierendes Studienobjekt für Datenbankexperten und Entwickler. Die Geschichte von SQLite erzählt von bewussten Designentscheidungen, die Portabilität und Zuverlässigkeit über maximale Performance stellen, und stellt gleichzeitig fundamentale Spannungen zwischen einem universellen Systemansatz und spezialisierten Workloads dar. Die Grundarchitektur von SQLite basiert auf einem virtuellen Maschinenmodell, bei dem SQL-Anfragen in Bytecode übersetzt werden, der anschließend von der Virtual Database Engine (VDBE) verarbeitet wird. Dieses Abstraktionsprinzip ermöglicht plattformübergreifende Gleichmäßigkeit und verbesserte Testbarkeit, verursacht jedoch auch einen gewissen Rechenaufwand.

Neben diesem Ansatz setzt SQLite auf eine Speicherstruktur, die gänzlich auf B-Bäumen basiert – Tisch-Bäume für die Speicherung der Daten und Index-Bäume zur Beschleunigung von Abfragen. Die Speicherarchitektur ist dabei zeilenorientiert, was in Kombination mit dem flexiblen Typisierungssystem von SQLite zu besonderen Eigenschaften aber auch Herausforderungen führt. Jede gespeicherte Datensatzzeile enthält einen Header mit Typinformationen für jede Spalte, gefolgt von den eigentlichen Werten. Um einen bestimmten Wert auszulesen, muss der Header sequentiell durchlaufen und die genaue Position des Werts ermittelt werden. Diese Methode ist zwar flexibel und kompatibel mit unterschiedlichen Datentypen in einer einzigen Spalte, erweist sich jedoch bei sehr breiten Tabellen oder analytischen Aufgaben, die viele Spalten betreffen, als verhältnismäßig rechenintensiv.

Dieses flexible Typisierungssystem erlaubt es, nahezu beliebige Werte in den Spalten zu speichern, was SQLite zu einem hervorragenden Werkzeug zur Verwaltung semi-strukturierter oder anwendungsbezogener Daten macht. Für analytische Workloads zeigt sich jedoch ein deutlicher Nachteil: Die zusätzliche Aufwand durch die Typprüfung und das Aufschlüsseln der Datenstrukturen kann die Performance erheblich bremsen. Eine umfassende Leistungsanalyse, durchgeführt von einem Forscherteam der University of Wisconsin-Madison in enger Zusammenarbeit mit SQLite-Entwicklern, bringt weitere Einsichten in die tatsächlichen Performance-Engpässe. Anhand des Star Schema Benchmark (SSB) wurde überprüft, welche Aspekte innerhalb der SQLite-Ausführung am meisten Rechenleistung beanspruchen. Zwei virtuelle Maschinenoperationen stachen dabei besonders hervor: SeekRowid und Column.

SeekRowid ist für das Auffinden von Datensätzen mithilfe von B-Baum-indizierten Indexen verantwortlich und spielt vor allem bei Join-Operationen eine zentrale Rolle. Die Column-Operation extrahiert Werte aus den Datensätzen, ein Prozess, bei dem die erwähnten Headerinformationen sequentiell gelesen werden müssen. Für komplexe Abfragen, insbesondere solche, die eine große Faktentabelle mit mehreren Dimensionstabellen verbinden, ergeben sich immense Kosten durch die vielen B-Baum-Suchexpeditionen und die mehrfache Werteextraktion. Diese Beobachtung führt zu einer zentralen Erkenntnis in der Welt der Datenbankoptimierung: Die Ursache vieler Performance-Probleme liegt in nicht notwendigen Arbeitsschritten und unnötigen Zugriffen. In Online Transaction Processing (OLTP)-Szenarien sind Abfragen oft gezielt auf einzelne Datensätze mit Indexzugriffen fokussiert, sodass die hier genannten Kosten überschaubar bleiben.

Im Gegensatz dazu multiplizieren sich diese Kosten bei analytischen Abfragen, die große Datenmengen bearbeiten, erheblich. Angesichts dieser Restriktionen wählten die Forscher und Entwickler einen pragmatischen Optimierungsansatz. Statt komplexe Hash-Joins einzuführen, die zwar theoretisch signifikante Geschwindigkeitsvorteile bringen, aber beträchtliche Herausforderungen im Speicher- und Abfrageplanungsmanagement verursachen würden, entschieden sie sich für eine weniger invasive Technik: Bloom-Filter kombiniert mit Lookahead Information Passing (LIP). Diese Entscheidung spiegelt die allgemeinen architektonischen Zwänge von SQLite wider. Änderungen müssen nicht nur rückwärtskompatibel sein, sondern auch die Stabilität des zugrundeliegenden Dateiformats bewahren, das mittlerweile als Digital Preservation Standard von der US Library of Congress empfohlen wird.

Zudem sollten solche Optimierungen keine Performanceeinbußen bei der Vielzahl der bestehenden Anwendungsfälle verursachen. Die Integration der Bloom-Filter-Logik erfolgte auf einer niedrigen Ebene im virtuellen Maschinenmodell von SQLite. Dabei wurden lediglich zwei neue VM-Anweisungen, FilterAdd und Filter, ergänzt, womit für Anwender und das Ökosystem kaum Auswirkungen spürbar sind. Die Filter werden während der Aufbauphase gebildet, indem Dimensionstabellen gescannt und hashbasierte Bits für die Join-Schlüssel gesetzt werden. Beim eigentlichen Abfrage-Durchlauf prüft SQLite, ob ein Faktentabellen-Datensatz anhand der Bloom-Filter eingebunden werden muss, bevor aufwändige B-Baum-Operationen ausgelöst werden.

Dieses Verfahren ist besonders effizient bei Sternschema-Joins, bei denen die Dimensionstabellen eine hohe Selektivität aufweisen. Die Kumulierung mehrerer solcher Filter ermöglicht die Eliminierung der Mehrheit überflüssiger Index-Suchen durch einfache Bitoperationen, was einen Beschleunigungsfaktor bis zu 4,2-fach bei analytischen Workloads wie SSB bewirken kann. Für OLTP-ähnliche Operationen bleiben hingegen die Kosten durch die zusätzlichen Prüfungsvorgänge vernachlässigbar. Trotz dieser Fortschritte bestehen fundamentale Grenzen der derzeitigen SQLite-Architektur. Die zeilenorientierte Speicherung und die flexible Typisierung machen das schnelle Abrufen einzelner Spaltenwerte kostspielig.

Prinzipiell könnte eine Umstellung auf eine spaltenorientierte Speicherung die analytische Performance dramatisch verbessern. Doch eine solche Änderung würde den Kern von SQLite erschüttern: die Kompatibilität des Dateiformats und dessen Zuverlässigkeit über Jahrzehnte hinweg. Für Entwickler und Systemarchitekten zeigt die SQLite-Analyse auch die Bedeutung präziser Messmethoden. Das aktivierbare Profiling des VDBE ermöglichte die Identifikation wirklich relevanter Bottlenecks. Dabei wurde klar, dass naheliegende Optimierungen wie Vectorisierung wenig wirksam wären, da der Interpretationsaufwand der virtuellen Maschinenbefehle im Vergleich zum datenbezogenen Overhead gering bleibt.

Die Erkenntnis, dass eine Profiling-gestützte Diagnose statt einer intuitiven Annahme die Richtung für Optimierungen bestimmt, empfiehlt sich für alle, die komplexe Softwaresysteme oder Datenbanken performant halten wollen. Das Beispiel der Bloom-Filter zeigt eindrucksvoll, wie man mit technischer Finesse und unter Wahrung der architektonischen Zwänge Effizienzgewinne erzielt. Die Einbettung in die bestehende virtuelle Maschinenlogik vermied störende, weitreichende Umbauten und bewahrte so die Stabilität des Gesamtmodells. Die Erweiterung beschränkte sich auf vereinzelte neue Operationen, wobei bestehende Mechanismen für Scanning, Expression Evaluation und Blob-Verarbeitung verwendet wurden. Im weiteren Blickwinkel offenbart sich eine grundsätzliche Designspaltung in der Datenbankwelt.

Moderne Anforderungen drücken auf eingebettete Lösungen wie SQLite, die über ihre ursprünglichen Nutzungsszenarien hinauswachsen müssen: anspruchsvolle analytische Workloads und datenwissenschaftliche Anwendungen erfordern immer leistungsfähigere Verfahren. Einerseits steht SQLite mit seinen gezielten, decimal gehaltenen Optimierungen, die kontinuierlich an die systeminternen Limits herankommen, auf Seiten der bewährten Generalisten. Auf der anderen Seite entstehen spezialisierte Systeme wie DuckDB, welche auf Spezialisierung und analytische Performance setzen, aber zu Lasten einer universell einsetzbaren Architektur. Beide Ansätze spiegeln unterschiedliche Prioritäten wider: der schmale Grat zwischen Vielseitigkeit und Effizienz. SQLite steckt mit seiner Milliarden-Installationen starken Verbreitung den Wert eines universalen, langlebigen Systems ab.

DuckDB dagegen führt vor Augen, welche Vorteile auf neue Systemarchitekturen spezialisierte Lösungen zurückführen können. Eine spannende Zukunftsperspektive könnte die hybride SQLite3/HE-Initiative bieten, die versucht, traditionelle zeilenorientierte Transaktionen und eine moderne, spaltenorientierte analytische Engine zu kombinieren. So könnte die Balance zwischen Stabilität, Kompatibilität und Performance neu definiert werden, ohne grundlegende Kompromisse eingehen zu müssen. Abschließend bleibt SQLite ein Musterbeispiel für gelungene Softwareentwicklung und technische Architektur. Die Kombination aus pragmatischem Design, Rücksicht auf Kompatibilität und gezielten Innovationen zeigt, wie sich technische Systeme über Jahrzehnte wandeln und dennoch ihre Relevanz bewahren.

Wer heute leistungsfähige eingebettete Datenbanklösungen sucht, findet in SQLite ein lebendiges Beispiel für langjährige evolutionäre Entwicklung, die zugleich wegweisend für zukünftige Systeme ist.